文章目录

- 1. 核心数据结构:算法的基石

- 1.1 负载均衡节点结构:定义服务器实体

- 1.2 关键概念阐述:权重 (Weight)

- 2. NGINX加权轮询算法旨在解决的具体问题深度分析

- 2.1 应对后端服务器间的负载不均衡问题

- 2.2 后端服务健康状态的动态感知与自适应调整

- 2.3 实现流量分配的平滑性与均衡性

- 2.4 提供配置的灵活性与卓越的易用性

- 3. 加权轮询算法核心操作的实现细节

- 3.1 初始化权重相关数据结构

- 3.2 选择目标节点的具体算法实现

- 3.3 失败处理与权重动态调整机制

- 4. NGINX加权轮询算法的时间复杂度深度分析

- 5. NGINX加权轮询与其他主流负载均衡算法的横向对比

- 6. 加权轮询算法实现中的关键优化策略剖析

- 6.1 精妙的平滑权重算法 (Smooth Weighted Round Robin)

- 6.2 智能的动态权重调整机制

- 6.3 精心优化的内存布局

- 6.4 贯彻极简主义的设计哲学

- 7. NGINX加权轮询在实际生产环境中的多样化应用

- 7.1 典型的基础配置示例

- 7.2 针对特定实际场景的配置优化策略

- 7.3 借助NGINX Plus实现动态调整与精细化监控

- 8. 加权轮询算法所体现的卓越工程设计价值

- 8.1 算法设计所遵循的核心原则

- 8.2 卓越的代码质量与高度的可维护性

- 8.3 优先考虑实际应用效果与性能

- 9. 加权轮询算法的核心技术深度剖析与原理阐释

- 9.1 平滑权重算法 (Smooth Weighted Round-Robin) 的核心运作原理

- 9.2 精密的动态权重调整机制与策略

- 9.3 健康检查 (Health Check) 的无缝集成

- 9.4 NGINX商业版 (NGINX Plus) 的功能增强与扩展

- 10. 加权轮询算法的性能特性深入分析与优化考量

- 10.1 时间复杂度具体构成与实际影响分析

- 10.2 空间复杂度优化与内存占用分析

- 11. NGINX加权轮询算法在不同应用场景下的深度应用与分析

- 11.1 在Web应用集群中的经典负载均衡应用

- 11.2 在API网关场景中的精细化流量路由应用

- 11.3 微服务架构 (Microservices Architecture) 中的应用

- 11.4 全球分布式系统 (GDS - Global Distributed Systems) 中的应用

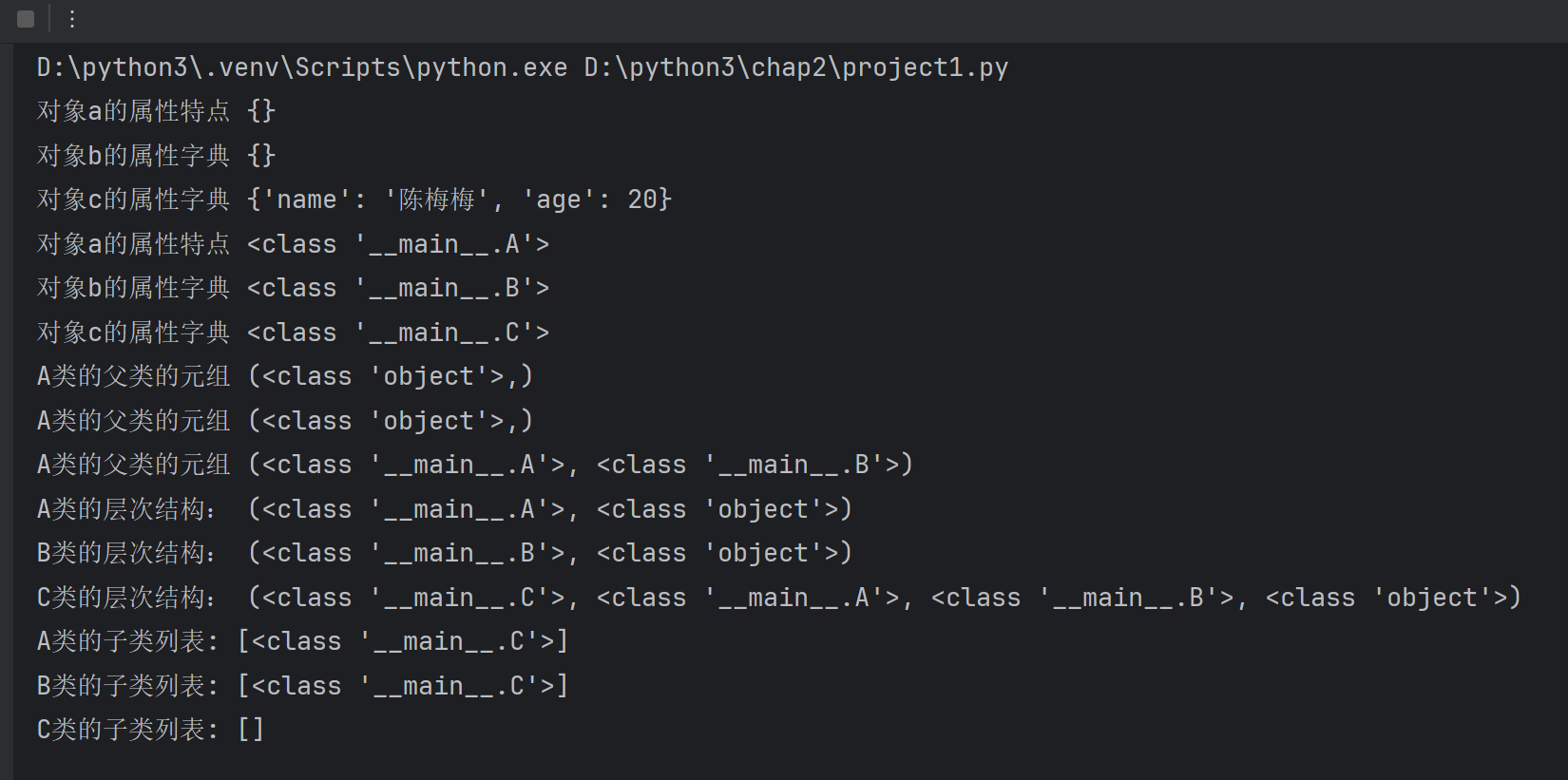

1. 核心数据结构:算法的基石

深入理解NGINX的加权轮询算法,首先需要熟悉其赖以构建的核心数据结构。

1.1 负载均衡节点结构:定义服务器实体

以下是定义单个后端服务器(peer)及其集群(peers)的关键数据结构:

typedef struct {

ngx_http_upstream_rr_peer_t *peer; // 在NGINX Plus中用于持久化连接的下一个peer

ngx_uint_t current_weight; // 当前动态计算的权重,选择时使用

ngx_uint_t effective_weight; // 有效权重,受健康状况动态调整

ngx_uint_t weight; // 配置的静态权重,基础处理能力指标

ngx_uint_t fails; // 当前连续失败次数

time_t accessed; // 最近一次访问(成功或失败)时间

time_t checked; // 最近一次健康检查(通常是失败后)时间

ngx_uint_t max_fails; // 最大允许连续失败次数

time_t fail_timeout; // 失败后标记为不可用的超时时长

ngx_event_get_peer_pt get; // 获取连接到此peer的方法

ngx_event_free_peer_pt free; // 释放与此peer连接的方法

void *data; // 传递给get/free方法的用户数据

#if (NGX_HTTP_SSL)

ngx_ssl_session_t *ssl_session; // 用于SSL会话复用

#endif

} ngx_http_upstream_rr_peer_t; // 单个后端服务器节点结构

typedef struct {

ngx_uint_t number; /* 集群中活跃服务器的数量 */

ngx_uint_t total_weight; /* 集群中所有活跃服务器的总权重(静态配置)*/

unsigned single:1; /* 标志位:是否只有一台服务器,用于优化路径 */

ngx_str_t *name; /* 上游服务器组(upstream block)的配置名称 */

ngx_http_upstream_rr_peer_t *peers; /* 指向所有peer节点(通常是数组首地址或链表头)的指针 */

ngx_http_upstream_rr_peer_t *current; /* 指向当前一轮选择中最终确定的peer节点 */

} ngx_http_upstream_rr_peers_t;

1.2 关键概念阐述:权重 (Weight)

在NGINX的加权轮询负载均衡算法中,每个后端服务器节点都关联着三个至关重要的权重值,它们共同决定了请求的分配逻辑:

weight(静态权重):这是在NGINX配置文件中为每个服务器明确指定的静态数值。它代表了服务器的基础处理能力或期望承载的负载比例。例如,一台性能更强的服务器通常会被赋予更高的静态权重。effective_weight(有效权重):该权重初始值等于配置的weight。然而,它并非一成不变,而是会根据服务器的实时健康状况(如请求成功或失败)动态调整。例如,当服务器出现连接失败时,其有效权重会相应降低。current_weight(当前权重):这是一个在负载均衡选择过程中动态计算和变化的临时权重值。在每一轮选择服务器时,该值都会被更新,算法依据此值来挑选出最合适的服务器,确保请求分配的平滑性和公平性。

2. NGINX加权轮询算法旨在解决的具体问题深度分析

2.1 应对后端服务器间的负载不均衡问题

此算法着重解决的问题包括:

- 服务器处理能力差异化:在实际生产环境中,一个服务器集群中的各个节点其处理能力(如CPU、内存、I/O性能)往往存在显著差异。

- 实现请求的公平化分配:核心需求是需要一种机制,能够严格按照各服务器的实际处理能力比例来智能地分配客户端请求。

- 克服简单轮询算法的局限性:传统的、普通的轮询算法(Round Robin)对所有服务器一视同仁,无法有效体现和利用服务器之间的处理能力差异,可能导致低配服务器过载而高配服务器资源闲置。

NGINX提供的精巧解决方案:

以下 ngx_http_upstream_get_peer 函数的简化逻辑展示了其核心思想。

static ngx_http_upstream_rr_peer_t *

ngx_http_upstream_get_peer(ngx_http_upstream_rr_peer_data_t *rrp)

{

ngx_http_upstream_rr_peer_t *peer, *best; // peer 用于迭代,best 存储当前最佳选择

ngx_http_upstream_rr_peers_t *peers; // 指向服务器组信息

ngx_uint_t total; // 本轮所有参与选择的服务器的有效权重之和

time_t now = ngx_time(); // 获取当前时间,用于健康检查

peers = rrp->peers;

best = NULL;

total = 0;

// 遍历服务器组中的所有 peer 节点

for (peer = peers->peer; peer; peer = peer->next) {

/* 关键步骤1: 健康检查逻辑 – 忽略那些当前标记为失败且仍在 fail_timeout 惩罚期内的服务器 */

if (peer->max_fails > 0 // max_fails 为0表示不进行失败检查

&& peer->fails >= peer->max_fails

&& now - peer->checked <= peer->fail_timeout)

{

continue; // 跳过此不健康节点

}

/* 关键步骤2: 更新当前节点的 current_weight – 累加其 effective_weight */

// 这是平滑加权轮询算法的核心之一:每个节点在被选中前,其 current_weight 都会增加

peer->current_weight += peer->effective_weight;

/* 关键步骤3: 累加总有效权重 – 用于后续选中节点的 current_weight 调整 */

total += peer->effective_weight;

/* 关键步骤4: 选择当前权重 (current_weight) 最高的服务器作为候选 */

// 如果 best 尚未被赋值,或者当前 peer 的 current_weight 更高,则更新 best

if (best == NULL || peer->current_weight > best->current_weight) {

best = peer;

}

}

// 如果没有找到任何可用的服务器(例如所有服务器都down了)

if (best == NULL) {

return NULL;

}

/* 关键步骤5: 调整被选中服务器 (best) 的 current_weight – 减去本轮的总有效权重 */

// 这是为了平衡后续轮次的服务器选择,避免该服务器因本次被选中而导致其 current_weight 持续过高

best->current_weight -= total;

return best; // 返回选中的最佳服务器

}

2.2 后端服务健康状态的动态感知与自适应调整

此算法着重解决的问题包括:

- 后端服务临时性不可用处理:后端服务节点可能由于各种原因(如程序崩溃、网络故障、依赖服务异常)而变得暂时不可用。

- 建立有效的错误惩罚机制:当检测到某个服务器出现异常时,需要有一种机制能够自动并及时地减少甚至暂停向该异常服务器发送新的请求,以避免雪崩效应。

- 赋予系统自动恢复的能力:当之前出现故障的服务器恢复正常服务后,负载均衡器应当能够自动侦测到其状态好转,并逐步将其重新纳入到正常的请求分发队列中。

NGINX提供的精巧解决方案:

以下 ngx_http_upstream_free_round_robin_peer 函数(通常在请求处理完毕后被调用)展示了其动态调整权重的逻辑。

/* 处理与后端服务器通信完成后的回调函数,用以更新peer状态 */

static void

ngx_http_upstream_free_round_robin_peer(ngx_peer_connection_t *pc, void *data,

ngx_uint_t state) // state 参数指明了本次连接的结果状态

{

ngx_http_upstream_rr_peer_data_t *rrp = data;

ngx_http_upstream_rr_peer_t *peer;

peer = rrp->current; // 获取本次请求实际使用的 peer 节点

/* 情况一:服务器连接失败或响应表明出现错误 (例如超时, 5xx错误等) */

if (state & NGX_PEER_FAILED) {

ngx_log_debug1(NGX_LOG_DEBUG_HTTP, pc->log, 0,

"free rr peer %ui FAILED", peer->id); // 记录调试日志

/* 增加该服务器的连续失败计数 */

peer->fails++;

peer->accessed = ngx_time(); // 更新最后访问时间

peer->checked = ngx_time(); // 更新最后检查(即失败)时间

/* 核心调整:显著降低该服务器的有效权重 (effective_weight) */

// 这里的策略是,每次失败,有效权重减少其初始配置权重 (weight) 的 1/8

// 这种递减方式使得服务器在连续失败时,其承接流量的能力迅速下降

peer->effective_weight -= peer->weight / 8;

/* 安全措施:确保有效权重 (effective_weight) 不会降至负数 */

if (peer->effective_weight < 0) {

peer->effective_weight = 0; // 最低为0,表示暂时不分配流量

}

} else { /* 情况二:服务器连接成功且响应正常 */

ngx_log_debug1(NGX_LOG_DEBUG_HTTP, pc->log, 0,

"free rr peer %ui OK", peer->id); // 记录调试日志

/* 如果服务器之前因失败导致有效权重降低,则逐步恢复其有效权重 */

if (peer->effective_weight < peer->weight) {

// 每次成功,有效权重增加其初始配置权重 (weight) 的 1/4

// 恢复速度通常设计得比降低速度慢一些,以更稳健地确认服务器已恢复

peer->effective_weight += peer->weight / 4;

// 确保恢复后的有效权重不会超过其原始配置的静态权重

if (peer->effective_weight > peer->weight) {

peer->effective_weight = peer->weight;

}

}

// 如果之前有失败记录,并且服务器持续一段时间表现良好,可以考虑重置失败计数 (fails)

// (具体重置逻辑可能在其他地方或依赖 fail_timeout)

if (peer->fails > 0 && (ngx_time() - peer->checked) > peer->fail_timeout) {

peer->fails = 0; // 如果超过静默期且表现良好,重置失败计数

}

}

}

在实际应用中的显著影响: 当集群中的某一台后端服务器开始出现故障迹象(例如,其响应时间显著变慢,或者频繁返回连接失败、超时等错误)时,NGINX的这套机制能够自动、迅速地降低该问题服务器的 effective_weight。其直接结果是,新的客户端请求将更少地被导向这个可能存在问题的服务器,而是更多地流向其他健康状况良好的服务器。这种处理方式不仅保障了用户体验,避免了将请求发送给一个缓慢或错误的服务器,同时也为出现问题的服务器提供了宝贵的恢复时间窗口,实现了某种程度上的系统自愈(self-healing)能力,提升了整体服务的韧性。

2.3 实现流量分配的平滑性与均衡性

此算法着重解决的问题包括:

- 避免短期内分配不均匀:简单的随机算法或朴素的轮询算法,在较短的时间窗口内,可能导致流量分配不均,某些服务器瞬时压力过大,而另一些则相对空闲。

- 应对突发性请求的合理分发:当系统遭遇大量并发请求突然涌入(例如秒杀活动、流量洪峰)时,需要一种能够迅速且按照预设比例将这些请求分散到各个服务器的机制。

- 提高集群整体资源利用效率:不恰当或不平滑的请求分配可能导致部分服务器资源紧张,而其他服务器资源未能得到充分利用,从而降低了整个集群的资源利用率和投资回报率。

NGINX提供的精巧解决方案:

以下是核心平滑加权轮询算法的伪代码,它清晰地展示了其选择逻辑。

/* 核心平滑权重选择算法的伪代码示意 */

function select_peer(peers_collection):

best_candidate = null // 用于存储本轮选中的最佳服务器

current_total_effective_weight = 0 // 用于累加本轮所有服务器的有效权重

// 第一步:遍历所有可用的服务器节点

for each peer_node in peers_collection:

// 前提:跳过已标记为不可用或不健康的服务器 (此处伪代码简化,实际实现中包含健康检查)

if peer_node.is_unavailable:

continue

// 核心机制1: 为每个服务器的 current_weight 增加其 effective_weight

// 这使得高权重的服务器的 current_weight 增长更快

peer_node.current_weight += peer_node.effective_weight

// 累加总有效权重,用于后续调整

current_total_effective_weight += peer_node.effective_weight

// 核心机制2: 选择 current_weight 最大的服务器作为当前的最佳候选

if best_candidate == null or peer_node.current_weight > best_candidate.current_weight:

best_candidate = peer_node

// 如果没有可选的服务器 (例如所有服务器都不可用)

if best_candidate == null:

return null // 返回空,表示无法选择

// 核心机制3: 选中最佳服务器后,调整其 current_weight

// 将其 current_weight 减去本轮所有服务器的有效权重之和 (current_total_effective_weight)

// 这一步是确保下一轮选择时,其他服务器也有机会被选中,从而实现平滑分配的关键

best_candidate.current_weight -= current_total_effective_weight

return best_candidate // 返回选中的服务器

在实际应用中的显著影响: NGINX所采用的这种平滑加权轮询算法,能够确保即使在非常短的时间跨度内(例如,在1秒钟内有数百个甚至数千个请求同时到达),这些请求的分配也能严格遵循管理员在配置文件中设定的权重比例。这就有效避免了传统简单加权轮询可能出现的"扎堆"现象——即在某一个短暂的时刻,某台服务器可能因随机性或轮询顺序而接收到远超其权重比例的请求,而其他服务器则相对空闲。其结果是更均匀的负载分布,更可预测的服务器性能,以及更高的整体系统稳定性。

2.4 提供配置的灵活性与卓越的易用性

此算法的设计兼顾了以下需求:

- 满足动态调整的运维需求:在实际运维过程中,业务负载和服务器状态是动态变化的,运维团队需要能够根据实时的业务发展、服务器扩容或缩容、以及临时的故障处理等情况,灵活调整各服务器的权重。

- 降低配置的整体复杂性:负载均衡系统的配置应该尽可能简单直观,易于理解和上手,以减少人为配置错误的可能性,并降低学习成本。

- 支持运行时的无缝调整能力:理想情况下,对服务器权重的调整或服务器列表的变更应支持在不中断现有服务(即"热加载"或"无停机")的前提下进行,以保障业务的连续性。

NGINX提供的精巧解决方案:

NGINX 通过其简洁明了的配置文件语法,极大地简化了负载均衡的配置。

# 一个简洁且功能强大的 upstream 配置语法示例

upstream backend_servers {

# server 指令用于定义一个后端服务器

# weight 参数指定该服务器的静态权重,数值越大,分配到的请求越多

server backend1.example.com weight=5; # 服务器1,权重为5

server backend2.example.com weight=1; # 服务器2,权重为1,处理能力相对较低或期望负载较少

server backend3.example.com weight=3; # 服务器3,权重为3

# backup 参数指定该服务器为备份服务器

# 仅当所有非备份服务器都不可用时,请求才会被转发到备份服务器

server backup1.example.com backup;

}

server {

listen 80;

location / {

# proxy_pass 指令将请求代理到名为 'backend_servers' 的上游服务器组

proxy_pass http://backend_servers;

}

}

在实际应用中的显著影响: NGINX这种简单而直观的配置方式,显著降低了运维人员的学习曲线和日常操作的出错概率。更为重要的是,NGINX支持在运行时通过发送特定信号(如 HUP)来重新加载配置文件,或者在 NGINX Plus 版本中通过其提供的 HTTP API 进行动态配置更新。这些特性使得运维团队可以在不停止 NGINX 服务、不中断用户请求的前提下,灵活调整后端服务器的权重、添加新服务器或移除故障服务器,从而实现了真正意义上的无停机服务调整和高度的运维灵活性。

3. 加权轮询算法核心操作的实现细节

3.1 初始化权重相关数据结构

此过程通常在NGINX加载配置文件并解析 upstream 块时执行。

static ngx_int_t

ngx_http_upstream_init_round_robin(ngx_conf_t *cf,

ngx_http_upstream_srv_conf_t *us) // us 指向 upstream 服务器配置块

{

ngx_http_upstream_rr_peers_t *peers; // 最终初始化的 peers 结构体

ngx_http_upstream_server_t *server_conf; // 指向配置文件中定义的单个 server

ngx_http_upstream_rr_peer_t *peer_runtime; // 指向运行时 peer 数组中的元素

ngx_uint_t i, n_servers, total_static_weight;

/* 步骤1: 为 peers 结构体分配内存空间,该结构体用于存储整个 upstream 的服务器信息 */

peers = ngx_pcalloc(cf->pool, sizeof(ngx_http_upstream_rr_peers_t));

if (peers == NULL) {

// 内存分配失败,返回错误

return NGX_ERROR;

}

/* 步骤2: 遍历配置文件中定义的所有 server,计算有效服务器数量和总静态权重 */

n_servers = 0; // 初始化有效服务器数量

total_static_weight = 0; // 初始化总静态权重

// us->servers 是一个 ngx_array_t,存储了所有 server 的配置信息

if (us->servers) { // 确保 servers 数组存在

server_conf_array = (ngx_http_upstream_server_t *)us->servers->elts;

for (i = 0; i < us->servers->nelts; i++) {

server_conf = &server_conf_array[i];

// 跳过被标记为 backup 的服务器,它们不参与常规的权重计算和初始分配

if (server_conf->backup) {

continue;

}

n_servers++; // 有效服务器数量加1

total_static_weight += server_conf->weight; // 累加静态权重

}

}

peers->number = n_servers; // 设置 peers 结构中的服务器数量

peers->total_weight = total_static_weight; // 设置 peers 结构中的总静态权重

peers->single = (n_servers == 1); // 如果只有一台服务器,设置 single 标记

peers->name = &us->host; // 设置 upstream 名称

/* 步骤3: 为存储所有运行时 peer 节点信息的数组 (peers->peer) 分配内存 */

// 注意:这里简化了 peers->peer 的实际创建,实际中 peers->peer 指向一个数组,

// 该数组的元素是 ngx_http_upstream_rr_peer_t

if (n_servers == 0 && !us->servers_backup) { // 如果没有主服务器且没有备份服务器

// 处理无服务器的情况,可能是配置错误

return NGX_ERROR;

}

// 假设 peers->peer 已经正确分配了包含 n_servers 个 ngx_http_upstream_rr_peer_t 的空间

// (实际代码中,这个数组的分配和填充更为复杂,涉及到主服务器和备份服务器的处理)

// 此处仅示意性地初始化每个 peer 的权重相关字段

// 再次遍历,为每个非备份服务器初始化其运行时 peer 结构

// (实际 NGINX 源码中,主服务器和备份服务器的 peer 是分开存储和处理的,

// peers->peer 通常指向主服务器 peer 链表的头部或数组的起始)

// 下面的循环是一个概念性的展示,实际初始化分布在多个函数和步骤中

// 伪代码示意初始化每个 peer

// for (i = 0; i < n_servers; i++) {

// // 获取配置中的 server 和运行时的 peer

// server_conf = ... ; // 对应配置

// peer_runtime = &peers->peer[i]; // 对应运行时的 peer 结构

// peer_runtime->weight = server_conf->weight; // 设置静态权重

// peer_runtime->effective_weight = server_conf->weight; // 初始有效权重等于静态权重

// peer_runtime->current_weight = 0; // 初始当前权重为0

// peer_runtime->fails = 0; // 初始失败次数为0

// peer_runtime->max_fails = server_conf->max_fails;

// peer_runtime->fail_timeout = server_conf->fail_timeout;

// // 其他字段如 sockaddr, name, checked, accessed 等也在此阶段或后续阶段被初始化

// }

// 将初始化完成的 peers 结构体关联到 upstream 配置的 peer.data 字段

// peer.data 是一个通用指针,用于存储特定负载均衡算法的私有数据

us->peer.data = peers;

us->peer.get = ngx_http_upstream_get_round_robin_peer; // 设置获取 peer 的回调函数

us->peer.free = ngx_http_upstream_free_round_robin_peer; // 设置释放 peer 的回调函数

// ... 其他 peer 初始化,如tries, next等

return NGX_OK; // 初始化成功

}

3.2 选择目标节点的具体算法实现

此函数在每次需要向上游服务器转发请求时被调用。

static ngx_int_t

ngx_http_upstream_get_round_robin_peer(ngx_peer_connection_t *pc, void *data)

{

ngx_http_upstream_rr_peer_data_t *rrp = data; // rrp 包含了 peers 和其他运行时数据

ngx_http_upstream_rr_peer_t *selected_peer; // 存储最终选择的 peer

ngx_http_upstream_rr_peers_t *server_group_peers; // 指向服务器组的 peers 结构

ngx_log_debug1(NGX_LOG_DEBUG_HTTP, pc->log, 0,

"get rr peer, try: %ui", pc->tries); // 记录尝试次数

server_group_peers = rrp->peers; // 获取服务器组信息

/* 优化路径:如果 upstream 中只有一台服务器 (single 标记为1) */

if (server_group_peers->single) {

selected_peer = server_group_peers->peers; // 直接获取唯一的 peer

// 检查这台唯一的服务器是否处于 down 状态 (例如,通过 max_fails 机制被标记)

if (selected_peer->down) {

// 如果唯一的服务器也 down 了,则无法选择,返回错误

// (实际 NGINX 会有更复杂的重试和 backup 逻辑)

return NGX_BUSY; // 或者 NGX_ERROR,取决于上下文

}

rrp->current = selected_peer; // 设置当前选中的 peer

pc->sockaddr = selected_peer->sockaddr; // 设置目标服务器的 socket 地址

pc->socklen = selected_peer->socklen; // 设置 socket 地址长度

pc->name = &selected_peer->name; // 设置目标服务器的名称 (用于日志等)

// selected_peer->conns++; // 增加连接计数 (如果实现了 least_conn 相关的逻辑)

return NGX_OK; // 选择成功

}

/* 标准路径:当有多台服务器时,执行加权轮询选择算法 */

// 调用前面分析过的 ngx_http_upstream_get_peer 函数 (实际可能是其内部版本或包装)

// ngx_http_upstream_get_peer 内部实现了平滑加权轮询和健康检查

selected_peer = ngx_http_upstream_get_peer(rrp);

if (selected_peer == NULL) {

// 如果 ngx_http_upstream_get_peer 未能选出任何服务器 (例如所有服务器都不可用)

// (实际 NGINX 可能会尝试 backup 服务器)

ngx_log_error(NGX_LOG_WARN, pc->log, 0, "all servers failed in upstream \"%V\"", server_group_peers->name);

return NGX_BUSY; // 表示暂时没有可用的上游服务器

}

// 成功选出一个 peer

ngx_log_debug2(NGX_LOG_DEBUG_HTTP, pc->log, 0,

"get rr peer, selected: %ui %V", selected_peer->id, &selected_peer->name);

rrp->current = selected_peer; // 设置当前选中的 peer

pc->sockaddr = selected_peer->sockaddr; // 设置目标服务器的 socket 地址

pc->socklen = selected_peer->socklen; // 设置 socket 地址长度

pc->name = &selected_peer->name; // 设置目标服务器的名称

// selected_peer->conns++; // 增加连接计数

return NGX_OK; // 选择成功

}

3.3 失败处理与权重动态调整机制

此函数在与上游服务器通信结束后被调用,根据通信结果 (state) 更新服务器状态。

static void

ngx_http_upstream_free_round_robin_peer(ngx_peer_connection_t *pc, void *data,

ngx_uint_t state) // state 包含连接成功/失败等状态位

{

ngx_http_upstream_rr_peer_data_t *rrp = data;

ngx_http_upstream_rr_peer_t *peer_node; // 本次连接的目标 peer

time_t now;

peer_node = rrp->current; // 获取当前处理的 peer 节点

now = ngx_time(); // 获取当前时间

/* 详细处理连接失败的情况 */

if (state & NGX_PEER_FAILED) {

peer_node->fails++; // 增加该 peer 的连续失败次数

peer_node->accessed = now; // 更新最后访问时间 (即本次失败的时间)

peer_node->checked = now; // 更新最后检查时间 (也即本次失败的时间)

/* 核心:根据失败次数和 max_fails 配置来调整 effective_weight 和 down 状态 */

// 如果连续失败次数尚未达到设定的 max_fails 阈值

if (peer_node->max_fails == 0 || peer_node->fails < peer_node->max_fails) {

// 适度减小其有效权重 (effective_weight)

// 这里的策略可以多样,例如 NGINX 源码中可能是 peer->effective_weight--

// 或者更复杂的递减,如示例中的除以2,但要确保不小于某个下限

if (peer_node->effective_weight > 0) { // 避免负权重或对0权重操作

// 示例性惩罚:有效权重减半,但不能低于其原始权重的1/4(或某个固定小值)

// peer_node->effective_weight /= 2;

// if (peer_node->effective_weight < peer_node->weight / 4 && peer_node->weight > 0) {

// peer_node->effective_weight = (peer_node->weight / 4 > 0) ? peer_node->weight / 4 : 1;

// } else if (peer_node->effective_weight == 0 && peer_node->weight > 0) {

// peer_node->effective_weight = 1; // 确保至少为1,除非原始权重为0

// }

// NGINX 源码中,当 fails < max_fails 时,effective_weight 通常会递减1

if (peer_node->effective_weight > 0) {

peer_node->effective_weight--;

}

}

} else { // 如果连续失败次数已达到或超过 max_fails 阈值

// 将该服务器标记为暂时不可用 (down)

// peer_node->down = 1; // (NGINX 中 down 状态通过 fails >= max_fails 和 checked时间判断)

// 其 effective_weight 通常会设置为0,表示在 fail_timeout 期间不再分配流量

peer_node->effective_weight = 0;

ngx_log_warn(pc->log, NGX_LOG_WARN, 0,

"upstream server %V marked as down due to %ui fails",

&peer_node->name, peer_node->fails);

}

} else { /* 处理连接成功的情况 (state 不包含 NGX_PEER_FAILED) */

// 如果服务器之前因失败导致有效权重降低,现在成功了,则逐步恢复其有效权重

if (peer_node->effective_weight < peer_node->weight) {

// 恢复策略:例如,每次成功,有效权重增加其原始配置权重的某个比例,或直接递增

// NGINX 源码中,effective_weight 会逐步增加,但不会超过 weight

// peer_node->effective_weight += peer_node->weight / 10; // 示例:增加10%

// if (peer_node->effective_weight > peer_node->weight) {

// peer_node->effective_weight = peer_node->weight; // 不超过原始权重

// }

// 更常见的做法是逐步增加,比如 effective_weight++ 直到等于 weight

peer_node->effective_weight++;

if (peer_node->effective_weight > peer_node->weight) {

peer_node->effective_weight = peer_node->weight;

}

}

/* 重置失败计数器的逻辑:如果服务器在一段时间内 (例如 fail_timeout) 持续成功响应,

或者本次成功发生在上次失败的 fail_timeout 之后,则可以重置 fails 计数器。 */

// (NGINX 中,fails 计数器主要通过 checked 和 fail_timeout 来间接实现"恢复期"后的重置)

// 当一个 peer 在 ngx_http_upstream_get_peer 中被选中时,如果它之前是 down 状态

// (即 fails >= max_fails && now - checked <= fail_timeout),

// 并且现在 now - checked > fail_timeout,那么它的 fails 会被重置为0。

// 此处 free peer 时,若成功,可以认为 checked 时间不需要更新,

// 这样 get_peer 中的逻辑就能正确判断是否过了 fail_timeout。

// 如果服务器是健康的 (fails < max_fails),那么 fails 计数器保持不变或在某些条件下清零。

if (peer_node->fails > 0 && (now - peer_node->checked) > peer_node->fail_timeout) {

peer_node->fails = 0; // 重置失败计数,表示服务器已恢复健康

ngx_log_debug1(NGX_LOG_DEBUG_HTTP, pc->log, 0,

"upstream server %V recovered", &peer_node->name);

}

// 无论成功失败,都更新 accessed 时间

peer_node->accessed = now;

}

// peer_node->conns--; // 减少连接计数 (如果实现了 least_conn 相关的逻辑)

}

4. NGINX加权轮询算法的时间复杂度深度分析

下表总结了NGINX加权轮询算法在不同操作场景下的时间复杂度:

| 情况/操作 | 时间复杂度 | 具体说明与考量 |

|---|---|---|

| 服务器选择 (Server Selection) | O(n) | 这表示算法的执行时间与活跃服务器的数量 (n) 成线性关系。在每次选择时,算法需要遍历所有(或大部分)当前被认为是健康的服务器节点,以计算和比较它们的 current_weight。 |

| 初始化 (Initialization) | O(n) | 在NGINX启动或重载配置文件时,需要为 upstream 块中定义的每个服务器 (n个) 初始化其对应的数据结构(如 ngx_http_upstream_rr_peer_t),包括权重的设置。 |

| 失败处理 (Failure Handling) | O(1) | 当一个与后端服务器的连接失败后,更新该服务器的状态(如增加 fails 计数、调整 effective_weight)通常是针对单个服务器节点的操作,因此其时间复杂度为常数级别。 |

| 配置重载 (Configuration Reload) | O(n) | 当NGINX接收到重载信号(如 SIGHUP)并重新加载配置文件时,如果 upstream 配置发生变化,原有的服务器数据结构可能需要被销毁并重新构建,这个过程的复杂度与服务器数量 (n) 相关。 |

| 单个请求的完整处理周期中的负载均衡部分 | O(n) | 对于每一个需要进行负载均衡的请求,其选择后端服务器的步骤是O(n)的。在高QPS(每秒查询率)的场景下,这部分开销的累积效应需要关注,但通常远小于网络I/O和后端应用处理的延迟。 |

尽管核心的选择操作具有 O(n) 的线性时间复杂度,但在绝大多数实际部署环境中,这种设计依然表现优异,原因在于:

- 服务器数量 ‘n’ 的典型规模可控:在一个上游服务器组中,后端服务器的数量 ‘n’ 通常维持在一个相对较小的范围内(例如,从几个到几十个,很少超过一百个)。在这个规模下,线性扫描的开销是完全可以接受的。

- 算法实现的极致简洁与高效:NGINX 的实现非常精炼,内部循环中的操作(主要是整数加法和比较)CPU执行效率极高,使得算法的常数因子(constant factor)非常小。

- 内存访问的连续性与缓存友好性:如前所述,NGINX倾向于将

peer节点存储在连续的内存数组中,这有利于CPU缓存的预取和命中,进一步降低了实际的内存访问延迟,使得遍历过程比理论上随机访问内存要快得多。

因此,在实践中,NGINX加权轮询算法的性能表现往往远好于其理论时间复杂度所可能暗示的担忧,能够轻松应对高并发、大流量的场景。

5. NGINX加权轮询与其他主流负载均衡算法的横向对比

| 特性维度 | 加权轮询 (Weighted Round Robin) | 一致性哈希 (Consistent Hashing) | 最少连接 (Least Connections) | IP哈希 (IP Hash) | 随机选择 (Random) |

|---|---|---|---|---|---|

| 核心时间复杂度 | O(n) - 选择过程 | O(log N) 或 O(K) - 查找/映射 | O(n) - 选择过程 | O(1) - 哈希计算 | O(1) - 随机数生成 |

| 内存占用情况 | 低 (存储节点状态) | 中 (哈希环/树结构) | 低 (需计数器) | 低 (哈希表可选) | 极低 |

| 请求分配均匀性 | 高 (尤其平滑加权算法) | 中 (受虚拟节点数影响) | 高 (动态适应负载) | 低 (易受IP分布影响) | 中 (概率性) |

| 会话粘性支持 | 无内置 (需配合其他机制) | 天然支持 (缓存场景优势) | 无内置 | 天然支持 | 无内置 |

| 动态调整能力 | 高 (通过权重和健康检查) | 低 (节点增删影响部分映射) | 高 (实时反馈连接数) | 低 (基于固定IP) | 低 (无状态) |

| 算法实现复杂度 | 中等 | 较高 | 中等 | 较低 | 最低 |

| 典型适用场景 | 通用Web服务、API网关 | 分布式缓存、CDN节点选择 | 长连接、计算密集型服务 | 有状态应用、会话保持 | 简单、低要求场景 |

| 对后端性能敏感度 | 中 (通过权重间接反映) | 低 | 高 (直接反映处理速度) | 低 | 低 |

此对比突出了加权轮询在分配均匀性和动态调整能力方面的优势,同时也指出了其在会话粘性等方面的天然不足(需额外机制补充)。

6. 加权轮询算法实现中的关键优化策略剖析

NGINX在其加权轮询算法的实现中,融入了多项关键优化,以确保其高效、稳定和公平。

6.1 精妙的平滑权重算法 (Smooth Weighted Round Robin)

NGINX采用的并非简单的加权轮询,而是经过优化的平滑加权轮询算法,这种算法能确保在连续的请求中,流量分配更加均匀,更精确地逼近配置的权重比例:

// 平滑加权轮询算法的核心实现逻辑回顾

ngx_http_upstream_rr_peer_t *

ngx_http_upstream_get_peer(ngx_http_upstream_rr_peer_data_t *rrp)

{

ngx_http_upstream_rr_peer_t *peer_iterator, *best_candidate; // 迭代器和最佳候选

ngx_http_upstream_rr_peers_t *server_group; // 服务器组

ngx_uint_t current_round_total_effective_weight; // 本轮总有效权重

server_group = rrp->peers;

best_candidate = NULL;

current_round_total_effective_weight = 0;

// 遍历所有(健康的)服务器节点

for (peer_iterator = server_group->peers; /* assuming array or needs proper iteration */; /* peer_iterator = peer_iterator->next or ++ */) {

// (此处省略了对 peer_iterator->down 和健康检查的判断,实际代码会包含)

if (peer_iterator->down /* || health_check_failed(peer_iterator) */) {

continue; // 跳过不可用服务器

}

// 核心步骤1: 每个服务器的 current_weight 增加其 effective_weight

peer_iterator->current_weight += peer_iterator->effective_weight;

// 累加本轮所有参与选择的服务器的有效权重

current_round_total_effective_weight += peer_iterator->effective_weight;

// 核心步骤2: 选择当前 current_weight 最高的节点作为最佳候选

if (best_candidate == NULL || peer_iterator->current_weight > best_candidate->current_weight) {

best_candidate = peer_iterator;

}

}

// 如果没有可选的服务器(例如全部宕机)

if (best_candidate == NULL) {

return NULL;

}

// 核心步骤3: 选中的最佳服务器的 current_weight 减去本轮的总有效权重

// 这是实现"平滑"的关键,用于平衡下一轮的选择

best_candidate->current_weight -= current_round_total_effective_weight;

return best_candidate; // 返回选中的服务器

}

这个平滑算法具有以下显著特点和优势:

- 确保权重比例的精确执行:它能够保证在任意连续的

sum(weights)个请求中(理论上),每个服务器接收到的请求数量严格与其配置的权重成正比,而非仅仅是概率上的趋近。 - 有效避免简单加权轮询的分配不均:传统的加权轮询可能在短期内(例如,权重为A:5, B:1时,可能出现连续5个A,再1个B的情况),而平滑算法则会交错分配(如A,A,A,B,A,A),使得分配更为平缓。

- 在请求量较少时依然保持分配平滑性:即使在短时间内总请求数量不多,该算法也能较好地维持权重比例,不会出现剧烈的流量倾斜。

6.2 智能的动态权重调整机制

NGINX不仅仅依赖静态配置的权重,它还会根据后端服务器的实际响应情况,智能地、动态地调整其 effective_weight(有效权重):

// 请求完成后,根据成功或失败状态进行权重调整的逻辑片段

if (state & NGX_PEER_FAILED) { // 如果请求失败

// 失败时,按比例降低该服务器的有效权重

peer->effective_weight -= peer->weight / 8; // 例如,减去原始权重的1/8

// 确保有效权重不会降至负数或过低的值

if (peer->effective_weight < 0) { // 严格来说应检查是否小于某个设定的最小值

peer->effective_weight = 0; // 或设置为一个非常小的正数,如1

}

} else { // 如果请求成功

// 成功时,逐步恢复该服务器的有效权重,但不能超过其原始配置权重

if (peer->effective_weight < peer->weight) {

peer->effective_weight += peer->weight / 4; // 例如,增加原始权重的1/4

if (peer->effective_weight > peer->weight) { // 上限检查

peer->effective_weight = peer->weight;

}

}

}

这种自适应的权重调整机制带来了以下重要优势:

- 快速响应服务器状态的实时变化:当某个服务器开始出现问题(如响应超时、错误增多)时,其有效权重会迅速下降,从而自动减少分配给它的新请求流量,保护了整体服务的可用性。

- 平滑地恢复服务器的承载能力:当问题服务器恢复正常后,其有效权重会逐步增加,避免了服务器刚一恢复就立即被大量请求淹没的风险,实现了"慢启动"式的流量回归。

- 通过比例调整适应不同初始权重:权重调整的幅度是基于服务器原始配置权重 (

peer->weight) 的比例,而非一个固定的绝对值,这使得该机制能更好地适应不同初始权重配置的服务器,调整更为合理。

6.3 精心优化的内存布局

NGINX 在设计其核心数据结构时,非常注重内存布局的优化,以提升CPU缓存的利用效率和整体性能:

- 服务器列表优先采用数组存储:对于上游服务器组中的

peer节点,当数量固定或可预估时,NGINX倾向于使用连续的内存数组来存储它们。这样做极大地提高了缓存局部性(cache locality),CPU在访问一个peer后,相邻的peer数据很可能已经在缓存中,从而加快了遍历速度。 - 相关配置参数组织紧凑:在

ngx_http_upstream_rr_peer_t这样的结构体中,相互关联的配置参数(如weight,effective_weight,current_weight,fails,max_fails,fail_timeout等)被组织在一起。这减少了访问这些数据时可能发生的内存跳转和缓存未命中次数。 - 热路径数据优先考量:在结构体定义中,那些在请求处理热路径上被频繁访问的数据(例如各种权重值、失败计数器)通常会放在结构体定义的前部或者精心安排其位置,以期进一步优化CPU缓存的命中率,减少内存访问延迟。

这些看似微小的内存布局考量,在高并发场景下能够累积产生显著的性能提升。

6.4 贯彻极简主义的设计哲学

NGINX 的整体设计哲学——追求高性能、高稳定性、低资源消耗和简洁性——也深刻体现在其加权轮询算法的实现之中:

- 算法逻辑清晰且简洁高效:加权轮询(尤其是平滑版本)的核心逻辑相对直观,代码实现也力求精炼,没有不必要的复杂性,这使得代码量较小,易于理解、调试和维护。

- 审慎选择数据结构,避免过度复杂化:NGINX 在此场景

在实际应用中的显著影响: 在包含不同配置和性能服务器的混合部署环境中(例如,部分新购高性能服务器与部分老旧低性能服务器并存),NGINX能够依据这些服务器的性能差异进行合理且智能的流量分配。这确保了高性能服务器可以处理与其能力相称的更多请求,而低性能服务器则不会因接收过多请求而过载,从而显著提高了整个集群的吞吐量、降低了平均响应时间,并提升了系统的整体稳定性。

7. NGINX加权轮询在实际生产环境中的多样化应用

NGINX的加权轮询算法因其灵活性和高效性,在各种实际部署场景中得到了广泛应用。

7.1 典型的基础配置示例

以下是一个常见的NGINX配置,展示了如何使用加权轮询来管理一组后端服务器:

http {

# 定义一个名为 'backend' 的上游服务器组

upstream backend {

# 基础权重配置:根据服务器处理能力分配不同的权重

server backend1.example.com weight=5; # 服务器1,处理能力强

server backend2.example.com weight=1; # 服务器2,处理能力较弱

server backend3.example.com weight=3; # 服务器3,处理能力中等

# 健康检查相关参数配置 (NGINX开源版主要依赖被动检测,NGINX Plus有主动检测)

# max_fails: 连续失败多少次后认为服务器不可用

# fail_timeout: 服务器被认为不可用后,在多长时间内不尝试连接

server backend4.example.com max_fails=3 fail_timeout=30s weight=2; # 服务器4,配置了健康检查参数

# 配置备份服务器:仅当所有主服务器都不可用时,流量才会导向备份服务器

server backup1.example.com backup;

# 可选的负载均衡指令,可以与加权轮询结合或替换它 (注意:某些指令会覆盖默认的轮询行为)

# least_conn; # 如果启用,则优先选择当前活动连接数最少的服务器(会覆盖轮询)

# ip_hash; # 如果启用,则基于客户端IP哈希选择服务器,实现会话保持(会覆盖轮询)

# hash $request_uri consistent; # NGINX Plus: 基于请求URI的一致性哈希

# 与上游服务器保持长连接,减少连接建立开销

keepalive 32; # 每个worker进程向上游服务器保持最多32个空闲长连接

}

server {

listen 80;

server_name example.com;

location / {

proxy_pass http://backend; # 将请求代理到 'backend' 上游服务器组

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

# 其他代理相关配置...

}

}

}

这个示例清晰地展示了如何通过 weight 参数控制流量分配比例,以及如何配置 max_fails 和 fail_timeout 来实现基本的故障转移,同时 backup 服务器提供了额外的冗余保障。

7.2 针对特定实际场景的配置优化策略

根据不同的业务需求和服务器环境,NGINX的加权轮询配置可以进行精细化调整:

场景一:异构服务器集群(服务器性能不一)

当集群中包含不同硬件配置(CPU、内存、磁盘I/O、网络带宽)的服务器时,精确配置权重至关重要:

upstream api_servers {

# 高性能服务器 (例如:新款、高配置) 获得显著更高的权重,以承载更多流量

server powerful-server.example.com weight=8; # 假设此服务器处理能力是基准的8倍

# 中等性能服务器配置适中权重

server medium-server.example.com weight=4; # 处理能力是基准的4倍

# 低性能或老旧服务器配置较低权重,仅处理少量流量或作为补充

server small-server.example.com weight=1; # 基准处理能力

}

通过这种方式,可以确保每台服务器都在其能力范围内工作,最大化集群整体处理能力并避免瓶颈。

场景二:考虑网络延迟的就近转发配置

在地理分布式部署中,虽然NGINX本身不直接进行基于延迟的路由,但可以通过在不同区域部署NGINX实例,并配置权重以优先本地服务器:

# 假设此NGINX实例部署在A区域

upstream backend_services_in_region_A {

# A区域内的本地服务器获得最高权重,以实现最低延迟访问

server local-server-in-A.example.com weight=10;

# 其他区域的服务器作为容灾或溢出选项,权重较低

server remote-server-in-B.example.com weight=3;

server remote-server-in-C.example.com weight=1;

}

这种配置结合地理DNS或Anycast技术,可以有效地将用户请求导向最近或网络条件最佳的数据中心。

场景三:实现平滑的灰度发布(Canary Release)

当发布新版本的应用程序时,可以使用权重来控制新旧版本间的流量分配,逐步验证新版本的稳定性:

upstream application_stack {

# 旧版本(v1)服务器承载大部分生产流量

server app-v1.example.com weight=9;

# 新版本(v2)服务器初始配置较低权重,仅接收少量(例如10%)流量用于测试和监控

server app-v2-canary.example.com weight=1; # 新版本,灰度流量

}

# 运维人员可以根据v2版本的表现(错误率、性能指标)逐步增加其权重,

# 同时减少v1的权重,直至v2完全替代v1。

这种策略大大降低了新版本上线带来的风险。

7.3 借助NGINX Plus实现动态调整与精细化监控

NGINX的商业版本 NGINX Plus 提供了更为强大和便捷的动态调整及监控能力,进一步增强了加权轮询的实用性:

通过API进行动态配置:

NGINX Plus 暴露了一个 HTTP API,允许在不重新加载整个NGINX配置(nginx -s reload)的情况下,实时修改上游服务器组的属性,包括单个服务器的权重、状态(up/down/draining)等。

# 示例:NGINX Plus API 端点配置

server {

listen 8080; # API监听的端口

location /api {

api write=on; # 开启API,并允许写操作

# 安全控制:通常只允许本地或信任网络访问

allow 127.0.0.1;

allow 192.168.1.0/24;

deny all;

}

}

使用curl等工具通过API动态调整服务器权重:

假设有一个名为 backend 的上游组,其中第一个服务器(索引为0)的权重需要从当前值调整为8。

# 动态调整上游组 'backend' 中索引为0的服务器的权重为8

# (API版本号 '6' 可能因NGINX Plus版本而异)

curl -X PATCH -d '{"weight": 8}' http://nginx-plus-instance:8080/api/6/http/upstreams/backend/servers/0

还可以动态添加或移除服务器,或者将服务器设置为 drain 模式以实现优雅下线。

通过API获取详细的监控数据和权重分配效果:

NGINX Plus API 同样可以用于获取关于上游服务器组的详细实时统计信息,包括每个服务器的健康状态、活动连接数、请求计数、响应时间、数据传输量以及当前的有效权重等。

# 查看名为 'backend' 的上游服务器组中所有服务器的当前状态和统计数据

curl http://nginx-plus-instance:8080/api/6/http/upstreams/backend/servers

这些监控数据对于理解实际的流量分配效果、排查问题以及自动化运维决策至关重要。

这些高级功能使得NGINX Plus在需要高度动态和精细化管理的复杂环境中表现更为出色。

8. 加权轮询算法所体现的卓越工程设计价值

NGINX加权轮询算法的实现不仅仅是一个算法的简单堆砌,它更体现了NGINX团队深厚的工程设计功底和对实际应用场景的深刻理解。

8.1 算法设计所遵循的核心原则

NGINX在其加权轮询算法的设计与实现中,处处体现了以下关键的设计原则:

- 简单、高效且实用 (Simple, Effective, and Practical):算法的核心逻辑力求简单明了,易于理解、实现和维护,同时确保在真实世界场景中能够高效运行并产生预期的负载均衡效果。避免了不必要的复杂性。

- 强大的自适应调整能力 (Strong Adaptive Adjustment):通过动态调整服务器的

effective_weight以响应其健康状况和性能表现,算法能够自动适应后端集群的变化,无需人工干预,提升了系统的鲁棒性和自愈能力。 - 追求流量分配的平滑性 (Smooth and Fair Distribution):采用平滑加权轮询机制,确保即使在短时间内,请求也能尽可能精确地按照配置的权重比例平稳地分配到各个服务器,避免了流量的剧烈波动和分配不均。

- 内建完善的容错设计 (Built-in Fault Tolerance):算法与健康检查机制紧密集成,能够优雅地处理服务器故障,自动降低或移除问题服务器的流量,并在其恢复后逐步将其重新纳入服务,保障了整体服务的高可用性。

这些原则共同确保了NGINX负载均衡功能既强大又可靠。

8.2 卓越的代码质量与高度的可维护性

NGINX的源代码以其高质量和良好的工程实践而闻名,这一点在其负载均衡模块中也得到了充分体现:

- 周到且完善的注释信息 (Comprehensive Comments):在关键的算法逻辑、数据结构定义以及重要的设计决策点,通常都伴有清晰、详细的注释,极大地帮助了开发者理解代码意图和后续维护。

- 清晰一致的命名规范 (Clear and Consistent Naming Conventions):变量名、函数名以及宏定义等都遵循一套清晰且具有表达力的命名规范,使得代码更易读懂,降低了理解门槛。

- 高度模块化的结构设计 (Modular Design):负载均衡逻辑(包括各种算法)被良好地封装在独立的模块或代码段中,与其他核心功能(如HTTP解析、事件处理)保持较低的耦合度,便于单独升级、测试或替换。

- 统一且健壮的错误处理机制 (Consistent Error Handling):NGINX拥有一套统一的错误码定义、错误检查模式和日志记录机制,这使得问题排查更为高效,并增强了系统的整体稳定性。

这些特性共同构成了NGINX代码库坚实的基础,也是其能够持续演进和被广泛信赖的重要因素。

8.3 优先考虑实际应用效果与性能

NGINX在算法选择和实现细节上,始终将实际部署中的运行效果和运维便利性置于理论上的完美或极端情况的优化之上:

- 算法复杂度与实现成本的审慎均衡:尽管O(n)的服务器选择复杂度在理论上并非最优,但考虑到实际场景中n通常不大,NGINX选择了这种实现简洁、常数因子小、易于维护的方案,而不是引入更复杂但可能带来额外开销的数据结构。

- 针对常见使用场景的深度优化:NGINX的许多优化是针对最常见的Web服务和反向代理场景进行的,确保在这些核心场景下性能卓越,而非过度优化那些边缘或极端情况。

- 充分考虑硬件特性与性能影响:在数据结构设计和代码实现中,NGINX的开发者会潜移默化地考虑到现代CPU的缓存层次结构、内存访问模式等硬件特性,力求编写出缓存友好、执行高效的代码。

- 力求配置的简便性与直观性:负载均衡功能的配置方式设计得简单直观,易于上手,大大降低了用户的使用门槛和配置错误的可能性,使得用户能快速上手并有效利用其功能。

9. 加权轮询算法的核心技术深度剖析与原理阐释

9.1 平滑权重算法 (Smooth Weighted Round-Robin) 的核心运作原理

平滑加权轮询算法旨在解决传统加权轮询可能出现的短期分配不均问题,其核心思想可以概括为以下几个步骤的循环:

-

候选者权重累加 (Candidate Weight Accumulation):

在每一轮选择开始时,对于集群中所有当前健康且可用的服务器,将其自身的effective_weight(有效权重)累加到其current_weight(当前动态调度权重)上。这意味着,effective_weight越高的服务器,其current_weight在此步骤后增长得越快。 -

选择当前权重最高者 (Selection of Maximum Current Weight):

遍历所有参与本轮选择的服务器,找出那个current_weight值最大的服务器。这个服务器即被选为本轮处理请求的最佳候选者。 -

选中者权重回退调整 (Selected Candidate Weight Reduction):

对于上一步被选中的服务器,将其current_weight减去本轮所有参与选择的服务器的effective_weight之总和。这个关键的"回退"操作是为了平衡后续的选择,避免高权重服务器在初始阶段被过度连续选中,从而使得其他服务器也有机会被选中,使整体分配趋向平滑。 -

周而复始的循环过程 (Iterative Process):

当下一次请求到来时,重复上述步骤1至3,从而持续地、平滑地将请求分配到各个服务器。

数学上的直观解释与效果保证:

可以证明(例如通过跟踪权重变化或归纳法),在一个由N台服务器组成的集群中,如果它们的权重分别为 w1, w2, ..., wN,那么在连续的 Sum(wi)(即所有服务器权重之和)次请求选择中,每台服务器 i 将精确地被选中 wi 次。这确保了请求分配严格按照配置的权重比例进行,并且过程是平滑的,而非简单轮询可能出现的集中分配。

一个简化的示例来说明(假设服务器A、B、C的权重分别为5, 1, 1,总权重为7):

(注意:此处的 current_weight 是简化示意,实际NGINX实现中 total_weight 指的是所有服务器 effective_weight 的总和)

| 轮次 | 初始/调整前 current_weight (A,B,C) | 计算过程 (peer.cw += peer.ew) & 选出best | best.cw -= total_ew (假设total_ew=7) | 调整后 current_weight (A,B,C) | 分配序列 |

|---|---|---|---|---|---|

| 1 | [0,0,0] | A: 0+5=5 (best), B: 0+1=1, C: 0+1=1 | A: 5-7 = -2 | [-2,1,1] | A |

| 2 | [-2,1,1] | A: -2+5=3 (best), B: 1+1=2, C: 1+1=2 | A: 3-7 = -4 | [-4,2,2] | A,A |

| 3 | [-4,2,2] | A: -4+5=1, B: 2+1=3 (best), C: 2+1=3 | B: 3-7 = -4 | [1,-4,3] | A,A,B |

| 4 | [1,-4,3] | A: 1+5=6 (best), B: -4+1=-3, C: 3+1=4 | A: 6-7 = -1 | [-1,-3,4] | A,A,B,A |

| 5 | [-1,-3,4] | A: -1+5=4, B: -3+1=-2, C: 4+1=5 (best) | C: 5-7 = -2 | [4,-2,-2] | A,A,B,A,C |

| 6 | [4,-2,-2] | A: 4+5=9 (best), B: -2+1=-1, C: -2+1=-1 | A: 9-7 = 2 | [2,-1,-1] | A,A,B,A,C,A |

| 7 | [2,-1,-1] | A: 2+5=7 (best), B: -1+1=0, C: -1+1=0 | A: 7-7 = 0 | [0,0,0] | A,A,B,A,C,A,A |

经过7轮后,A被选中5次,B被选中1次,C被选中1次,恰好符合权重5:1:1,且分配过程相对交错。current_weight 也回归初始状态 [0,0,0],开始循环。

9.2 精密的动态权重调整机制与策略

NGINX 中 effective_weight 的动态调整策略,是对服务器健康状况变化的一种自适应响应机制,其核心设计考虑如下:

- 权重下调策略 (Weight Reduction on Failure):当 NGINX 检测到对某个后端服务器的连接尝试失败或收到错误响应时(例如超时、5xx错误),它会启动惩罚机制。通常,该服务器的

effective_weight会按其原始配置weight的一定比例减少。例如,在某些实现中可能是peer->effective_weight -= peer->weight / 8。这种按比例的减少比固定值减少更为灵活,能适应不同初始权重的服务器。 - 权重恢复策略 (Weight Restoration on Success):相反,当之前表现不佳的服务器开始持续成功响应请求时,NGINX 会逐步恢复其

effective_weight。恢复过程通常也是渐进式的,例如peer->effective_weight++;。恢复过程通常比惩罚过程更平缓,以确保服务器确实稳定恢复。 - 权重上下限控制 (Weight Boundary Control):

effective_weight的调整始终受到其上下限的约束。它永远不会低于0(表示服务器暂时完全不接收流量),也永远不会超过其在配置文件中设定的原始静态权重weight(表示服务器已恢复到最佳状态)。

这种精心设计的动态调整机制具有以下几个重要特性和优势:

- 渐进式变化,避免系统震荡:权重的调整是逐步进行的,而不是突变式的,这有助于维持系统的整体稳定性,避免因权重剧烈变化导致的流量分配震荡。

- 赋予系统自恢复能力:对于暂时性的网络抖动或服务器短暂故障,该机制允许服务器在问题解决后自动、平滑地恢复其在集群中的服务能力和流量份额。

- 基于比例的调整,适应多样化配置:调整的幅度(无论是减少还是增加)通常与其原始配置权重成正比,这使得该机制能够公平且有效地应用于具有不同处理能力(即不同初始权重)的服务器集群。

9.3 健康检查 (Health Check) 的无缝集成

NGINX 的加权轮询算法与其健康检查机制是紧密集成、协同工作的,共同保障了负载均衡的可靠性。

// 在 ngx_http_upstream_get_peer 函数内部,选择服务器前会进行健康状态判断

if (peer->max_fails > 0 // 检查是否配置了最大失败次数

&& peer->fails >= peer->max_fails // 检查当前连续失败次数是否已达到上限

&& (ngx_time() - peer->checked) <= peer->fail_timeout) // 检查是否仍在失败超时窗口期内

{

// 如果上述条件均满足,则认为此服务器当前不健康

continue; // 在本轮选择中跳过此不健康的服务器,不参与 current_weight 的计算和比较

}

// 如果服务器通过了上述检查,则继续参与 current_weight 的累加和选择逻辑 ...

这种深度的集成提供了多层次、多维度的故障侦测与处理能力:

- 被动健康检测 (Passive Health Checks):这是NGINX开源版本的主要健康检查方式。NGINX在每次尝试向上游服务器转发请求时,会根据连接结果(成功、超时、错误响应等)来更新该服务器的

fails计数和effective_weight。这是一种基于实际交互结果的"事后"检测。 - 主动健康探测 (Active Health Checks - NGINX Plus):NGINX Plus 版本提供了更为完善的主动健康检查功能。它可以配置为定期、独立地向上游服务器发送特定的探测请求(如HTTP GET、TCP连接探测),并根据探测结果(如响应码、响应内容、连接成功与否)来判断服务器的健康状况,从而更早、更主动地发现问题。

- 权重与健康状态的联动效应 (Synergy between Weight and Health Status):服务器的健康状态直接影响其是否参与本轮的负载均衡选择。一个被健康检查机制标记为"down"的服务器,其实际上其

effective_weight可能已被降为0,或者在选择逻辑中被直接跳过,从而确保不会有新的流量被导向已确认存在问题的服务器。当服务器从"down"状态恢复时(例如fail_timeout过期),其effective_weight也会逐步恢复。

9.4 NGINX商业版 (NGINX Plus) 的功能增强与扩展

在开源版NGINX坚实的基础上,其商业版本 NGINX Plus 针对企业级应用场景的需求,增加了许多更高级和更完善的功能,特别是在负载均衡和流量管理方面:

- 高级会话持久性 (Advanced Session Persistence):除了开源版提供的

ip_hash,NGINX Plus 提供了基于 Cookie 的会话粘性(sticky cookie)、基于特定路由的粘性(sticky route)以及学习型粘性(sticky learn)等多种更灵活和强大的会话保持机制。这对于需要维持用户会话状态的有状态应用(如购物车、在线银行等)至关重要,确保用户的连续请求被导向同一个后端服务器。 - 运行时动态重配置与服务器管理API (Dynamic Reconfiguration API):NGINX Plus 提供了一套功能完善的 HTTP API,允许管理员或自动化系统在运行时动态地添加、移除上游服务器,修改服务器的权重、状态(up/down/draining),调整健康检查参数等,而无需重新加载整个NGINX配置文件。这极大地提高了运维的灵活性和响应速度。

- 复杂且可定制的主动健康检查 (Advanced Active Health Checks):NGINX Plus 的主动健康检查功能更为强大,支持多种探测协议(TCP, HTTP, gRPC, UDP等),可以自定义请求内容和期望的响应状态码/内容,甚至可以配置健康检查的频率、超时和重试次数,从而实现对后端服务更精细、更准确的健康状态监控。

- 详尽的监控指标与仪表盘 (Detailed Monitoring Metrics & Dashboard):NGINX Plus 提供了更为丰富和细粒度的监控指标,通过其 API 或内置的实时活动监控仪表盘,可以清晰地看到每个上游服务器组、每个服务器的请求计数、活动连接数、响应时间分布、错误率、数据吞吐量、当前有效权重等关键性能数据。这些数据为容量规# NGINX负载均衡加权轮询算法源码深度剖析

10. 加权轮询算法的性能特性深入分析与优化考量

对算法性能的透彻理解是评估其适用性和进行优化的前提。

10.1 时间复杂度具体构成与实际影响分析

下表更细致地剖析了NGINX加权轮询算法各关键操作的时间复杂度及其在实际运行中的考量:

| 操作环节 | 理论时间复杂度 | 关键影响因素与实际考量 |

|---|---|---|

| 服务器选择(核心) | O(n) | ‘n’ 是当前活跃(非down状态且未在fail_timeout内)的服务器数量。算法需要遍历这 ‘n’ 个服务器,进行 current_weight 的累加和比较。虽然是线性复杂度,但由于 ‘n’ 在多数场景下不大(例如几十个),且操作本身简单(几次加法和比较),常数因子极小,实际开销通常很低。 |

| 失败/成功后处理 | O(1) | 在一次请求与后端服务器交互完成后,更新该服务器的 fails 计数、effective_weight 等状态信息,这些操作直接针对已知的 current peer,因此是常数时间操作。 |

| 配置初始化/重载 | O(N) | ‘N’ 是配置文件中声明的总服务器数量(包括主服务器和备份服务器)。在NGINX启动或执行 reload 操作时,需要为所有服务器构建或更新其内部数据结构,这是一个与服务器总数成线性关系的过程。 |

| 单个请求的完整处理周期中的负载均衡部分 | O(n) | 对于每一个需要进行负载均衡的请求,其选择后端服务器的步骤是O(n)的。在高QPS(每秒查询率)的场景下,这部分开销的累积效应需要关注,但通常远小于网络I/O和后端应用处理的延迟。 |

尽管核心的选择操作具有 O(n) 的线性时间复杂度,但在绝大多数实际部署环境中,这种设计依然表现优异,原因在于:

- 服务器数量 ‘n’ 的典型规模可控:在一个上游服务器组中,后端服务器的数量 ‘n’ 通常维持在一个相对较小的范围内(例如,从几个到几十个,很少超过一百个)。在这个规模下,线性扫描的开销是完全可以接受的。

- 算法实现的极致简洁与高效:NGINX 的实现非常精炼,内部循环中的操作(主要是整数加法和比较)CPU执行效率极高,使得算法的常数因子(constant factor)非常小。

- 内存访问的连续性与缓存友好性:如前所述,NGINX倾向于将

peer节点存储在连续的内存数组中,这有利于CPU缓存的预取和命中,进一步降低了实际的内存访问延迟,使得遍历过程比理论上随机访问内存要快得多。

因此,在实践中,NGINX加权轮询算法的性能表现往往远好于其理论时间复杂度所可能暗示的担忧,能够轻松应对高并发、大流量的场景。

10.2 空间复杂度优化与内存占用分析

NGINX 在实现加权轮询算法时,对空间复杂度和内存占用的控制同样非常出色和高效:

- 每个服务器节点占用固定且较小的内存空间:

ngx_http_upstream_rr_peer_t结构体的大小是固定的,包含了权重、状态、服务器地址等必要信息。每个服务器实例在内存中对应这样一个结构体,其占用的字节数是可预测且相对较小的。 - 无需额外的复杂索引结构:与某些可能使用堆(Heap)、平衡树(Balanced Tree)或其他复杂数据结构来优化选择过程的负载均衡算法不同,NGINX的平滑加权轮询通过巧妙的算法逻辑在简单的线性结构(数组)上实现了高效选择,从而避免了这些复杂结构带来的额外内存开销和管理成本。

- 整体空间使用与服务器数量成正比,即 O(N):对于一个包含 ‘N’ 个服务器(包括主备)的上游组,其负载均衡相关的内存占用主要由这 ‘N’ 个

ngx_http_upstream_rr_peer_t结构体以及一个ngx_http_upstream_rr_peers_t结构体构成。因此,总的空间复杂度是 O(N),这是一种非常经济和可扩展的内存使用模式。 - 内存池的高效利用:NGINX 广泛使用其自有的内存池(

ngx_pool_t)来管理这些数据结构的分配和释放。内存池机制有助于减少内存碎片,提高内存分配效率,并且在请求处理完毕或配置重载时能够快速、完整地回收相关内存。

综上所述,NGINX 的加权轮询算法在空间效率方面表现优异,对系统内存资源的消耗非常经济,对于资源受限的环境或追求极致性能的场景尤为重要。

11. NGINX加权轮询算法在不同应用场景下的深度应用与分析

NGINX的加权轮询因其通用性和可配置性,能够灵活适应多种复杂的应用场景。

11.1 在Web应用集群中的经典负载均衡应用

Web应用集群是负载均衡最常见的应用场景之一,其核心特点通常包括:

- 高并发请求处理需求:需要能够公平且高效地将大量并发用户请求分发到后端的多个Web服务器实例。

- 服务器性能可能存在异构性:集群中的服务器可能在CPU、内存、网络带宽等硬件配置上存在差异,需要按能力分配流量。

- 请求处理时间存在波动:不同类型的Web请求(如静态资源获取、动态页面生成、数据库查询等)其处理时间可能差异巨大。

- 服务状态多样性:可能同时包含无状态的Web服务和需要会话保持的有状态应用(尽管加权轮询本身不直接提供会话保持,但可以与其他机制结合)。

NGINX加权轮询在此场景下的典型配置与应用考量:

upstream web_application_cluster {

# 核心原则:权重配置应尽可能精确匹配各服务器的实际处理能力(如CPU核心数、内存大小、磁盘I/O等综合评估)

# 精确配置权重比例,确保高性能服务器承担更多流量

server web_server_node1.example.com weight=8; # 例如,一台配置为16核CPU、32GB内存的服务器

server web_server_node2.example.com weight=4; # 例如,一台配置为8核CPU、16GB内存的服务器

server web_server_node3.example.com weight=2; # 例如,一台配置为4核CPU、8GB内存的老旧服务器

# 为关键服务器配置合理的健康检查参数,以便快速隔离故障节点

# max_fails=2: 连续2次失败即认为不可用

# fail_timeout=30s: 标记不可用后,30秒内不尝试连接,给其恢复时间

server web_server_node4.example.com max_fails=2 fail_timeout=30s weight=8; # 另一台高性能服务器

# 配置备份服务器,作为整个集群的高可用性保障

# 仅当所有主服务器 (web_server_node1 至 web_server_node4) 都故障时,流量才会导向此备份服务器

server backup_web_server.example.com backup;

# 考虑为上游连接启用 keepalive,以减少频繁建立TCP连接的开销

keepalive 64; # 每个worker进程向上游服务器保持最多64个空闲长连接

}

server {

listen 80;

server_name www.myapp.com;

location / {

proxy_pass http://web_application_cluster;

# 其他必要的 proxy_set_header 指令

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

# 配置超时参数

proxy_connect_timeout 5s;

proxy_read_timeout 30s;

proxy_send_timeout 30s;

}

}

通过上述配置,NGINX加权轮询能够实现以下关键目标:

- 按服务器处理能力精确分配流量:确保高性能服务器得到充分利用,而低配置服务器不会因超负荷而响应缓慢或崩溃。

- 快速识别并自动隔离故障服务器:通过

max_fails和fail_timeout机制,NGINX能够将被动健康检查发现的故障节点及时从服务轮询中暂时移除。 - 提供集群级冗余:在所有主服务器均发生故障的极端情况下,

backup服务器能够接管服务,保障业务的连续性。 - 提升整体性能:通过

keepalive减少了与后端服务器间TCP连接建立的延迟和资源消耗。

11.2 在API网关场景中的精细化流量路由应用

API网关作为现代分布式架构中的关键组件,其核心特点包括:

- 路由到众多异构的后端微服务:需要将来自客户端的API请求,根据路径、版本或其他标识,准确路由到不同的后端服务集群。

- 各后端服务的容量和性能特性差异巨大:不同的微服务可能由不同的团队开发,部署在不同的基础设施上,其处理能力、响应时间、资源需求(CPU密集型、内存密集型、I/O密集型)各不相同。

- 对服务质量(QoS)和故障隔离要求极高:任何一个后端服务的故障都不应大面积影响其他API的可用性。

- 可能需要根据API版本或特性进行流量分流:例如,将部分流量导向新版本的API实现进行测试或灰度发布。

NGINX作为API网关时,加权轮询的配置与应用考量:

# 针对用户服务 (User Service) 的上游配置

# 假设用户服务读多写少,因此为读实例分配更高权重

upstream user_service_upstream {

server user-read-instance1.internal.example.com weight=5;

server user-read-instance2.internal.example.com weight=5;

server user-write-instance1.internal.example.com weight=1; # 写实例可能较少或处理能力要求不同

zone user_service_zone 64k; # NGINX Plus: 共享内存区域,用于跨worker同步状态

}

# 针对内容服务 (Content Service) - 假设其为计算密集型服务

upstream content_service_upstream {

server content-instance1.internal.example.com weight=3;

server content-instance2.internal.example.com weight=3;

# 可以配置更积极的健康检查

# health_check interval=5s fails=2 passes=3 uri=/health type=http; (NGINX Plus)

zone content_service_zone 64k;

}

# 针对搜索服务 (Search Service) - 假设其为内存密集型服务,且实例较少

upstream search_service_upstream {

server search-instance1.internal.example.com weight=1;

server search-instance2.internal.example.com weight=1;

zone search_service_zone 64k;

}

server {

listen 443 ssl http2; # 推荐使用 HTTPS 和 HTTP/2

server_name api.example.com;

# SSL/TLS 配置 (证书、密钥等)

# ssl_certificate /path/to/cert.pem;

# ssl_certificate_key /path/to/key.pem;

# ... 其他SSL优化配置

# 基于请求URI的前缀,将请求路由到不同的上游微服务集群

location /api/v1/users {

# 鉴权、限流等逻辑 (省略,通常在API网关层面实现)

# auth_request /_validate_token;

# limit_req zone=api_users burst=10 nodelay;

proxy_pass http://user_service_upstream;

# ... API网关通用proxy配置 (超时、重试、头部设置等)

}

location /api/v1/content {

proxy_pass http://content_service_upstream;

# ...

}

location /api/v1/search {

proxy_pass http://search_service_upstream;

# ...

}

# NGINX Plus: API用于动态管理upstream

location /api-upstream-management {

api write=on;

allow 127.0.0.1; # 严格限制访问

deny all;

}

}

应用效果分析:

- 精细化流量控制:为每个微服务集群独立配置上游和权重,可以根据各服务的具体负载特性和资源容量进行精细化的流量分配。

- 服务隔离:不同服务的上游配置相互独立,一个服务的故障或性能问题不会直接影响到其他服务的负载均衡(除非是共享资源瓶颈)。

- 可扩展性:当某个微服务需要扩容时,只需在其对应的upstream中添加新的服务器实例并分配合适的权重即可,对其他服务无影响。

- NGINX Plus增强:通过

zone指令可以在worker进程间共享上游服务器的状态(如健康状况、当前权重等),使得负载均衡决策更为一致和准确。主动健康检查和动态API管理进一步提升了运维效率和可靠性。

11.3 微服务架构 (Microservices Architecture) 中的应用

微服务架构通常具备以下核心特点:

- 服务数量众多且各自独立部署:系统被拆分为大量小而自治的服务单元,每个服务都有自己的生命周期和部署实例。

- 服务间通过网络频繁调用:服务与服务之间的交互主要依赖轻量级的网络通信协议(如HTTP/REST, gRPC)。

- 不同服务的资源需求差异巨大:有的服务可能是CPU密集型,有的是内存密集型,有的是I/O密集型,其所需的服务器配置和实例数量各不相同。

- 服务实例可能进行动态的弹性伸缩:根据实时负载情况,服务实例的数量可能会频繁地增加(scale-out)或减少(scale-in),需要负载均衡器能够适应这种动态变化。

NGINX在微服务架构中作为服务间负载均衡器或边缘网关的应用:

# 示例一:与服务发现机制 (如 Consul, etcd, Kubernetes DNS) 集成

# NGINX开源版可以通过 'resolve' 参数配合DNS SRV记录实现基础的服务发现

upstream auth_service_discovered {

# 'resolve' 指示NGINX定期重新解析DNS获取上游服务器列表

# 'service=auth' 是Consul DNS SRV记录的约定格式,查找名为'auth'的服务

# 'valid=10s' 设置DNS记录的缓存有效期

server auth.service.consul service=_http._tcp resolve; # 'resolve'参数启用DNS SRV解析

# 'service=' 指定服务名称

# 注意:开源NGINX对SRV的原生支持有限,NGINX Plus在这方面更强大。

# 上述 'server ... service=... resolve' 语法是NGINX Plus的。

# 开源版可能需要更复杂的配置或第三方模块。

}

upstream payment_service_discovered {

# zone upstream_payment_service 64k; # NGINX Plus

server payment.service.consul service=_http._tcp resolve; # NGINX Plus

}

# 流量控制与韧性策略配置

server {

listen 80; # 内部服务间通信端口

location /internal_api/auth {

proxy_pass http://auth_service_discovered;

# 增强韧性的代理配置

proxy_next_upstream error timeout http_502 http_503 http_504; # 定义哪些错误触发重试到下一个上游

proxy_next_upstream_tries 3; # 最多重试3次(到不同的上游实例)

proxy_next_upstream_timeout 5s; # 重试的总超时时间

proxy_connect_timeout 1s; # 连接超时

}

location /internal_api/payments {

proxy_pass http://payment_service_discovered;

proxy_connect_timeout 2s;

proxy_read_timeout 5s; # 读取响应超时

# 可以配置 backup 服务器或更复杂的重试逻辑

}

}

NGINX Plus 版本支持更原生的动态服务发现和更高级的负载均衡策略,例如 least_conn 或 least_time,这些在微服务场景中可能比简单的加权轮询更优:

# NGINX Plus: 从服务注册中心(如Consul)动态更新上游服务器列表

upstream backend_microservice_pool {

zone upstream_backend_ms 64k; # 共享内存区域

# 初始时可以不定义任何服务器,或定义一个占位服务器

# server 0.0.0.0:1 down; # 占位,初始不可用

# 通过 NGINX Plus API 或与服务发现集成的模块来动态填充此上游组

# 例如,使用 consul_server 指令 (需特定模块) 或通过API脚本轮询Consul并更新

# 在微服务场景,'least_conn' (最少连接) 或 'least_time' (最小平均响应时间 - NGINX Plus)

# 往往是比加权轮询更受欢迎的策略,因为它们能更好地适应服务实例的实时负载。

# 但如果服务实例性能差异大,依然可以结合权重使用。

least_conn;

# หรือ least_time header; (NGINX Plus)

health_check interval=5s fails=2 passes=3 uri=/health type=http; (NGINX Plus)

keepalive 16;

}

在微服务环境中,NGINX(尤其是NGINX Plus)通过其灵活的负载均衡算法(包括加权轮询,尽管 least_conn 等可能更常用)、与服务发现的集成能力以及强大的流量控制和韧性特性(如重试、超时、熔断(通过 max_fails 和 fail_timeout 间接实现)),扮演着至关重要的角色,确保了服务间通信的可靠性和高效性。

11.4 全球分布式系统 (GDS - Global Distributed Systems) 中的应用

全球分布式系统通常具备以下核心特点:

- 服务器节点广泛分布于多个地理区域/数据中心:为了服务全球用户或实现异地容灾,应用实例会部署在世界各地的不同数据中心。

- 网络延迟和链路质量存在显著差异:不同区域的用户访问不同数据中心,或数据中心之间的通信,其网络延迟和稳定性各不相同。

- 可能需要实现就近接入或基于地理位置的路由:为了优化用户体验,通常希望将用户请求导向离其最近或网络条件最佳的数据中心。

- 不同区域的服务器集群配置和容量可能不同:各数据中心的资源投入和服务器规模可能因当地市场需求、成本等因素而异。

NGINX在全球分布式系统中作为区域内负载均衡器的配置策略:

(注意:NGINX本身通常作为区域内的L7负载均衡器,GSLB功能更多依赖DNS层面或专门的GSLB设备/服务。但NGINX可以通过 geo 和 map 模块实现一定程度的基于客户端IP的区域导向。)

# 步骤1: 定义 geo 模块,根据客户端IP地址判断其大致地理区域

# (需要 ngx_http_geoip_module 或 ngx_http_geo_module)

# 假设使用 ngx_http_geo_module

geo $client_geo_region {

default "default_region"; # 未匹配到任何网段时的默认区域

# 示例IP网段,实际应使用更精确的GeoIP数据库或服务

1.2.3.0/24 "us-east";

4.5.6.0/24 "us-west";

7.8.9.0/24 "eu-central";

10.11.12.0/24 "ap-southeast";

}

# 步骤2: 定义每个区域内部的上游服务器组并配置权重

upstream us_east_servers_pool {

server us-east-dc1-server1.example.com weight=5;

server us-east-dc1-server2.example.com weight=5;

# 可以配置其他区域的服务器作为跨区域备份,但权重极低或标记为backup

server eu-central-dc1-server1.example.com weight=1 backup;

zone upstream_us_east 64k; # NGINX Plus

}

upstream us_west_servers_pool {

server us-west-dc1-server1.example.com weight=7; # 可能此区域服务器更强

server us-west-dc1-server2.example.com weight=3;

zone upstream_us_west 64k; # NGINX Plus

}

upstream eu_central_servers_pool {

server eu-central-dc1-server1.example.com weight=4;

server eu-central-dc1-server2.example.com weight=4;

zone upstream_eu_central 64k; # NGINX Plus

}

upstream ap_southeast_servers_pool {

server ap-southeast-dc1-server1.example.com weight=6;

zone upstream_ap_southeast 64k; # NGINX Plus

}

upstream default_region_servers_pool { # 为无法确定区域的流量准备

# 可以是某个主要区域的别名,或一个综合的服务器池

server us-east-dc1-server1.example.com weight=1;

server us-west-dc1-server1.example.com weight=1;

server eu-central-dc1-server1.example.com weight=1;

zone upstream_default 64k; # NGINX Plus

}

# 步骤3: 使用 map 模块,将 $client_geo_region 变量映射到对应的上游服务器组名称

map $client_geo_region $selected_upstream_pool {

us-east us_east_servers_pool;

us-west us_west_servers_pool;

eu-central eu_central_servers_pool;

ap-southeast ap_southeast_servers_pool;

default default_region_servers_pool; # 默认或未匹配时使用的池

}

server {

listen 80; # 或 443 ssl

server_name gds.example.com;

location / {

# 使用 $selected_upstream_pool 变量作为 proxy_pass 的目标

# 这实现了基于客户端地理位置的动态上游选择

proxy_pass http://$selected_upstream_pool;

# ... 其他通用proxy配置

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

# 考虑设置 X-Client-Region: $client_geo_region 传递给后端

}

}

应用效果与考量:

- 就近接入优化:通过

geo和map模块的组合,可以将用户请求导向地理或网络拓扑上更近的数据中心内的NGINX集群(或直接是应用服务器集群),从而显著降低访问延迟,提升用户体验。 - 区域内负载均衡:在每个区域特定的上游服务器组(如

us_east_servers_pool)内部,依然使用加权轮询(或其他所选算法)来在区域内的服务器之间分配负载,确保区域内资源的高效利用。 - 区域级容灾:通过在某个区域的上游组中配置其他区域的服务器作为

backup或低权重节点,可以实现一定程度的区域级故障转移。但更完善的GSLB通常在DNS层面实现。 - GeoIP数据准确性:这种方案的有效性高度依赖于GeoIP数据库的准确性和实时性。过时或不准确的GeoIP数据可能导致错误的区域判断。

- NGINX作为GSLB的局限性:虽然NGINX可以通过上述方式实现基下并没有选择诸如优先队列(堆)或平衡树等虽然理论上可能在某些特定操作上更优但实现和维护开销更大的复杂数据结构,而是选择了简单数组配合巧妙的算法逻辑。

- 关键操作中严格控制内存分配:在请求处理的热路径上,NGINX 会极力避免动态内存分配(malloc/free),因为这些操作可能引入不可预测的延迟和内存碎片。权重调整等操作都是在预先分配好的数据结构上直接进行的。

这种极简主义和对性能的极致追求,是NGINX能够成为业界领先的高性能反向代理和负载均衡器的重要原因之一。