机器学习笔记之贝叶斯线性回归——线性回归背景介绍

- 引言

- 回顾:线性回归

- 场景构建

- 从概率密度函数认识最小二乘法

- 回顾:最小二乘估计

- 回顾:线性回归与正则化

- 关于线性回归的简单小结

- 贝叶斯线性回归

- 贝叶斯方法

- 贝叶斯方法在线性回归中的任务

- 贝叶斯线性回归推断任务介绍

引言

本节开始,介绍贝叶斯线性回归(Bayesian Linear Regression)。

回顾:线性回归

场景构建

给定数据集合

D

a

t

a

=

{

(

x

(

i

)

,

y

(

i

)

)

}

i

=

1

N

\mathcal Data = \left\{\left(x^{(i)},y^{(i)}\right)\right\}_{i=1}^N

Data={(x(i),y(i))}i=1N,其中样本

x

(

i

)

(

1

=

1

,

2

,

⋯

,

N

)

x^{(i)}(1 = 1,2,\cdots,N)

x(i)(1=1,2,⋯,N)是

p

p

p维随机变量,对应的标签信息

y

(

i

)

y^{(i)}

y(i)是一维随机变量:

x

(

i

)

∈

R

p

,

y

(

i

)

∈

R

i

=

1

,

2

,

⋯

,

N

X

=

(

x

(

1

)

,

x

(

2

)

,

⋯

,

x

(

N

)

)

T

=

(

x

1

(

1

)

,

x

2

(

1

)

,

⋯

,

x

p

(

1

)

x

1

(

2

)

,

x

2

(

2

)

,

⋯

,

x

p

(

2

)

⋮

x

1

(

N

)

,

x

2

(

N

)

,

⋯

,

x

p

(

N

)

)

N

×

p

Y

=

(

y

(

1

)

y

(

2

)

⋮

y

N

×

1

(

N

)

)

\begin{aligned} x^{(i)} & \in \mathbb R^p,y^{(i)} \in \mathbb R \quad i=1,2,\cdots,N \\ \mathcal X & = \left(x^{(1)},x^{(2)},\cdots,x^{(N)}\right)^T = \begin{pmatrix} x_1^{(1)},x_2^{(1)},\cdots,x_p^{(1)} \\ x_1^{(2)},x_2^{(2)},\cdots,x_p^{(2)} \\ \vdots \\ x_1^{(N)},x_2^{(N)},\cdots,x_p^{(N)} \\ \end{pmatrix}_{N \times p} \quad \mathcal Y = \begin{pmatrix} y^{(1)} \\ y^{(2)} \\ \vdots \\ y^{(N)}_{N \times 1} \end{pmatrix} \end{aligned}

x(i)X∈Rp,y(i)∈Ri=1,2,⋯,N=(x(1),x(2),⋯,x(N))T=⎝⎜⎜⎜⎜⎛x1(1),x2(1),⋯,xp(1)x1(2),x2(2),⋯,xp(2)⋮x1(N),x2(N),⋯,xp(N)⎠⎟⎟⎟⎟⎞N×pY=⎝⎜⎜⎜⎛y(1)y(2)⋮yN×1(N)⎠⎟⎟⎟⎞

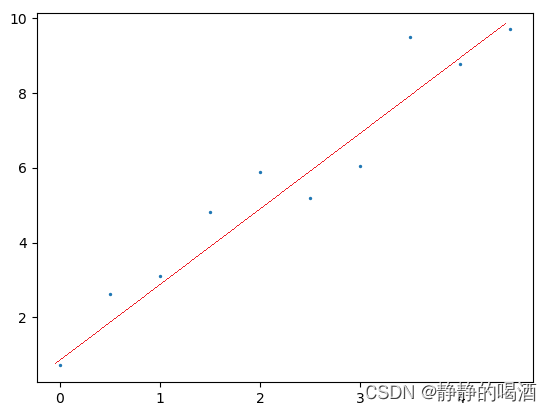

从概率密度函数认识最小二乘法

给定数据集合

D

a

t

a

Data

Data以及相应拟合直线表示如下:

其中直线的表达式为:

这里‘偏置信息’

b

b

b忽略掉,

x

i

(

i

=

1

,

2

,

⋯

,

p

)

x_i(i=1,2,\cdots,p)

xi(i=1,2,⋯,p)表示样本的第

i

i

i维特征信息。

f

(

X

)

=

W

T

X

=

X

T

W

=

∑

i

=

1

p

w

i

⋅

x

i

f(\mathcal X) = \mathcal W^T \mathcal X = \mathcal X^T \mathcal W = \sum_{i=1}^p w_i \cdot x_i

f(X)=WTX=XTW=i=1∑pwi⋅xi

从概率密度函数角度观察,标签分布可看作是

f

(

x

)

f(x)

f(x)的基础加上均值为0的高斯分布噪声:

X

\mathcal X

X是包含

p

p

p维特征的随机变量集合;

Y

\mathcal Y

Y是一个一维随机变量;

ϵ

\epsilon

ϵ表示一维高斯分布(它和

Y

\mathcal Y

Y的维数相同)。

Y

=

f

(

X

)

+

ϵ

X

∈

R

p

,

Y

∈

R

,

ϵ

∼

N

(

0

,

σ

2

)

\mathcal Y = f(\mathcal X) + \epsilon \quad \mathcal X \in \mathbb R^p,\mathcal Y \in \mathbb R,\epsilon \sim \mathcal N(0,\sigma^2)

Y=f(X)+ϵX∈Rp,Y∈R,ϵ∼N(0,σ2)

回顾:最小二乘估计

关于线性回归问题求解模型参数

W

\mathcal W

W时,使用的是最小二乘估计(Least Square Estimation,LSE):

L

(

W

)

=

∑

i

=

1

N

∣

∣

W

T

x

(

i

)

−

y

(

i

)

∣

∣

2

\mathcal L(\mathcal W) = \sum_{i=1}^N ||\mathcal W^Tx^{(i)} - y^{(i)}||^2

L(W)=i=1∑N∣∣WTx(i)−y(i)∣∣2

并且通过最小二乘估计,求解模型参数

W

\mathcal W

W的矩阵形式表达:

矩阵表达的弊端:

-

X

T

X

\mathcal X^T\mathcal X

XTX

是一个p × p p \times p p×p的对称矩阵,它至少是半正定矩阵,但不一定是正定矩阵。从而导致( X T X ) − 1 (\mathcal X^T\mathcal X)^{-1} (XTX)−1可能是不可求的。 由于X \mathcal X X是样本集合,如果X \mathcal X X的样本量较大,会导致X T X \mathcal X^T\mathcal X XTX的计算代价极高。

W = ( X T X ) − 1 X T Y \mathcal W = (\mathcal X^T \mathcal X)^{-1} \mathcal X^T \mathcal Y W=(XTX)−1XTY

从概率密度函数角度观察,最小二乘估计本质是极大似然估计(Maximum Likelihood Estimate,MLE):

给定样本

x

(

i

)

x^{(i)}

x(i)和对应标签

y

(

i

)

y^{(i)}

y(i)之间的关联关系,可以得到

P

(

y

(

i

)

∣

x

(

i

)

)

\mathcal P(y^{(i)} \mid x^{(i)})

P(y(i)∣x(i))的概率分布:

这里先将

μ

\mu

μ写在上面。

y

(

i

)

=

W

T

x

(

i

)

+

ϵ

ϵ

∼

N

(

μ

,

σ

2

)

→

P

(

y

(

i

)

∣

x

(

i

)

;

W

)

∼

N

(

W

T

x

(

i

)

+

μ

,

σ

2

)

\begin{aligned} & y^{(i)} = \mathcal W^Tx^{(i)} + \epsilon \quad \epsilon \sim \mathcal N(\mu,\sigma^2) \\ & \to \mathcal P(y^{(i)} \mid x^{(i)};\mathcal W) \sim \mathcal N(\mathcal W^Tx^{(i)} + \mu,\sigma^2) \end{aligned}

y(i)=WTx(i)+ϵϵ∼N(μ,σ2)→P(y(i)∣x(i);W)∼N(WTx(i)+μ,σ2)

对似然函数

L

(

W

)

\mathcal L(\mathcal W)

L(W)进行构建:

将高斯分布的概率密度函数带入~

L

(

W

)

=

log

∏

i

=

1

N

P

(

y

(

i

)

∣

x

(

i

)

;

W

)

=

∑

i

=

1

N

log

[

1

σ

2

π

exp

(

−

[

y

(

i

)

−

(

W

T

x

(

i

)

+

μ

)

]

2

2

σ

2

)

]

\begin{aligned} \mathcal L(\mathcal W) & = \log \prod_{i=1}^N \mathcal P(y^{(i)} \mid x^{(i)};\mathcal W) \\ & = \sum_{i=1}^N \log \left[\frac{1}{\sigma \sqrt{2 \pi}} \exp \left(- \frac{[y^{(i)} - \left(\mathcal W^Tx^{(i)} + \mu\right)]^2}{2\sigma^2}\right)\right] \end{aligned}

L(W)=logi=1∏NP(y(i)∣x(i);W)=i=1∑Nlog[σ2π1exp(−2σ2[y(i)−(WTx(i)+μ)]2)]

使用极大似然估计对最优模型参数

W

^

\hat {\mathcal W}

W^进行计算:

其中

∑

i

=

1

N

log

1

σ

2

π

,

1

2

σ

2

\sum_{i=1}^N \log \frac{1}{\sigma \sqrt{2\pi}},\frac{1}{2\sigma^2}

∑i=1Nlogσ2π1,2σ21均是与

x

(

i

)

x^{(i)}

x(i)无关的量,视作常数。

W

^

=

arg

max

W

L

(

W

)

=

arg

max

W

{

∑

i

=

1

N

log

[

1

σ

2

π

exp

(

−

[

y

(

i

)

−

(

W

T

x

(

i

)

+

μ

)

]

2

2

σ

2

)

]

}

=

arg

max

W

{

∑

i

=

1

N

log

1

σ

2

π

−

∑

i

=

1

N

[

y

(

i

)

−

(

W

T

x

(

i

)

+

μ

)

]

2

2

σ

2

}

∝

arg

min

W

∑

i

=

1

N

[

y

(

i

)

−

(

W

T

x

(

i

)

+

μ

)

]

2

μ

=

0

→

arg

min

W

∑

i

=

1

N

[

y

(

i

)

−

W

T

x

(

i

)

]

2

\begin{aligned} \hat {\mathcal W} & = \mathop{\arg\max}\limits_{\mathcal W} \mathcal L(\mathcal W) \\ & = \mathop{\arg\max}\limits_{\mathcal W}\left\{\sum_{i=1}^N \log \left[\frac{1}{\sigma \sqrt{2 \pi}} \exp \left(- \frac{[y^{(i)} - \left(\mathcal W^Tx^{(i)} + \mu\right)]^2}{2\sigma^2}\right)\right]\right\} \\ & = \mathop{\arg\max}\limits_{\mathcal W}\left\{\sum_{i=1}^N \log \frac{1}{\sigma\sqrt{2\pi}} - \sum_{i=1}^N\frac{[y^{(i)} - \left(\mathcal W^T x^{(i)} + \mu\right)]^2}{2\sigma^2}\right\} \\ & \propto \mathop{\arg\min}\limits_{\mathcal W}\sum_{i=1}^N \left[y^{(i)} - \left(\mathcal W^Tx^{(i)} + \mu\right)\right]^2 \\ \quad & \mu = 0 \to \mathop{\arg\min}\limits_{\mathcal W} \sum_ {i=1}^N \left[y^{(i)} - \mathcal W^Tx^{(i)}\right]^2 \end{aligned}

W^=WargmaxL(W)=Wargmax{i=1∑Nlog[σ2π1exp(−2σ2[y(i)−(WTx(i)+μ)]2)]}=Wargmax{i=1∑Nlogσ2π1−i=1∑N2σ2[y(i)−(WTx(i)+μ)]2}∝Wargmini=1∑N[y(i)−(WTx(i)+μ)]2μ=0→Wargmini=1∑N[y(i)−WTx(i)]2

这里令

μ

=

0

\mu=0

μ=0关于极大似然估计关于

W

^

\hat{\mathcal W}

W^的求解公式与最小二乘估计相同。

回顾:线性回归与正则化

针对最小二乘估计的过拟合 问题,引入正则化(Regularized)。常见的正则化有两种方式:

- Lasso回归(

L

1

\mathcal L_1

L1正则化)

arg min W [ ∑ i = 1 N ∣ ∣ W T x ( i ) − y ( i ) ∣ ∣ 2 + λ ∣ ∣ W ∣ ∣ 1 ] ∣ ∣ W ∣ ∣ 1 = ∣ w 1 ∣ + ⋯ + ∣ w p ∣ \mathop{\arg\min}\limits_{\mathcal W} \left[\sum_{i=1}^N ||\mathcal W^Tx^{(i)} - y^{(i)}||^2 + \lambda ||\mathcal W||_1\right] \quad ||\mathcal W||_1 = |w_1| + \cdots + |w_p| Wargmin[i=1∑N∣∣WTx(i)−y(i)∣∣2+λ∣∣W∣∣1]∣∣W∣∣1=∣w1∣+⋯+∣wp∣ - 岭回归(Ridge回归;

L

2

\mathcal L_2

L2正则化)

arg min W [ ∑ i = 1 N ∣ ∣ W T x ( i ) − y ( i ) ∣ ∣ 2 + λ ∣ ∣ W ∣ ∣ 2 2 ] ∣ ∣ W ∣ ∣ 2 2 = ∣ w 1 ∣ 2 + ⋅ + ∣ w p ∣ 2 \mathop{\arg\min}\limits_{\mathcal W} \left[\sum_{i=1}^N ||\mathcal W^Tx^{(i)} - y^{(i)}||^2 + \lambda ||\mathcal W||_2^2\right] \quad ||\mathcal W||_2^2 = \sqrt{|w_1|^2 + \cdot + |w_p|^2} Wargmin[i=1∑N∣∣WTx(i)−y(i)∣∣2+λ∣∣W∣∣22]∣∣W∣∣22=∣w1∣2+⋅+∣wp∣2

从概率密度函数角度考虑基于正则化的最小二乘估计,可将其视作关于

W

\mathcal W

W的最大后验概率估计(Maximum a Posteriori Probability,MAP):

W

^

M

A

P

=

arg

max

W

P

(

Y

∣

W

)

⋅

P

(

W

)

P

(

Y

)

∝

arg

max

W

P

(

Y

∣

W

)

⋅

P

(

W

)

\begin{aligned} \hat {\mathcal W}_{MAP} & = \mathop{\arg\max}\limits_{\mathcal W} \frac{\mathcal P(\mathcal Y \mid \mathcal W) \cdot \mathcal P(\mathcal W)}{\mathcal P(\mathcal Y)} \\ & \propto \mathop{\arg\max}\limits_{\mathcal W} P(\mathcal Y \mid \mathcal W) \cdot \mathcal P(\mathcal W) \\ \end{aligned}

W^MAP=WargmaxP(Y)P(Y∣W)⋅P(W)∝WargmaxP(Y∣W)⋅P(W)

由于样本间独立同分布,因而有:

增加一个

log

\log

log函数,不影响最值的取值结果。

W

^

M

A

P

∝

arg

max

W

[

log

∏

i

=

1

N

P

(

y

(

i

)

∣

W

)

⋅

P

(

W

)

]

\hat {\mathcal W}_{MAP} \propto \mathop{\arg\max}\limits_{\mathcal W} \left[\log \prod_{i=1}^N \mathcal P(y^{(i)} \mid \mathcal W) \cdot \mathcal P(\mathcal W)\right]

W^MAP∝Wargmax[logi=1∏NP(y(i)∣W)⋅P(W)]

令先验分布

P

(

W

)

∼

N

(

μ

0

,

σ

0

2

)

\mathcal P(\mathcal W) \sim \mathcal N(\mu_0 ,\sigma_0^2)

P(W)∼N(μ0,σ02),将

P

(

Y

∣

W

)

∼

N

(

W

T

X

,

σ

2

)

\mathcal P(\mathcal Y \mid \mathcal W) \sim \mathcal N(\mathcal W^T \mathcal X,\sigma^2)

P(Y∣W)∼N(WTX,σ2)一同代入上式,有:

这里既包含对

W

\mathcal W

W分布的假设。也包含关于高斯噪声

Y

∣

W

\mathcal Y \mid \mathcal W

Y∣W的假设。该假设完全写法是

Y

∣

X

;

W

\mathcal Y \mid \mathcal X;\mathcal W

Y∣X;W只不过这里

X

\mathcal X

X是已知量,省略掉了。

W

^

M

A

P

=

arg

min

W

∑

i

=

1

N

[

(

y

(

i

)

−

W

T

x

(

i

)

)

2

+

σ

2

σ

0

2

(

W

−

μ

0

)

2

]

\hat {\mathcal W}_{MAP} = \mathop{\arg\min}\limits_{\mathcal W} \sum_{i=1}^N \left[\left(y^{(i)} - \mathcal W^T x^{(i)}\right)^2 + \frac{\sigma^2}{\sigma_0^2}(\mathcal W - \mu_0)^2\right]

W^MAP=Wargmini=1∑N[(y(i)−WTx(i))2+σ02σ2(W−μ0)2]

令

λ

=

σ

2

σ

0

2

,

μ

0

=

0

\lambda = \frac{\sigma^2}{\sigma_0^2},\mu_0 = 0

λ=σ02σ2,μ0=0时,上式将转化为:

W

^

M

A

P

=

arg

min

W

∑

i

=

1

N

[

(

y

(

i

)

−

W

T

x

(

i

)

)

2

+

λ

∣

∣

W

∣

∣

2

2

]

\hat {\mathcal W}_{MAP} = \mathop{\arg\min}\limits_{\mathcal W} \sum_{i=1}^N \left[\left(y^{(i)} - \mathcal W^T x^{(i)}\right)^2 + \lambda ||\mathcal W||_2^2\right]

W^MAP=Wargmini=1∑N[(y(i)−WTx(i))2+λ∣∣W∣∣22]

上述是关于岭回归

W

\mathcal W

W分布的假设,如果是Lasso回归,将

W

\mathcal W

W分布假设为拉普拉斯分布(Laplace Distribution)。

关于线性回归的简单小结

无论是最小二乘估计还是包含了正则化的最小二乘估计,其本质均是频率派的求解方式,将模型参数

W

\mathcal W

W视作未知常量,通过极大似然估计、最大后验概率估计等方式对

W

\mathcal W

W进行优化,从而使目标函数达到最值。

本质上是‘优化问题’。

并且这种估计方式是点估计(Point Estimation),由于概率模型能够源源不断的生成样本,理论上无法完美地、精确描述概率模型的分布信息,只能通过有限的样本集合来估计模型参数。

也就是说,使用‘统计得到的样本集合’估计总体参数。

假设某概率模型服从高斯分布:

N

(

μ

,

σ

2

)

\mathcal N(\mu,\sigma^2)

N(μ,σ2),这里的

μ

,

σ

2

\mu,\sigma^2

μ,σ2是描述概率分布的参数,是固定的。但是该概率模型可以生成无穷无尽的样本,假设某样本集合

X

=

{

x

(

1

)

,

x

(

2

)

,

⋯

,

x

(

N

)

}

\mathcal X =\left\{x^{(1)},x^{(2)},\cdots ,x^{(N)}\right\}

X={x(1),x(2),⋯,x(N)}是生成出的一部分样本,我们通过统计的方式得到该样本的均值、方差

μ

X

,

σ

X

2

\mu_{\mathcal X},\sigma_{\mathcal X}^2

μX,σX2去估计真正的参数

μ

,

σ

2

\mu,\sigma^2

μ,σ2。

贝叶斯线性回归

区别于频率派的点估计方式,贝叶斯派使用的是贝叶斯估计(Bayesian Estimation)。此时的参数 W \mathcal W W不再是一个未知的常量,而是一个随机变量。

对于 W \mathcal W W的估计过程中,需要通过给定数据估计出 W \mathcal W W的后验概率分布 P ( W ∣ D a t a ) \mathcal P(\mathcal W \mid Data) P(W∣Data)。

贝叶斯方法

在变分推断——基本介绍中介绍过贝叶斯学派角度认识问题。其核心是:不同于频率派将模型参数

W

\mathcal W

W看作未知的常量,而是将

W

\mathcal W

W看作随机变量,从而求解

W

\mathcal W

W的后验概率分布

P

(

W

∣

D

a

t

a

)

\mathcal P(\mathcal W \mid Data)

P(W∣Data),基于该分布,对新样本进行预测:

令新样本为

x

^

\hat x

x^,预测任务可表示为

P

(

x

^

∣

D

a

t

a

)

\mathcal P(\hat x \mid Data)

P(x^∣Data).

P

(

x

^

∣

D

a

t

a

)

=

∫

W

∣

D

a

t

a

P

(

x

^

,

W

∣

D

a

t

a

)

d

W

=

∫

W

∣

D

a

t

a

P

(

W

∣

X

)

⋅

P

(

x

^

∣

W

)

d

W

=

E

W

∣

D

a

t

a

[

P

(

x

^

∣

W

)

]

\begin{aligned} \mathcal P(\hat x \mid Data) & = \int_{\mathcal W \mid Data} \mathcal P(\hat x,\mathcal W \mid Data) d \mathcal W \\ & = \int_{\mathcal W \mid Data} \mathcal P(\mathcal W \mid \mathcal X) \cdot \mathcal P(\hat x \mid \mathcal W) d\mathcal W \\ & = \mathbb E_{\mathcal W \mid Data} \left[\mathcal P(\hat x \mid \mathcal W)\right] \end{aligned}

P(x^∣Data)=∫W∣DataP(x^,W∣Data)dW=∫W∣DataP(W∣X)⋅P(x^∣W)dW=EW∣Data[P(x^∣W)]

贝叶斯方法在线性回归中的任务

针对上述贝叶斯方法的描述,在线性回归中的任务包含以下两个:

- 推断任务(Inference):通过贝叶斯定理,求解后验概率 P ( W ∣ D a t a ) \mathcal P(\mathcal W \mid Data) P(W∣Data)。

- 预测任务(Prediction):基于后验概率 P ( W ∣ D a t a ) \mathcal P(\mathcal W \mid Data) P(W∣Data),对新样本的后验 P ( x ^ ∣ D a t a ) \mathcal P(\hat x \mid Data) P(x^∣Data)进行估计。

贝叶斯线性回归推断任务介绍

后验概率

P

(

W

∣

D

a

t

a

)

\mathcal P(\mathcal W \mid Data)

P(W∣Data)表示如下:

数据集合

D

a

t

a

Data

Data包含样本集合

X

\mathcal X

X和对应标签集合

Y

\mathcal Y

Y.

P

(

W

∣

D

a

t

a

)

=

P

(

W

∣

X

,

Y

)

=

P

(

W

,

Y

∣

X

)

P

(

Y

∣

X

)

=

P

(

Y

∣

W

,

X

)

⋅

P

(

W

)

∫

W

P

(

Y

∣

W

,

X

)

⋅

P

(

W

)

d

W

\begin{aligned} \mathcal P(\mathcal W \mid Data) & = \mathcal P(\mathcal W \mid \mathcal X,\mathcal Y) \\ & = \frac{\mathcal P(\mathcal W,\mathcal Y \mid \mathcal X)}{\mathcal P(\mathcal Y \mid \mathcal X)} \\ & = \frac{\mathcal P(\mathcal Y \mid \mathcal W,\mathcal X) \cdot \mathcal P(\mathcal W)}{\int_{\mathcal W} \mathcal P(\mathcal Y \mid \mathcal W,\mathcal X) \cdot \mathcal P(\mathcal W) d\mathcal W} \end{aligned}

P(W∣Data)=P(W∣X,Y)=P(Y∣X)P(W,Y∣X)=∫WP(Y∣W,X)⋅P(W)dWP(Y∣W,X)⋅P(W)

其中

P

(

Y

∣

W

,

X

)

\mathcal P(\mathcal Y \mid \mathcal W,\mathcal X)

P(Y∣W,X)是似然(Likelihood),

P

(

W

)

\mathcal P(\mathcal W)

P(W)是先验分布(Piror Distribution)。

P

(

W

)

\mathcal P(\mathcal W)

P(W)实际上是

P

(

W

∣

X

)

\mathcal P(\mathcal W \mid \mathcal X)

P(W∣X),由于

X

\mathcal X

X不对

W

\mathcal W

W产生影响,这里省略。这个先验分布是推断之前给定的某一种分布。

由于样本之间独立同分布,因而似然

P

(

Y

∣

W

,

X

)

\mathcal P(\mathcal Y \mid \mathcal W,\mathcal X)

P(Y∣W,X)可表示为如下形式:

根据上面介绍的线性回归模型,样本

x

(

i

)

x^{(i)}

x(i)和对应标签

y

(

i

)

y^{(i)}

y(i)之间是‘包含均值为0高斯噪声的线性关系’:

P

(

y

(

i

)

∣

W

,

x

(

i

)

)

∼

N

(

W

T

x

(

i

)

,

σ

2

)

P

(

Y

∣

W

,

X

)

=

∏

i

=

1

N

P

(

y

(

i

)

∣

W

,

x

(

i

)

)

=

∏

i

=

1

N

N

(

W

T

x

(

i

)

,

σ

2

)

\mathcal P(y^{(i)} \mid \mathcal W,x^{(i)}) \sim \mathcal N(\mathcal W^Tx^{(i)},\sigma^2)\\ \begin{aligned}\mathcal P(\mathcal Y \mid \mathcal W,\mathcal X) & = \prod_{i=1}^N \mathcal P(y^{(i)} \mid \mathcal W,x^{(i)}) \\ & = \prod_{i=1}^N \mathcal N(\mathcal W^T x^{(i)},\sigma^2) \end{aligned}

P(y(i)∣W,x(i))∼N(WTx(i),σ2)P(Y∣W,X)=i=1∏NP(y(i)∣W,x(i))=i=1∏NN(WTx(i),σ2)

关于先验分布

P

(

W

)

\mathcal P(\mathcal W)

P(W),我们同样假设它是一个 均值为0的高斯分布:

其中

Σ

p

r

i

o

r

\Sigma_{prior}

Σprior表示先验高斯分布的‘协方差矩阵’,由于

W

\mathcal W

W和

X

\mathcal X

X维度相同,因而

[

Σ

p

r

i

o

r

]

p

×

p

[\Sigma_{prior}]_{p \times p}

[Σprior]p×p.

P

(

W

)

∼

N

(

0

,

Σ

p

i

r

o

r

)

\mathcal P(\mathcal W) \sim \mathcal N(0,\Sigma_{piror})

P(W)∼N(0,Σpiror)

至此,关于

W

\mathcal W

W的后验概率分布

P

(

W

∣

D

a

t

a

)

\mathcal P(\mathcal W \mid Data)

P(W∣Data)可表示为:

贝叶斯定理的分母部分称作’证据‘(Evidence),它可看作关于数据集合

D

a

t

a

Data

Data的一个常量(因为数据集合是已知的),和参数

W

\mathcal W

W无关。

P

(

W

∣

D

a

t

a

)

=

P

(

Y

∣

W

,

X

)

⋅

P

(

W

)

∫

W

P

(

Y

∣

W

,

X

)

⋅

P

(

W

)

d

W

∝

P

(

Y

∣

W

,

X

)

⋅

P

(

W

)

\begin{aligned} \mathcal P(\mathcal W \mid Data) & = \frac{\mathcal P(\mathcal Y \mid \mathcal W,\mathcal X) \cdot \mathcal P(\mathcal W)}{\int_{\mathcal W} \mathcal P(\mathcal Y \mid \mathcal W,\mathcal X) \cdot \mathcal P(\mathcal W) d\mathcal W} \\ & \propto \mathcal P(\mathcal Y \mid \mathcal W,\mathcal X) \cdot \mathcal P(\mathcal W) \end{aligned}

P(W∣Data)=∫WP(Y∣W,X)⋅P(W)dWP(Y∣W,X)⋅P(W)∝P(Y∣W,X)⋅P(W)

观察,由于似然

P

(

Y

∣

W

,

X

)

\mathcal P(\mathcal Y \mid \mathcal W,\mathcal X)

P(Y∣W,X)服从高斯分布,并且先验分布同样假设为高斯分布,因而后验分布

P

(

W

∣

D

a

t

a

)

\mathcal P(\mathcal W \mid Data)

P(W∣Data)同样服从高斯分布。

这里用到了指数族分布的共轭性质,具体描述是:似然P ( Y ∣ W , X ) \mathcal P(\mathcal Y \mid \mathcal W,\mathcal X) P(Y∣W,X)存在一个共轭的先验分布P ( W ) \mathcal P(\mathcal W) P(W),对应效果是:后验分布P ( W ∣ D a t a ) \mathcal P(\mathcal W \mid Data) P(W∣Data)与先验分布形成相同的分布形式。并且高斯分布是一个包含’自共轭性质‘的指数族分布。即高斯分布是高斯分布自身的’共轭分布‘。

定义后验的高斯分布为

N

(

μ

W

,

Σ

W

)

\mathcal N(\mu_{\mathcal W},\Sigma_{\mathcal W})

N(μW,ΣW),具体表示如下:

N

(

μ

W

,

Σ

W

)

∝

[

∏

i

=

1

N

N

(

y

(

i

)

∣

W

T

x

(

i

)

,

σ

2

)

]

⋅

N

(

0

,

Σ

p

i

r

o

r

)

\mathcal N(\mu_{\mathcal W},\Sigma_{\mathcal W}) \propto \left[\prod_{i=1}^N \mathcal N(y^{(i)} \mid \mathcal W^Tx^{(i)},\sigma^2)\right] \cdot \mathcal N(0,\Sigma_{piror})

N(μW,ΣW)∝[i=1∏NN(y(i)∣WTx(i),σ2)]⋅N(0,Σpiror)

下一节将介绍 μ W , Σ W \mu_{\mathcal W},\Sigma_{\mathcal W} μW,ΣW的求解过程。

相关参考:

机器学习-贝叶斯线性回归(1)-背景介绍

机器学习-贝叶斯线性回归(2)-推导介绍

![[BJDCTF2020]EzPHP](https://img-blog.csdnimg.cn/7bc295a160fc4036815b014ad15c3156.png)

![[CVPR2022] Cross-Model Pseudo-Labeling for Semi-Supervised Action Recognition](https://img-blog.csdnimg.cn/decf823f99cf4f938b06cf4b6dd88be0.png)