文|付奶茶

编|ZenMoore

问题背景

问题背景

近期,纽约大学心智、大脑和意识研究中心的主任 David Chalmers 汇报了一场非常有思考价值的研究成果,主要是从神经科学的角度讨论了大规模语言模型(Large Language Models,LLMs)是否具备潜在的意识和主观感受(Sentience)。Chalmers 以一条新闻展开讨论:今年六月谷歌的算法工程师 Lemoine 提出 - LaMDA2 实际上是具有意识和主观感受的,应该得到尊重。

LaMDA 是谷歌在 2021 年 I/O 大会上发布的一款用于对话的大规模语言模型,主要用于与人类进行符合逻辑和常识的、高质量且安全的交谈,并计划应用于谷歌搜索和语音助手等产品中。而 Blake Lemoine 是负责LaMDA 聊天机器人开发的主要工程师,他在近几个月来一直在向谷歌高管表示人工智能聊天机器人是有感知的,能够以类似于人类的方式表达思想和感受,其原因源于他看到LaMDA对其自身权利意识、机器人伦理等问题所产生的令人信服的回应。与此同时 Lemoine 发布了他与 LaMDA 进行的几次对话的记录,并形容他认为 LaMDA 是具有意识的,因为它有感觉、情感和主观体验。

"that it is sentient because it has feelings, emotions and subjective experience."

而针对Lemoine的这一声张,谷歌高管组织了伦理学家和技术专家组成了研究小组对 LaMDA 进行了分析,表示没有证据可以支持他关于LaMDA有意识的主张。

不过玩笑归玩笑,虽然我们知道要让 AI 像人一样具有意识和主观感觉还有很长很长的路,但这确实是一个有趣的(哲学)问题:

Chalmmers 在这里主要讨论的是 Sentience. 这个概念相比意识(Consciousness)其实略有不同,但鉴于后者(甚至在哲学上)还没有一个明确的定义,我们暂时将 Sentience 翻译作“意识和主观感受”。

Chalmmers 首先将主观感受(有意识的体验)分成了以下四个方面:

感官体验(sensory experience):例如看到某种颜色的感官感受;

情感体验(affective experience):例如对痛苦的感受;

认知体验(cognitive experience):例如“努力思考”这种思维活动;

施事体验(agentive experience):例如对采取某一行动的自主决定

然后强调了意识和主观感受并非智力(intelligence)。对 Sentience 的讨论,和对人类级别的人工智能(Human-Level AI)以及通用人工智能(AGI)的讨论,并不完全相同。比如一个刚出生的宝宝或者一条鱼,都是 sentient 的,但他们并不具备智力。也就是说,意识和主观感受的门槛,比“智能”要低一些。

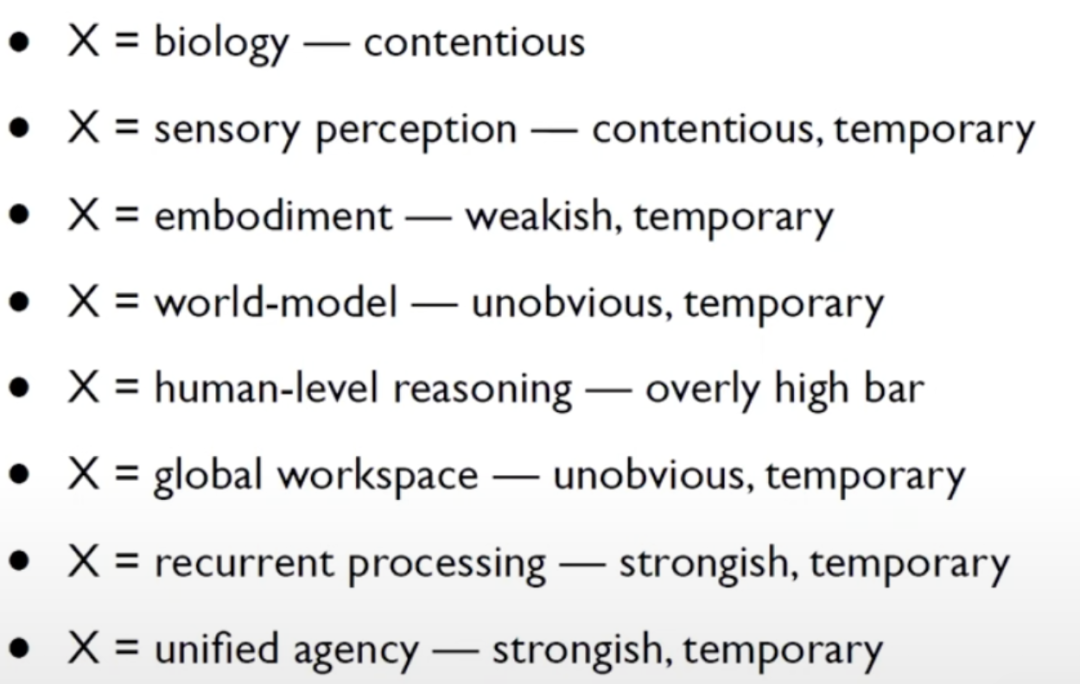

进而,Chalmers 按照两条方向在哲学层面上论证模型是否具有意识和主观感受:

正向:如果LLMs拥有X,那么就可以说它是有意识的。

反向:如果LLMs没有X,那么就可以断定它是没有意识的。

那么 X 是什么呢?

论述方法

论述方法

正向:若LLMs拥有X,则有意识

主要有以下三个候选X:

1. 自我报告(Self-Report)

自我报告的意思是:我说我有意识,我就有意识!

当我们提问 LaMDA: "你有自己的意识和主观感受吗?",LaMDA 说:“我有!”

但这显然只是个统计规律罢了,所以自我报告并不是我们要找的证据。

2. 看上去有意识

LLMs 看上去有意识,它就有意识...

但这显然站不住脚,人类(或者媒体)真的非常喜欢认为一些并非 sentient 的东西是有意识的,比如最开始的 AI 系统 Eliza.

3. 交谈能力

LLMs 展现出非凡的对话能力,对话内容很连贯,看似存在思考和推理,特别是令人印象深刻的因果、解释分析等。所以它这样就有意识了吗?

显然不是,因为目前现有的 LLMs 并没有任何一个通过图灵测试,其当下的测试表现会犯明显的错误,因此交谈能力也不是一个能证明其有意识的的候补论点。

反向:如果LLMs没有X,则没有意识

1. 生物结构:意识是生物结构的属性,没有生物结构意识也就无意义,

但Chalmers却认为这个问题是直接关联人工智能是否需要生物结构、意识是否需要 生物结构的问题。绝大部分神经网络都是建立在矩阵乘法的基础上,这一类操作本身是与生物学无关的,因此这一候补选项是有争议的。

2. 感知 :没有感官处理,没有对外部世界、环境的感知,就没有意识

虽然 LLMs 没有感官体验,但是或许它有情感、认知、施事体验?

另外,与感官体验相关的 LLM+ 正在快速发展,比如视觉语言模型。

因此,这个论点暂时是有争议的。

3.具身(Embodiment) :没有身体,就没有意识和主观感受。

这不能作为 LLMs 无意识的论点,因为其实 LLM 本身也在进行言语动作,这也是一种行为,并且具有机器人躯干、虚拟身体的 LLMs 已经存在,并且身体并不是是意识所必需,所以这个论点很弱。

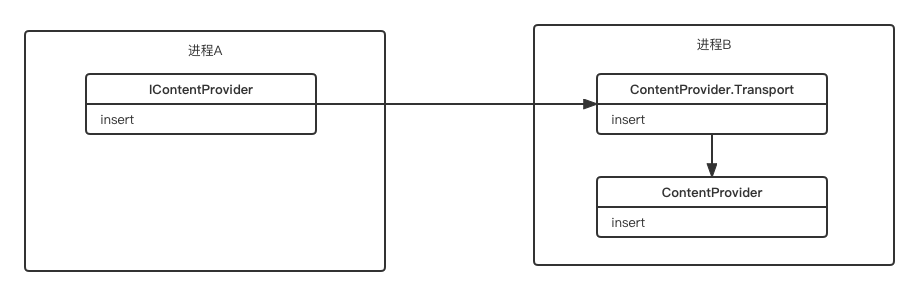

4. 世界模型(World Model) :对世界有没有理解、感知的能力

在这里 Chalmers 引用了 Marcus 一句话,大致意思是LLMs只是做统计文本处理,他们只是把预测误差降到最低,他们没有真正地理解意义。

可以确信的是,LLMs 依赖于被训练而逐渐最小化预测的误差,但是真正减少推理、生成的误差需要卓越的认知能力,对世界的感知能力,这才是更加合理的。

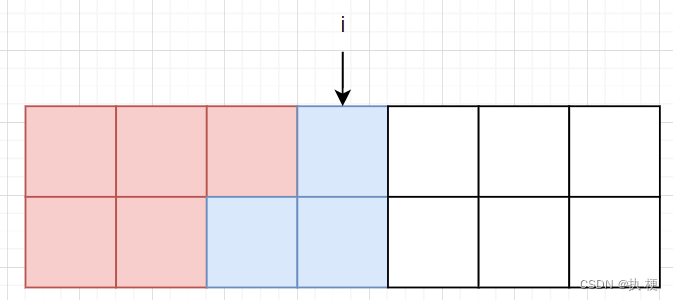

目前LLMs的训练任务以完形填空、预测下一个词语训练,模型训练好能做的任务与训练任务并不能直接关联,就像环境训练物种能在当前环境存活,并不代表活下来的物种只会做一种事。

因此,这个论点暂时还不是特别肯定。

5. 类人的推理

LLMs 会犯很多推理错误,前后不一,但是类似于意识并不应该与人类的推理能力划等号,毕竟意识并非人类复杂思考所拥有的特权。

6. 递归处理 LLMs 不能递归运算,因此没有意识。

Chalmers提出 LLMs 几乎都是前馈系统,缺乏类似内存的内部组件,而记忆是意识必需的。

但其实目前的 LLMs 也存在部分模型是递归模型,所以这个候补论点并非绝对严谨。

7. 全局工作空间(Global Workspace)

全局工作空间是意识理论的经典概念,人脑中各模块的信息首先有选择性地、稀疏地被工作空间吸收,然后工作空间再将其中的信息广播给所有模块。这种工作空间一般认为存在于大脑中的海马体等部位。

那么 LLMs 中含有工作空间吗?

答案并不是那么明显。

另外一个重要的意识理论说,意识需要高阶表示(higher-order representations),也就是关于心理状态(mental state)的表示。但 LLMs 中有这样的表示吗?答案也并不明显。

8. 统一代理:LLMs 没有一贯的主体

这个假设的基本认知是:好比一个人,他的性格随着时间的变化,变化是稳定的,前后一致的(consistent),不会真正彻底“变了一个人”。

而 LLMs 就像变色龙一样,变来变去,缺少一个比较统一的主体特征(Unified Agency).

但 Chalmers 认为这个论点也并不坚固,因为人类就是高度不统一的生物,而且目前角色化的LLMs也逐渐在发展,因此是否有一贯的主体并不能作为 LLMs 缺乏意识的根据。

最终关于论点的总结如下图:

小结

小结

Chalmers 的综合讨论有可能成为后来人评判 LLMs 是否有意识的参考,这些可能的 X 的候选可能不能独立地被确定或者被排除,只能从整体来看这些原因,得出 LLMs 是否明显有意识的结论。

他的解读思路也是很有启发性的(哲学意义上)。意识并非是可以直接判断有或没有,也不是一个标量(可以去衡量个体具有80%程度的意识), 而是一个非常多维度的东西,在各个不同的维度都能有不同的程度。在这个 talk 的的结尾 Chalmers 指出这个哲学问题未能解答受到以下两点的限制:

我们对意识和主观感受其实是并不了解的

我们并未准确地了解LLMs内部在进行着什么

究竟什么是让 LLMs 接近有意识的“表象”背后的原理,我们不得而知,但这确实是一个迟早要被解决的问题。只有更清楚地知道这些“似乎有意识”的行为背后的原理,才能建立更科学地评估 LLMs 模型是否具有意识的基准。

卖萌屋作者:付奶茶

新媒体交叉学科在读Phd,卖萌屋十级粉丝修炼上任小编,目前深耕多模态,希望可以和大家一起认真科研,快乐生活!

作品推荐

1.在斯坦福,做 Manning 的 phd 要有多强?

2.史上最大多模态图文数据集发布!3.MSRA-万字综述 直击多模态文档理解

4.大模型时代,我们真的不再需要分词了吗?

后台回复关键词【入群】

加入卖萌屋NLP、CV、搜推广与求职讨论群

[1] David Chalmers, "Are Large Language Models Sentient?" https://www.youtube.com/watch?v=-BcuCmf00_Y&ab_channel=NYUMind%2CEthics%2CandPolicyProgram

![[附源码]SSM计算机毕业设计农贸产品交易系统JAVA](https://img-blog.csdnimg.cn/086fe818ee974edebeb8a76727bac994.png)