互联网大厂Java求职面试:Spring AI与大模型交互在短视频平台中的应用

面试场景设定

郑薪苦,一名有着丰富项目经验但总是能用奇葩比喻解释复杂技术的程序员,正在接受某知名互联网大厂技术总监的面试。

第一轮提问

面试官:假设我们正在设计一个千万级用户同时在线的直播系统,你会如何设计实时互动消息系统?

郑薪苦:首先,我们可以使用Spring AI结合LangChain4j来处理消息的生成和理解。这就像在一个巨大的聊天室里,每个人都带着AI助手,帮助他们理解和回应其他人的消息。

面试官:那么你如何确保消息的低延迟传输呢?

郑薪苦:我们可以使用WebSocket或者SSE来实现实时通讯。这就像是给每个用户配备了一条高速公路专线,确保消息能够快速到达。

面试官:如果遇到高峰期流量激增怎么办?

郑薪苦:可以引入Kafka作为消息队列进行削峰填谷。想象一下,Kafka就像是一个巨大的水坝,不管上游洪水多么汹涌,下游都能保持平稳的水流。

第二轮提问

面试官:请谈谈你在视频内容分发网络(CDN)优化与边缘计算应用方面的经验。

郑薪苦:通过在CDN节点上部署轻量级的AI推理服务,可以实现内容的智能缓存和预取。这就像是在每个城市都设立了一个小型图书馆,读者可以就近借阅书籍,而不需要每次都跑到中央图书馆。

面试官:如何保障直播平台的延迟控制与音视频同步策略?

郑薪苦:可以采用WebRTC技术,并结合自适应码率调整算法。这就好比是开车时根据路况自动调整速度,既能保证安全又能提高效率。

面试官:对于UGC内容审核系统的设计,你有什么建议?

郑薪苦:可以构建一个多模态的内容审核管道,包括文本、图像和视频的综合分析。这个过程类似于组织一场多学科会诊,各个专家共同协作,确保诊断结果准确无误。

第三轮提问

面试官:针对直播间实时互动与弹幕系统的吞吐量优化,你有哪些思路?

郑薪苦:可以利用Redis的发布订阅功能,配合虚拟线程提升并发处理能力。这就好比是在一个大型派对上,每个人都有自己的私人服务员,随时准备响应他们的需求。

面试官:关于视频内容的版权保护与区块链存证,你怎么看?

郑薪苦:可以通过将关键元数据写入区块链,确保其不可篡改。这就像把重要文件锁进银行保险箱,只有授权人员才能访问。

面试官:最后一个问题,社交图谱分析与用户关系网络构建需要注意哪些方面?

郑薪苦:需要关注数据的稀疏性和动态变化,可以考虑使用图数据库如Neo4j来存储和查询。这就像维护一张复杂的铁路网图,不仅要记录每条线路,还要实时更新列车时刻表。

总结性评价

面试官:郑先生,你的回答展现了扎实的技术基础和创新思维,尽管有些比喻让人哭笑不得,但确实抓住了问题的核心。我们会尽快通知你面试结果,请回家耐心等待。

技术详解

Spring AI与大模型交互

Spring AI是一个新兴框架,旨在简化Java应用程序与大语言模型(LLMs)和其他人工智能模型的集成。以下是几个核心概念和技术原理的详细解析:

- 高级模式与自定义开发

- Spring AI提供了一系列注解和工具类,使得开发者可以轻松地调用外部AI服务或本地运行的模型。

- 自定义开发通常涉及创建特定的Token处理器和上下文管理器,以满足企业的个性化需求。

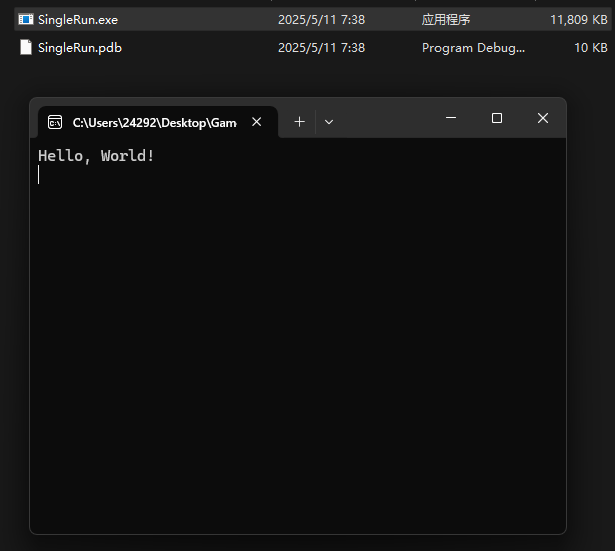

// 示例代码:使用Spring AI调用外部大模型API

@RestController

@RequestMapping("/api/ai")

public class AiController {

@Autowired

private AiService aiService;

@PostMapping("/generate")

public ResponseEntity<String> generateText(@RequestBody String prompt) {

String response = aiService.generate(prompt);

return ResponseEntity.ok(response);

}

}

@Service

public class AiService {

@Value("${ai.api.key}")

private String apiKey;

public String generate(String prompt) {

// 调用外部AI API

OkHttpClient client = new OkHttpClient();

RequestBody body = RequestBody.create(

MediaType.get("application/json"),

"{\"prompt\":\"" + prompt + "\",\"max_tokens\":50}"

);

Request request = new Request.Builder()

.url("https://api.example.com/v1/completions")

.addHeader("Authorization", "Bearer " + apiKey)

.post(body)

.build();

try (Response response = client.newCall(request).execute()) {

if (!response.isSuccessful()) throw new IOException("Unexpected code " + response);

return response.body().string();

} catch (IOException e) {

e.printStackTrace();

return null;

}

}

}

-

企业级LLM应用的性能与可靠性保障

- 在生产环境中,必须考虑模型的冷启动时间、内存占用以及请求的吞吐量。

- 可以通过预加载模型、使用缓存机制和分布式部署来提升性能。

- 监控和日志记录也是不可或缺的,以便及时发现和解决问题。

-

RAG系统中上下文窗口优化与多种检索策略融合

- RAG(Retrieval-Augmented Generation)系统结合了检索和生成两种方法,能够在回答问题时参考外部知识源。

- 上下文窗口优化涉及到如何有效地选择和压缩输入数据,以减少模型的计算负担。

- 多种检索策略包括基于关键词的搜索、向量空间模型和图遍历等。

实际业务场景中的应用案例

- 短视频创作工具的云端渲染与特效处理系统:通过Spring AI驱动的自动化脚本,可以在云端快速生成高质量的视频特效,显著缩短制作周期。

- UGC内容审核系统:多模态内容审核管道不仅提高了审核效率,还减少了人工干预的需求。

常见陷阱和优化方向

- 过度依赖单一模型:可能导致鲁棒性不足,应探索多模型融合方案。

- 忽视数据隐私:在处理用户数据时,务必遵循相关法律法规,采取加密和脱敏措施。

相关技术的发展趋势和替代方案比较

- Transformer vs RNN:虽然Transformer在许多任务上表现出色,但在某些序列建模任务中,RNN仍然具有优势。

- 云原生AI平台:越来越多的企业开始采用云原生解决方案,如AWS SageMaker和Google Vertex AI,这些平台提供了丰富的工具和服务,降低了AI开发门槛。

幽默金句总结

- “Kafka就像是一个巨大的水坝,不管上游洪水多么汹涌,下游都能保持平稳的水流。”

- “在每个城市都设立了一个小型图书馆,读者可以就近借阅书籍,而不需要每次都跑到中央图书馆。”

- “这就像在大型派对上,每个人都有自己的私人服务员,随时准备响应他们的需求。”

- “把重要文件锁进银行保险箱,只有授权人员才能访问。”

- “维护一张复杂的铁路网图,不仅要记录每条线路,还要实时更新列车时刻表。”

![[ctfshow web入门] web77](https://i-blog.csdnimg.cn/direct/8706933533104cbd8e3579e6f0ae7ac9.png)