摘要:

跨模态行人重识别技术(cm-ReID)旨在可见光、红外等不同模态图像中识别出同一个人,其在人 机协同、万物互联、跨界融合、万物智能的智能系统与装备中有重要应用。提出一种数据增强的跨模态行人 重识别方法,在波长域进行数据增强的同时保留可见图像的结构信息,以弥合不同模态之间的差距。在此基 础上,基于瑞芯微的 RK3588 芯片设计实现了一套边缘智能终端,并部署了跨模态行人重识别算法。

0 引言

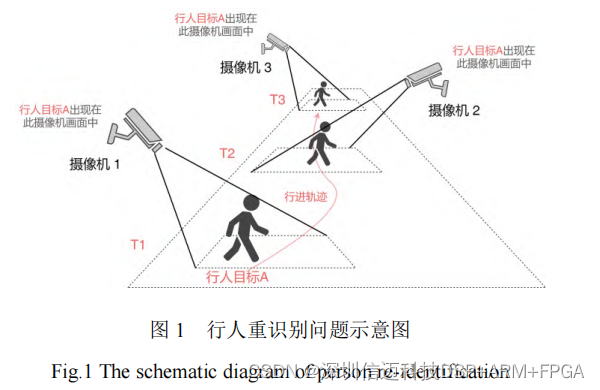

行人重识别(Re-ID),广泛用于视频监控,安

全和智慧城市等各种应用中,旨在解决在不同位置

部署的多个不重叠摄像机中检索感兴趣的行人问题,

由于其在智能视频监控中的重要性,已经引起了计

算机视觉界的越来越多的关注

[1-3]

。当前大量的行人

重识别模型都着眼于可见光-可见光行人图像匹配,

最常见的单模态行人重识别任务,如图1所示,给定

一个探测到的行人图像,并将其与其他不重叠的摄

像机捕获的一组图像进行匹配,该组图库包含所有

可见摄像机数据。由于照明,相机型号差异,视角

变化和姿势变化,前景行人图像可能会变化很大。

尽管存在这些挑战,但随着深度神经网络的发展以

及行人重识别研究的持续推进,在单一可见模态下,

可见光-可见光行人重识别取得了很大的进步并获

得了很高的精度

[4-6]。不过,由于可见光行人重识别

在某些不良的光照条件下,比如在黑夜中无法给出

相应的判别信号。所以如果只通过可见光摄像机,而

没有额外的人工光源,应用将受到限制,因为该系统

在每天的一半时段内都无法正常工作,这就极大地

影响了行人重识别的实际应用。

在实际情况下,如果使用24

h

智能监控系统,可

以在白天通过可见摄像机获取探测图像,而在夜间

通过热像仪捕获图像,图像来自不同的模态。对于实

际应用,现代监视系统通常以双模态运行,即白天

在可见模态下工作,而在夜间自动切换为红外模态。

给定行人的红外图像,目标是匹配相应行人的可见

图像。此跨模态图像匹配任务称为可见光红外行人

重识。与具有丰富色彩信息和结构图案的可见光图

像相比,红外图像是在红外光谱下捕获的,由于可

见光谱的反射率和热光谱的发射率之间存在自然差

异,从而导致外观完全不同,失去了鲜明的颜色特

征。模态差异使得在可见光光谱和红外光谱之间识

别同一个人变得更加困难。这个新问题是一个交叉

模态问题,近年来只有少数相关的前沿工作

[7-9]

。

为推动跨模态行人重识别技术在智能系统与装

备中的实际应用,参考边缘智能终端

[10-15]

的部署应

用,本文提出了一种高效的跨模态波长增强的行人

重识别方法,在波长域进行数据增强的同时保留可

见图像的结构信息,以弥合不同模态之间的差距。同

时,本文基于国产化RK3588芯片设计了边缘智能终

端,部署了跨模态行人重识别算法,并设计实现了

人工智能综合视频监控软件。实践表明,本文提出的

方法在两个基准数据集SYSU-MM01

[16]

和RegDB

[17]

上取

得了较好的性能,并能够在实际场景中进行应用部

署。

1

跨模态行人重识别方法

1.1

红外可见光跨模态行人重识别数据集

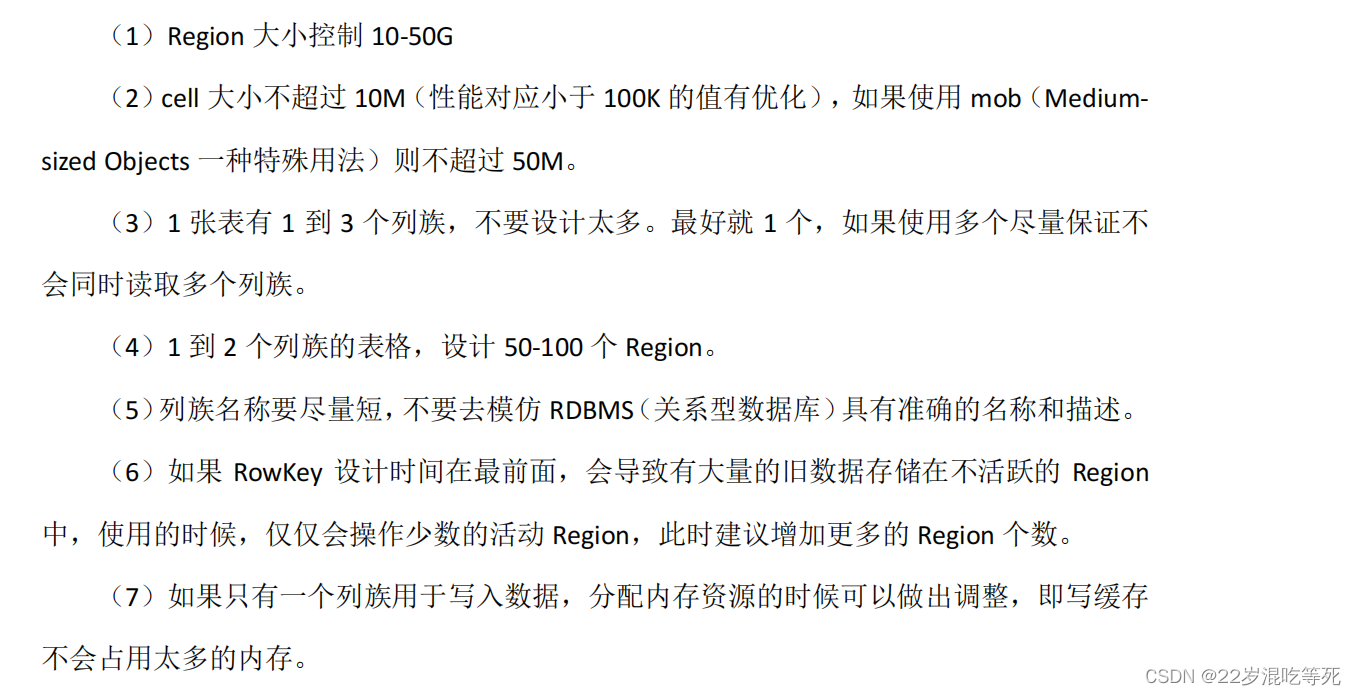

为了研究可见光红外跨模态行人重识别问题,

需要收集同一行人对应的可见光图像和红外图像,

如图2所示。文献[16]提出了SYSU-MM01数据集,其

中包括了由4个可见光摄像机以及2台在室内和户外

拍摄的近红外摄像机所拍摄的影像,其中的可见光

图像由Kinect V1在明亮的室内房间拍摄,红外图像

是由近红外相机在黑暗条件下拍摄的。

在文献[17]的工作中,提出了一个新的称为

RegDB的可见光热红外数据集,该数据集利用文献

[16]中的原始数据并设计了类似于SYSU-MM01数据

集的架构。RegDB

[17]

数据集中,可见光摄像机拍摄的

图像分辨率为800×600像素,红外摄像机拍摄的图

像分辨率为640×480像素,总共采集了412名行人的

8 240张图片(包含4 120张可见光图像和4 120张对

应的红外图像)。主要区别在于,SYSUMM01包含可

见光和近红外图像,而RegDB包含可见光和远红外图

像,这使得一些方法在两个数据集中都难以工作。

由于波长较短,来自SYSU-MM01数据集的近红外图像

具有清晰的边缘和清晰的背景。作为比较,RegDB数

据集中的远红外图像边缘模糊,丢失了许多彩色图

案。

1.2

红外可见光跨模态行人重识别方法

较大的跨模态差异是红外可见光跨模态行人重

识别的最大问题,这是由可见光和热像仪的不同反

射可见光谱和感测到的发射率引起的。可见光图像

具有3个通道,其中包含波长范围为

400~700 nm

的可

见光的颜色信息,包含足够的人的肤色信息,而热图

像具有一个包含不可见光信息的通道,其波长比可

见光的波长更长。因此,这两种方式本质上是不同

的,导致可见光行人重识别中行人的最重要的颜色

信息特征,很难用于红外可见光跨模态行人重识别

的异构数据。当将这两种模态的图像直接进行联合

跨模态学习时,大多数现有的红外可见光跨模态行

人重识别方法变得对参数敏感,难以收敛且计算量

大。

目前的红外可见光跨模态行人重识别方法大多

将输入图像转换为相同或不同的模态图像,或由

GAN

生成相似的图像,受到以下限制:

1)

将可见光图像、灰度图像、红外图像同步输

入网络,但忽略它们对波长的依赖性会丢失波长之

间相关性的大量信息,这将影响最终性能,例如图

3

(a)所示。

2)

不同层次特征之间的不同感受野可能会降低

直接特征融合的效果,因为结果感受野减少。

3)

来自不同模态的图像很少,仅在

3

个

RGB

通

道中保持可见光图像的颜色或简单地将可见图像转

换为灰度图像就限制了跨模态行人重识别的数据增

强,例如图

3

(b)、图

3

(c)所示。

本文提出了一种颜色抖动增强方法,用于数据

增强模型中不同波长之间的关系,如图

3

(d)所示。

在文献

[18]

中提出的基于同质增强的三元跨模态行

人重识别学习方法的基础上,在基于亮度、对比度、

道到增强模态的映射,具体操作中在

torchvision

中

使用

torchvision.transforms.ColorJitter()

函数来实现

亮度、对比度、饱和度和色调空间的随机调整。与

现有的数据增强方法不同

[18]

,颜色抖动增加了每个

波长的多样性,从而为整个输入产生了更多不同强

度波长的信息组合。有了这种颜色抖动,生成的图

像将在不同波长上有效地增加互补信息,而不需要

额外的注释数据。然后将红外、可见、增强模态这

3

种图像经过一个参数共享的单流网络来学习不同图

像输入之间的关系,并根据这种关系从不同的模态

中搜索物体。

2 边缘智能终端部署

2.1 硬件实现

与目标检测、目标跟踪等一般视觉人工智能任

务可采用单一计算机后端不同,跨模态行人重识别

技术是跨摄像机多视角的视觉人工智能任务,涉及

到多路视频流信号的联合分析,在前端设备数量较

多的情况下,单一处理后端难以满足实际的

AI

推理

高计算量需求,限制了整体应用系统的扩展性。

为了验证及演示本文提出的跨模态行人重识别

技术的先进性及实用性,本文单独设计了一套边缘

计算系统实现,如图 4 所示。边缘计算系统以板卡

的形式将跨模态行人重识别神经网络推理单元集成

到每路摄像设备前端。实际工作时,可见光、红外

模态视频流数据经过边缘计算系统实时处理分析后,

将图像与人工智能推理结果一同回传给后端,降低

了数据集中处理的计算压力,且系统弹性可扩展,

不受接入前端设备的数量影响,更符合跨模态行人

重识别任务的实际应用场景需求。

如图

5

所示,边缘计算系统硬件方案以国产瑞

芯微

RK3588

处理器为处理核心,该处理器采用四

核

ARM Cortex-A76+

四核

Cortex-A55

处理单元,搭

配

16G

板载内存,系统整体具有高性能、低功耗的

特点,典型功耗

10 W

。内置

NPU

(神经网络处理单

元),支持

INT4/INT8/INT16/FP16

混合计算,含

3

个

NPU

独立核心,可联合计算亦可单独工作,浮点

计 算 运 算 能 力 高 达

6TOP

。具备

H.264/H.265/VP9/AVS2

等格式的专用编解码硬件模

块,支持高达

8k

分辨率视频流的实时编解码。系统

支持

2

路千兆以太网接口。同时针对多模态视频监

控的特定任务场景,本文方案扩展搭配

ADV7281A

模拟视频解码芯片,提供四路模拟视频接口,兼容

NTSC/PAL/SECAM

多制式模拟视频,形成了完整的

模拟

/

数字视频流的兼容支持能力。提供

5

组

485

接

口,可以对转台、云台等设备进行串口控制。

图

5

基于

RK3588

处理器的边缘智能终端实物图(左为终

端正面,右为终端反面)

2.2

软件环境

边缘计算部署软件环境由

PC

端开发转换环境

与边缘段部署运行环境两部分组成。

PC

端开发转换环境为瑞芯微提供的

RKNN

Toolkit2

工具链,其包含一组兼容

Caffe

、

TensorFlow

、

ONNX

、

PyTorch

等人工智能框架,进行神经网络模

型调整、优化、转换的基础软件工具及多语言编程

接口,用于将训练完成的人工智能网络模型转换输

出为

RKNN

专用格式。如图 6 所示,边缘端部署运

行环境具体包含:

1)

视频流取流模块,用于读取可见光或红外热

成像摄像机视频流,支持

RTSP/RTMP

等网络流格

式的网络摄像机或者

MIPI/USB

接口的数字摄像头

设备。

2)

人工智能神经网络推理核心单元,其为瑞芯

微官方提供的

RKNPU2

基础

NPU

推理环境,其作

用为将

PC

端处理转换后的

RKNN

格式的神经网络

模型部署在芯片专属

NPU

单元中,同时接收取流模

块获取的可见光或者红外视频流进行神经网络推理,

并向后输出推理结果。

3)

流媒体服务器模块,用于将通过人工智能神

经网络处理后的的可见光或红外视频流进行二次推

流输出到后端。针对显控终端软件不同显控需求,

本方案提供

3

种视频流输出方式:针对调试、非

AI

显示功能,提供原始视频流转发透传模式;针对一

般性非交互

AI

推理显示功能,提供叠加显示模式,

即

AI

推理结果与原始视频图像叠加后输出给后端;

针对客户端需要对

AI

推理结果进一步加工的功能,

提供

AI

推理结果单独输出模式。

4)

设备串口控制模块,用于向摄像机前端发送

串口控制命令,控制其转动,扫描等功能动作;

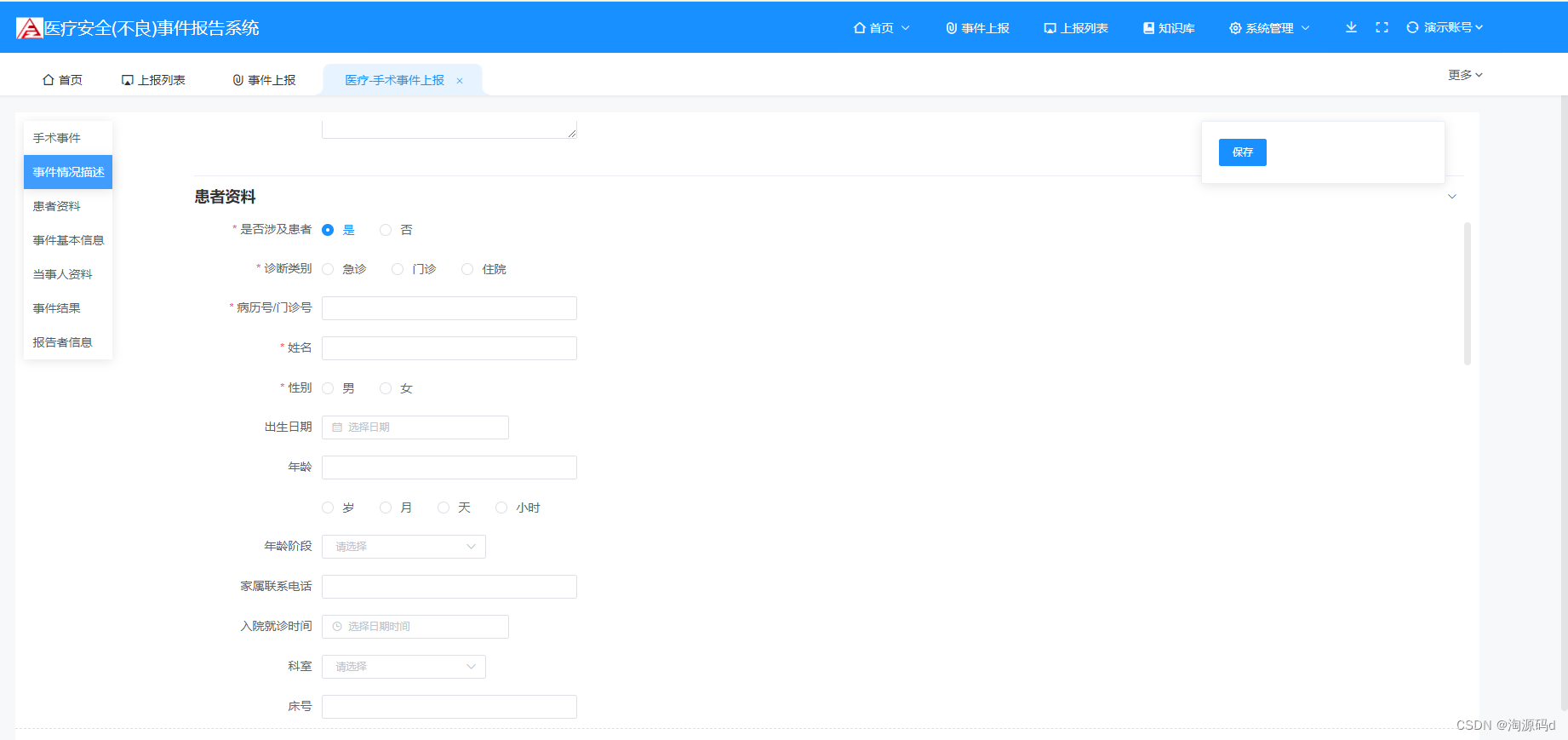

5)Web

服务模块,用于向后端提供直观、易用

的基于

Web

界面的设置接口,同时可实时向后端报

告边缘计算系统运行状态,包括板载各项硬件状态、

软件功能模块、通信状态等部分的实时监测信息,

易于显控终端程序对板载各个系统进行监测,并对

板载资源进行相应的规划与调整。同时提供

GUI

接

口,配置看门狗、上电重连、断线重连、灾难恢复

等功能辅助功能,最大化板载功能的易用性。

该设计方案通过引入层级配置文件的配置方案,

提供系统状态版本切换功能,即可根据具体应用场

景需求,通过上传系统功能配置文件的形式,一键

切换系统工作状态,或者通过提供不同版本的系统

配置文件,针对具体情境进行工作状态动态切换,

便于系统调试或者提供基于场景的工作模式切换功

能。

图 7 边缘智能终端软件依赖关系图

如图 7 所示,该设计通过将系统抽象成相互独

立的功能模块,相互之间通过接口结合配置信息进

行组合形成具体功能的形式,最大化的保持了系统

的扩展性,以适应不断变化的应用需求。同时,模

块化的设计支持对每个独立功能部分进行迭代升级,

或者引入新的功能模块,为系统提供最大化向后扩

展可能性保障。通过

WEB

向用户提供直观、易用的

用户交互接口,系统所有功能设置,参数设置,系

统状态等均可通过该用户接口进行统一设定,最小

化系统使用难度。

3

实验与结果分析

3.1

模型训练与部署

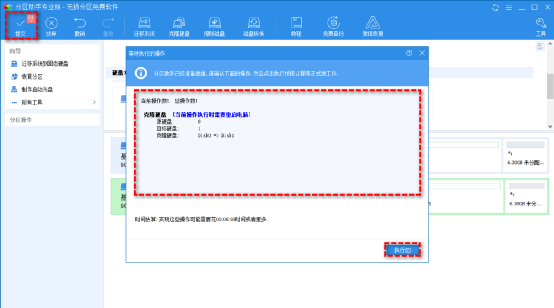

如图 8 所示,模型训练分为以下

4

个步骤:

步骤 1

数据准备及格式转换。将 SYSUMM01、

RegDB多摄像机可见光、红外热成像图像数据混合、

清洗、均衡化后统一转换为

PASVCAL

格式数据文

件。

步骤 2 将预处理的多模态数据进行增强,即在

基于亮度、对比度、饱和度和色调空间的抖动,从

可见图像生成增强模态,在波长域进行数据增强的

同时保留可见图像的结构信息。

步骤 3

根据数据集多模态成分具体构成,决定

模型每个训练周期训练数据分割策略、模型学习率

调整关系等策略参数,构建输出训练模型策略配置

文件。

步骤 4

执行模型训练程序,训练结束后生

成

.pth

格式神经网络模型。

将训练生成的

.pth

神经网络模型权重文件转换

成为瑞芯微专属

RKNN

格式,须先将其转换为

ONNX

格式。

ONNX

(

Open Neural Network Exchange

)

是一种针对机器学习所设计的开放式的文件格式,

用于存储训练好的模型。它使得不同的人工智能框

架(如

Pytorch, MXNet

)可以采用相同格式存储模

型数据并交互。通过调用

torch.onnx

模块将神经网

络模型权重文件转换为

.ONNX

神经网络交换文件。

下面通过调用

RKNN Toolkit2

工具将

.ONNX

文

件转换为瑞芯微专属

RKNN

专属神经网络权重文件

并存储于边缘计算板的预定目录。利用

RK3588

部

署时,实际采集的可见光和红外图像分辨率不一致,

可见光图像分辨率为

1 920

×

1 080

,红外图像分辨

率为

640

×

512

。实际部署中,将可见光图像降采样

为

640

×

512 作为模型的输入,对不同分辨率的图像

调整为一致的分辨率进行处理。通过与边缘计算版

取流与流媒体服务器模块结合,可完成可见光

/

红外

图像实时读取分析回传后端的完整边缘计算功能。

3.2

实验结果分析

将本文提出的方法与 HCML

[19]

、Zero-Pad

[16]

、

HSME

[20]

、D2RL

[21]

、MAC

[22]

、MSR

[23]

、HAT

[18]

在两个基准

数据集 SYSU-MM01

[16]

和 RegDB

[17]

上进行了实验和比

较。其中在 SYSU-MM01 数据集上的运行结果如表 1

所示,在 RegDB 数据集上的运行结果如表 2 所示。

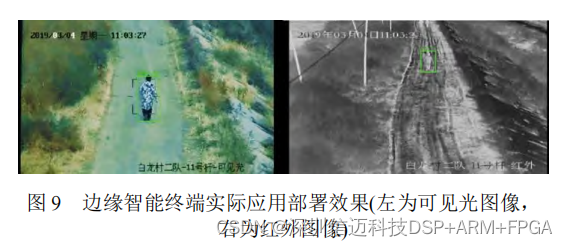

同时,将本文设计的边缘智能终端部署于昼夜

安防监控的实际应用场景中,运行效果如图

9

所示,

左侧为可见光图像,右侧为跨模态行人重识别算法

匹配的红外图像。

4

结论

本文研究了红外可见光跨模态行人重识别方法

及基于边缘智能终端的部署。得出主要结论如下:

1)

提出了一种高效的跨模态波长增强的行人重

识别方法,以弥合不同模态之间的差距。该方法在

两个基准数据集

SYSU-MM01

和

RegDB

上取得了

较好的性能

2)

在实践中,基于国产化

RK3588

芯片设计了

边缘智能终端,并部署了跨模态行人重识别算法。

实践表明,能够在昼夜安防监控场景中进行应用部

署。

关于未来的研究方向,可以从如下角度考虑:

1)

构建更高质量的红外可见光数据集:目前基

于红外和可见光的数据集相当匮乏,构建高质量的

数据集有助于以深度学习网络为代表的方法的模型

优化。

2)

利用多模态和传感器信息:结合多种传感器

的空间姿态、性能等参数信息,可以利用更多的先

验信息提升性能。

信迈提供RK3588视觉方案。

![[Dubbo] 重要接口与类](https://img-blog.csdnimg.cn/21c1dde285854163a96ca36d42a0ce2a.png)