在自然语言处理(NLP)的广阔天地中,序列数据是绝对的核心——无论是流淌的文本、连续的语音还是跳跃的时间序列,都蕴含着前后紧密关联的信息。传统神经网络如同面对一幅打散的拼图,无法理解词语间的顺序关系,注定在序列任务上举步维艰。而循环神经网络(RNN)的诞生,正是为了解决这一核心挑战,为机器赋予了处理序列信息的记忆能力。

一、序列数据:NLP世界的基石

序列数据无处不在:

-

文本序列: "我爱自然语言处理" – 每个字的位置都影响语义

-

语音信号: 随时间变化的声波,前后帧高度相关

-

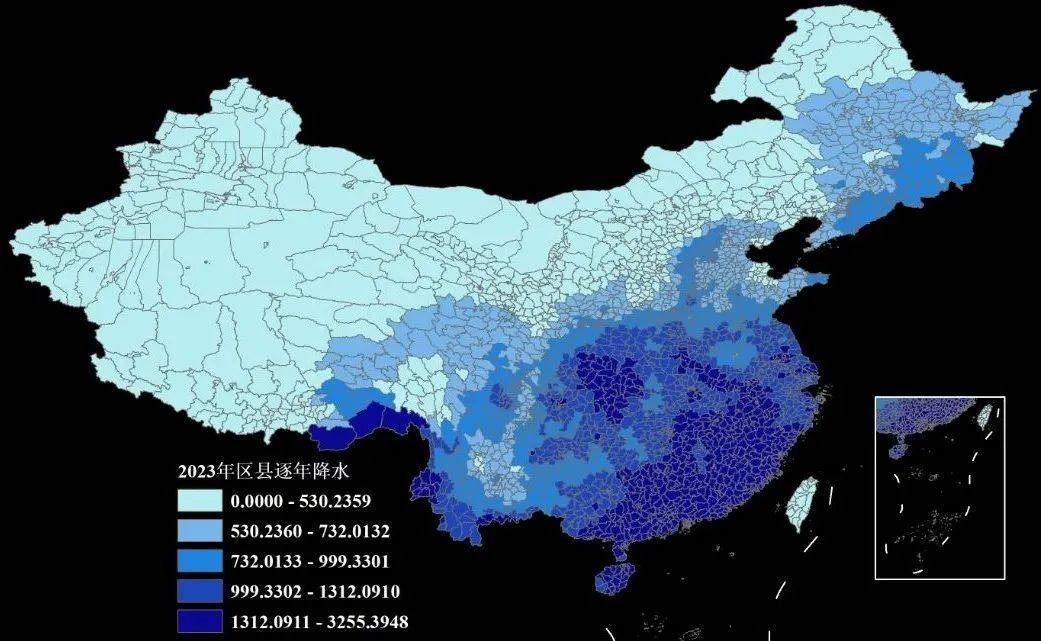

时间序列: 股票价格、气象数据、用户行为日志

关键特性: 序列中元素的顺序至关重要。"猫追老鼠"与"老鼠追猫"意义截然相反。传统神经网络(如MLP、CNN)的固定输入输出结构无法有效建模这种动态的、长度可变的依赖关系。

二、RNN:赋予网络记忆的灵魂

RNN的核心思想直击要害:引入“记忆”概念,使网络具备对历史信息的持续感知能力。

1. 循环结构:时间展开的秘密

想象一个不断自我更新的笔记本:

-

输入序列: 在时间步

t,接收输入x_t(如句子中的第t个词向量) -

隐藏状态

h_t: 网络的“记忆体”,编码了截至当前时间步的所有历史信息 -

输出

y_t: 基于当前记忆h_t生成的预测(如下一个词的概率分布)

核心递归公式:

h_t = f(W_{xh} * x_t + W_{hh} * h_{t-1} + b_h)

y_t = g(W_{hy} * h_t + b_y)

其中:

-

f和g是激活函数(如tanh,softmax) -

W_{xh},W_{hh},W_{hy}是权重矩阵 -

b_h,b_y是偏置向量 -

h_{t-1}是前一时间步的隐藏状态,充当了记忆的角色

RNN在时间维度上展开,形成深度网络链,共享参数W

2. 参数共享:智慧的传承

与传统网络不同,RNN在所有时间步共享同一组参数 (W_{xh}, W_{hh}, W_{hy})。这带来两大优势:

-

模型尺寸恒定: 无论输入序列多长,参数量不变,大大提升内存效率

-

泛化能力增强: 网络学会的“处理序列片段”的知识可泛化到序列的不同位置

3. 前向传播:记忆的流动之旅

以句子“我爱NLP”为例(分词为["我", "爱", "NLP"]):

-

t=1:输入x1 = "我",初始h0常置零向量

h1 = tanh(W_{xh} * "我" + W_{hh} * h0 + b_h)→ 记忆更新为包含“我” -

t=2:输入x2 = "爱"

h2 = tanh(W_{xh} * "爱" + W_{hh} * h1 + b_h)→ 记忆融合了“我爱” -

t=3:输入x3 = "NLP"

h3 = tanh(W_{xh} * "NLP" + W_{hh} * h2 + b_h)→ 记忆包含完整句子信息 -

输出

y3可能预测句子结束符或下一个可能词

三、RNN的训练:穿越时间的反向传播(BPTT)

训练RNN如同教导一个拥有记忆的学生回顾历史错误。BPTT算法是标准反向传播在时间轴上的扩展:

-

前向传播: 沿时间轴展开网络,计算所有

h_t和y_t -

计算损失: 汇总各时间步损失(如交叉熵)

L = Σ L_t(y_t, y_true_t) -

反向传播: 从

t=T开始倒序计算梯度:-

损失

L对y_t的梯度 -

y_t梯度反向传播至h_t -

关键:

h_t的梯度不仅来自当前输出,还来自下一时刻的隐藏状态h_{t+1}(因为h_t影响h_{t+1}),梯度计算变为:

∂L/∂h_t = (∂L/∂h_t|_{direct}) + (∂L/∂h_{t+1} * ∂h_{t+1}/∂h_t)

-

-

参数更新: 累加所有时间步梯度,更新共享权重

W

四、RNN的阿喀琉斯之踵:挑战与局限

尽管开创性,基础RNN面临严峻挑战:

1. 梯度消失/爆炸:记忆的消散与风暴

-

问题本质: 计算

h_t对h_k (k<<t)的梯度时,涉及多次矩阵连乘:

∂h_t / ∂h_k ≈ ∏_{i=k}^{t-1} (diag(f') * W_{hh}) -

梯度消失: 若

W_{hh}的特征值<1,梯度指数级衰减 → 网络无法学习长距离依赖(如段落开头的主题词影响结尾) -

梯度爆炸: 若

W_{hh}的特征值>1,梯度指数级增长 → 数值溢出,训练崩溃 -

影响: RNN实际只能有效利用有限历史(约10步),成为处理长序列的瓶颈。

2. 长程依赖建模困难

梯度消失直接导致模型难以关联序列中相隔较远的相关元素,如:

“在遥远东方的古老王国里,住着一位...(数百词后)... 巨龙守护着宝藏。”

基础RNN可能遗忘关键主语“巨龙”与开头的关联。

3. 计算效率与并行化

RNN的顺序依赖性(计算 h_t 必须先有 h_{t-1})阻碍了GPU的并行加速潜力,训练速度受限。

五、进化之路:RNN的强力变体

为克服基础RNN缺陷,研究者提出革命性改进:

1. LSTM:长短期记忆网络(记忆的精密控制)

LSTM引入“门控”机制和细胞状态 C_t,如同一个可精确读写擦除的记忆板:

-

遗忘门

f_t: 决定丢弃哪些旧记忆C_{t-1}

f_t = σ(W_f * [h_{t-1}, x_t] + b_f) -

输入门

i_t: 控制新信息̃C_t的写入量

i_t = σ(W_i * [h_{t-1}, x_t] + b_i)

̃C_t = tanh(W_C * [h_{t-1}, x_t] + b_C) -

细胞状态更新:

C_t = f_t ⊙ C_{t-1} + i_t ⊙ ̃C_t→ 核心!梯度高速公路 -

输出门

o_t: 基于C_t生成当前输出h_t

o_t = σ(W_o * [h_{t-1}, x_t] + b_o)

h_t = o_t ⊙ tanh(C_t)

LSTM通过门控机制保护梯度,解决长程依赖问题

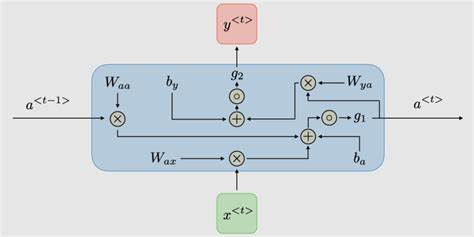

2. GRU:门控循环单元(简约高效的记忆)

GRU融合LSTM的门控思想,结构更简洁:

-

重置门

r_t: 控制历史记忆h_{t-1}对当前新候选状态的影响

r_t = σ(W_r * [h_{t-1}, x_t]) -

更新门

z_t: 平衡旧状态h_{t-1}和新候选状态̃h_t

z_t = σ(W_z * [h_{t-1}, x_t]) -

候选状态:

̃h_t = tanh(W * [r_t ⊙ h_{t-1}, x_t]) -

隐藏状态更新:

h_t = (1 - z_t) ⊙ h_{t-1} + z_t ⊙ ̃h_t

GRU在效果接近LSTM的同时,参数更少,计算效率更高,成为许多场景的首选。

六、RNN在NLP中的璀璨应用

RNN及其变体推动了NLP的爆发式发展:

-

语言建模: 预测下一个词的概率

P(w_t | w_1, w_2, ..., w_{t-1}),是机器翻译、语音识别的基石。 -

文本生成: 基于历史词序列生成连贯文本(诗歌、故事、代码)。

-

机器翻译: 经典Seq2Seq架构:编码器RNN压缩源语言句义为向量,解码器RNN据此生成目标语言序列。

-

情感分析: 分析评论/推文的整体情感倾向(正面/负面),需理解上下文语气。

-

命名实体识别: 序列标注任务,识别文本中人名、地名、组织名(如

[B-PER, I-PER, O, O, B-LOC])。 -

语音识别: 将声学特征序列映射为文字序列。

# 使用PyTorch实现一个简单的GRU情感分类器 import torch import torch.nn as nn class SentimentGRU(nn.Module): def __init__(self, vocab_size, embed_dim, hidden_dim, output_dim): super().__init__() self.embedding = nn.Embedding(vocab_size, embed_dim) self.gru = nn.GRU(embed_dim, hidden_dim, batch_first=True) self.fc = nn.Linear(hidden_dim, output_dim) # 输出情感类别 def forward(self, text): # text: [batch_size, seq_length] embedded = self.embedding(text) # [batch_size, seq_len, embed_dim] output, hidden = self.gru(embedded) # 取最后一个时间步的隐藏状态作为句子表示 return self.fc(hidden.squeeze(0))

七、总结与展望:RNN的遗产与新篇章

循环神经网络(RNN)及其变体LSTM、GRU,是序列建模史上的里程碑。它们通过循环结构与隐藏状态,赋予神经网络处理序列数据的关键能力——记忆,解决了传统模型处理不定长、依赖关系的难题。

尽管如今Transformer凭借其自注意力机制和强大的并行能力,在诸多NLP任务中(如BERT、GPT)取得更优表现,但RNN的价值并未褪色:

-

历史地位: 深刻理解RNN是掌握序列建模思想的必经之路。

-

特定场景优势: 在流式数据处理(实时语音识别)、超长序列(某些时序预测)、资源受限环境(GRU的轻量性)中,RNN及其变体仍有独特价值。

-

模型融合: RNN常作为Transformer架构中的组件,如编码器的补充层。