目录

一、短信登录(redis+seesion)

基于Session实现登录流程

🔄 图中关键模块解释:

利用seesion登录的问题

设计key的具体细节

整体访问流程

二、商户查询缓存

reids与数据库主动更新的三种方案

缓存穿透

缓存雪崩问题及解决思路

缓存击穿问题及解决思路

三、优惠券秒杀

全局唯一ID

初步实现秒杀下单秒杀下单应该思考的内容:

乐观锁解决超卖问题

有关超卖问题分析:在我们原有代码中是这么写的

悲观锁解决一人一单

分布式锁解决集群模式下的秒杀问题

分布式锁

解决Redis分布式锁误删问题

四、Reidssion

1. 分布式锁-redission功能介绍

2. 分布式锁-redission可重入锁原理

3. 分布式锁-redission锁重试和WatchDog机制

4. 分布式锁-redission锁的MutiLock原理

五、异步秒杀优化

Redis消息队列-基于Stream的消息队列-消费者组

项目分为

重点:短信登录、商户查询缓存、优惠券秒杀、用户签到

这部分涉及到reids+seesion、缓存击穿、缓存穿透、缓存雪崩、乐观锁,悲观锁、分布式锁、与HyperLogLog的使用,对我们来说非常的重要

一、短信登录(redis+seesion)

基于Session实现登录流程

发送验证码:

用户在提交手机号后,会校验手机号是否合法,如果不合法,则要求用户重新输入手机号

如果手机号合法,后台此时生成对应的验证码,同时将验证码进行保存,然后再通过短信的方式将验证码发送给用户

短信验证码登录、注册:

用户将验证码和手机号进行输入,后台从session中拿到当前验证码,然后和用户输入的验证码进行校验,如果不一致,则无法通过校验,如果一致,则后台根据手机号查询用户,如果用户不存在,则为用户创建账号信息,保存到数据库,无论是否存在,都会将用户信息保存到session中,方便后续获得当前登录信息

校验登录状态:

用户在请求时候,会从cookie中携带者JsessionId到后台,后台通过JsessionId从session中拿到用户信息,如果没有session信息,则进行拦截,如果有session信息,则将用户信息保存到threadLocal中,并且放行

Tomcat运行原理

response:响应,反应

用户通过 socket 发起 HTTP 请求,Tomcat 接收并分发请求到工作线程,由 Web 应用(如 Spring Boot)中的 Controller → Service → DAO 完成处理后,再将结果通过 response 写回用户。

🔄 图中关键模块解释:

| 模块 | 说明 |

| 用户 socket | 发起 TCP 连接,发送 HTTP 请求。 |

| Tomcat | Java Web 容器,监听端口、管理线程池、转发请求到 Web 应用。 |

| 监听线程 | 监听 TCP 请求,交由线程池中的工作线程处理。 |

| 工作线程池 | 处理具体的请求(取 socket 数据、封装 request/response)。 |

| WebApp | 实际部署在 Tomcat 里的 Web 应用,如使用 Spring MVC 开发的项目。 |

| Controller | 接收请求,调度服务层。 |

| Service | 处理业务逻辑。 |

| DAO | 与数据库进行交互。 |

| DB | 后端数据库。 |

利用seesion登录的问题

每个tomcat中都有一份属于自己的session,假设用户第一次访问第一台tomcat,并且把自己的信息存放到第一台服务器的session中,但是第二次这个用户访问到了第二台tomcat,那么在第二台服务器上,肯定没有第一台服务器存放的session,所以此时 整个登录拦截功能就会出现问题,我们能如何解决这个问题呢?早期的方案是session拷贝,就是说虽然每个tomcat上都有不同的session,但是每当任意一台服务器的session修改时,都会同步给其他的Tomcat服务器的session,这样的话,就可以实现session的共享了

但是这种方案具有两个大问题

1、每台服务器中都有完整的一份session数据,服务器压力过大。

2、session拷贝数据时,可能会出现延迟

所以咱们后来采用的方案都是基于redis来完成,我们把session换成redis,redis数据本身就是共享的,就可以避免session共享的问题了

首先我们要思考一下利用redis来存储数据,那么到底使用哪种结构呢?由于存入的数据比较简单,我们可以考虑使用String,或者是使用哈希,如下图,如果使用String,同学们注意他的value,用多占用一点空间,如果使用哈希,则他的value中只会存储他数据本身,如果不是特别在意内存,其实使用String就可以啦。

设计key的具体细节

所以我们可以使用String结构,就是一个简单的key,value键值对的方式,但是关于key的处理,session他是每个用户都有自己的session,但是redis的key是共享的,咱们就不能使用code了

在设计这个key的时候,我们之前讲过需要满足两点

1、key要具有唯一性

2、key要方便携带

如果我们采用phone:手机号这个的数据来存储当然是可以的,但是如果把这样的敏感数据存储到redis中并且从页面中带过来毕竟不太合适,所以我们在后台生成一个随机串token,然后让前端带来这个token就能完成我们的整体逻辑了

整体访问流程

当注册完成后,用户去登录会去校验用户提交的手机号和验证码,是否一致,如果一致,则根据手机号查询用户信息,不存在则新建,最后将用户数据保存到redis,并且生成token作为redis的key,当我们校验用户是否登录时,会去携带着token进行访问,从redis中取出token对应的value,判断是否存在这个数据,如果没有则拦截,如果存在则将其保存到threadLocal中,并且放行。

public class RefreshTokenInterceptor implements HandlerInterceptor {

private StringRedisTemplate stringRedisTemplate;

public RefreshTokenInterceptor(StringRedisTemplate stringRedisTemplate) {

this.stringRedisTemplate = stringRedisTemplate;

}

@Override

public boolean preHandle(HttpServletRequest request, HttpServletResponse response, Object handler) throws Exception {

// 1.获取请求头中的token

String token = request.getHeader("authorization");

if (StrUtil.isBlank(token)) {

return true;

}

// 2.基于TOKEN获取redis中的用户

String key = LOGIN_USER_KEY + token;

Map<Object, Object> userMap = stringRedisTemplate.opsForHash().entries(key);

// 3.判断用户是否存在

if (userMap.isEmpty()) {

return true;

}

// 5.将查询到的hash数据转为UserDTO

UserDTO userDTO = BeanUtil.fillBeanWithMap(userMap, new UserDTO(), false);

// 6.存在,保存用户信息到 ThreadLocal

UserHolder.saveUser(userDTO);

// 7.刷新token有效期

stringRedisTemplate.expire(key, LOGIN_USER_TTL, TimeUnit.MINUTES);

// 8.放行

return true;

}

@Override

public void afterCompletion(HttpServletRequest request, HttpServletResponse response, Object handler, Exception ex) throws Exception {

// 移除用户

UserHolder.removeUser();

}

}

//设置拦截器校验

public class LoginInterceptor implements HandlerInterceptor {

@Override

public boolean preHandle(HttpServletRequest request, HttpServletResponse response, Object handler) throws Exception {

// 1.判断是否需要拦截(ThreadLocal中是否有用户)

if (UserHolder.getUser() == null) {

// 没有,需要拦截,设置状态码

response.setStatus(401);

// 拦截,会返回等录界面

return false;

}

// 有用户,则放行

return true;

}

}二、商户查询缓存

实际开发中,会构筑多级缓存来使系统运行速度进一步提升,例如:本地缓存与redis中的缓存并发使用

浏览器缓存:主要是存在于浏览器端的缓存

应用层缓存:可以分为tomcat本地缓存,比如之前提到的map,或者是使用redis作为缓存

数据库缓存:在数据库中有一片空间是 buffer pool,增改查数据都会先加载到mysql的缓存中

CPU缓存:当代计算机最大的问题是 cpu性能提升了,但内存读写速度没有跟上,所以为了适应当下的情况,增加了cpu的L1,L2,L3级的缓存

由于数据库的查询速度比较慢,而且在大量查询条件下,数据库的查询有可能失败和造成数据库崩溃,所以我们可以添加一层缓存中间件,叫做redis

代码思路:如果缓存有,则直接返回,如果缓存不存在,则查询数据库,然后存入redis。

reids与数据库主动更新的三种方案

由于我们的缓存的数据源来自于数据库,而数据库的数据是会发生变化的,因此,如果当数据库中数据发生变化,而缓存却没有同步,此时就会有一致性问题存在,其后果是:

用户使用缓存中的过时数据,就会产生类似多线程数据安全问题,从而影响业务,产品口碑等;怎么解决呢?有如下几种方案

- Cache Aside Pattern 人工编码方式:缓存调用者在更新完数据库后再去更新缓存,也称之为双写方案

- Read/Write Through Pattern : 由系统本身完成,数据库与缓存的问题交由系统本身去处理

- Write Behind Caching Pattern :调用者只操作缓存,其他线程去异步处理数据库,实现最终一致(用一个独立的线程, 异步的去看一看缓存中的数据和数据库中的数据的一致性,进行异步的更新,效率比较高),如果缓存出现了宕机,那么就会产生数据丢失的问题

综合考虑使用方案一,但是方案一调用者如何处理呢?这里有几个问题

操作缓存和数据库时有三个问题需要考虑:

如果采用第一个方案,那么假设我们每次操作数据库后,都操作缓存,但是中间如果没有人查询,那么这个更新动作实际上只有最后一次生效,中间的更新动作意义并不大,我们可以把缓存删除,等待再次查询时,将缓存中的数据加载出来

- 删除缓存还是更新缓存?

-

- 更新缓存:每次更新数据库都更新缓存,无效写操作较多

- 删除缓存:更新数据库时让缓存失效,查询时再更新缓存

- 如何保证缓存与数据库的操作的同时成功或失败?(添加事务)

-

- 单体系统,将缓存与数据库操作放在一个事务

- 分布式系统,利用TCC等分布式事务方案(确保都能成功或者失败

应该具体操作缓存还是操作数据库,我们应当是先操作数据库,再删除缓存,原因在于,如果你选择第一种方案,在两个线程并发来访问时,假设线程1先来,他先把缓存删了,此时线程2过来,他查询缓存数据并不存在,此时他写入缓存,当他写入缓存后,线程1再执行更新动作时,实际上写入的就是旧的数据,新的数据被旧数据覆盖了。

- 先操作缓存还是先操作数据库?

-

- 先删除缓存,再操作数据库

- 先操作数据库,再删除缓存

综上所述,先操作数据库,再删除缓存更优

缓存穿透

缓存穿透 :缓存穿透是指客户端请求的数据在缓存中和数据库中都不存在,这样缓存永远不会生效,这些请求都会打到数据库。用户请求的数据在缓存中和数据库中都不存在,不断发起这样的请求,给数据库带来巨大压力

常见的解决方案有两种:

- 缓存空对象

-

- 优点:实现简单,维护方便

- 缺点:

-

-

- 额外的内存消耗

- 可能造成短期的不一致

-

- 布隆过滤

-

- 优点:内存占用较少,没有多余key

- 缺点:

-

-

- 实现复杂

- 存在误判可能

-

缓存空对象思路分析:当我们客户端访问不存在的数据时,先请求redis,但是此时redis中没有数据,此时会访问到数据库,但是数据库中也没有数据,这个数据穿透了缓存,直击数据库,我们都知道数据库能够承载的并发不如redis这么高,如果大量的请求同时过来访问这种不存在的数据,这些请求就都会访问到数据库,简单的解决方案就是哪怕这个数据在数据库中也不存在,我们也把这个数据存入到redis中去(设置比较短的TTL),这样,下次用户过来访问这个不存在的数据,那么在redis中也能找到这个数据就不会进入到缓存了

布隆过滤:布隆过滤器其实采用的是哈希思想来解决这个问题,通过一个庞大的二进制数组,走哈希思想去判断当前这个要查询的这个数据是否存在,如果布隆过滤器判断存在,则放行,这个请求会去访问redis,哪怕此时redis中的数据过期了,但是数据库中一定存在这个数据,在数据库中查询出来这个数据后,再将其放入到redis中,

假设布隆过滤器判断这个数据不存在,则直接返回

这种方式优点在于节约内存空间,存在误判,误判原因在于:布隆过滤器走的是哈希思想,只要哈希思想,就可能存在哈希冲突

缓存穿透的解决方案有哪些?

- 缓存null值(可能会存在短期不一致性)

- 布隆过滤(算法)

- 增强id的复杂度,避免被猜测id规律

- 做好数据的基础格式校验

- 加强用户权限校验

- 做好热点参数的限流

缓存雪崩问题及解决思路

缓存雪崩是指在同一时段大量的缓存key同时失效或者Redis服务宕机,导致大量请求到达数据库,带来巨大压力。

解决方案:

- 给不同的Key的TTL添加随机值

- 利用Redis集群提高服务的可用性(哨兵机制)

- 给缓存业务添加降级限流策略

- 给业务添加多级缓存(微服务),应对亿级以上的并发

缓存击穿问题及解决思路

缓存击穿问题也叫热点Key问题,就是一个被高并发访问并且缓存重建业务较复杂的key突然失效了,无数的请求访问会在瞬间给数据库带来巨大的冲击。

常见的解决方案有两种:

- 互斥锁

- 逻辑过期

逻辑分析:假设线程1在查询缓存之后,本来应该去查询数据库,然后把这个数据重新加载到缓存的,此时只要线程1走完这个逻辑,其他线程就都能从缓存中加载这些数据了,但是假设在线程1没有走完的时候,后续的线程2,线程3,线程4同时过来访问当前这个方法, 那么这些线程都不能从缓存中查询到数据,那么他们就会同一时刻来访问查询缓存,都没查到,接着同一时间去访问数据库,同时的去执行数据库代码,对数据库访问压力过大

解决方案一、使用锁来解决:

因为锁能实现互斥性。假设线程过来,只能一个人一个人的来访问数据库,从而避免对于数据库访问压力过大,但这也会影响查询的性能,因为此时会让查询的性能从并行变成了串行,我们可以采用tryLock方法 + double check来解决这样的问题。

假设现在线程1过来访问,他查询缓存没有命中,但是此时他获得到了锁的资源,那么线程1就会一个人去执行逻辑,假设现在线程2过来,线程2在执行过程中,并没有获得到锁,那么线程2就可以进行到休眠,直到线程1把锁释放后,线程2获得到锁,然后再来执行逻辑,此时就能够从缓存中拿到数据了。

解决方案二、逻辑过期方案

方案分析:我们之所以会出现这个缓存击穿问题,主要原因是在于我们对key设置了过期时间,假设我们不设置过期时间,其实就不会有缓存击穿的问题,但是不设置过期时间,这样数据不就一直占用我们内存了吗,我们可以采用逻辑过期方案。

我们把过期时间设置在 redis的value中,注意:这个过期时间并不会直接作用于redis,而是我们后续通过逻辑去处理。假设线程1去查询缓存,然后从value中判断出来当前的数据已经过期了,此时线程1去获得互斥锁,那么其他线程会进行阻塞,获得了锁的线程他会开启一个 线程去进行 以前的重构数据的逻辑,直到新开的线程完成这个逻辑后,才释放锁, 而线程1直接进行返回,假设现在线程3过来访问,由于线程线程2持有着锁,所以线程3无法获得锁,线程3也直接返回数据,只有等到新开的线程2把重建数据构建完后,其他线程才能走返回正确的数据。

这种方案巧妙在于,异步的构建缓存,缺点在于在构建完缓存之前,返回的都是脏数据。

进行对比

**互斥锁方案:**由于保证了互斥性,所以数据一致,且实现简单,因为仅仅只需要加一把锁而已,也没其他的事情需要操心,所以没有额外的内存消耗,缺点在于有锁就有死锁问题的发生,且只能串行执行性能肯定受到影响

逻辑过期方案: 线程读取过程中不需要等待,性能好,有一个额外的线程持有锁去进行重构数据,但是在重构数据完成前,其他的线程只能返回之前的数据,且实现起来麻烦

因为现在redis中存储的数据的value需要带上过期时间,此时要么去修改原来的实体类,要么新建一个实体类,我们采用第二个方案,这个方案,对原来代码没有侵入性。

@Data

public class RedisData {

private LocalDateTime expireTime;

private Object data;

}ShopServiceImpl

private static final ExecutorService CACHE_REBUILD_EXECUTOR = Executors.newFixedThreadPool(10);

public Shop queryWithLogicalExpire( Long id ) {

String key = CACHE_SHOP_KEY + id;

// 1.从redis查询商铺缓存

String json = stringRedisTemplate.opsForValue().get(key);

// 2.判断是否存在

if (StrUtil.isBlank(json)) {

// 3.存在,直接返回

return null;

}

// 4.命中,需要先把json反序列化为对象

RedisData redisData = JSONUtil.toBean(json, RedisData.class);

Shop shop = JSONUtil.toBean((JSONObject) redisData.getData(), Shop.class);

LocalDateTime expireTime = redisData.getExpireTime();

// 5.判断是否过期

if(expireTime.isAfter(LocalDateTime.now())) {

// 5.1.未过期,直接返回店铺信息

return shop;

}

// 5.2.已过期,需要缓存重建

// 6.缓存重建

// 6.1.获取互斥锁

String lockKey = LOCK_SHOP_KEY + id;

boolean isLock = tryLock(lockKey);

// 6.2.判断是否获取锁成功

if (isLock){

CACHE_REBUILD_EXECUTOR.submit( ()->{

try{

//重建缓存

this.saveShop2Redis(id,20L);

}catch (Exception e){

throw new RuntimeException(e);

}finally {

unlock(lockKey);

}

});

}

// 6.4.返回过期的商铺信息

return shop;

}三、优惠券秒杀

全局唯一ID

当用户抢购时,就会生成订单并保存到tb_voucher_order这张表中,而订单表如果使用数据库自增ID就存在一些问题:

- id的规律性太明显

- 受单表数据量的限制

场景分析:如果我们的id具有太明显的规则,用户或者说商业对手很容易猜测出来我们的一些敏感信息,比如商城在一天时间内,卖出了多少单,这明显不合适。

场景分析二:随着我们商城规模越来越大,mysql的单表的容量不宜超过500W,数据量过大之后,我们要进行拆库拆表,但拆分表了之后,他们从逻辑上讲他们是同一张表,所以他们的id是不能一样的, 于是乎我们需要保证id的唯一性。

全局ID生成器,是一种在分布式系统下用来生成全局唯一ID的工具,一般要满足下列特性:

所以我们就可以以第一位为符号位,后31位为毫秒级别自增的时间戳,后32为在reids中自增

/**

* 生成策略是基于redis的自增长,需要有key对应的值不断自增

* 不同的业务对应不同的key

* @param keyPrefix

* @return

*/

public Long nextId(String keyPrefix) {

//1.生成时间戳

LocalDateTime now = LocalDateTime.now();

long nowSecond = now.toEpochSecond(ZoneOffset.UTC);

long timestamp = nowSecond - BEGIN_TIMSTAMP;

//2.生成序列号,注入reids

//2.获取当前的日期,精确到天

String data = now.format(DateTimeFormatter.ofPattern("yyyy:MM:dd"));

long count = stringRedisTemplate.opsForValue().increment("icr:" + keyPrefix + ":" + data);

//3. 拼接并返回

//ps:这里左移32位为时间戳,|运算符表示,相同为0,相异为1

return timestamp << COUNT_BTTS | count;

}初步实现秒杀下单秒杀下单应该思考的内容:

下单时需要判断两点:

- 秒杀是否开始或结束,如果尚未开始或已经结束则无法下单

- 库存是否充足,不足则无法下单

下单核心逻辑分析:

当用户开始进行下单,我们应当去查询优惠卷信息,查询到优惠卷信息,判断是否满足秒杀条件

比如时间是否充足,如果时间充足,则进一步判断库存是否足够,如果两者都满足,则扣减库存,创建订单,然后返回订单id,如果有一个条件不满足则直接结束。

乐观锁解决超卖问题

有关超卖问题分析:在我们原有代码中是这么写的

if (voucher.getStock() < 1) {

// 库存不足

return Result.fail("库存不足!");

}

//5,扣减库存

boolean success = seckillVoucherService.update()

.setSql("stock= stock -1")

.eq("voucher_id", voucherId).update();

if (!success) {

//扣减库存

return Result.fail("库存不足!");

}假设线程1过来查询库存,判断出来库存大于1,正准备去扣减库存,但是还没有来得及去扣减,此时线程2过来,线程2也去查询库存,发现这个数量一定也大于1,那么这两个线程都会去扣减库存,最终多个线程相当于一起去扣减库存,此时就会出现库存的超卖问题。

超卖问题是典型的多线程安全问题,针对这一问题的常见解决方案就是加锁:而对于加锁,我们通常有两种解决方案:见下图:

悲观锁:

悲观锁可以实现对于数据的串行化执行,比如syn,和lock都是悲观锁的代表,同时,悲观锁中又可以再细分为公平锁,非公平锁,可重入锁,等等

乐观锁:

乐观锁:会有一个版本号,每次操作数据会对版本号+1,再提交回数据时,会去校验是否比之前的版本大1 ,如果大1 ,则进行操作成功,这套机制的核心逻辑在于,如果在操作过程中,版本号只比原来大1 ,那么就意味着操作过程中没有人对他进行过修改,他的操作就是安全的,如果不大1,则数据被修改过,当然乐观锁还有一些变种的处理方式,比如cas:

乐观锁的典型代表:就是cas,利用cas进行无锁化机制加锁,var5 是操作前读取的内存值,while中的var1+var2 是预估值,如果预估值 == 内存值,则代表中间没有被人修改过,此时就将新值去替换 内存值

其中do while 是为了在操作失败时,再次进行自旋操作,即把之前的逻辑再操作一次。

int var5;

do {

var5 = this.getIntVolatile(var1, var2);

} while(!this.compareAndSwapInt(var1, var2, var5, var5 + var4));

return var5;

悲观锁解决一人一单

需求:修改秒杀业务,要求同一个优惠券,一个用户只能下一单

现在的问题在于:

优惠卷是为了引流,但是目前的情况是,一个人可以无限制的抢这个优惠卷,所以我们应当增加一层逻辑,让一个用户只能下一个单,而不是让一个用户下多个单

具体操作逻辑如下:比如时间是否充足,如果时间充足,则进一步判断库存是否足够,然后再根据优惠卷id和用户id查询是否已经下过这个订单,如果下过这个订单,则不再下单,否则进行下单

VoucherOrderServiceImpl

初步代码:增加一人一单逻辑

if (count > 0) {

// 用户已经购买过了

return Result.fail("用户已经购买过一次!");

}存在问题:现在的问题还是和之前一样,并发过来,查询数据库,都不存在订单,所以我们还是需要加锁,但是乐观锁比较适合更新数据,而现在是插入数据,所以我们需要使用悲观锁操作

注意:在这里提到了非常多的问题,我们需要慢慢的来思考,首先我们的初始方案是封装了一个createVoucherOrder方法,同时为了确保他线程安全,在方法上添加了一把synchronized 锁

只要有一个线程进入该方法,其他任何线程想要进入这个对象实例的这个方法,都得等待,不管这些线程操作的数据是不是相互独立

@Transactional

public synchronized Result createVoucherOrder(Long voucherId) {

//代码

return Result.ok(orderId);

},但是这样添加锁,锁的粒度太粗了,在使用锁过程中,控制锁粒度 是一个非常重要的事情,因为如果锁的粒度太大,会导致每个线程进来都会锁住,所以我们需要去控制锁的粒度,以下这段代码需要修改为:

intern() 这个方法是从常量池中拿到数据,如果我们直接使用userId.toString() 他拿到的对象实际上是不同的对象,new出来的对象,我们使用锁必须保证锁必须是同一把,所以我们需要使用intern()方法

@Transactional

public Result createVoucherOrder(Long voucherId) {

synchronized(userId.toString().intern()){

// 5.1.查询订单

int count = query().eq("user_id", userId).eq("voucher_id", voucherId).count();

// 5.2.判断是否存在

if (count > 0) {

// 用户已经购买过了

return Result.fail("用户已经购买过一次!");

}

// 6.扣减库存

boolean success = seckillVoucherService.update()

.setSql("stock = stock - 1") // set stock = stock - 1

.eq("voucher_id", voucherId).gt("stock", 0) // where id = ? and stock > 0

.update();

if (!success) {

// 扣减失败

return Result.fail("库存不足!");

}

// 7.创建订单

VoucherOrder voucherOrder = new VoucherOrder();

// 7.1.订单id

long orderId = redisIdWorker.nextId("order");

voucherOrder.setId(orderId);

// 7.2.用户id

voucherOrder.setUserId(userId);

// 7.3.代金券id

voucherOrder.setVoucherId(voucherId);

save(voucherOrder);

// 7.返回订单id

return Result.ok(orderId);

}

}但是以上代码还是存在问题,问题的原因在于当前方法被spring的事务控制,如果你在方法内部加锁,可能会导致当前方法事务还没有提交,但是锁已经释放也会导致问题,所以我们选择将当前方法整体包裹起来,确保事务不会出现问题:如下:

在seckillVoucher 方法中,添加以下逻辑,这样就能保证事务的特性,同时也控制了锁的粒度

但是以上做法依然有问题,因为你调用的方法,其实是this.的方式调用的,事务想要生效,还得利用代理来生效,所以这个地方,我们需要获得原始的事务对象, 来操作事务

synchronized在集群模式下会失效,我们需要用到下面的分布式锁

分布式锁解决集群模式下的秒杀问题

通过加锁可以解决在单机情况下的一人一单安全问题,但是在集群模式下就不行了。

1、我们将服务启动两份,端口分别为8081和8082:

2、然后修改nginx的conf目录下的nginx.conf文件,配置反向代理和负载均衡:

有关锁失效原因分析

由于现在我们部署了多个tomcat,每个tomcat都有一个属于自己的jvm,那么假设在服务器A的tomcat内部,有两个线程,这两个线程由于使用的是同一份代码,那么他们的锁对象是同一个,是可以实现互斥的,但是如果现在是服务器B的tomcat内部,又有两个线程,但是他们的锁对象写的虽然和服务器A一样,但是锁对象却不是同一个,所以线程3和线程4可以实现互斥,但是却无法和线程1和线程2实现互斥,这就是 集群环境下,syn锁失效的原因,在这种情况下,我们就需要使用分布式锁来解决这个问题。

分布式锁

所以我们需要跨进程的锁

分布式锁的核心思想就是让大家都使用同一把锁,只要大家使用的是同一把锁,那么我们就能锁住线程,不让线程进行,让程序串行执行,这就是分布式锁的核心思路

那么分布式锁他应该满足一些什么样的条件呢?

可见性:多个线程都能看到相同的结果,注意:这个地方说的可见性并不是并发编程中指的内存可见性,只是说多个进程之间都能感知到变化的意思

互斥:互斥是分布式锁的最基本的条件,使得程序串行执行

高可用:程序不易崩溃,时时刻刻都保证较高的可用性

高性能:由于加锁本身就让性能降低,所有对于分布式锁本身需要他就较高的加锁性能和释放锁性能

安全性:安全也是程序中必不可少的一环

常见的分布式锁有三种:

Mysql:mysql本身就带有锁机制,但是由于mysql性能本身一般,所以采用分布式锁的情况下,其实使用mysql作为分布式锁比较少见

Redis:redis作为分布式锁是非常常见的一种使用方式,现在企业级开发中基本都使用redis或者zookeeper作为分布式锁,利用setnx这个方法,如果插入key成功,则表示获得到了锁,如果有人插入成功,其他人插入失败则表示无法获得到锁,利用这套逻辑来实现分布式锁

Zookeeper:zookeeper也是企业级开发中较好的一个实现分布式锁的方案,由于本套视频并不讲解zookeeper的原理和分布式锁的实现,所以不过多阐述

实现分布式锁时需要实现的两个基本方法:

- 获取锁:

-

- 互斥:确保只能有一个线程获取锁

- 非阻塞:尝试一次,成功返回true,失败返回false

- 释放锁:

-

- 手动释放

- 超时释放:获取锁时添加一个超时时间

要具备原子性,获取锁要么都成功要么都失败

SET lock thread1 EX 10 NX,nx代表没有就创建,有就不创建,Ex表示如果发生宕机,会在10s后自动释放

核心思路:

我们利用redis 的SETNX 方法,当有多个线程进入时,我们就利用该方法,第一个线程进入时,redis 中就有这个key 了,返回了1,如果结果是1,则表示他抢到了锁,那么他去执行业务,然后再删除锁,退出锁逻辑,没有抢到锁的哥们,等待一定时间后重试即可

实现分布式锁方案

SimpleRedisLock

利用setnx方法进行加锁,同时增加过期时间,防止死锁,此方法可以保证加锁和增加过期时间具有原子性

private static final String KEY_PREFIX="lock:"

@Override

public boolean tryLock(long timeoutSec) {

// 获取线程标示

String threadId = Thread.currentThread().getId()

// 获取锁

Boolean success = stringRedisTemplate.opsForValue()

.setIfAbsent(KEY_PREFIX + name, threadId + "", timeoutSec, TimeUnit.SECONDS);

return Boolean.TRUE.equals(success);

}- 释放锁逻辑

释放锁,防止删除别人的锁

public void unlock() {

//通过del删除锁

stringRedisTemplate.delete(KEY_PREFIX + name);

}解决Redis分布式锁误删问题

需求:修改之前的分布式锁实现,满足:在获取锁时存入线程标示(可以用UUID表示)

在释放锁时先获取锁中的线程标示,判断是否与当前线程标示一致

- 如果一致则释放锁

- 如果不一致则不释放锁

之前我们用的是线程的id,在jvm内部线程id是一个递增的数字,当我们在集群的模式下,多个jvm很有可能会出现线程id冲突的问题

所以说我们直接使用线程id区分锁是不够的,我们需要用UUID来区分不同的服务(jvm),再用线程id区分不同的线程,两者结合

核心逻辑:在存入锁时,放入自己线程的标识,在删除锁时我们利用UUID对每个锁独特标识,判断当前这把锁的标识是不是自己存入的,如果是,则进行删除,如果不是,则不进行删除。

同时,在更极端的情况下例如:

当线程1需要释放锁的时候,发生了阻塞,导致锁被超时自动释放,然后我们的线程2获取到了锁,刚好线程1又不阻塞了,这时候线程1要释放锁,因为前文已经做过判断了,所以这里很可能因为判断锁和释放锁没有保持原子性导致线程2的锁被释放

所以我们可以引入lua脚本来保证锁的原子性,同时观察redission的底层源码,我们也会发现,redission的底层也是采用lua脚本的方案

总结上文:

基于Redis的分布式锁实现思路:

- 利用set nx ex获取锁,并设置过期时间,保存线程标示

- 释放锁时先判断线程标示是否与自己一致,一致则删除锁

-

- 特性:

-

-

- 利用set nx满足互斥性

- 利用set ex,设置超时时间,保证故障时锁依然能释放,避免死锁,提高安全性

- 利用Redis集群保证高可用和高并发特性

-

我们一路走来,利用添加过期时间,防止死锁问题的发生,但是有了过期时间之后,可能出现误删别人锁的问题,这个问题我们开始是利用删之前 通过拿锁,比锁,删锁这个逻辑来解决的,也就是删之前判断一下当前这把锁是否是属于自己的,但是现在还有原子性问题,也就是我们没法保证拿锁比锁删锁是一个原子性的动作,最后通过lua表达式来解决这个问题

四、Reidssion

1. 分布式锁-redission功能介绍

基于setnx实现的分布式锁存在下面的问题:

重入问题:重入问题是指 获得锁的线程可以再次进入到相同的锁的代码块中,可重入锁的意义在于防止死锁,比如HashTable这样的代码中,他的方法都是使用synchronized修饰的,假如他在一个方法内,调用另一个方法,那么此时如果是不可重入的,不就死锁了吗?所以可重入锁他的主要意义是防止死锁,我们的synchronized和Lock锁都是可重入的。

不可重试:是指目前的分布式只能尝试一次,我们认为合理的情况是:当线程在获得锁失败后,他应该能再次尝试获得锁。

**超时释放:**我们在加锁时增加了过期时间,这样的我们可以防止死锁,但是如果卡顿的时间超长,虽然我们采用了lua表达式防止删锁的时候,误删别人的锁,但是毕竟没有锁住,有安全隐患

主从一致性: 如果Redis提供了主从集群,当我们向集群写数据时,主机需要异步的将数据同步给从机,而万一在同步过去之前,主机宕机了,就会出现死锁问题。

那么什么是Redission呢

Redisson是一个在Redis的基础上实现的Java驻内存数据网格(In-Memory Data Grid)。它不仅提供了一系列的分布式的Java常用对象,还提供了许多分布式服务,其中就包含了各种分布式锁的实现。

Redission提供了分布式锁的多种多样的功能

2. 分布式锁-redission可重入锁原理

在Lock锁中,他是借助于底层的一个voaltile的一个state变量来记录重入的状态的,比如当前没有人持有这把锁,那么state=0,假如有人持有这把锁,那么state=1,如果持有这把锁的人再次持有这把锁,那么state就会+1 ,如果是对于synchronized而言,他在c语言代码中会有一个count,原理和state类似,也是重入一次就加一,释放一次就-1 ,直到减少成0 时,表示当前这把锁没有被人持有。

在redission中,我们的也支持支持可重入锁

在分布式锁中,他采用hash结构用来存储锁,其中大key表示表示这把锁是否存在,用小key表示当前这把锁被哪个线程持有,所以接下来我们一起分析一下当前的这个lua表达式

这个地方一共有3个参数

KEYS[1] : 锁名称

ARGV[1]: 锁失效时间

ARGV[2]: id + ":" + threadId; 锁的小key (hash结构的vaule)

exists: 判断数据是否存在 name:是lock是否存在,如果==0,就表示当前这把锁不存在

redis.call('hset', KEYS[1], ARGV[2], 1);此时他就开始往redis里边去写数据 ,写成一个hash结构

Lock{

id + ":" + threadId : 1

}

如果当前这把锁存在,则第一个条件不满足,再判断

redis.call('hexists', KEYS[1], ARGV[2]) == 1

此时需要通过大key+小key判断当前这把锁是否是属于自己的,如果是自己的,则进行

redis.call('hincrby', KEYS[1], ARGV[2], 1)

将当前这个锁的value进行+1 ,redis.call('pexpire', KEYS[1], ARGV[1]); 然后再对其设置过期时间,如果以上两个条件都不满足,则表示当前这把锁抢锁失败,最后返回pttl,即为当前这把锁的失效时间

如果小伙帮们看了前边的源码, 你会发现他会去判断当前这个方法的返回值是否为null,如果是null,则对应则前两个if对应的条件,退出抢锁逻辑,如果返回的不是null,即走了第三个分支,在源码处会进行while(true)的自旋抢锁。

"if (redis.call('exists', KEYS[1]) == 0) then " +

"redis.call('hset', KEYS[1], ARGV[2], 1); " +

"redis.call('pexpire', KEYS[1], ARGV[1]); " +

"return nil; " +

"end; " +

"if (redis.call('hexists', KEYS[1], ARGV[2]) == 1) then " +

"redis.call('hincrby', KEYS[1], ARGV[2], 1); " +

"redis.call('pexpire', KEYS[1], ARGV[1]); " +

"return nil; " +

"end; " +

"return redis.call('pttl', KEYS[1]);"

//获取锁失败返回剩余有效期,单位为毫秒

3. 分布式锁-redission锁重试和WatchDog机制

说明:由于课程中已经说明了有关tryLock的源码解析以及其看门狗原理,所以笔者在这里给大家分析lock()方法的源码解析,希望大家在学习过程中,能够掌握更多的知识

抢锁过程中,获得当前线程,通过tryAcquire进行抢锁,该抢锁逻辑和之前逻辑相同

1、先判断当前这把锁是否存在,如果不存在,插入一把锁,返回null

2、判断当前这把锁是否是属于当前线程,如果是,则返回null

所以如果返回是null,则代表着当前这哥们已经抢锁完毕,或者可重入完毕,但是如果以上两个条件都不满足,则进入到第三个条件,返回的是锁的失效时间,同学们可以自行往下翻一点点,你能发现有个while( true) 再次进行tryAcquire进行抢锁

long threadId = Thread.currentThread().getId();

Long ttl = tryAcquire(-1, leaseTime, unit, threadId);

// lock acquired

if (ttl == null) {

return;

}接下来会有一个条件分支,因为lock方法有重载方法,一个是带参数,一个是不带参数,如果带带参数传入的值是-1,如果传入参数,则easeTime是他本身,所以如果传入了参数,此时leaseTime != -1 则会进去抢锁,抢锁的逻辑就是之前说的那三个逻辑

if (leaseTime != -1) {

return tryLockInnerAsync(waitTime, leaseTime, unit, threadId, RedisCommands.EVAL_LONG);

}如果是没有传入时间,则此时也会进行抢锁, 而且抢锁时间是默认看门狗时间 commandExecutor.getConnectionManager().getCfg().getLockWatchdogTimeout()

ttlRemainingFuture.onComplete((ttlRemaining, e) 这句话相当于对以上抢锁进行了监听,也就是说当上边抢锁完毕后,此方法会被调用,具体调用的逻辑就是去后台开启一个线程,进行续约逻辑,也就是看门狗线程

RFuture<Long> ttlRemainingFuture = tryLockInnerAsync(waitTime,

commandExecutor.getConnectionManager().getCfg().getLockWatchdogTimeout(),

TimeUnit.MILLISECONDS, threadId, RedisCommands.EVAL_LONG);

ttlRemainingFuture.onComplete((ttlRemaining, e) -> {

if (e != null) {

return;

}

// lock acquired

if (ttlRemaining == null) {

scheduleExpirationRenewal(threadId);

}

});

return ttlRemainingFuture;此逻辑就是续约逻辑,注意看commandExecutor.getConnectionManager().newTimeout() 此方法

Method( new TimerTask() {},参数2 ,参数3 )

指的是:通过参数2,参数3 去描述什么时候去做参数1的事情,现在的情况是:10s之后去做参数一的事情

因为锁的失效时间是30s,当10s之后,此时这个timeTask 就触发了,他就去进行续约,把当前这把锁续约成30s,如果操作成功,那么此时就会递归调用自己,再重新设置一个timeTask(),于是再过10s后又再设置一个timerTask,完成不停的续约

那么大家可以想一想,假设我们的线程出现了宕机他还会续约吗?当然不会,因为没有人再去调用renewExpiration这个方法,所以等到时间之后自然就释放了。

private void renewExpiration() {

ExpirationEntry ee = EXPIRATION_RENEWAL_MAP.get(getEntryName());

if (ee == null) {

return;

}

Timeout task = commandExecutor.getConnectionManager().newTimeout(new TimerTask() {

@Override

public void run(Timeout timeout) throws Exception {

ExpirationEntry ent = EXPIRATION_RENEWAL_MAP.get(getEntryName());

if (ent == null) {

return;

}

Long threadId = ent.getFirstThreadId();

if (threadId == null) {

return;

}

RFuture<Boolean> future = renewExpirationAsync(threadId);

future.onComplete((res, e) -> {

if (e != null) {

log.error("Can't update lock " + getName() + " expiration", e);

return;

}

if (res) {

// reschedule itself

renewExpiration();

}

});

}

}, internalLockLeaseTime / 3, TimeUnit.MILLISECONDS);

ee.setTimeout(task);

}4. 分布式锁-redission锁的MutiLock原理

为了提高redis的可用性,我们会搭建集群或者主从,现在以主从为例

此时我们去写命令,写在主机上, 主机会将数据同步给从机,但是假设在主机还没有来得及把数据写入到从机去的时候,此时主机宕机,哨兵会发现主机宕机,并且选举一个slave变成master,而此时新的master中实际上并没有锁信息,此时锁信息就已经丢掉了。

为了解决这个问题,redission提出来了MutiLock锁,使用这把锁咱们就不使用主从了,每个节点的地位都是一样的, 这把锁加锁的逻辑需要写入到每一个主丛节点上,只有所有的服务器都写入成功,此时才是加锁成功,假设现在某个节点挂了,那么他去获得锁的时候,只要有一个节点拿不到,都不能算是加锁成功,就保证了加锁的可靠性。

那么MutiLock 加锁原理是什么呢?笔者画了一幅图来说明

当我们去设置了多个锁时,redission会将多个锁添加到一个集合中,然后用while循环去不停去尝试拿锁,但是会有一个总共的加锁时间,这个时间是用需要加锁的个数 * 1500ms ,假设有3个锁,那么时间就是4500ms,假设在这4500ms内,所有的锁都加锁成功, 那么此时才算是加锁成功,如果在4500ms有线程加锁失败,则会再次去进行重试.

五、异步秒杀优化

当用户发起请求,此时会请求nginx,nginx会访问到tomcat,而tomcat中的程序,会进行串行操作,分成如下几个步骤

1、查询优惠卷

2、判断秒杀库存是否足够

3、查询订单

4、校验是否是一人一单

5、扣减库存

6、创建订单

在这六步操作中,又有很多操作是要去操作数据库的(数据库操作比较缓慢),而且还是一个线程串行执行, 这样就会导致我们的程序执行的很慢,所以我们需要异步程序执行,那么如何加速呢?

在这里笔者想给大家分享一下课程内没有的思路,看看有没有小伙伴这么想,比如,我们可以不可以使用异步编排来做,或者说我开启N多线程,N多个线程,一个线程执行查询优惠卷,一个执行判断扣减库存,一个去创建订单等等,然后再统一做返回,这种做法和课程中有哪种好呢?答案是课程中的好,因为如果你采用我刚说的方式,如果访问的人很多,那么线程池中的线程可能一下子就被消耗完了,而且你使用上述方案,最大的特点在于,你觉得时效性会非常重要,但是你想想是吗?(并不是,比如我只要确定他能做这件事,然后我后边慢慢做就可以了,我并不需要他一口气做完这件事),所以我们应当采用的是课程中,类似消息队列的方式来完成我们的需求,而不是使用线程池或者是异步编排的方式来完成这个需求。

综上,我们直接来引入redisStream消息队列

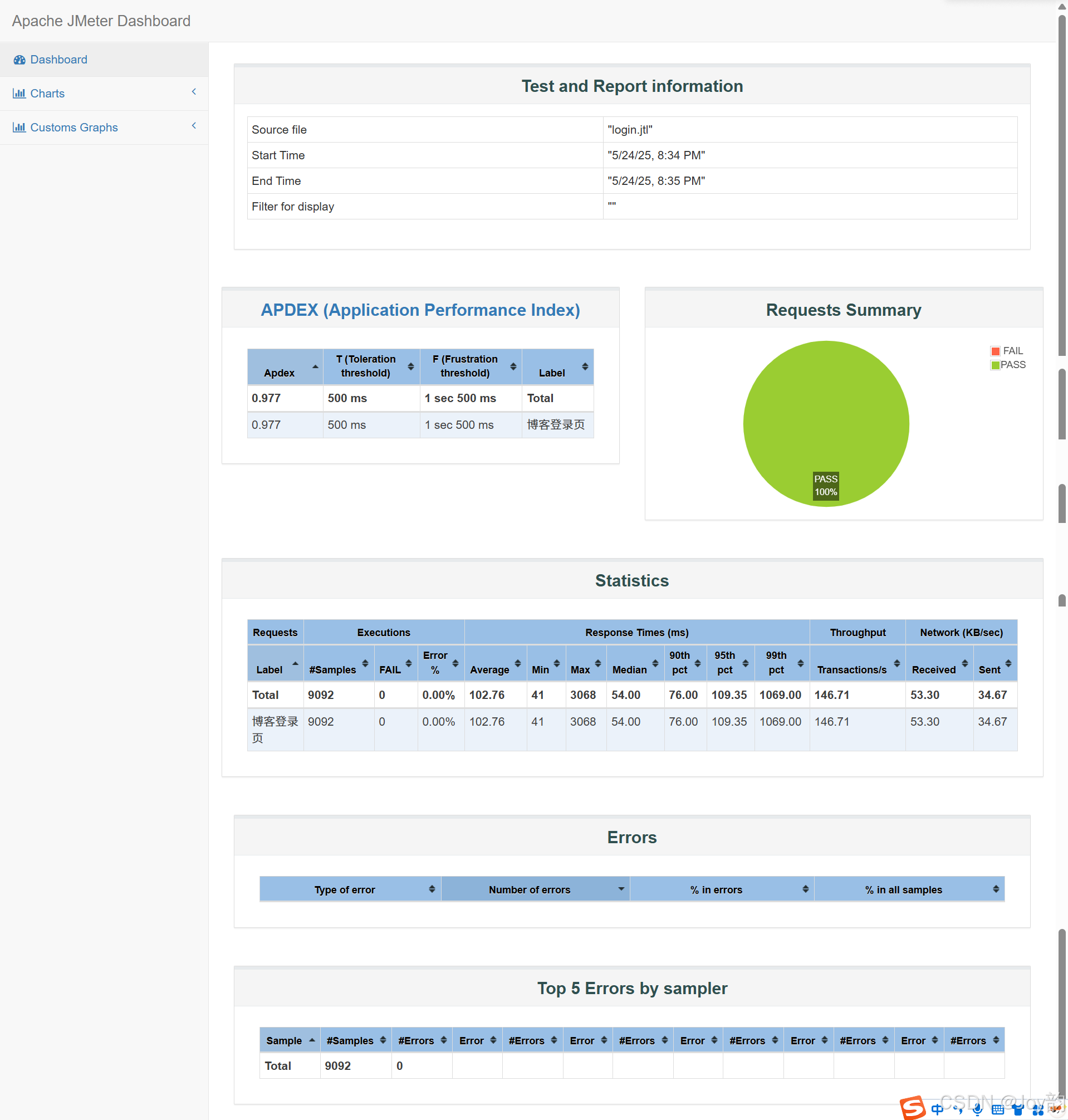

Redis消息队列-基于Stream的消息队列-消费者组

消费者组(Consumer Group):将多个消费者划分到一个组中,监听同一个队列。具备下列特点:

创建消费者组:

![]()

key:队列名称

groupName:消费者组名称

ID:起始ID标示,$代表队列中最后一个消息,0则代表队列中第一个消息

MKSTREAM:队列不存在时自动创建队列

其它常见命令:

删除指定的消费者组

XGROUP DESTORY key groupNam e给指定的消费者组添加消费者(

XGROUP CREATECONSUMER key groupname consumername删除消费者组中的指定消费者

XGROUP DELCONSUMER key groupname consumername从消费者组读取消息:

XREADGROUP GROUP group consumer [COUNT count] [BLOCK milliseconds] [NOACK] STREAMS key [key ...] ID

[ID ...]- group:消费组名称

- consumer:消费者名称,如果消费者不存在,会自动创建一个消费者

- count:本次查询的最大数量

- BLOCK milliseconds:当没有消息时最长等待时间

- NOACK:无需手动ACK,获取到消息后自动确认(给了NOACK代表不用消费者确认,消息投递给消费者会自动确认)

- STREAMS key:指定队列名称

- ID:获取消息的起始ID:

">":从下一个未消费的消息开始,确保所有消息都会被消费

其它:根据指定id从pending-list中获取已消费但未确认的消息,(例如0,是从pending-list中的第一个消息开始)

结尾跟0,代表读取pending-list 中的第一条消息

XPENDING key group [空闲时间] start(最大-) end(最小+) cout

命令格式:

XPENDING key group [start end count] [consumer]其中:

key:流的键名(stream 的 key)group:消费者组名(consumer group)[start end count]:可选参数,用于限制返回的 pending 条目范围:

-

start:最小的消息 ID(可以用-表示最小)end:最大的消息 ID(可以用+表示最大)count:返回的最大条数

[consumer]:可选参数,只查询指定消费者名的 pending 条目

正确使用示例:

XPENDING mystream mygroup - + 10含义:

- 在流

mystream中, - 查看消费者组

mygroup的 pending 消息, - 消息 ID 范围是从最小 (

-) 到最大 (+), - 最多返回 10 条消息的详细信息。

返回内容类似:

bash复制编辑1) 1) "1686748123145-0" # 消息ID

2) "consumer-1" # 消费者名称

3) (integer) 2000 # 空闲时间(毫秒)

4) (integer) 3 # 被传递的次数

2) ...STREAM类型消息队列的XREADGROUP命令特点:

- 消息可回溯

- 可以多消费者争抢消息,加快消费速度

- 可以阻塞读取

- 没有消息漏读的风险

- 有消息确认机制,保证消息至少被消费一次

需求:

- 创建一个Stream类型的消息队列,名为stream.orders

- 修改之前的秒杀下单Lua脚本,在认定有抢购资格后,直接向stream.orders中添加消息,内容包含voucherId、userId、orderId

- 项目启动时,开启一个线程任务,尝试获取stream.orders中的消息,完成下单

修改lua表达式,新增

VoucherOrderServiceImpl

private class VoucherOrderHandler implements Runnable {

@Override

public void run() {

while (true) {

try {

// 1.获取消息队列中的订单信息 XREADGROUP GROUP g1 c1 COUNT 1 BLOCK 2000 STREAMS s1 >

List<MapRecord<String, Object, Object>> list = stringRedisTemplate.opsForStream().read(

Consumer.from("g1", "c1"),

StreamReadOptions.empty().count(1).block(Duration.ofSeconds(2)),

StreamOffset.create("stream.orders", ReadOffset.lastConsumed())

);

// 2.判断订单信息是否为空

if (list == null || list.isEmpty()) {

// 如果为null,说明没有消息,继续下一次循环

continue;

}

// 解析数据

MapRecord<String, Object, Object> record = list.get(0);

Map<Object, Object> value = record.getValue();

VoucherOrder voucherOrder = BeanUtil.fillBeanWithMap(value, new VoucherOrder(), true);

// 3.创建订单

createVoucherOrder(voucherOrder);

// 4.确认消息 XACK

stringRedisTemplate.opsForStream().acknowledge("s1", "g1", record.getId());

} catch (Exception e) {

log.error("处理订单异常", e);

//处理异常消息

handlePendingList();

}

}

}

private void handlePendingList() {

while (true) {

try {

// 1.获取pending-list中的订单信息 XREADGROUP GROUP g1 c1 COUNT 1 BLOCK 2000 STREAMS s1 0

List<MapRecord<String, Object, Object>> list = stringRedisTemplate.opsForStream().read(

Consumer.from("g1", "c1"),

StreamReadOptions.empty().count(1),

StreamOffset.create("stream.orders", ReadOffset.from("0"))

);

// 2.判断订单信息是否为空

if (list == null || list.isEmpty()) {

// 如果为null,说明没有异常消息,结束循环

break;

}

// 解析数据

MapRecord<String, Object, Object> record = list.get(0);

Map<Object, Object> value = record.getValue();

VoucherOrder voucherOrder = BeanUtil.fillBeanWithMap(value, new VoucherOrder(), true);

// 3.创建订单

createVoucherOrder(voucherOrder);

// 4.确认消息 XACK

stringRedisTemplate.opsForStream().acknowledge("s1", "g1", record.getId());

} catch (Exception e) {

log.error("处理pendding订单异常", e);

try{

Thread.sleep(20);

}catch(Exception e){

e.printStackTrace();

}

}

}

}

}