一、平台简介

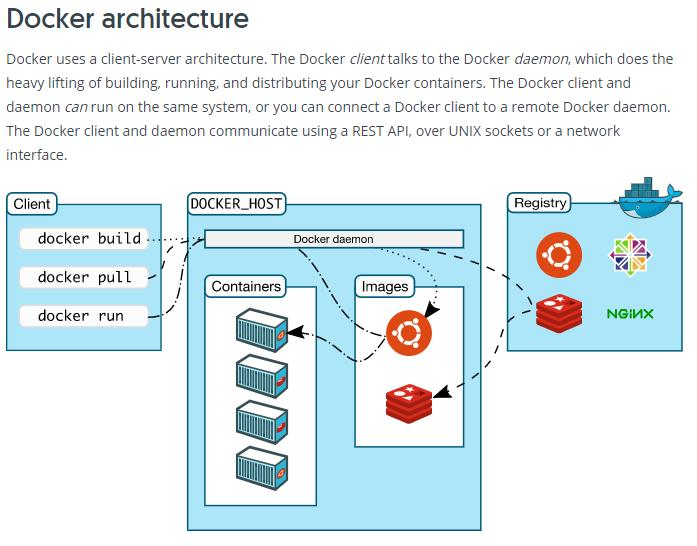

GPUGEEK 是一个专注于提供 GPU 算力租赁服务的平台,在人工智能与深度学习领域为用户搭建起便捷的算力桥梁。它整合了丰富多样的 GPU 资源,涵盖 RTX - 4090、RTX - 3090、A100 - PCIE 等多种型号,满足不同用户在模型训练、数据处理、图像渲染等场景下的算力需求。同时,该平台还设有镜像市场、模型市场等功能板块,为用户提供一站式的 AI 开发与运算支持。

二、选择 GPUGEEK 平台的理由

(一)丰富的算力资源

平台提供了种类繁多的 GPU 类型,从消费级的 RTX 系列到专业级的 A 系列,显存从 24GB 到 48GB 不等,用户可以根据自身项目的规模与复杂度灵活选择

(二)灵活的计费模式

GPUGEEK 支持按流量计费、包天、包月等多种计费方式。按流量计费适用于短期且任务量波动较大的项目,用户只需为实际使用的算力资源付费,避免了资源闲置造成的浪费;包天、包月模式则对于长期稳定运行的项目更为友好,能以相对优惠的价格锁定算力,降低整体使用成本。这种多样化的计费选择,充分考虑了不同用户的使用习惯和预算安排。

(三)优质的生态支持

镜像市场汇聚了众多开发者分享的实用镜像,涵盖了常见的深度学习框架和开发环境,如 PyTorch、TensorFlow 等,方便用户快速部署项目。

模型市场则提供了各类热门的预训练模型,像 Qwen - 3、GLM - 4 等大语言模型,以及用于图像、视频、音频处理的相关模型,为用户的研究和开发提供了丰富的资源储备。

使用GPUGEEK进行深度学习

进入到容器实例的页面,点击创建实例

进入到页面我们可以看到他这里的计费模式是按量付费,用多少扣多少,显卡的话我们就3090就行了

新人的话是有20元的算力券的,可以点击链接进行注册操作获取新人算力券

镜像的版本我们设置为DeepSeekR1就行

直接点击右下角的创建实例就行了,然后我们稍等一会儿就创建好了

创建过程中不会计费。实例创建完成后,手动关机可不计费

等机器创建好了之后我们点击这个登录操作

然后他会弹出相关的账号密码啥的,供你远程登录操作服务器

复制你自己的登录指令和登录密码然后直接点击确认

点击Tensorboard JupyterLab

我们这里进入到新页面,这里默认是登录好了的,我们就不需要使用账号密码登录了,直接使用这个服务器

我们来到模型广场,找到这个DeepSeek V3模型,点击进去

查看相关的API信息,可以看到这里提供了四种调用方式Node.js、Python、HTTP、OpenAI

我们先进行API-KEYS的获取,点击API-KEYS进入到页面,点击复制我们的专属API-KEYS

我们发现他这里并没有提供实际的调用代码,所以我们就得自己本地进行代码的书写了

我这利生成了一份代码,你可以参考下

import requests

import json

# API 配置

API_KEY = "API_Token" #替换为自己的 API_Token

url = "https://api.gpugeek.com/predictions"

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json",

"Stream": "true"

}

# 初始化对话

conversation_history = []

user_input = input("请输入初始问题:")

conversation_history.append(f"用户: {user_input}")

while True:

# 构建提示

prompt = "\n".join(conversation_history) + "\n助手:"

# 发送请求

data = {

"model": "GpuGeek/Qwen3-32B", # 替换为自己的模型名称

"input": {

"frequency_penalty": 0,

"max_tokens": 8192,

"prompt": prompt,

"temperature": 0.6,

"top_k": 50, # 官方示例中包含此参数

"top_p": 0.7

}

}

try:

# 发送请求并使用流式处理

response = requests.post(url, headers=headers, json=data, stream=True)

# 检查响应状态码

if response.status_code != 200:

print(f"请求失败,状态码: {response.status_code}")

print(f"错误内容: {response.text}")

break

# 处理流式响应(按官方示例)

full_reply = ""

for line in response.iter_lines():

if line:

try:

# 解码并解析JSON

json_line = line.decode("utf-8")

result = json.loads(json_line)

# 提取回复内容

if "output" in result:

output = result["output"]

if isinstance(output, list):

full_reply += "".join(output)

elif isinstance(output, str):

full_reply += output

except json.JSONDecodeError as e:

print(f"解析JSON行时出错: {e}")

print(f"行内容: {json_line}")

# 打印完整回复

if full_reply:

print(f"助手: {full_reply}")

conversation_history.append(f"助手: {full_reply}")

else:

print("助手未返回有效回复")

except requests.exceptions.RequestException as e:

print(f"请求异常: {e}")

break

# 询问用户是否继续

next_input = input("是否继续对话?(输入内容继续,输入 'q' 退出): ")

if next_input.lower() == 'q':

break

conversation_history.append(f"用户: {next_input}")

这里我们就成功的进行调用了

可以看的出来效果还是很不错的

并且这里还有CPU的相关监控,可以看见性能是非常的强悍啊

总结

经过一段时间对 GPUGEEK 平台的使用,其给我留下了深刻且良好的印象。在算力方面,充足且多样化的 GPU 资源确保了我不同类型项目的顺利推进,无论是小型的算法验证实验,还是大型的复杂模型训练,都能找到合适的硬件配置。他们的计费模式是按量付费,这个很人性化,在当前大多数的算力平台都不能达到按量付费这个要求,都是捆绑付费,GPUGEEK在这一点做的很好

当然,平台也并非十全十美。在使用过程中,偶尔会遇到资源紧张时排队等待的情况,希望未来平台能够进一步扩充资源池,优化资源调度策略,提升用户体验。总体而言,GPUGEEK 是一个功能强大、使用便捷、生态丰富的 GPU 算力租赁平台,对于人工智能领域的开发者和研究人员来说,是一个不可多得的得力助手,能够有效助力项目的开发与落地。

如果你们也想体验下GPUGEEK里面的各种优秀的资源,你们可以点击链接进行注册操作