针对深度学习入门新手目标不明确 知识体系杂乱的问题 拟开启快速入门深度学习系列文章的创作

旨在帮助大家快速的入门深度学习

写在前面:

本系列按照吴恩达系列课程顺序发布(说明一下为什么不直接看原笔记 因为内容太多 没有大量时间去阅读 所有作者需要一次梳理清楚 并整理思路 方便后续学习

对于入门的建议就是 在看文章的时候 如果有不懂的概念及时的搜索一下

本人学识有限 以上内容均根据本人理解 如有不对的地方大家多多指正 欢迎交流

本系列吴恩达深度学习入门系列作为起点 可能会穿插代码或者公式的推导

本系列也是对本人自2月25日以来学习深度学习内容的梳理与总结

希望我们都可以亲手杀死曾经那个颓废的自己!

---------------------------------------------------------------------------------------------------------------------------------

逻辑回归用于二分类任务 本文也以这个例子进行说明

如图 这是一个二分类任务 1代表猫 0代表狗

在计算机中 图像的表示形式如下图所示 这里有三个通道 红绿蓝 这里只是化了5*4个格子 代表像素 实际上 像素可以是64*64 或者更大

以64*64像素为例 在输入之前 我们要把这些像素用特征向量来表示 对于本例 像素的大小就是64*64*3

这里的维度 大家一定搞清楚 很重要 不理解的看下面的图

解释一下这张图 首先y预测就是对y的估计 表示了y=1是一只猫的可能性 我们需要用w x b表示y预测 但是这样是不行的 因为我们输出的是概率 在0-1之间 所以要套上一层sigmoid激活函数

对于激活函数的定义 和曲线已经画出 顺便说一下 训练的过程就是不断学习w b的过程 以更好的预测y

损失函数

我们定义一个损失函数 通过让损失函数更趋近于0来更新w b 来更加靠近真实的y

本例损失函数如下图 已经解释的很清楚了

代价函数

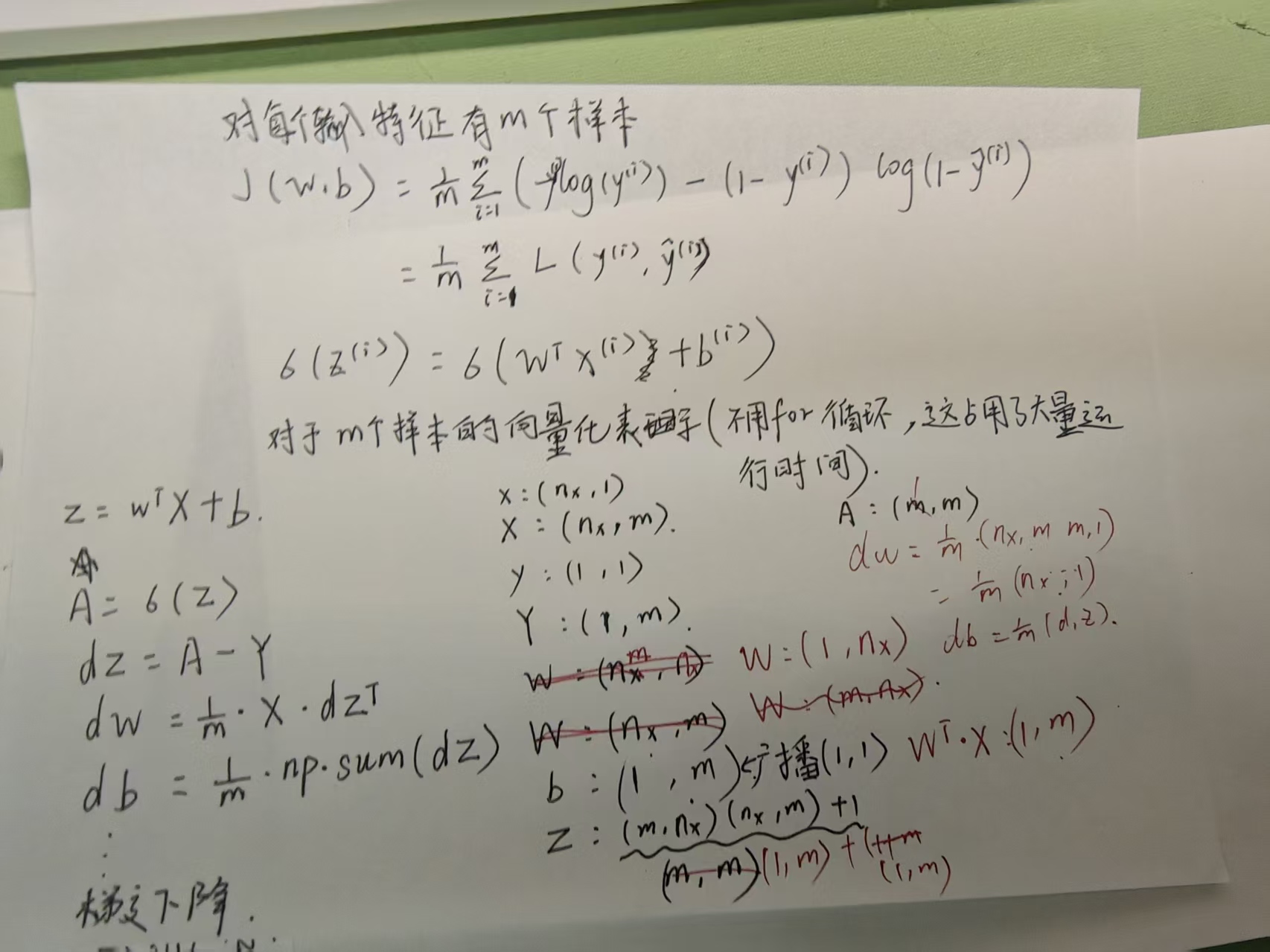

注意在表示第i个样本时 括号在上面

梯度下降法

可以看出 梯度下降就是在不断寻找J最小的点 并以此确定w b

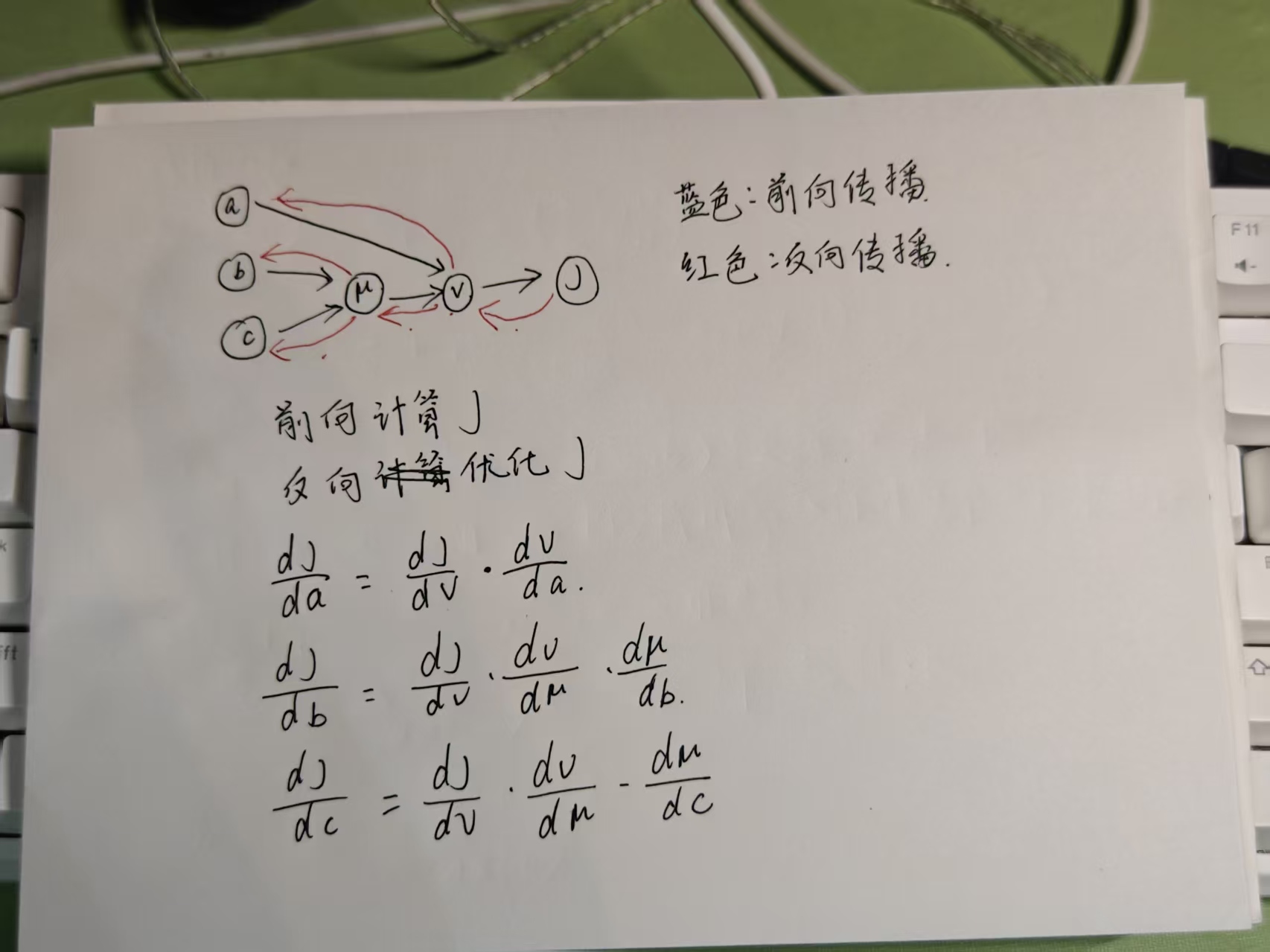

计算图

逻辑回归中的梯度下降

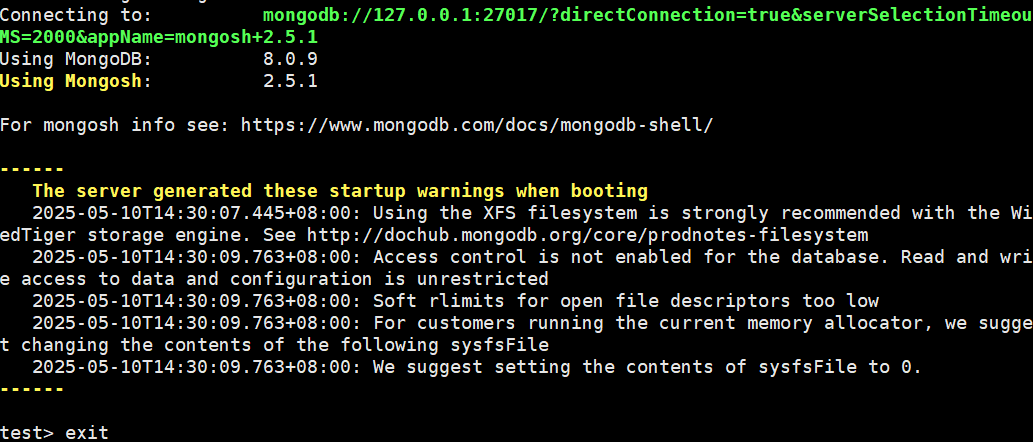

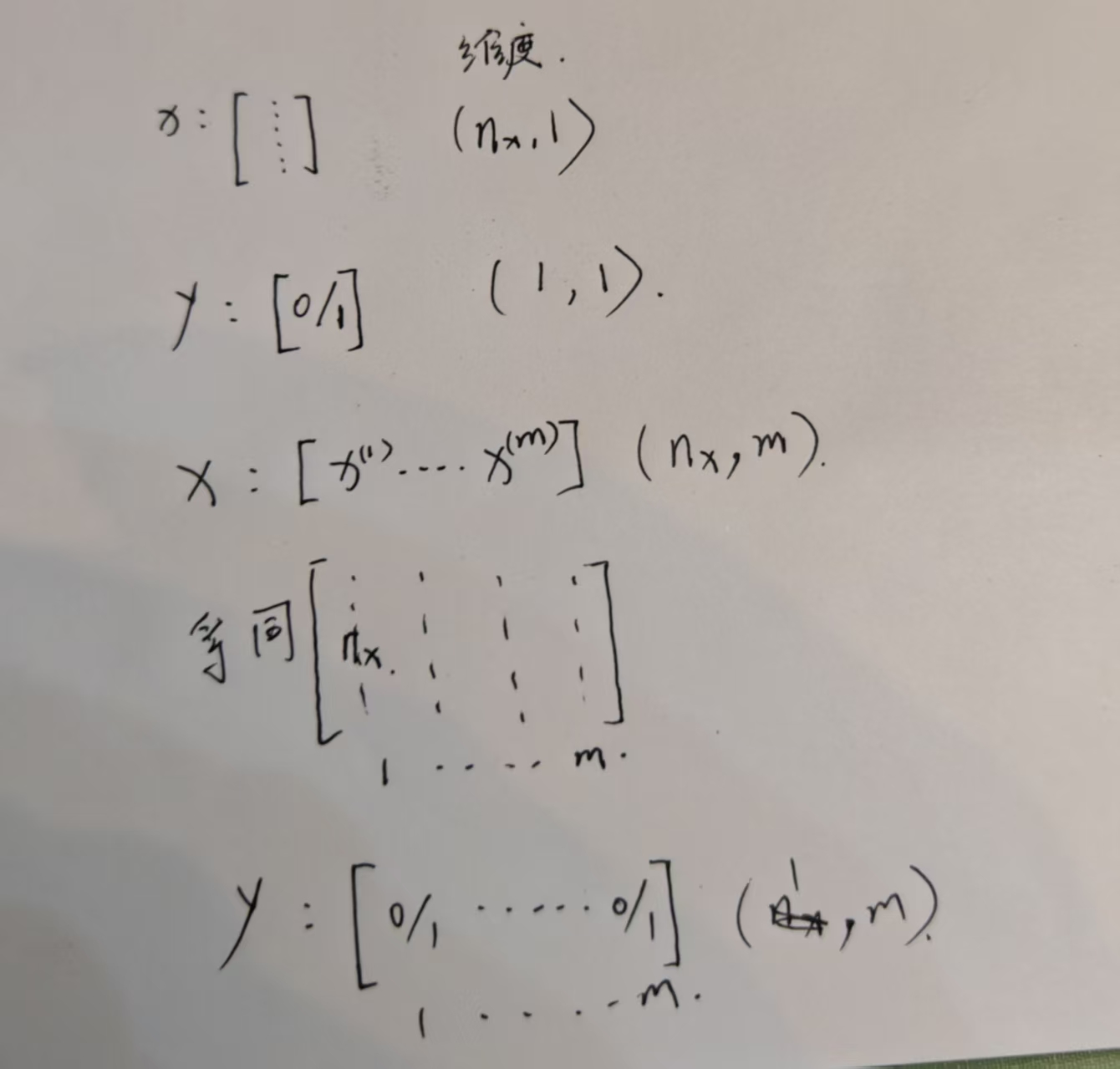

对于M个样本的逻辑回归

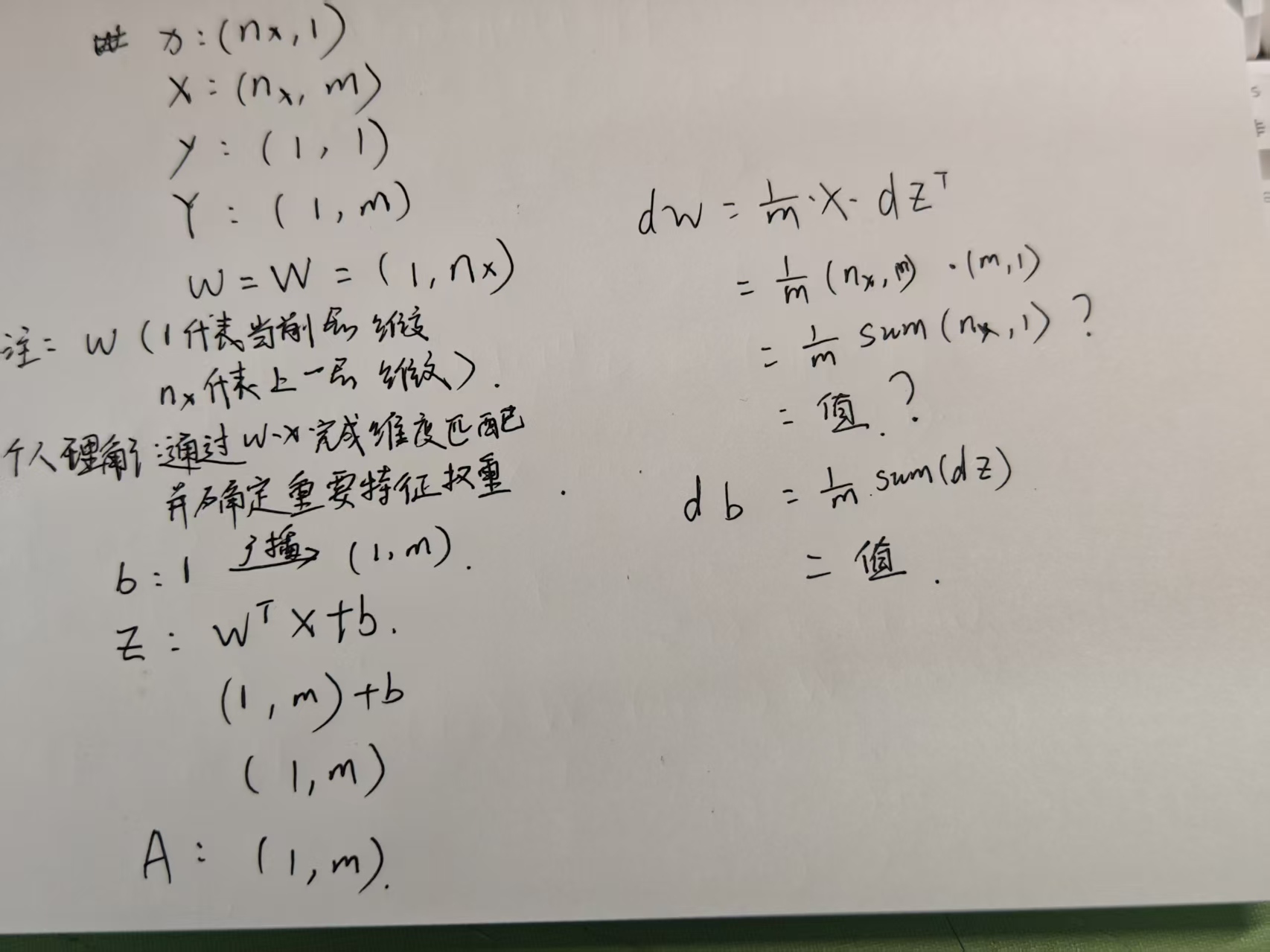

下面写的有点乱 维度可以看这张 对于W的维度 还是有一些不确定 希望大佬指正

![[超详细,推荐!!!]前端性能优化策略详解](https://i-blog.csdnimg.cn/direct/71bcdabdc46f439ea28a1801e5040cfb.png)