激活函数总结(三十):激活函数补充

- 1 引言

- 2 激活函数

- 2.1 Logit激活函数

- 2.2 Softsign激活函数

- 3. 总结

1 引言

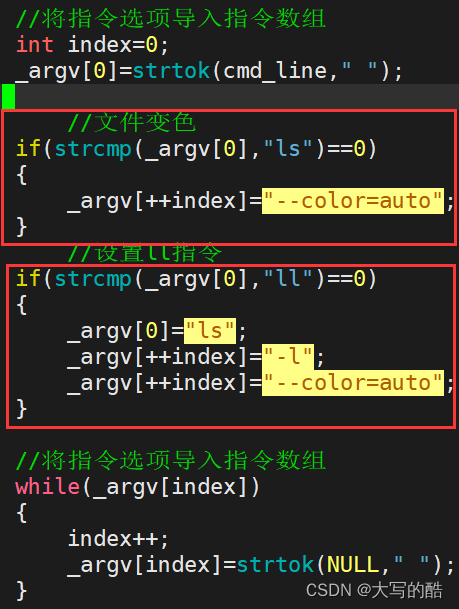

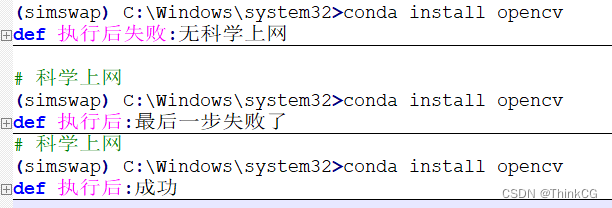

在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、ReLU、Leaky ReLU、PReLU、Swish、ELU、SELU、GELU、Softmax、Softplus、Mish、Maxout、HardSigmoid、HardTanh、Hardswish、HardShrink、SoftShrink、TanhShrink、RReLU、CELU、ReLU6、GLU、SwiGLU、GTU、Bilinear、ReGLU、GEGLU、Softmin、Softmax2d、Logsoftmax、Identity、LogSigmoid、Bent Identity、Absolute、Bipolar、Bipolar Sigmoid、Sinusoid、Cosine、Arcsinh、Arccosh、Arctanh、LeCun Tanh、TanhExp、Gaussian 、GCU、ASU、SQU、NCU、DSU、SSU、SReLU、BReLU、PELU、Phish、RBF、SQ-RBF、ISRU、ISRLU、SQNL、PLU、APL、Inverse Cubic、Soft Exponential、ParametricLinear、Piecewise Linear Unit、CLL、SquaredReLU、ModReLU、CosReLU、SinReLU、Probit、Smish、Multiquadratic、InvMultiquadratic、PSmish、ESwish、CoLU、ShiftedSoftPlus)。在这篇文章中,会接着上文提到的众多激活函数继续进行介绍,给大家带来更多不常见的激活函数的介绍。这里放一张激活函数的机理图:

2 激活函数

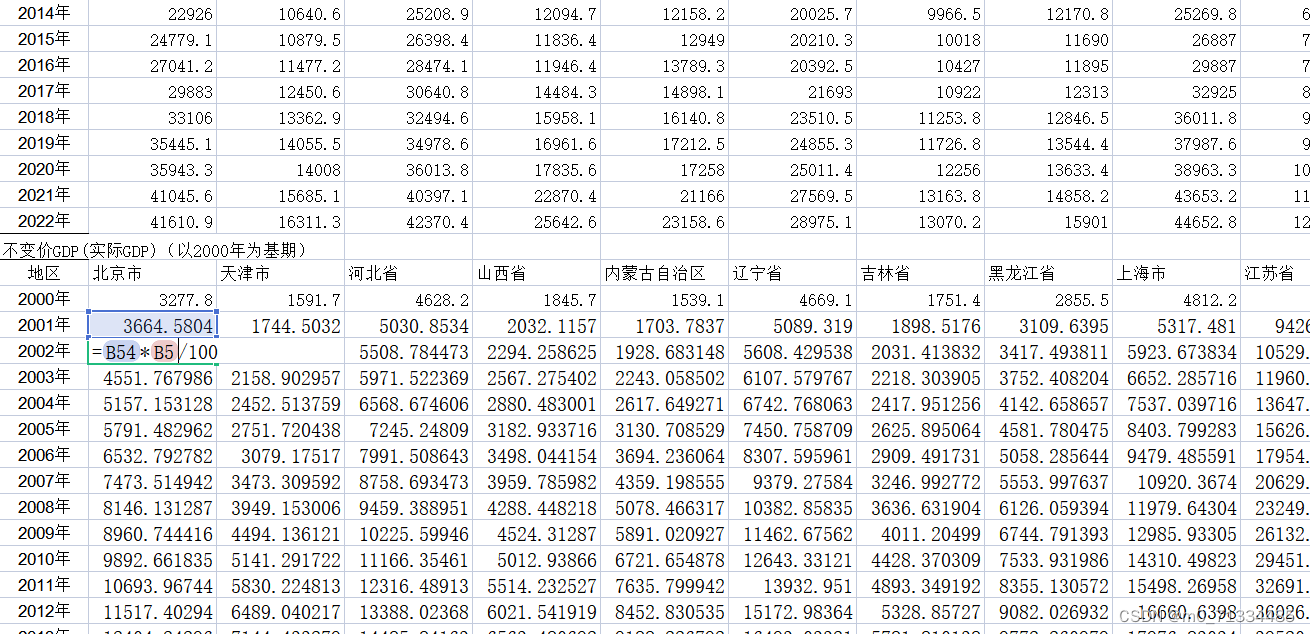

2.1 Logit激活函数

Logit 函数在输入值 x 介于 −∞和 1之间时是定义良好的。然而,需要注意的是,当 x=1 时,分母为零,这会导致函数无法计算。因此,这个激活函数在应用中需要小心处理,确保避免将输入设置为 1。其数学表达式和数学图像分别如下所示:

f

(

x

)

=

x

1

−

x

f(x)=\frac{x}{1-x}

f(x)=1−xx

优点:

-

非线性性质: 这个激活函数是

非线性的,可以帮助神经网络模型捕捉数据中的复杂模式和关系。 -

简单性: 这个函数的数学形式相对

简单,只涉及除法和线性操作。 -

不对称性: 这个函数的

输出值范围是 (−∞,1),因此它在不同于其他常见激活函数(如 Sigmoid 和 Tanh)的范围内产生输出。

缺点:

- 存在无定义区域: 当 x=1 时,

分母为零,函数无法计算。这意味着这个激活函数的应用需要注意避免将输入设置为 1。 - 不对称性: 这个函数的输出范围是 (−∞,1),因此在某些情况下,

不对称的输出范围可能会引入一些问题。 - 导数的问题: 这个函数的导数存在问题,尤其是在接近 x=1 的情况下,导数可能变得

非常大,可能会导致数值不稳定性。

虽然该激活函数比较简单,但是因为其特性很少在当前使用。。。。。

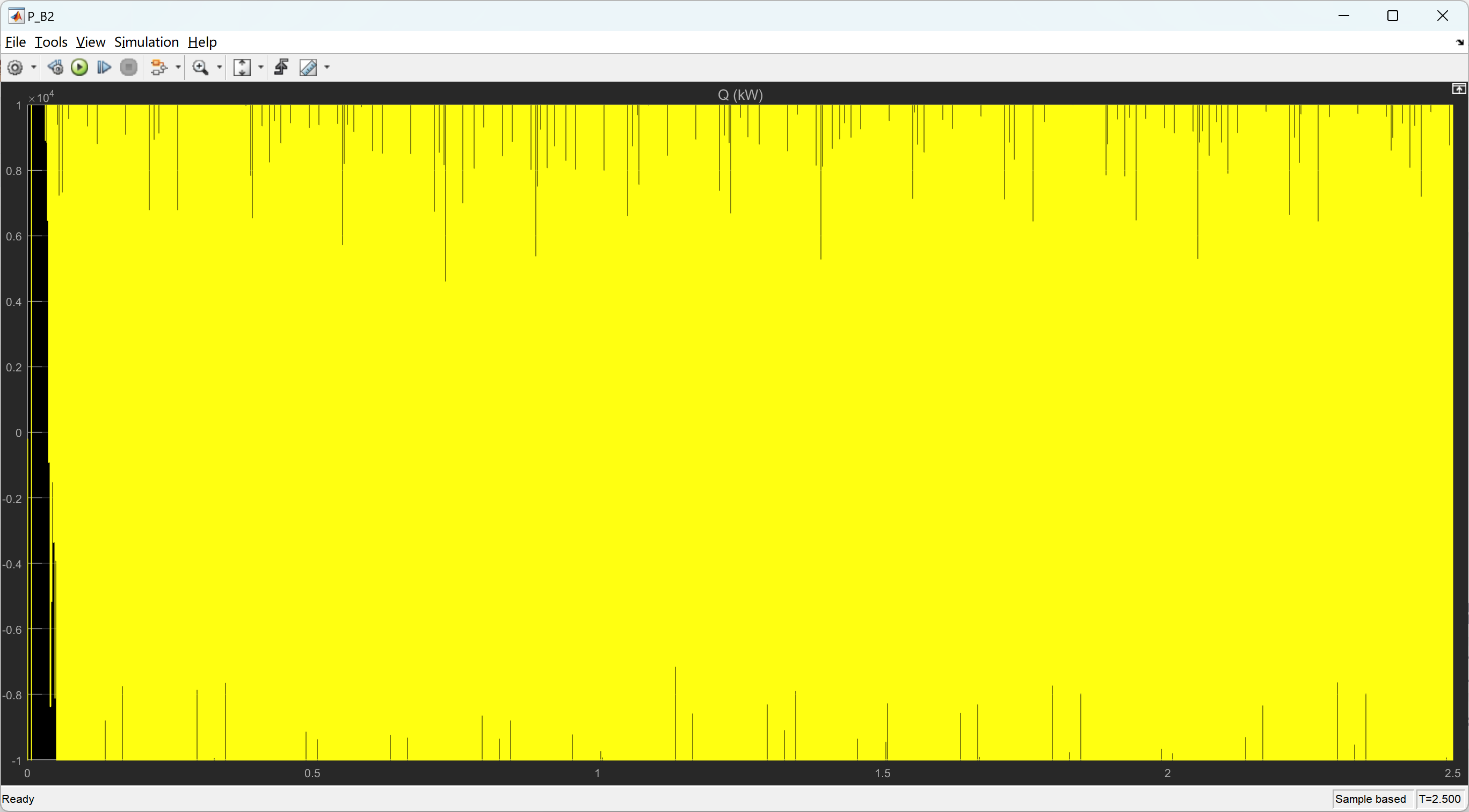

2.2 Softsign激活函数

Softsign 激活函数是一种平滑的非线性函数,类似于双曲正切(tanh)激活函数,但具有在输入接近零时的更大斜率。它将实数映射到 [-1, 1] 范围内,同时保留了输入的符号信息。其数学表达式和数学图像分别如下所示:

f

(

x

)

=

x

1

+

∣

x

∣

f(x)=\frac{x}{1+∣x∣}

f(x)=1+∣x∣x

优点:

- 平滑性: Softsign 激活函数是

平滑的,具有连续可微性,对于优化算法和训练过程有益。 - 非线性特性: 它引入了

非线性,允许神经网络捕获数据中的复杂模式。 - 可导性: Softsign 在除了

零点外都是可导的,这对于梯度下降等优化算法的训练很重要。

缺点:

- 输出范围: Softsign 激活函数将输入映射到

[-1, 1]范围内,可能不适用于所有问题,特别是需要输出范围在 [0, 1] 或其他不同范围的情况。 - 梯度消失问题: 在输入

接近零的时候,Softsign 的斜率变得非常大,这可能导致梯度消失问题,特别是在深层网络中。

虽然该激活函数比较简单,但是因为其特性很少在当前使用。。。。。

3. 总结

到此,使用 激活函数总结(三十) 已经介绍完毕了!!! 如果有什么疑问欢迎在评论区提出,对于共性问题可能会后续添加到文章介绍中。如果存在没有提及的激活函数也可以在评论区提出,后续会对其进行添加!!!!

如果觉得这篇文章对你有用,记得点赞、收藏并分享给你的小伙伴们哦😄。

![[NLP]LLM---FineTune自己的Llama2模型](https://img-blog.csdnimg.cn/a3137a07771c4a2598564de391049b6d.png)