前言

最近一位数仓同学问我,当 Spark 任务出现数据倾斜的问题时该如何处理呢?那么今天就来讲一下遇到了数据倾斜问题时处理的方式方法。

1)数据倾斜的定义

Spark 中的数据倾斜问题主要指 shuffle 过程中出现的数据倾斜问题,是由于不同的 key 对应的数据量不同导致的不同task所处理的数据量不同的问题。

2)数据倾斜的表现

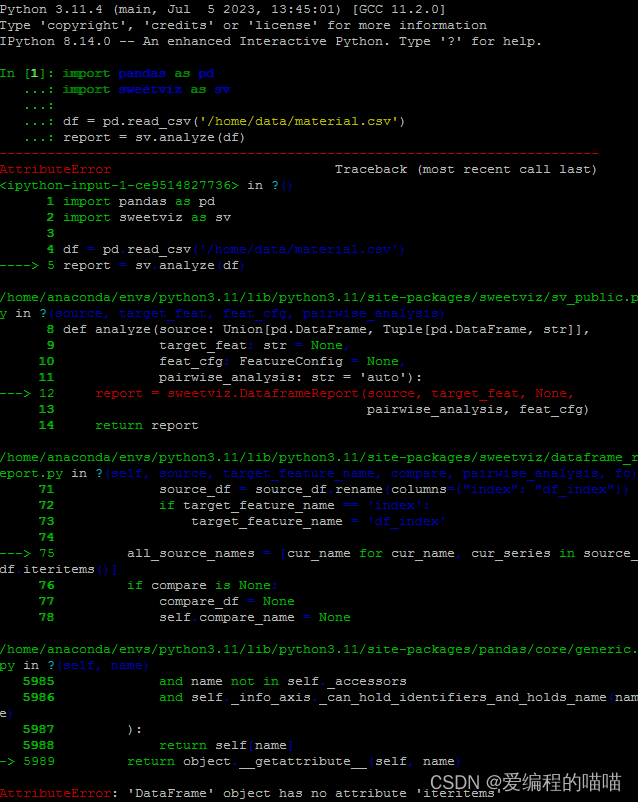

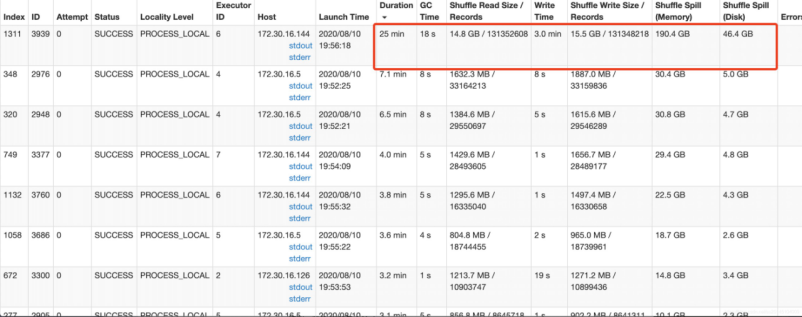

Spark 作业的大部分 task 都执行迅速,一个或几个 task 执行的很慢,此时可能出现了数据倾斜,作业可以运 行,但是运行得非常慢;

Spark 作业的大部分 task 都执行迅速,但是有的 task 在运行过程中会突然报出 OOM,反复执行几次都在某一 个 task 报出 OOM 错误,此时可能出现了数据倾斜,作业无法正常运行。

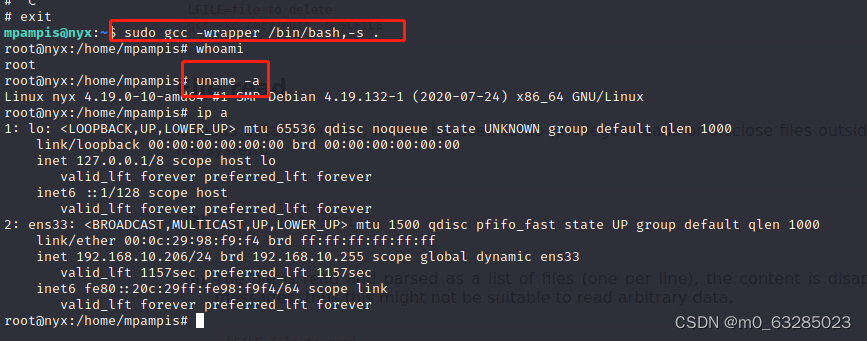

上述截图中其他任务的执行速度和处理数据记录数都差不多,但第一条处理的数据量高达 15GB,近一亿数据记录,发现了数据倾斜。

3)定位数据倾斜问题

步骤一: 看数据倾斜发生在哪个 Stage