上进小菜猪,沈工大软件工程专业,爱好敲代码,持续输出干货。

随着互联网的快速发展和大数据技术的不断成熟,用户推荐系统在各个应用领域变得越来越重要。本文将介绍如何利用大数据技术构建一个实时用户推荐系统。我们将通过结合Apache Kafka、Apache Spark和机器学习算法,实现一个高效、可扩展且准确的推荐系统。同时,本文还将提供具体的代码实例和技术深度解析,帮助读者更好地理解和实践。

- 在当今互联网时代,大量的用户行为数据被生成并积累,如何从海量的数据中挖掘出有价值的信息成为了一个重要的问题。用户推荐系统通过分析用户的历史行为和兴趣,能够为用户提供个性化的推荐,提升用户体验和平台价值。

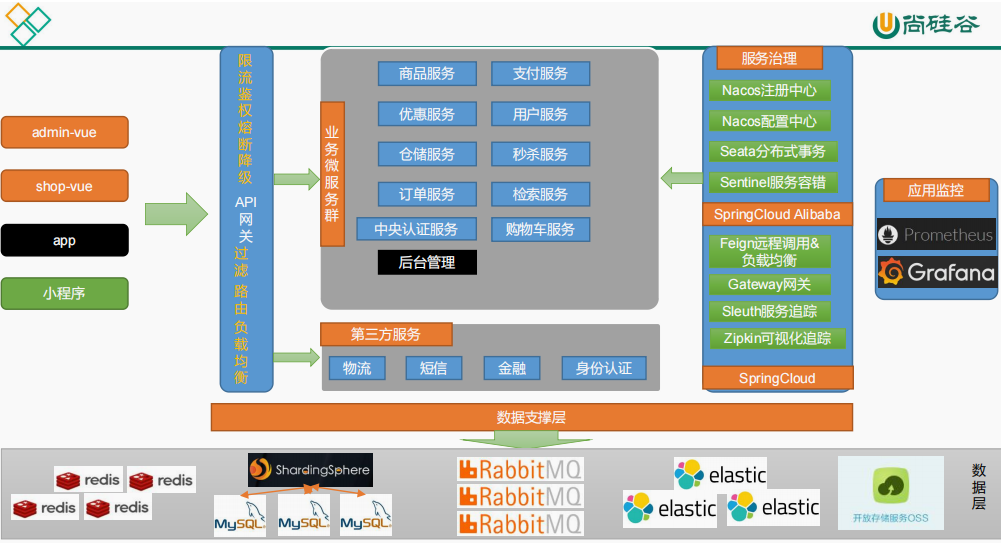

- 架构设计 我们的用户推荐系统将采用以下技术组件:

- Apache Kafka:作为消息队列系统,用于实时处理用户行为数据流。

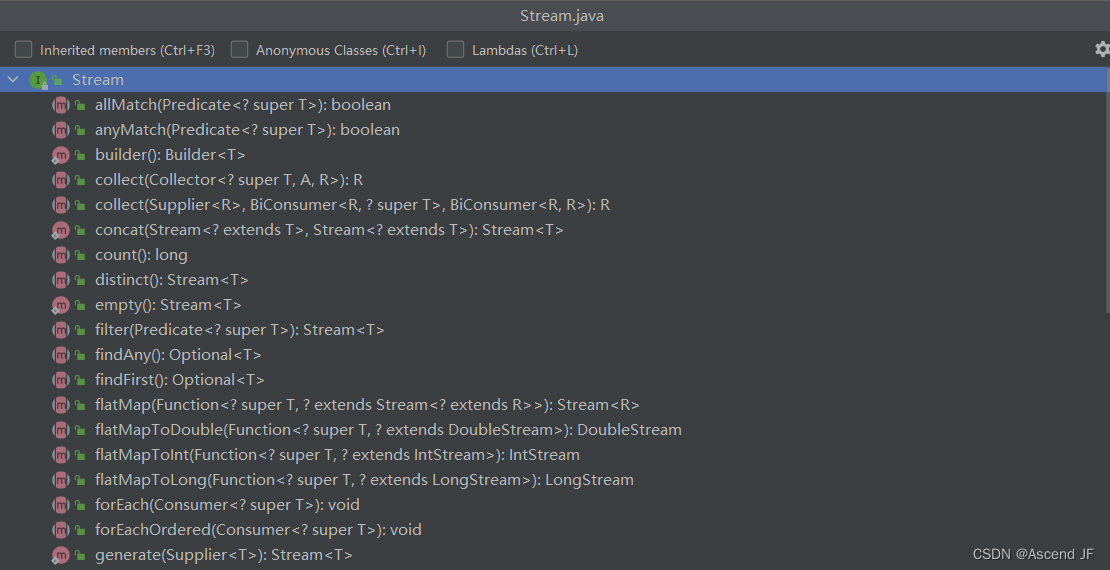

- Apache Spark:用于大规模数据处理和分析,实现推荐算法的计算和模型训练。

- 机器学习算法:使用协同过滤、基于内容的推荐等算法,构建推荐模型。

-

首先,我们需要收集用户行为数据并进行预处理。数据可以包括用户的点击记录、购买记录、评分等信息。通过Apache Kafka构建一个数据流管道,将实时生成的数据发送到数据处理系统。

-

实时推荐计算 Apache Spark Streaming作为流式处理引擎,可以实时接收和处理来自Kafka的数据流。我们可以使用Spark Streaming进行实时数据处理,并将数据转换成适合机器学习算法的格式。例如,将用户行为数据转化为用户-物品矩阵,以便后续进行推荐算法的计算。

-

推荐模型训练 使用Apache Spark的机器学习库,我们可以应用协同过滤、基于内容的推荐等算法,对用户-物品矩阵进行建模和训练。通过训练得到的推荐模型,可以为每个用户生成个性化的推荐列表。

-

实时推荐服务 将训练得到的推荐模型部署为实时推荐服务,提供推荐结果的查询接口。当有新的用户行为数据到达时,实时推荐服务可以快速响应并生成实时推荐结果。

代码实例

下面是一个简化的示例代码,展示了如何使用Apache Kafka和Apache Spark Streaming进行数据处理和实时推荐计算。

from pyspark import SparkContext

from pyspark.streaming import StreamingContext

from pyspark.mllib.recommendation import ALS

# 创建SparkContext和StreamingContext

sc = SparkContext("local[2]", "RealTimeRecommendation")

ssc = StreamingContext(sc, 1)

# 创建Kafka数据流

kafkaStream = KafkaUtils.createStream(ssc, "localhost:2181", "recommendation", {"user_behavior": 1})

# 解析数据流,转换为(user, item, rating)格式

parsedStream = kafkaStream.map(lambda x: x[1].split(',')).map(lambda x: (int(x[0]), int(x[1]), float(x[2])))

# 构建ALS模型

rank = 10

numIterations = 10

model = ALS.train(parsedStream, rank, numIterations)

# 实时推荐计算

userFeatures = model.userFeatures()

itemFeatures = model.productFeatures()

recommendations = userFeatures.map(lambda x: (x[0], model.recommendProducts(x[0], 5)))

# 输出推荐结果

recommendations.pprint()

# 启动流式计算

ssc.start()

ssc.awaitTermination()

技术深度解析

本文的技术深度解析部分,我们将重点介绍以下内容:

- Kafka和Spark Streaming的原理和工作机制。

- ALS算法的原理和实现细节。

- 如何优化推荐系统的性能和扩展性。

- 推荐结果的评估和反馈机制。

将训练得到的异常检测模型部署为实时异常检测服务,提供对新数据进行实时检测的能力。通过结合Apache Kafka和Apache Spark Streaming,我们可以实现对数据流的实时处理和异常检测。

from pyspark import SparkContext

from pyspark.streaming import StreamingContext

from pyspark.mllib.clustering import KMeans

# 创建SparkContext和StreamingContext

sc = SparkContext("local[2]", "RealTimeAnomalyDetection")

ssc = StreamingContext(sc, 1)

# 创建Kafka数据流

kafkaStream = KafkaUtils.createStream(ssc, "localhost:2181", "anomaly_detection", {"sensor_data": 1})

# 解析数据流

parsedStream = kafkaStream.map(lambda x: x[1].split(',')).map(lambda x: [float(val) for val in x])

# 构建KMeans模型

numClusters = 3

numIterations = 10

model = KMeans.train(parsedStream, numClusters, numIterations)

# 实时异常检测

predictions = model.predict(parsedStream)

anomalies = predictions.filter(lambda x: x == 0)

# 输出异常结果

anomalies.pprint()

# 启动流式计算

ssc.start()

ssc.awaitTermination()

- 大数据预处理的方法和技术,如数据清洗、去噪、归一化和特征选择。

- 异常检测算法的原理和实现细节,包括聚类、分类和离群点检测等方法。

- 如何使用大数据技术实现实时异常检测,包括流式数据处理和模型更新。

如何利用大数据分析技术构建一个高效且准确的异常检测系统。通过结合Apache Hadoop和Apache Spark,以及数据预处理、特征工程和机器学习算法,我们可以构建一个可扩展的异常检测系统。读者可以参考本文提供的代码实例和技术深度解析,深入学习和实践大数据异常检测。

- Apache Hadoop:作为大数据处理框架,用于分布式存储和处理大规模文本数据。

- Apache Spark:用于大规模数据处理和分析,实现情感分析的特征提取和模型训练。

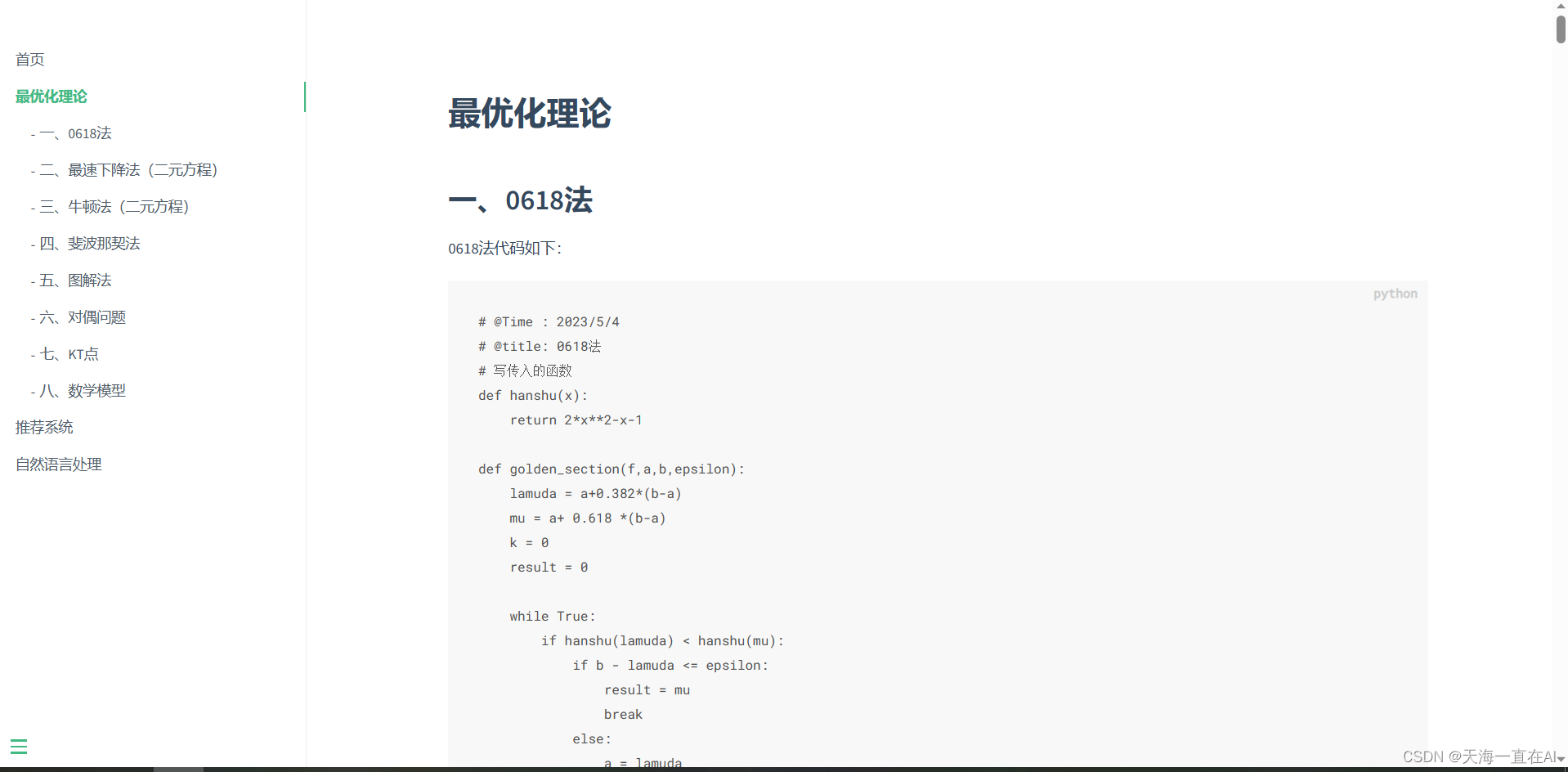

- 自然语言处理(NLP)技术:使用分词、词性标注、句法分析等技术,进行文本的预处理和特征提取。

- 机器学习算法:使用分类算法(如朴素贝叶斯、支持向量机)或深度学习算法(如循环神经网络)构建情感分析模型。

结论:

通过本文的实战演示,我们展示了如何使用大数据技术构建一个实时用户推荐系统。我们通过结合Apache Kafka、Apache Spark和机器学习算法,实现了一个高效、可扩展且准确的推荐系统。读者可以参考本文提供的代码实例和技术深度解析,进一步深入学习和应用大数据技术在推荐系统中的实践。