文章目录

- Spark 运行环境

- 一、Local 模式

- 1. 下载压缩包

- 2.上传到服务器

- 3. 解压

- 4. 启动 Local 环境

- 5. 命令行工具

- 6. 退出本地模式

- 7. 提交应用

- 二、Standalone 模式

- 1. 解压

- 2. 修改配置文件

- 1)进入解压缩后路径的 conf 目录,复制 workers.template 文件为 workers

- 2)修改 workers文件,添加 work 节点

- 3)复制 spark-env.sh.template 文件名为 spark-env.sh

- 4)修改 spark-env.sh 文件,添加 JAVA_HOME 环境变量和集群对应的 master 节点

- 5)分发 spark-standalone 目录

- 3. 启动集群

- 1)执行脚本命令

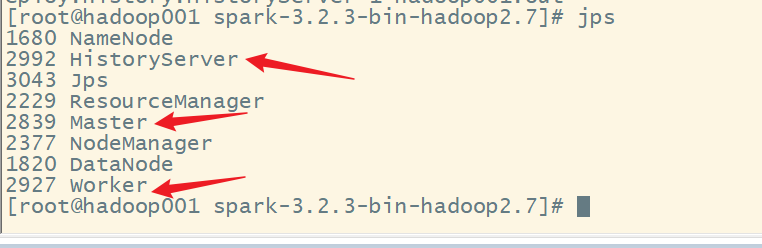

- 2)查看三台服务器运行进程

- 3)查看 Master 资源监控 Web UI 界面:http://hadoop001:8080/

- 4. 提交应用

- 5. 提交参数说明

- 6. 配置历史服务

- 1)修改 spark-defaults.conf.template 文件名为 spark-defaults.conf

- 2)启动 hadoop 集群

- 3)创建 directory 文件夹

- 4)修改 spark-default.conf 文件,配置日志存储路径

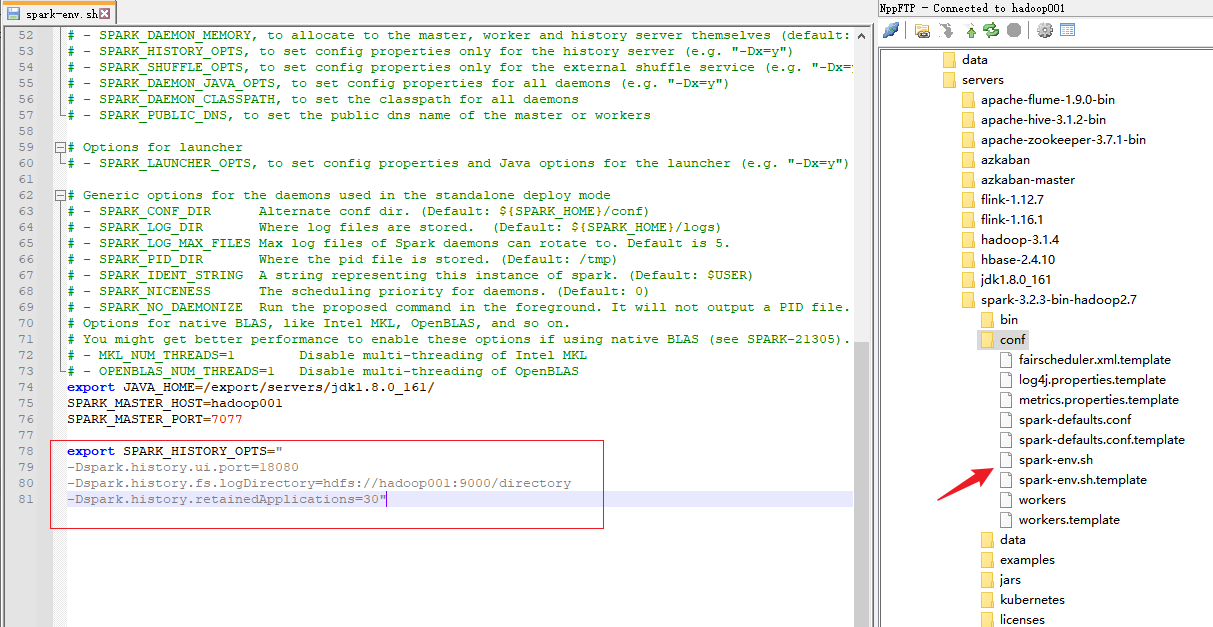

- 5)修改 spark-env.sh 文件, 添加日志配置

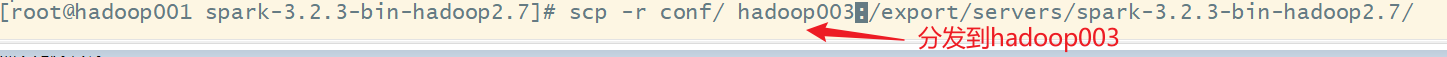

- 6)分发配置文件

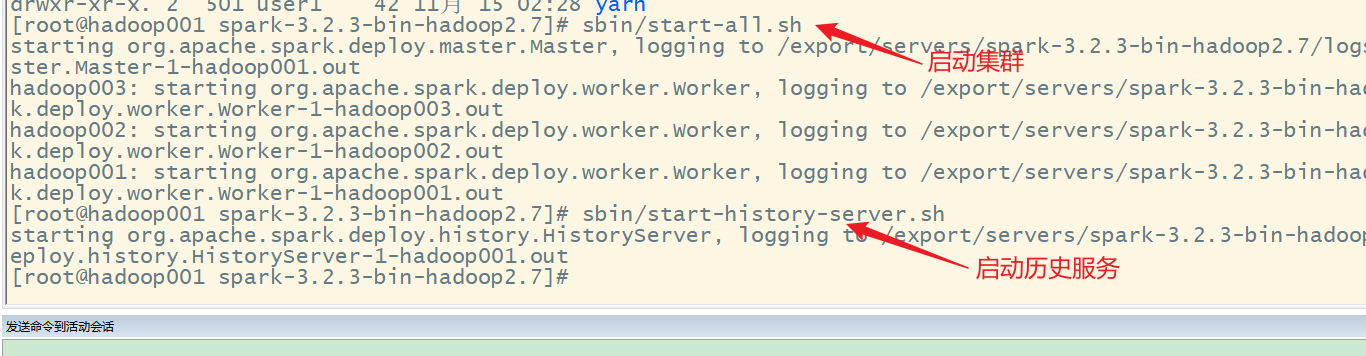

- 7)重新启动集群和历史服务

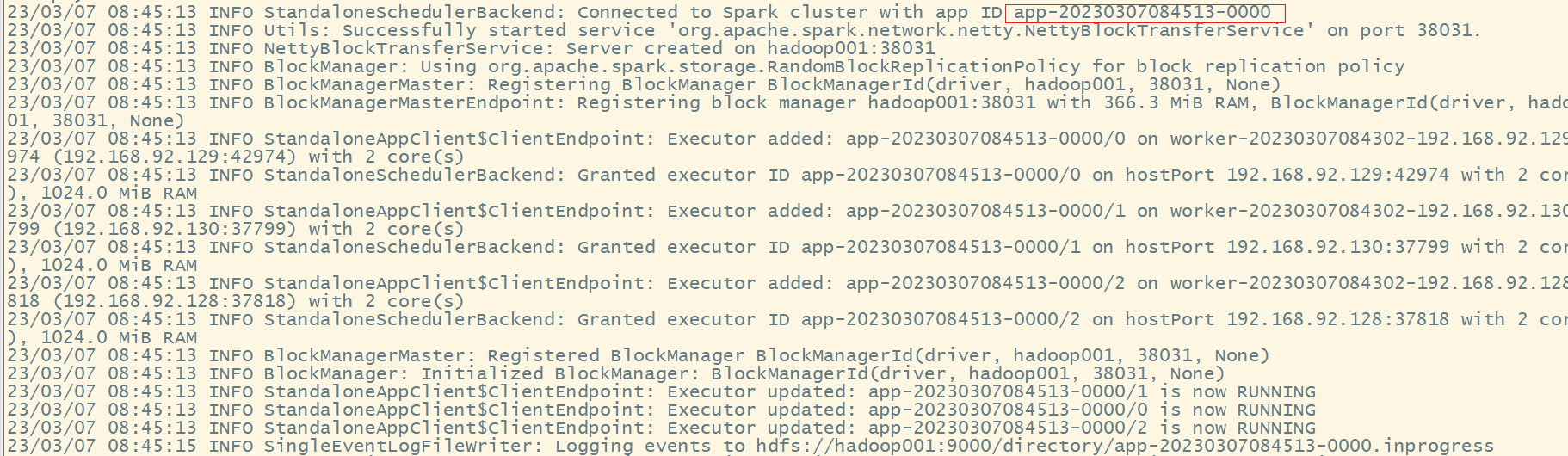

- 8)重新执行任务

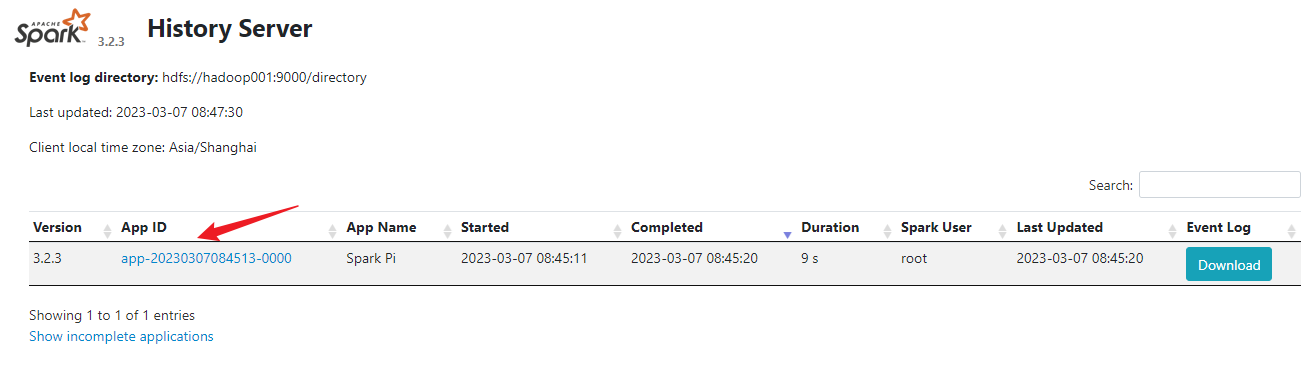

- 9)查看历史服务:http://hadoop001:18080

- 7. 配置高可用(HA)

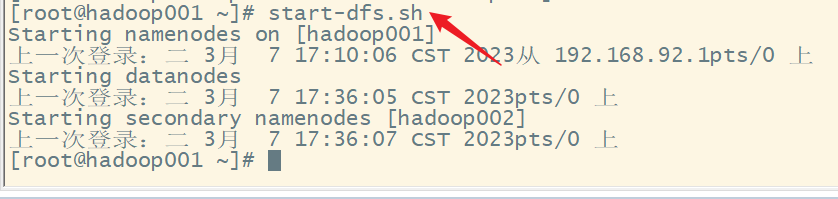

- 1)启动HDFS

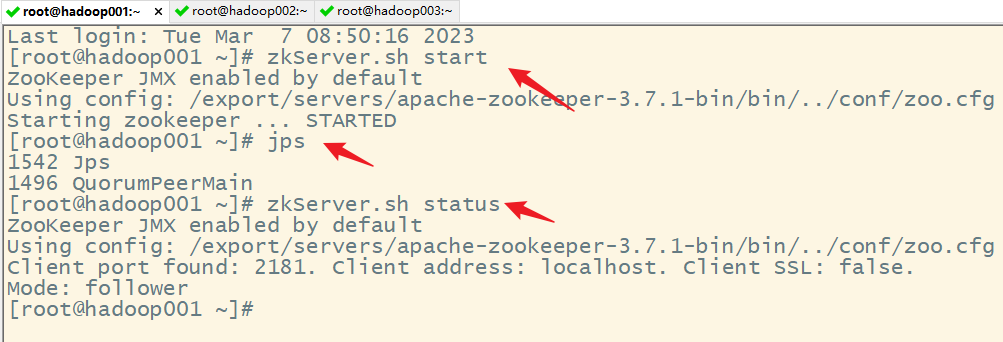

- 2)启动 Zookeeper

- 3)修改 spark-env.sh 文件添加如下配置

- 4)分发配置文件

- 5)启动集群

- 6)启动 hadoop002 的单独 Master 节点

- 7)提交应用到高可用集群

- 8)停止 Hadoop001的 Master 资源监控进程

- 9)查看 Hadoop002 的 Master 资源监控 Web UI,稍等一段时间后,Hadoop002节点的 Master 状态提升为活动状态

Spark 运行环境

Spark 作为一个数据处理框架和计算引擎,被设计在所有常见的集群环境中运行, 在国内工作中主流的环境为 Yarn,不过逐渐容器式环境也慢慢流行起来。接下来,我们就分别看看不同环境下 Spark 的运行

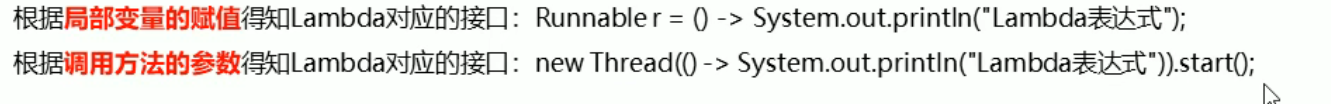

一、Local 模式

所谓的 Local 模式,就是不需要其他任何节点资源就可以在本地执行 Spark 代码的环境,一般用于教学,调试,演示等。

1. 下载压缩包

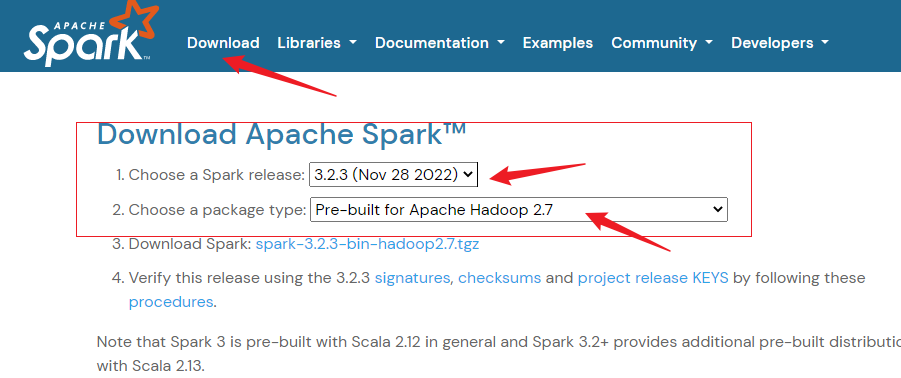

Spark官网

下载 Spark 安装包

点击下载:

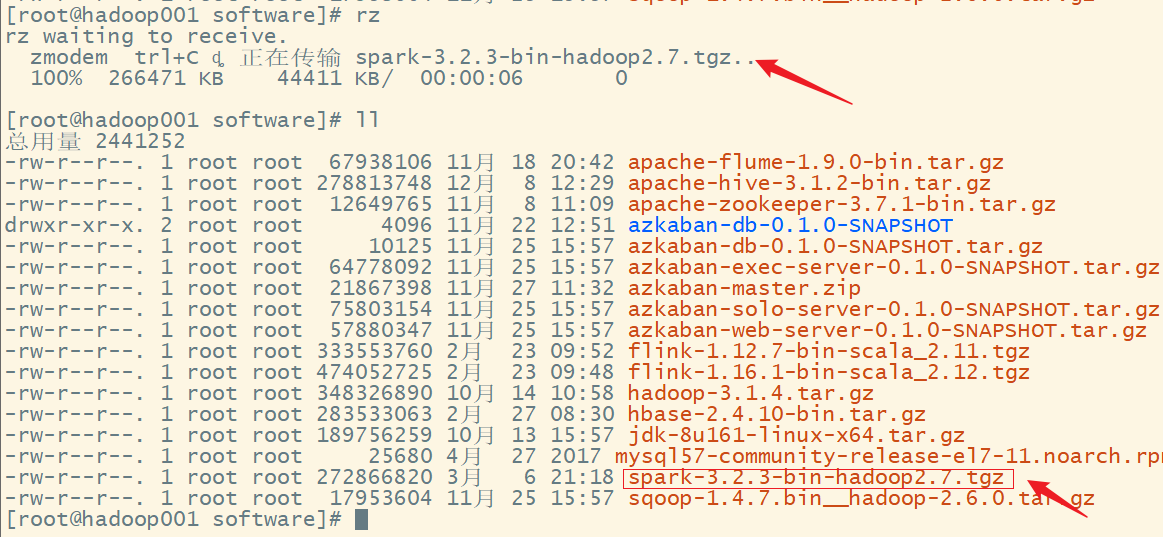

2.上传到服务器

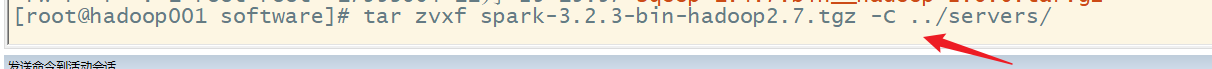

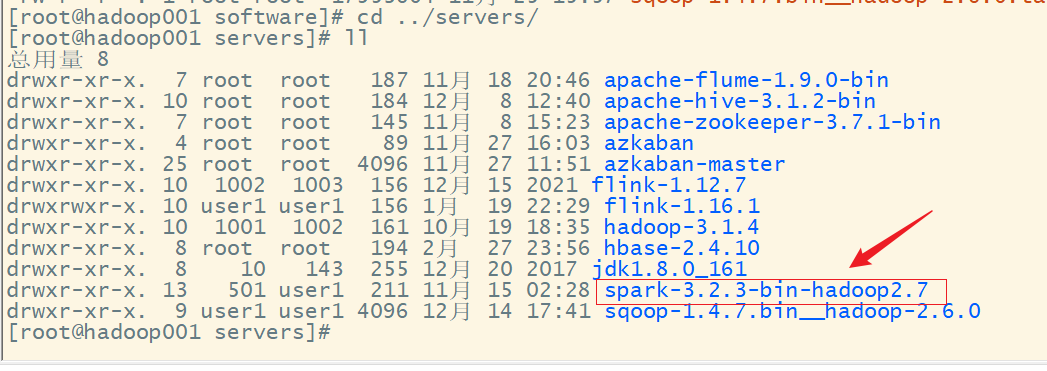

3. 解压

4. 启动 Local 环境

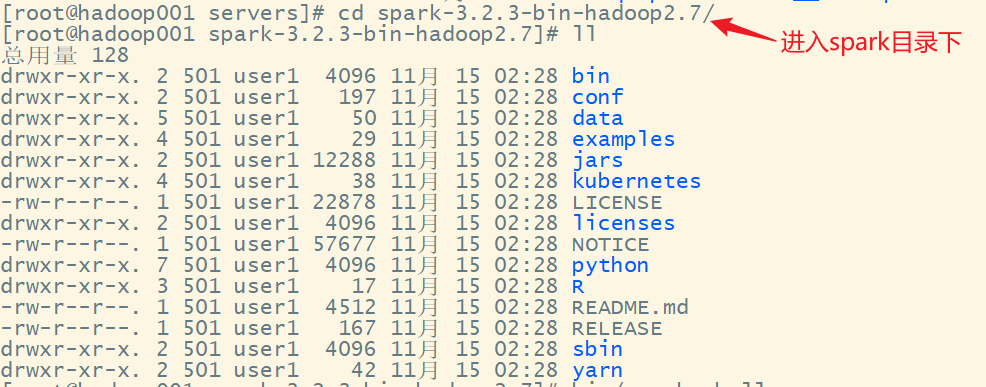

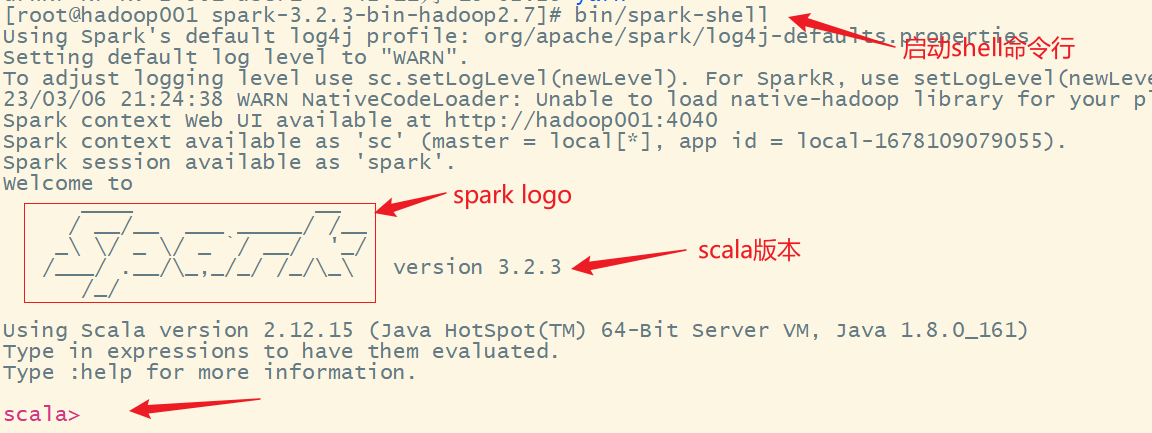

1)进入解压缩后的路径,执行如下指令

bin/spark-shell

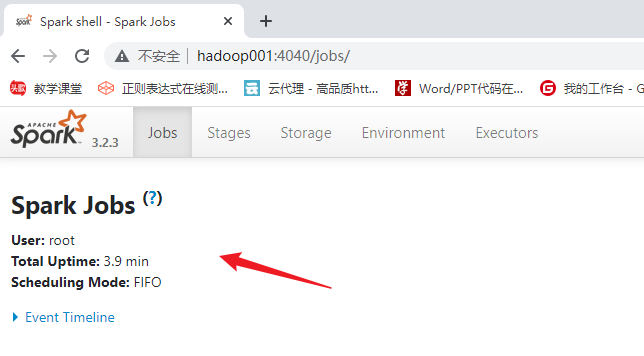

2)启动成功后,可以输入网址进行 Web UI 监控页面访问

5. 命令行工具

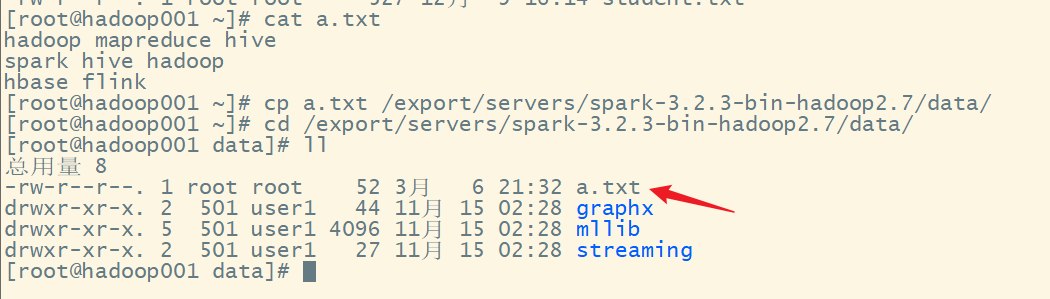

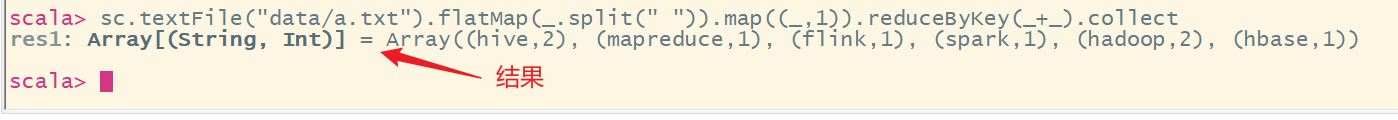

在解压缩文件夹下的 data 目录中,添加 a.txt 文件。

在命令行工具中执行如下代码指令

sc.textFile("data/a.txt").flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_).collect

6. 退出本地模式

按键 Ctrl+C 或输入 Scala 指令

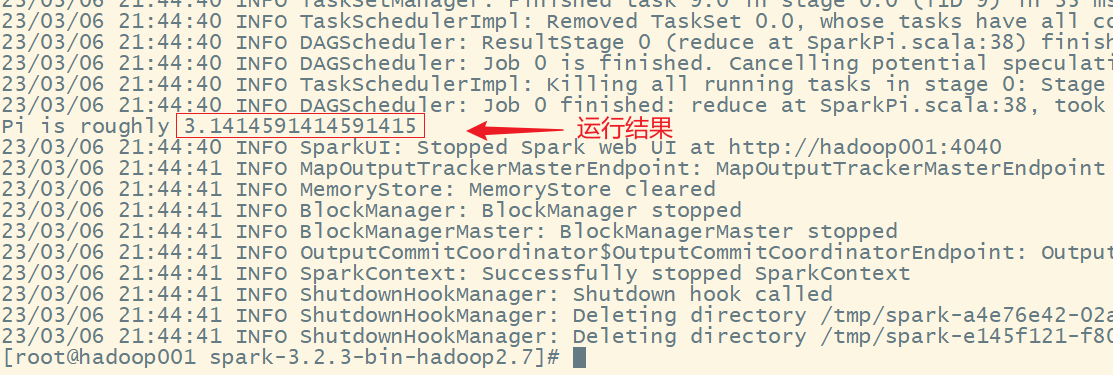

7. 提交应用

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master local[2] \

./examples/jars/spark-examples_2.12-3.2.3.jar \

10

1) --class 表示要执行程序的主类,此处可以更换为咱们自己写的应用程序

2) --master local[2] 部署模式,默认为本地模式,数字表示分配的虚拟 CPU 核数量

3) spark-examples_2.12-3.0.0.jar 运行的应用类所在的 jar 包,实际使用时,可以设定为咱们自己打的 jar 包

4) 数字 10 表示程序的入口参数,用于设定当前应用的任务数量

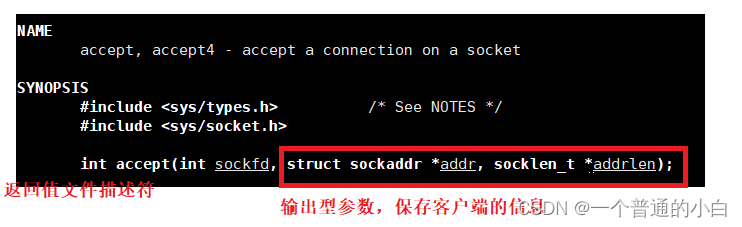

二、Standalone 模式

local 本地模式毕竟只是用来进行练习演示的,真实工作中还是要将应用提交到对应的集群中去执行,这里我们来看看只使用 Spark 自身节点运行的集群模式,也就是我们所谓的独立部署(Standalone)模式。Spark 的 Standalone 模式体现了经典的 master-slave 模式。

集群规划:

| Master | Worker | |

|---|---|---|

| hadoop001 | ✅ | ✅ |

| hadoop002 | ❎ | ✅ |

| hadoop003 | ❎ | ✅ |

1. 解压

同上

2. 修改配置文件

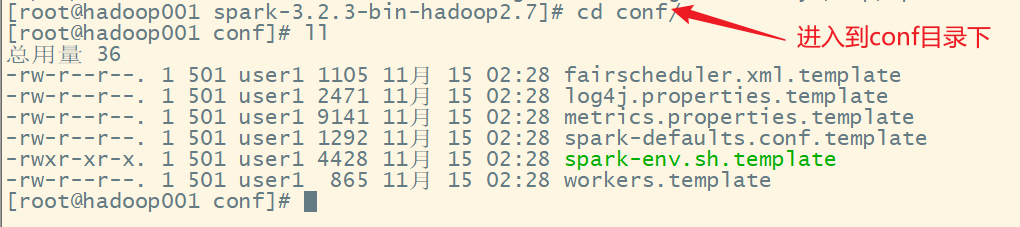

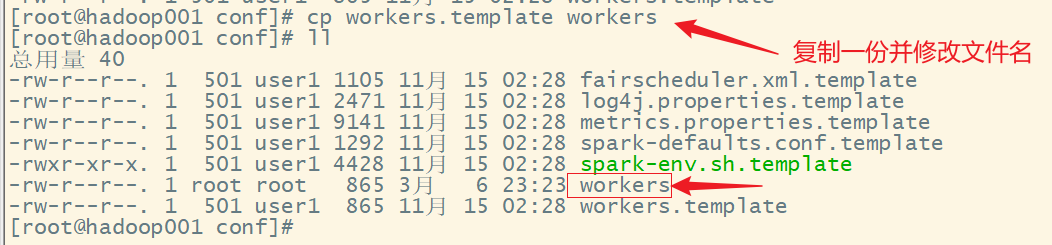

1)进入解压缩后路径的 conf 目录,复制 workers.template 文件为 workers

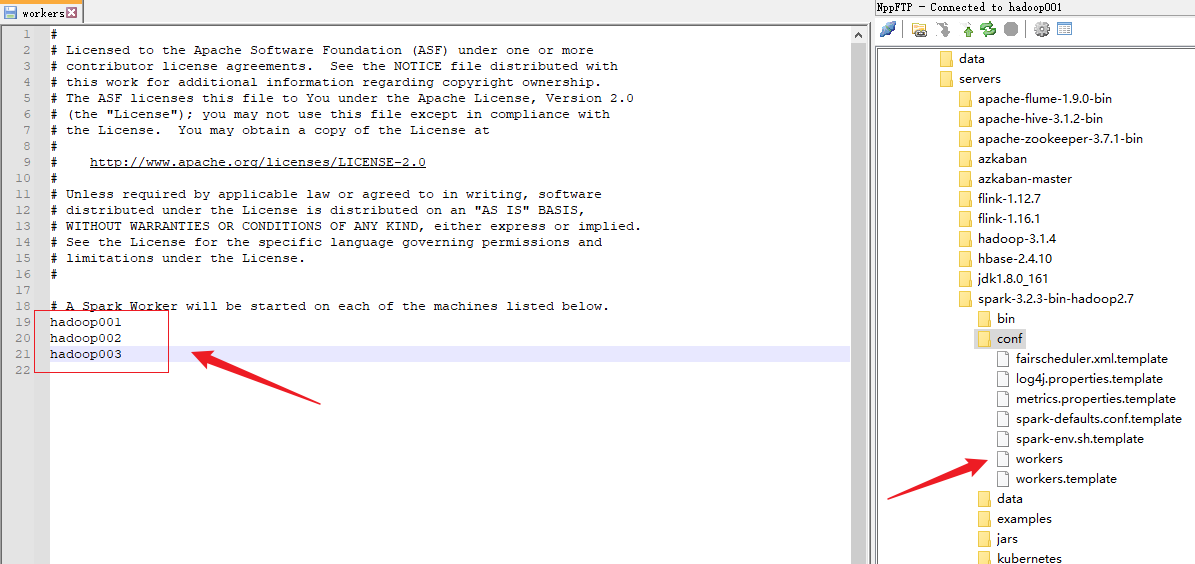

2)修改 workers文件,添加 work 节点

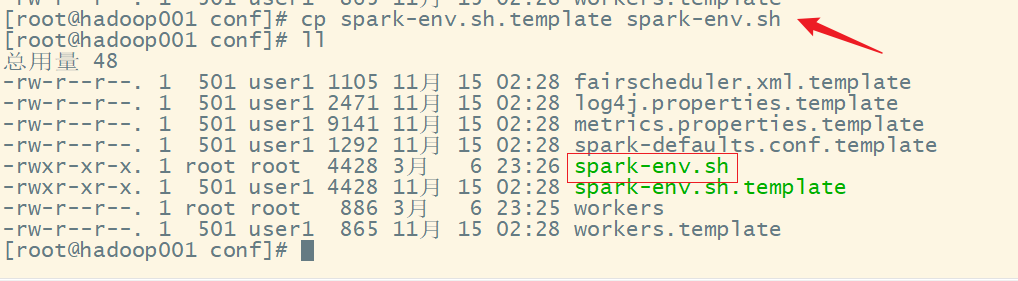

3)复制 spark-env.sh.template 文件名为 spark-env.sh

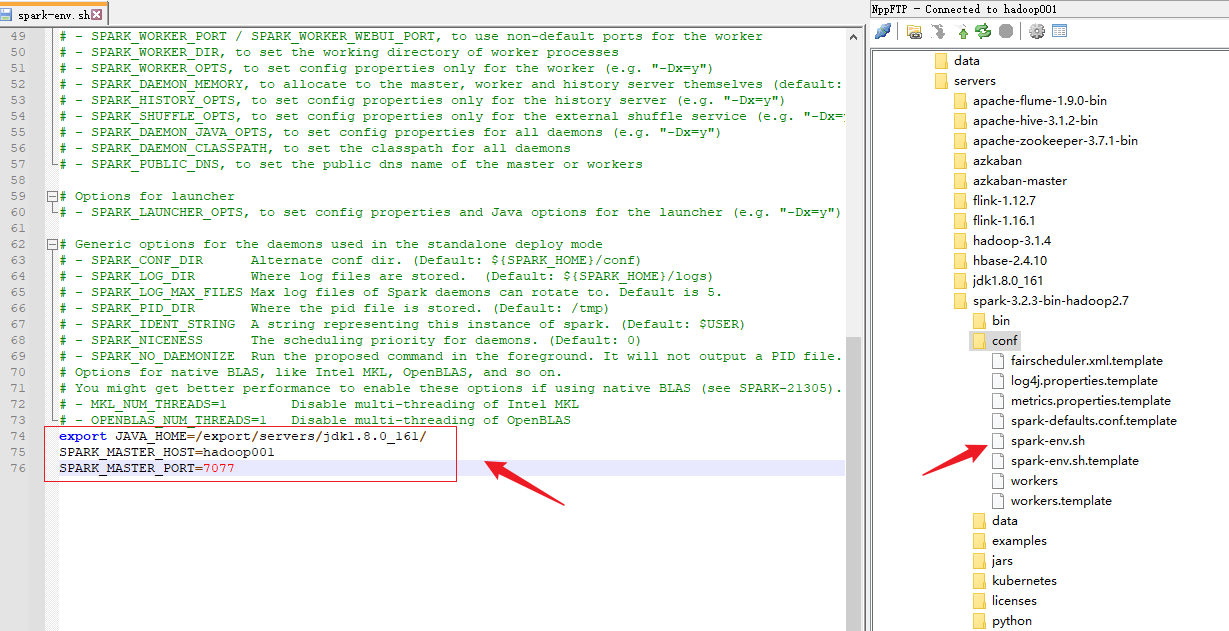

4)修改 spark-env.sh 文件,添加 JAVA_HOME 环境变量和集群对应的 master 节点

export JAVA_HOME=/export/servers/jdk1.8.0_161/

SPARK_MASTER_HOST=hadoop001

SPARK_MASTER_PORT=7077

注意:7077 端口,相当于 hadoop3 内部通信的 8020 端口,此处的端口需要确认自己的 Hadoop 配置

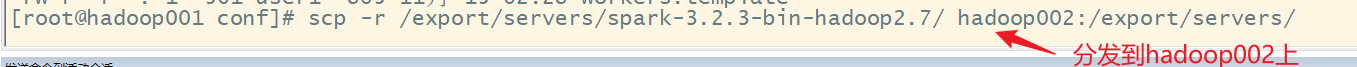

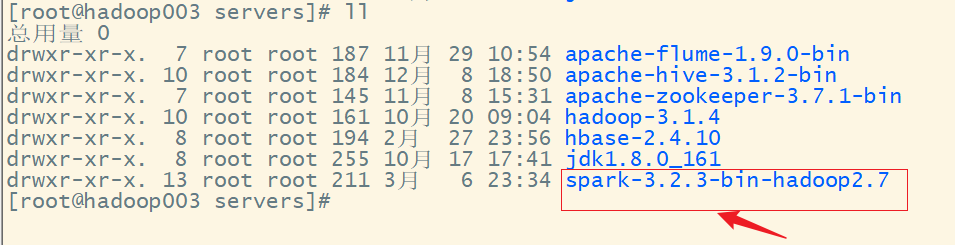

5)分发 spark-standalone 目录

分发到hadoop002

分发到hadoop003

3. 启动集群

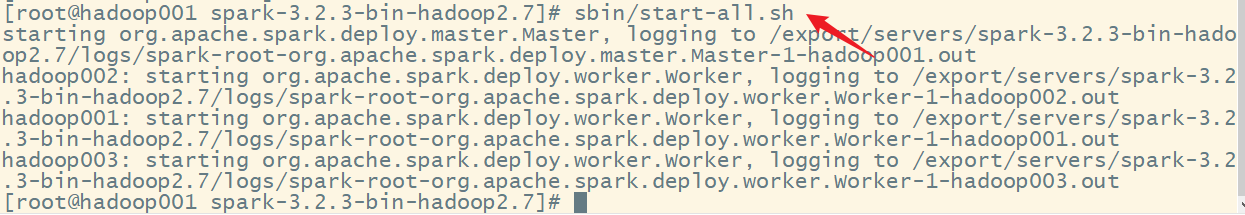

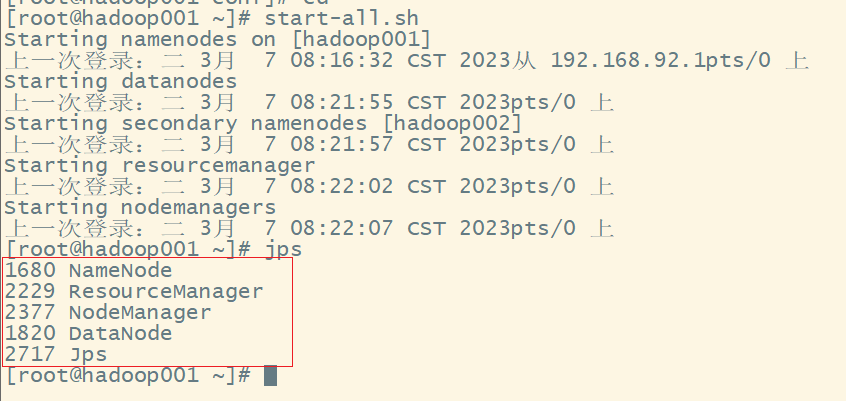

1)执行脚本命令

sbin/start-all.sh

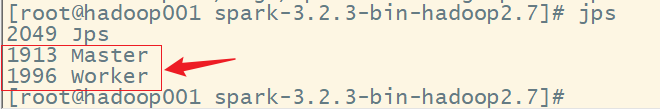

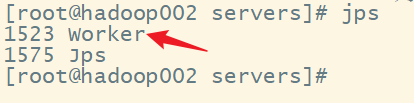

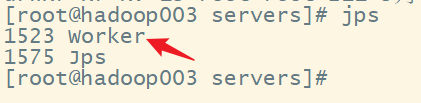

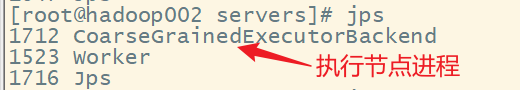

2)查看三台服务器运行进程

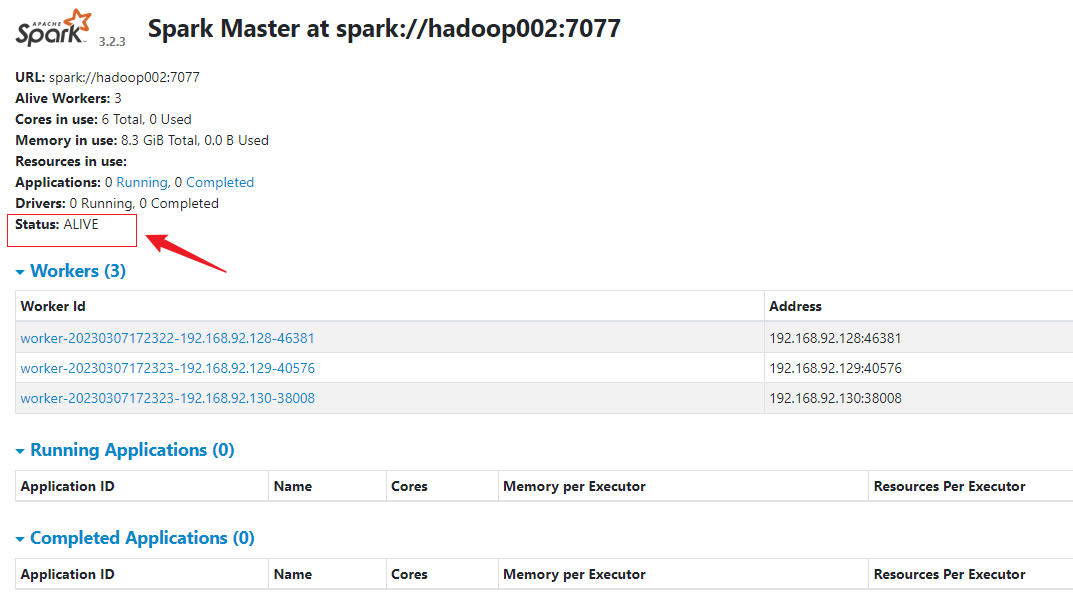

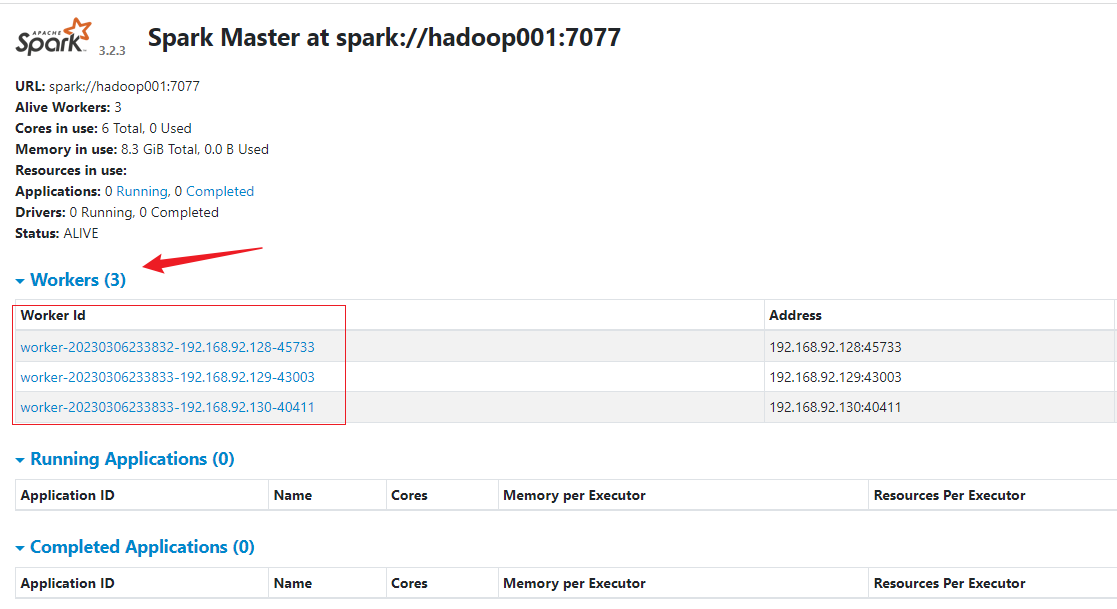

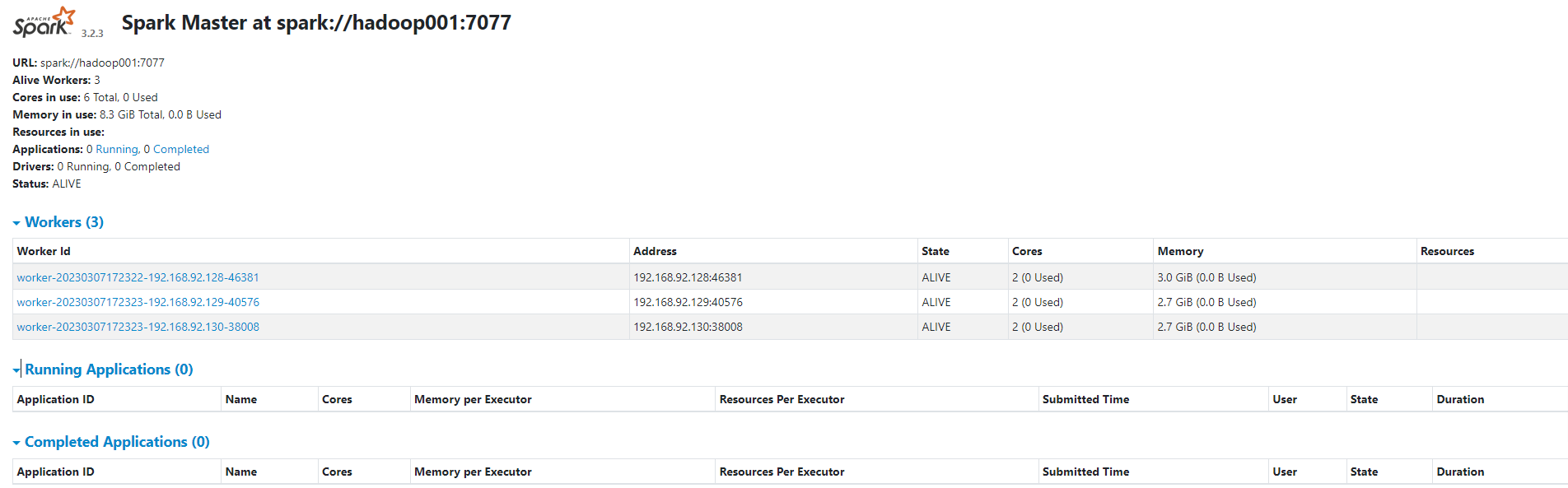

3)查看 Master 资源监控 Web UI 界面:http://hadoop001:8080/

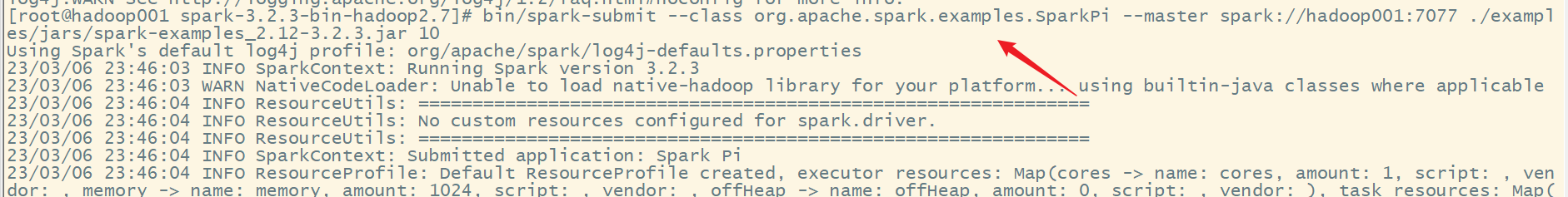

4. 提交应用

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://hadoop001:7077 \

./examples/jars/spark-examples_2.12-3.2.3.jar \

10

1)–class 表示要执行程序的主类

2)–master spark://hadoop001:7077 独立部署模式,连接到 Spark 集群

3)spark-examples_2.12-3.2.3.jar 运行类所在的 jar 包

4) 数字 10 表示程序的入口参数,用于设定当前应用的任务数量

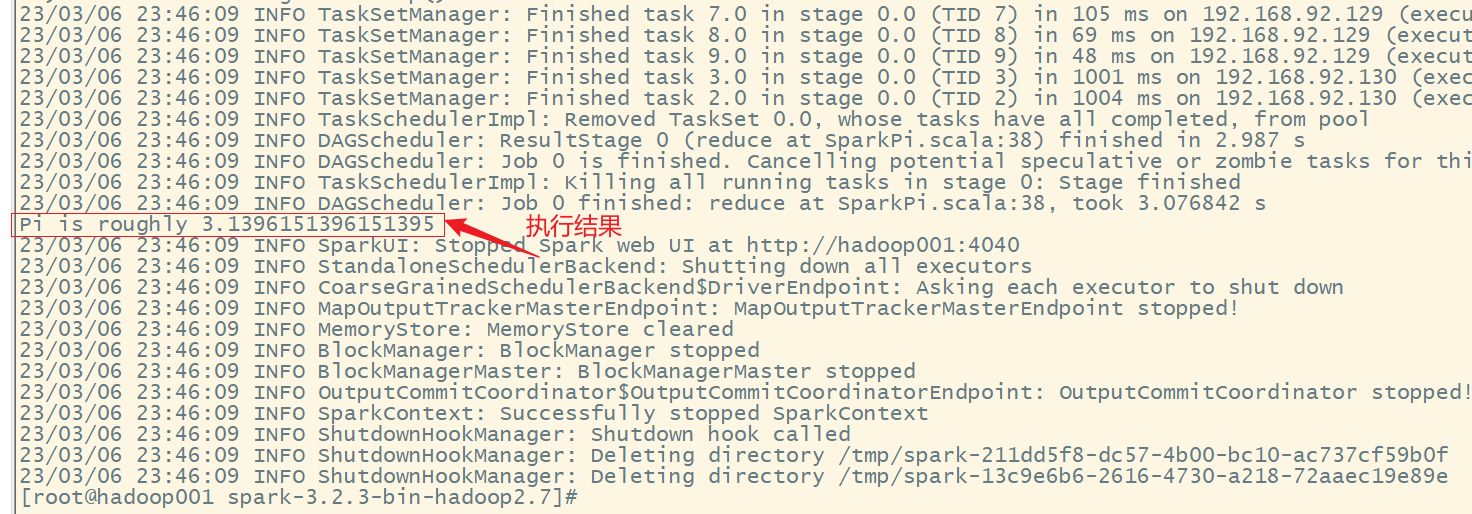

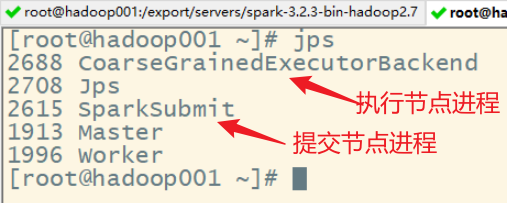

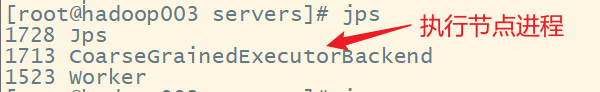

执行任务时,会产生多个 Java 进程

执行任务时,默认采用服务器集群节点的总核数,每个节点内存 1024M。

5. 提交参数说明

在提交应用中,一般会同时一些提交参数

bin/spark-submit \

--class <main-class>

--master <master-url> \

... # other options

<application-jar> \

[application-arguments]

| 参数 | 解释 | 可选值举例 |

|---|---|---|

| –class | Spark 程序中包含主函数的类 | |

| –master | Spark 程序运行的模式(环境) | 模式:local[*]、spark://hadoop001:7077、Yarn |

| –executor-memory 1G | 指定每个 executor 可用内存为 1G | 符合集群内存配置即可,具体情况具体分析。 |

| –total-executor-cores 2 | 指定所有executor使用的cpu核数为 2 个 | 符合集群内存配置即可,具体情况具体分析。 |

| –executor-cores | 指定每个executor使用的cpu核数 | |

| application-jar | 打包好的应用 jar,包含依赖。这个 URL 在集群中全局可见。 比如 hdfs:// 共享存储系统,如果是file:// path,那么所有的节点的path 都包含同样的 jar | 符合集群内存配置即可,具体情况具体分析。 |

| application-arguments | 传给 main()方法的参数 | 符合集群内存配置即可,具体情况具体分析。 |

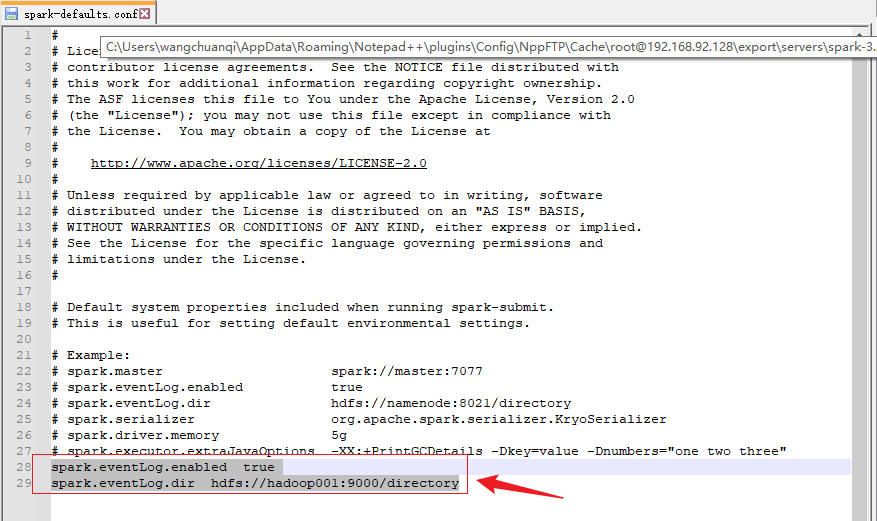

6. 配置历史服务

由于 spark-shell 停止掉后,集群监控 hadoop001:4040 页面就看不到历史任务的运行情况,所以开发时都配置历史服务器记录任务运行情况。

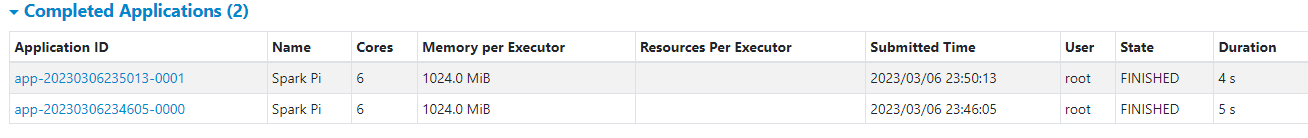

1)修改 spark-defaults.conf.template 文件名为 spark-defaults.conf

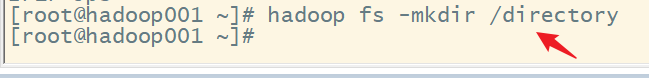

2)启动 hadoop 集群

3)创建 directory 文件夹

集群查看:

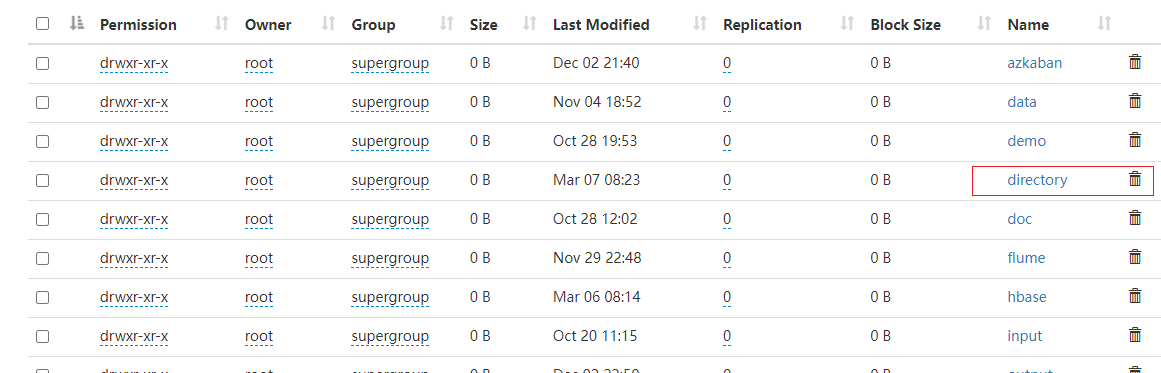

4)修改 spark-default.conf 文件,配置日志存储路径

spark.eventLog.enabled true

spark.eventLog.dir hdfs://hadoop001:9000/directory

5)修改 spark-env.sh 文件, 添加日志配置

export SPARK_HISTORY_OPTS="

-Dspark.history.ui.port=18080

-Dspark.history.fs.logDirectory=hdfs://hadoop001:9000/directory

-Dspark.history.retainedApplications=30"

⚫ 参数 1 含义:WEB UI 访问的端口号为 18080

⚫ 参数 2 含义:指定历史服务器日志存储路径

⚫ 参数 3 含义:指定保存 Application 历史记录的个数,如果超过这个值,旧的应用程序信息将被删除,这个是内存中的应用数,而不是页面上显示的应用数。

6)分发配置文件

7)重新启动集群和历史服务

8)重新执行任务

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://hadoop001:7077 \

./examples/jars/spark-examples_2.12-3.2.3.jar \

10

9)查看历史服务:http://hadoop001:18080

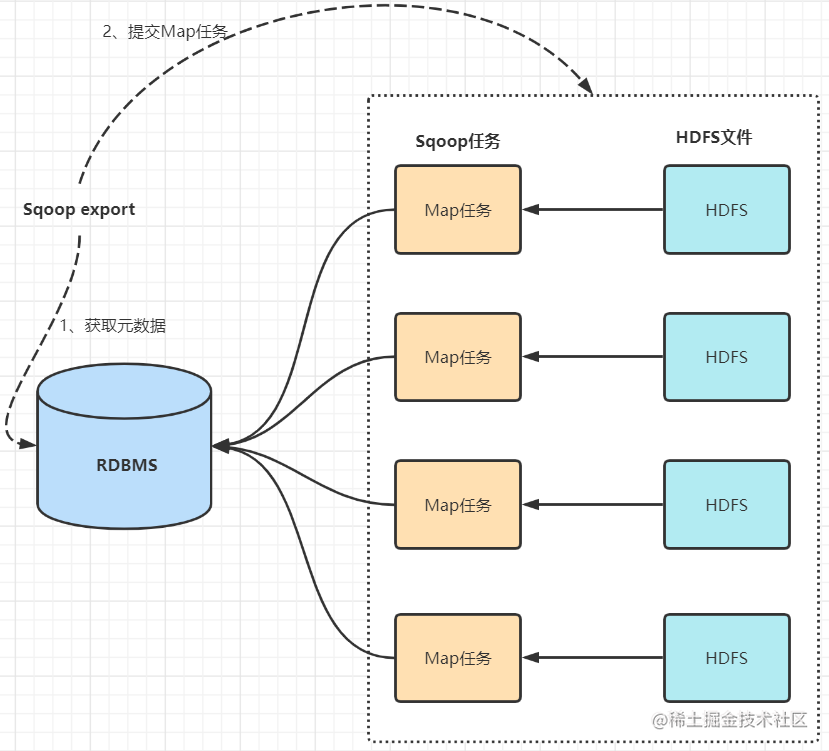

7. 配置高可用(HA)

所谓的高可用是因为当前集群中的 Master 节点只有一个,所以会存在单点故障问题。所以为了解决单点故障问题,需要在集群中配置多个 Master 节点,一旦处于活动状态的 Master发生故障时,由备用 Master 提供服务,保证作业可以继续执行。这里的高可用一般采用

Zookeeper 设置

集群规划:

| Master | Zookeeper | Worker | |

|---|---|---|---|

| hadoop001 | ✅ | ✅ | ✅ |

| hadoop002 | ✅ | ✅ | ✅ |

| hadoop003 | ✅ | ✅ |

1)启动HDFS

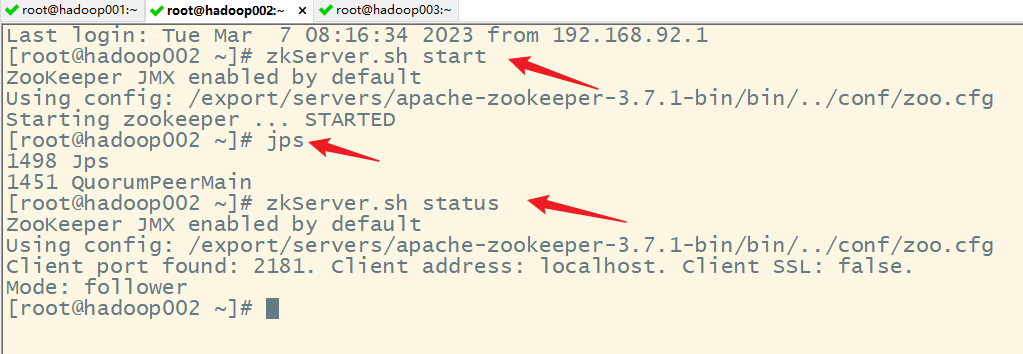

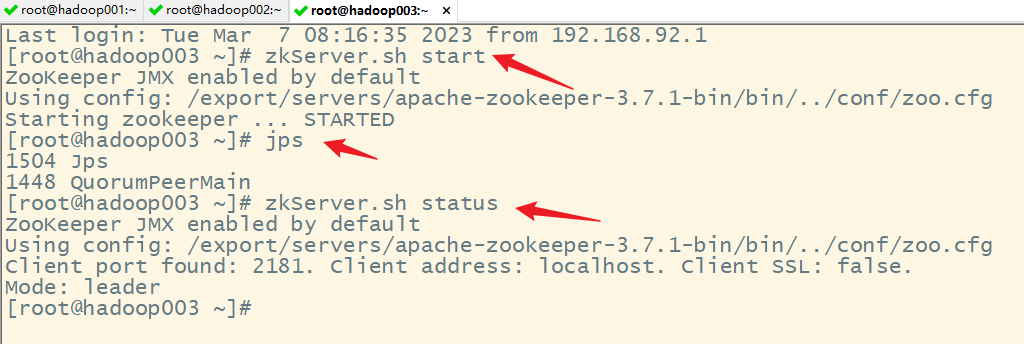

2)启动 Zookeeper

3)修改 spark-env.sh 文件添加如下配置

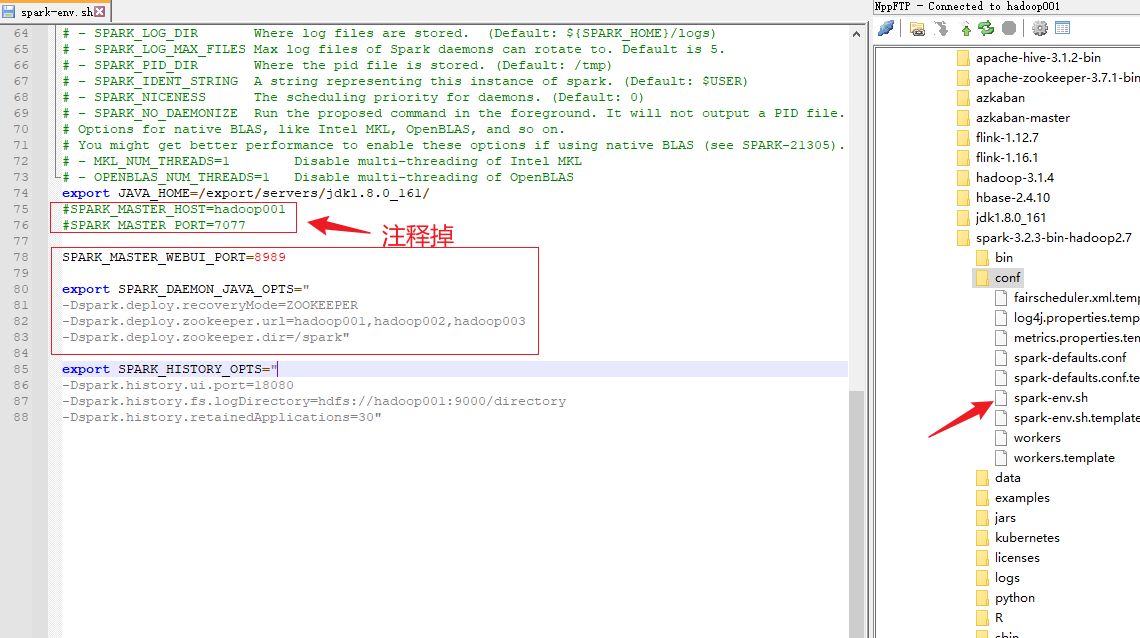

注释如下内容:

#SPARK_MASTER_HOST=hadoop001

#SPARK_MASTER_PORT=7077

添加如下内容:

#Master 监控页面默认访问端口为 8080,但是可能会和 Zookeeper 冲突,所以改成 8989,也可以自定义,访问 UI 监控页面时请注意

SPARK_MASTER_WEBUI_PORT=8989

export SPARK_DAEMON_JAVA_OPTS="

-Dspark.deploy.recoveryMode=ZOOKEEPER

-Dspark.deploy.zookeeper.url=hadoop001,hadoop002,hadoop003

-Dspark.deploy.zookeeper.dir=/spark"

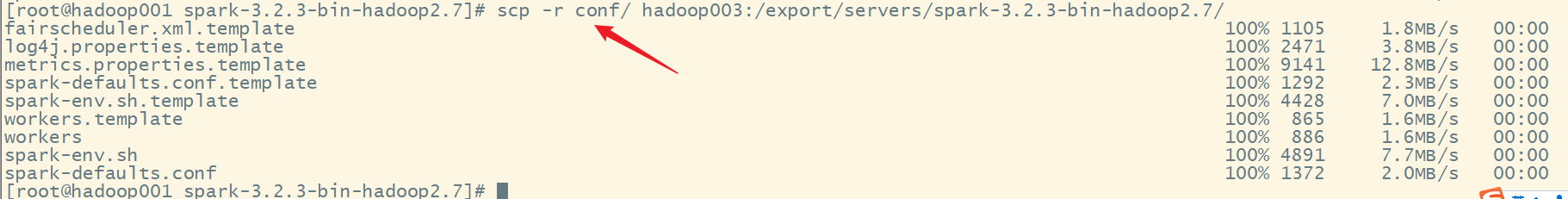

4)分发配置文件

5)启动集群

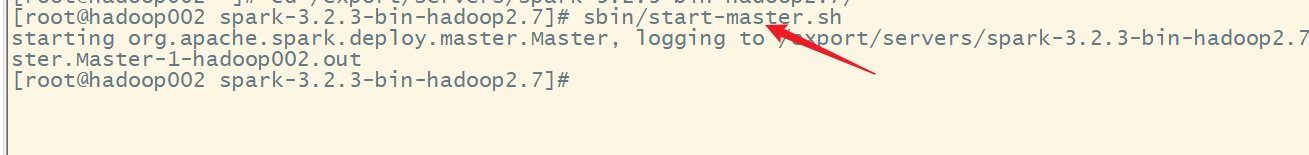

6)启动 hadoop002 的单独 Master 节点

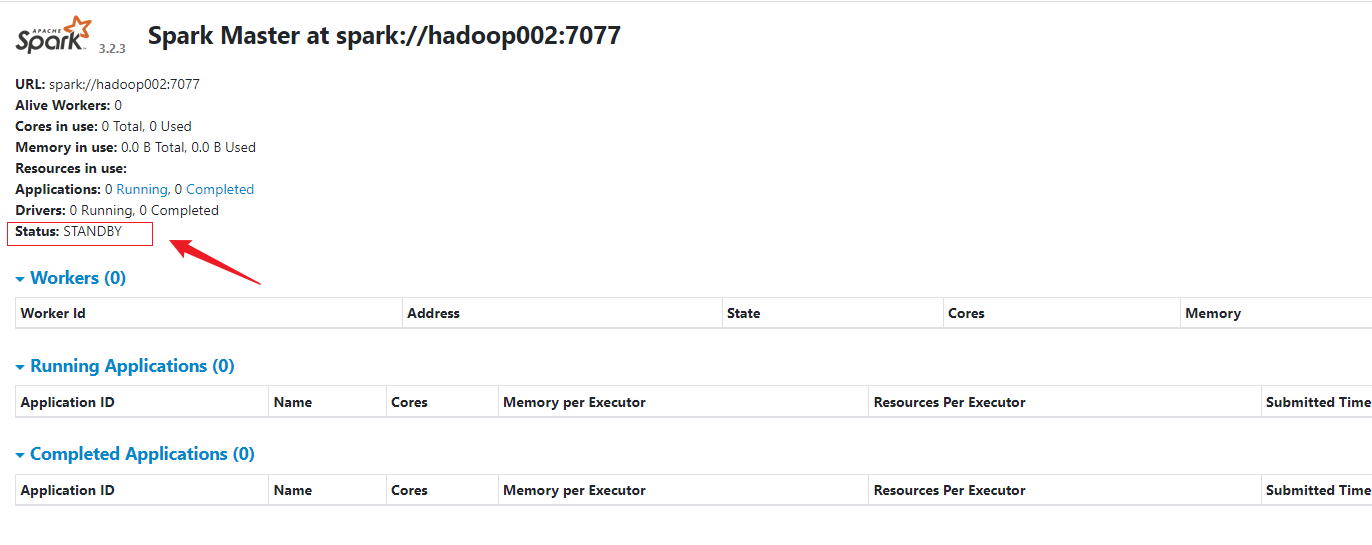

此时 hadoop002 节点 Master 状态处于备用状态

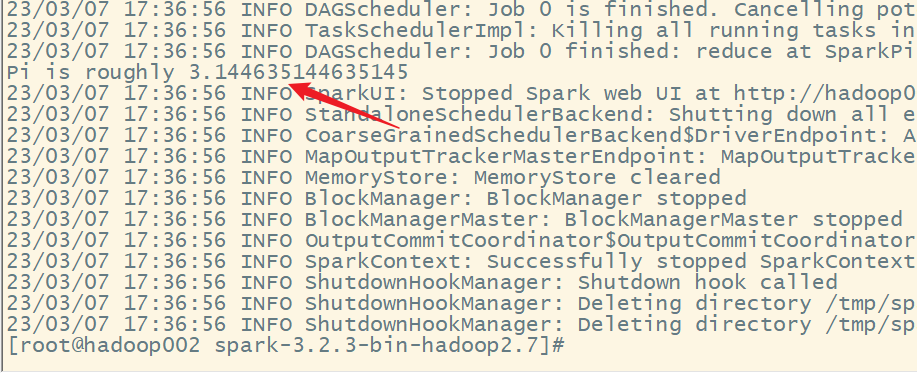

7)提交应用到高可用集群

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://hadoop001:7077,hadoop002:7077 \

./examples/jars/spark-examples_2.12-3.2.3.jar \

10

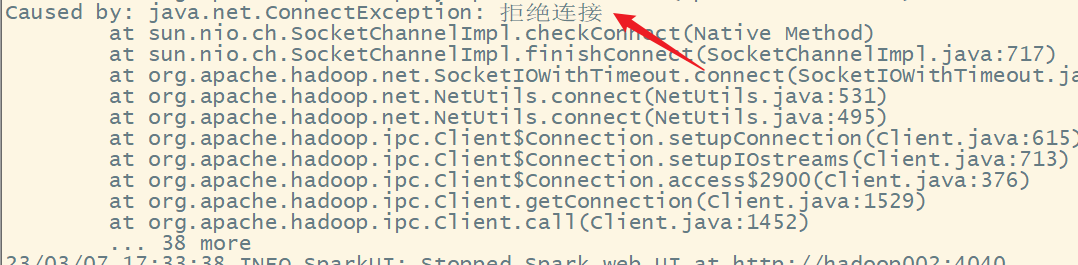

出现错误:

错误原因:没有启动Hadoop集群

8)停止 Hadoop001的 Master 资源监控进程

9)查看 Hadoop002 的 Master 资源监控 Web UI,稍等一段时间后,Hadoop002节点的 Master 状态提升为活动状态