文章目录

- 一、环境配置

- 1、修改主机名,然后切换到root用户

- 2、确认主机网关

- a.确认windows主机网关

- b.确认虚拟机主机网关

- 3、修改网络配置

- 4、设置DNS域名解析的配置文件resolv.conf。

- 5、修改hosts文件

- 6、重启网络服务

- 7、验证网络服务

- a.虚拟机ping百度

- b.主机ping虚拟机

- 二、Hadoop伪分布式安装

- 1、创建hadoop用户

- a.新建用户

- b.添加用户组

- c.赋予root权限

- 2、切换到hadoop,创建压缩包上传文件和安装文件目录

- 3、上传压缩包

- 4、解压jdk和hadoop

- 5、配置jdk、hadoop环境变量

- 6、修改hadoop配置文件

- core-site.xml

- hdfs-site.xml

- hadoop-env.xml

- 7、执行NameNode的格式化

- 8、配置免密登录

- 9、启动hadoop集群

- 三、安装

- 1、

- !!!出现的问题!!!

- !!!解决:

一、环境配置

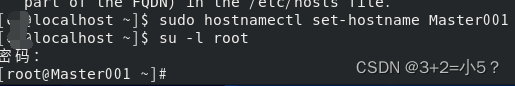

1、修改主机名,然后切换到root用户

sudo hostnamectl set-hostname Master001

su -l root

2、确认主机网关

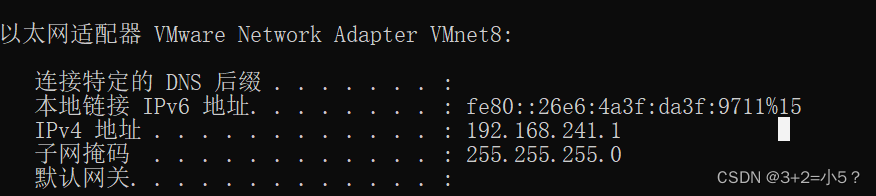

a.确认windows主机网关

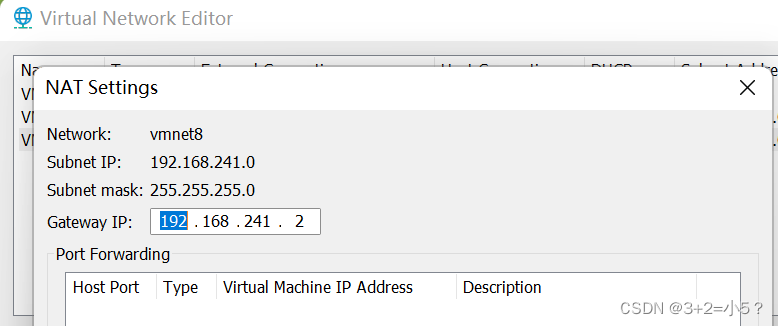

b.确认虚拟机主机网关

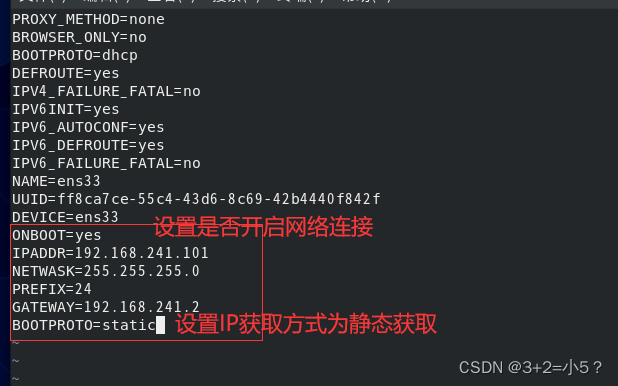

3、修改网络配置

vi /etc/sysconfig/network-scripts/ifcfg-ens33

ONBOOT=yes

IPADDR=192.168.241.101

NETWASK=255.255.255.0

PREFIX=24

GATEWAY=192.168.241.2

BOOTPROTO=static

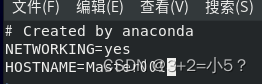

修改主机名

修改主机名

4、设置DNS域名解析的配置文件resolv.conf。

vi /etc/resolv.conf

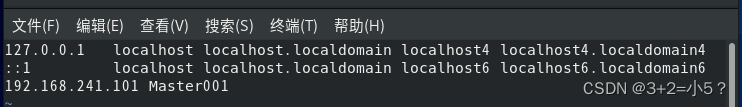

5、修改hosts文件

vi /etc/hosts

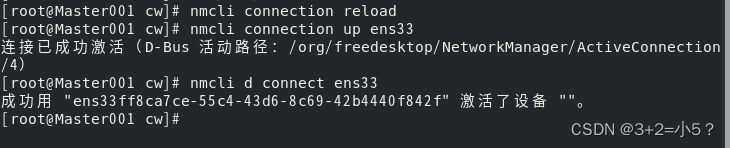

6、重启网络服务

nmcli connection reload

nmcli connection up ens33

nmcli d connect ens33

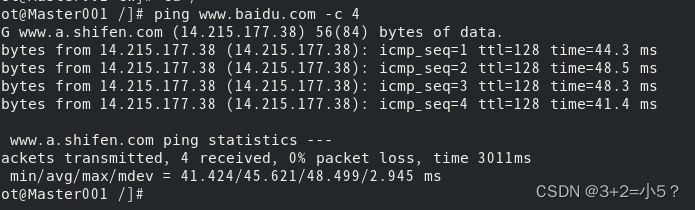

7、验证网络服务

a.虚拟机ping百度

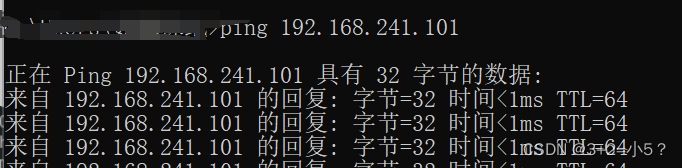

b.主机ping虚拟机

二、Hadoop伪分布式安装

1、创建hadoop用户

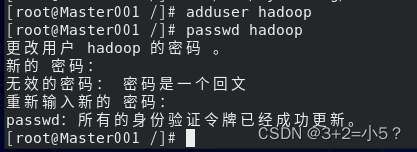

a.新建用户

adduser hadoop

passwd hadoop

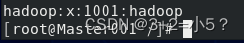

b.添加用户组

usermod -a -G hadoop hadoop

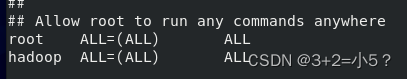

c.赋予root权限

vi /etc/sudoers

hadoop ALL=(ALL) ALL

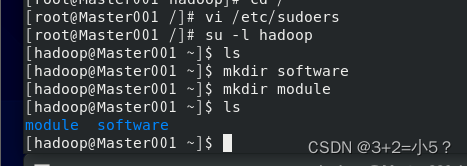

2、切换到hadoop,创建压缩包上传文件和安装文件目录

3、上传压缩包

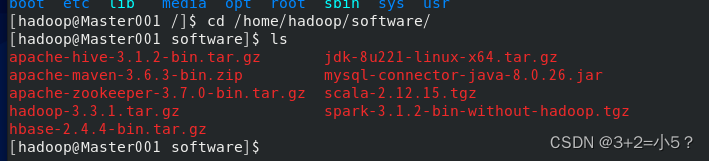

4、解压jdk和hadoop

tar -zxf jdk-8u221-linux-x64.tar.gz -C /home/hadoop/module/

tar -zxf hadoop-3.3.1.tar.gz -C /home/hadoop/module/

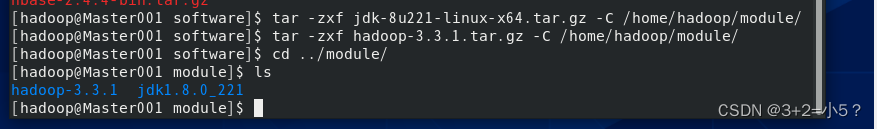

5、配置jdk、hadoop环境变量

vi /etc/profile

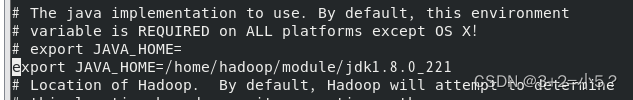

#JAVA

export JAVA_HOME=/home/hadoop/module/jdk1.8.0_221

export PATH=$PATH:$JAVA_HOME/bin

#HADOOP

export HADOOP_HOME=/home/hadoop/module/hadoop-3.3.1

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib/native"

export JAVA_LIBRARY_PATH=$HADOOP_HOME/lib/native:$JAVA_LIBRARY_PATH

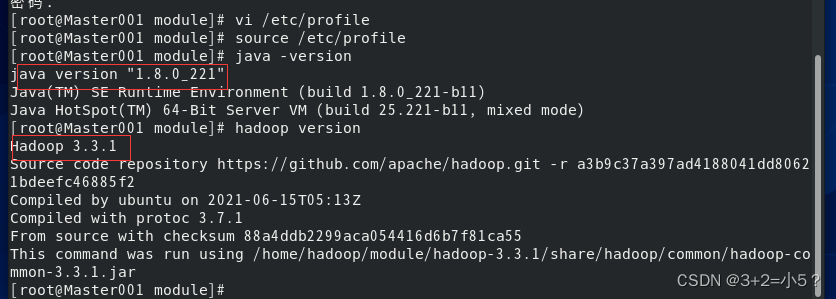

6、修改hadoop配置文件

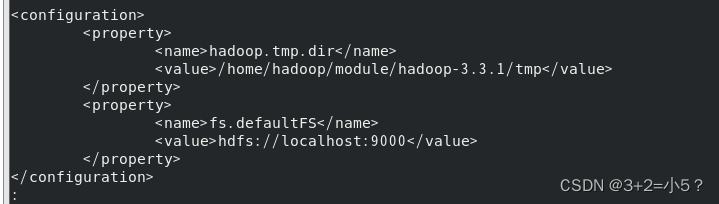

core-site.xml

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/module/hadoop-3.3.1/tmp</value>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/home/hadoop/module/hadoop-3.3.1/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/home/hadoop/module/hadoop-3.3.1/tmp/dfs/data</value>

</property>

hadoop-env.xml

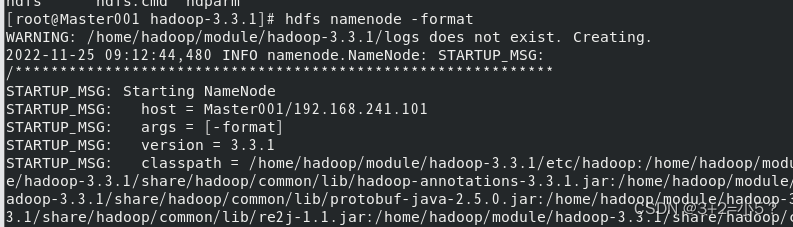

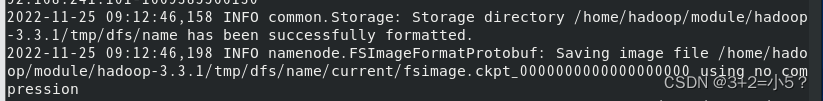

7、执行NameNode的格式化

如果要多次执行格式化,要删除data目录,否则datanode进程无法启动

hdfs namenode -format

格式化成功后name目录多了一个current文件夹

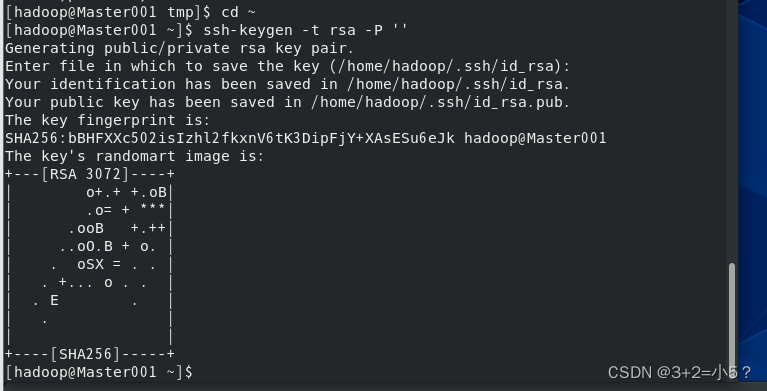

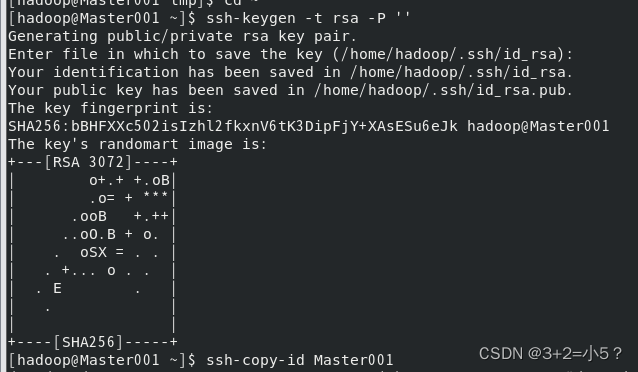

8、配置免密登录

ssh-keygen -t rsa -P ''

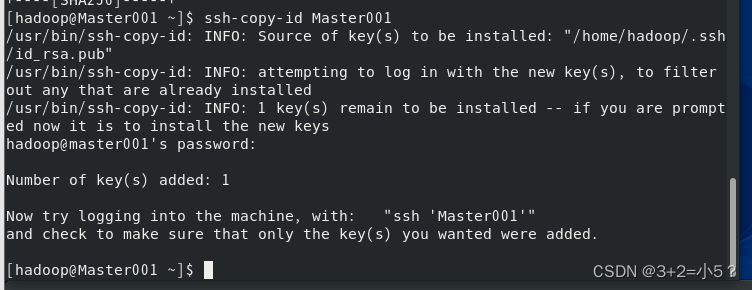

将密钥传给Master001

ssh-copy-id Master001

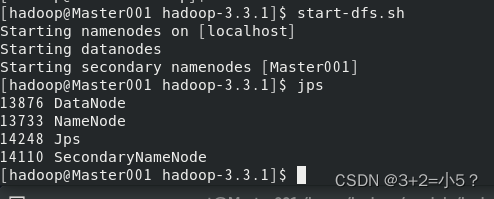

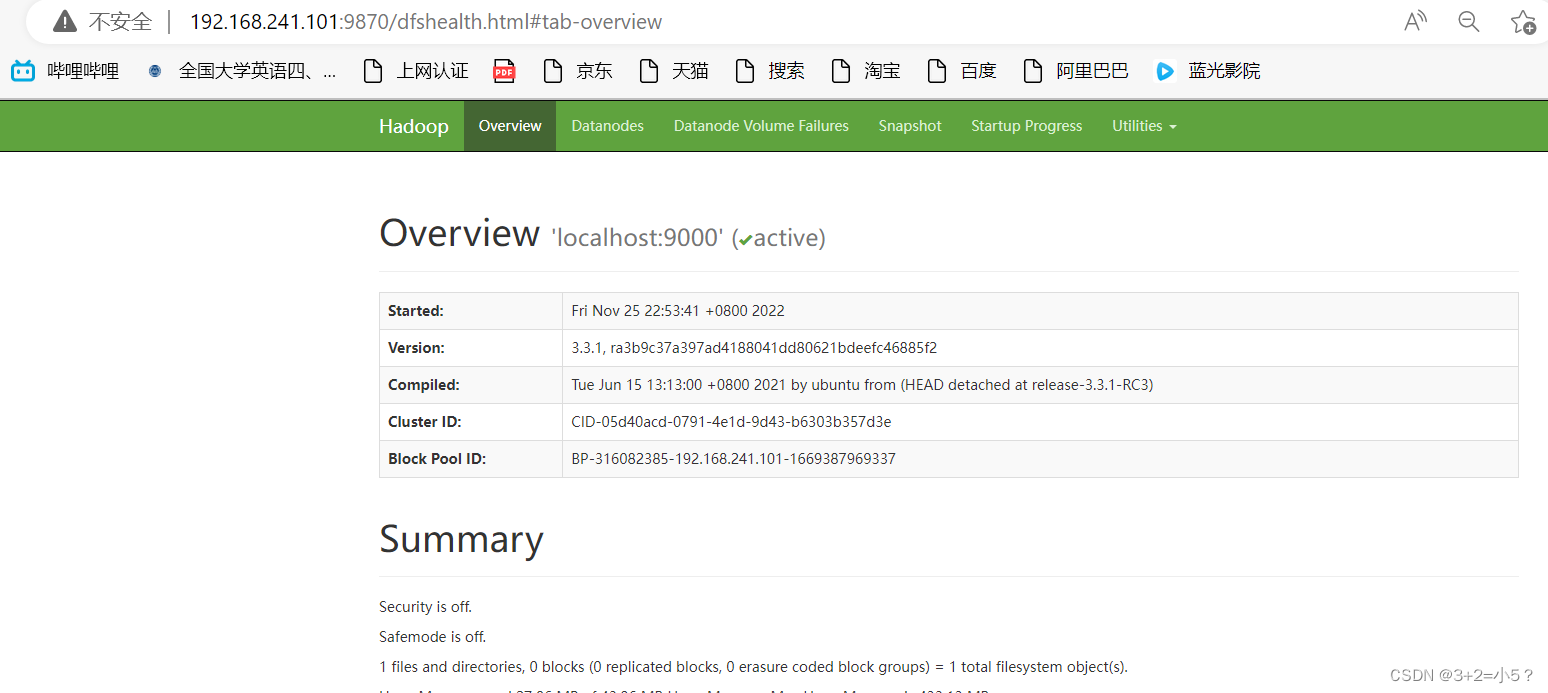

9、启动hadoop集群

hadoop配置安装完成

三、安装

1、

更新ing

!!!出现的问题!!!

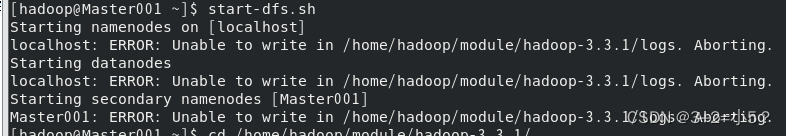

1、Master001: ERROR: Unable to write in /home/hadoop/module/hadoop-3.3.1/logs. Aborting.

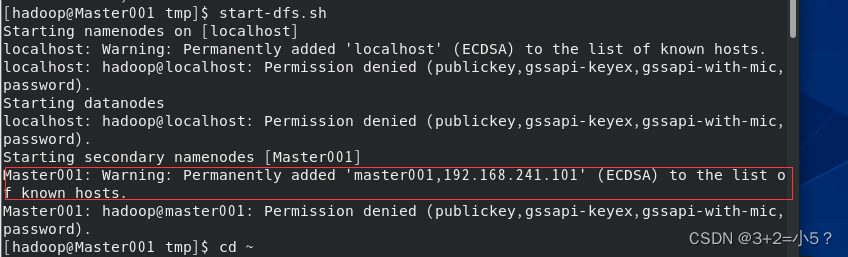

2、Warning: Permanently added ‘localhost’ (ECDSA) to the list of known hosts

!!!解决:

1、权限不够,授予权限

sudo chmod 777 /home/hadoop/module/hadoop-3.3.1/logs/

2、设置免密登录

![[附源码]Python计算机毕业设计二手书交易系统](https://img-blog.csdnimg.cn/43d2c962d2f64f8784eac886445a7323.png)