前提:本机已安装python,且版本大于3.9,推荐3.10

官方规定如下

我已安装

1.安装torch

查看自己电脑显卡信息

说明我没有装CUDA

使用 nvidia-smi 命令查看驱动信息

说明我NVIDIA 显卡已安装驱动,支持的 CUDA Runtime 版本为 12.6

去PyTorch 官网查一下用什么命令,官网:Previous PyTorch Versions

安装命令

pip install torch==2.6.0 torchvision==0.21.0 torchaudio==2.6.0 --index-url https://download.pytorch.org/whl/cu126

发现被墙掉了,那就下载 .whl 文件后手动安装

访问这个网站:https://download.pytorch.org/whl/cu126/torch/ 找到了我的,

下载完了直接扔D盘,执行命令pip install D:\torch-2.6.0+cu126-cp310-cp310-win_amd64.whl,就看到在装了,装完这个就能删掉了,如果网络环境访问官方 PyPI 很慢或不稳定(尤其在中国大陆常见),这里也会失败,可以切换到国内的镜像站

我这里安装完成了

开始验证

依次输入红框内容

这里报错没有NumPy,那就装一个

执行命令pip install numpy

安装完了继续验证

命令依次如下:

python

import torch

torch.cuda.current_device()

torch.cuda.get_device_name(0)

torch.cuda.get_device_name(0)

都没问题,那么前提的python环境已经ok了。

2.安装LLaMA-Factory

去github上下载人家的项目:https://github.com/hiyouga/LLaMA-Factory

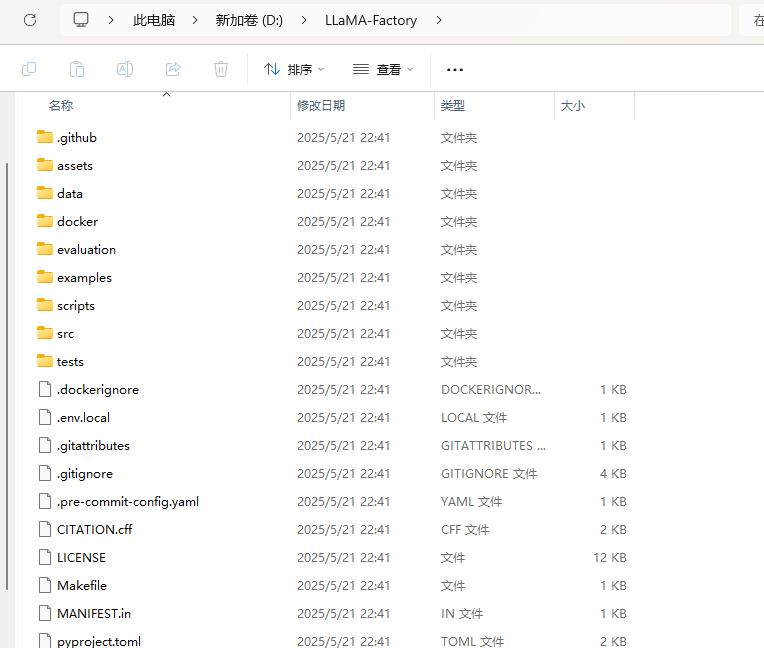

我这里是放到D盘中

cmd进到这个目录

根据官方文档,安装这两个组件,当然Extra dependencies available说明这些组件也可以安装,这里快速尝试,先不管这些了

执行命令 pip install -e ".[torch,metrics]" ,使用隔离环境,不用--no-build-isolation,防止出现问题

这里就安装完成了,验证一下,看看版本号,命令:llamafactory-cli version

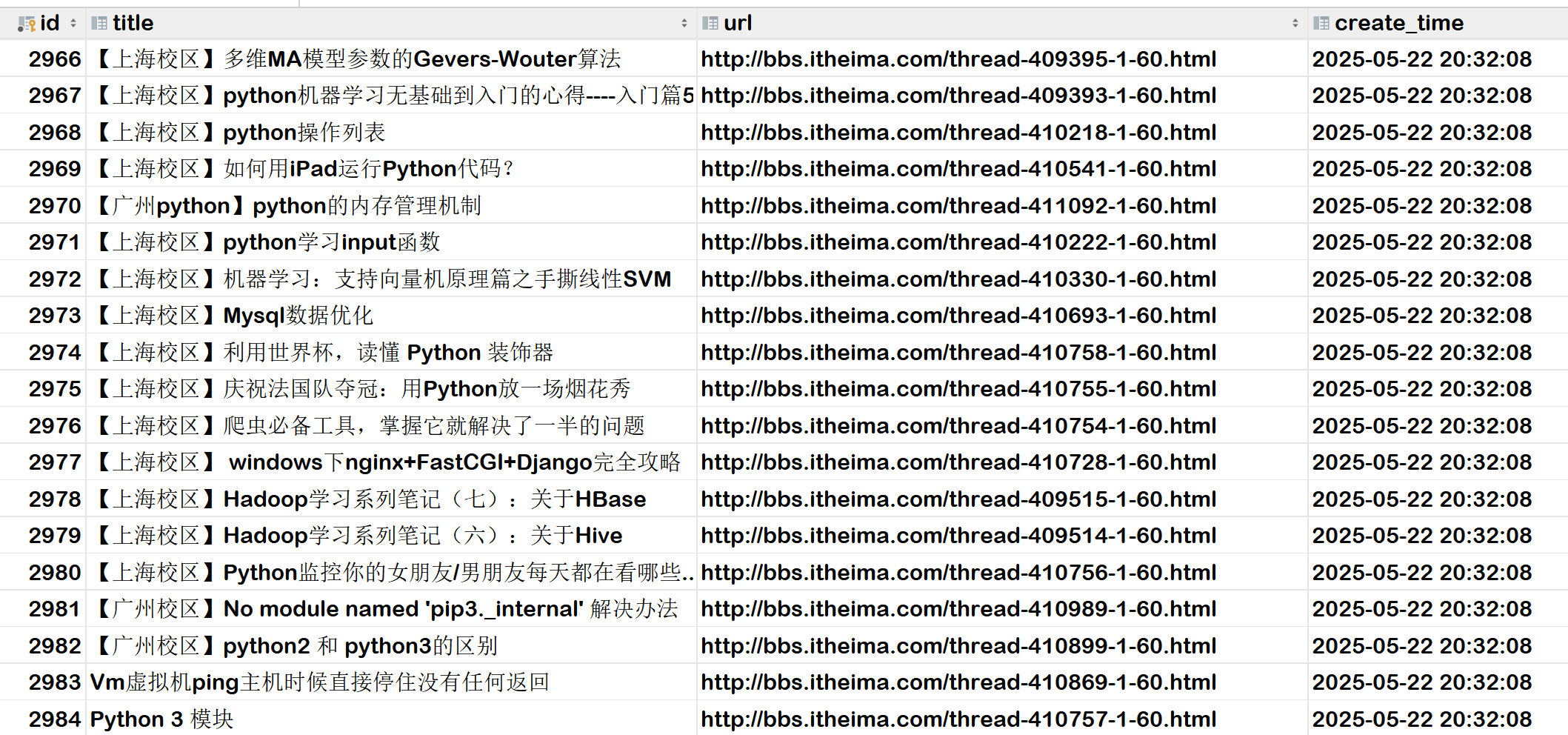

3.下载模型

去魔搭社区下载个模型来试试,网址:

魔搭社区

找个小点的模型试试

有介绍怎么下载

我选择用git安装在LLaMA-Factory文件夹下面

4.运行软件

在文件夹下执行llamafactory-cli webui,就启动了

可以看到启动成功

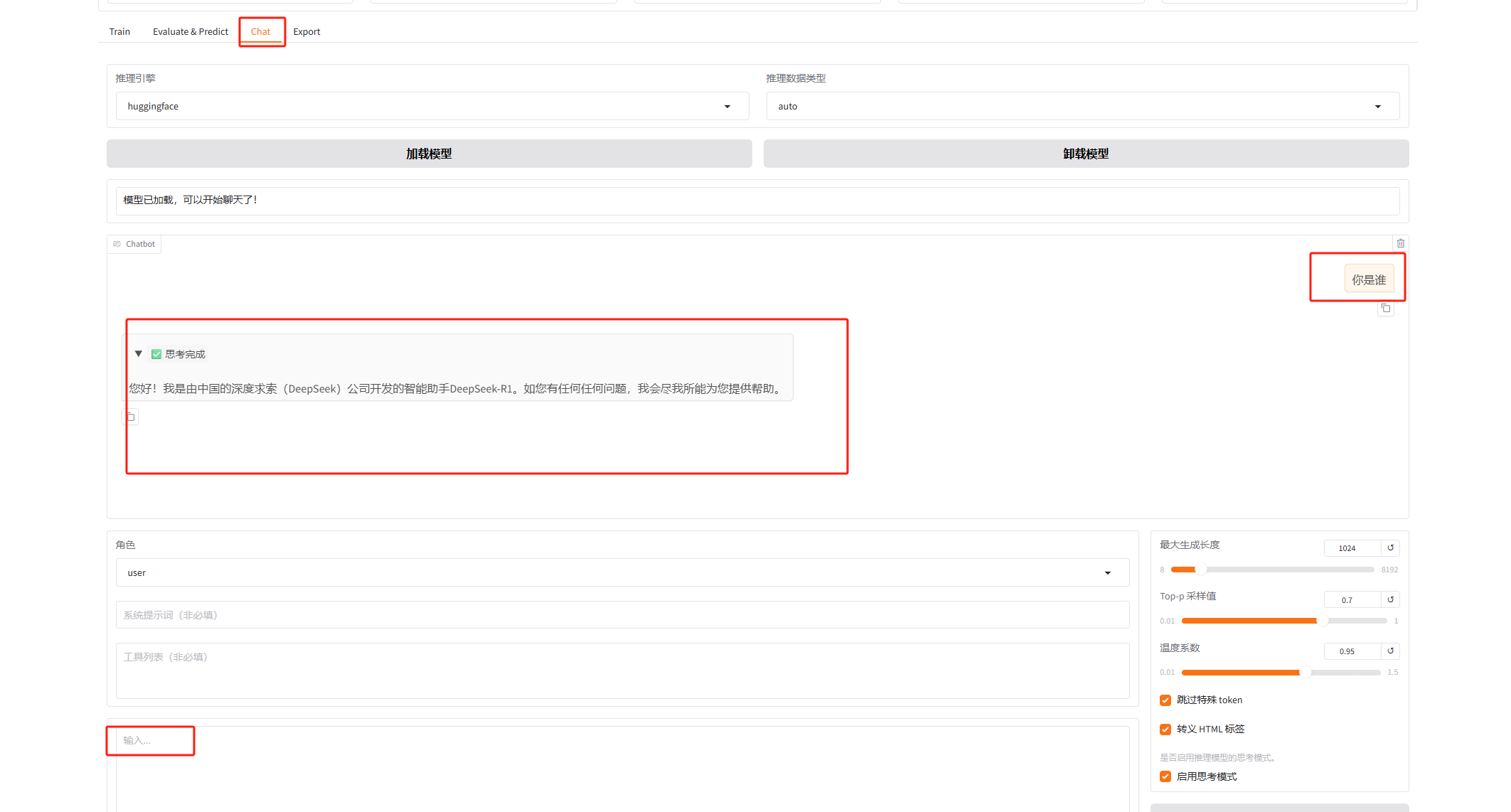

可以看到我们的模型已经加载进来了,找到chat,点击加载模型,试着聊天,没问题就说明完成了