Sigmoid与Softmax:从二分类到多分类的深度解析

news2026/2/21 13:22:05

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.coloradmin.cn/o/2377645.html

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈,一经查实,立即删除!相关文章

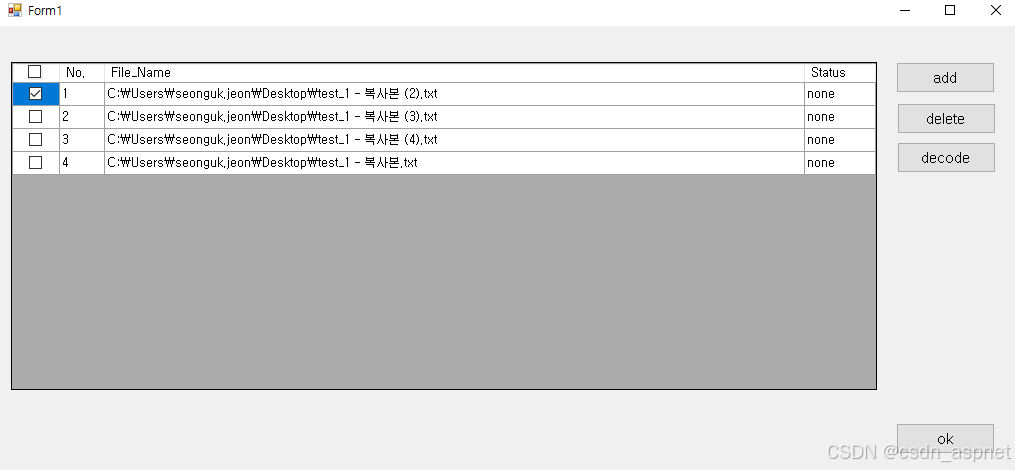

C# DataGridView 选中所有复选框

问题描述 在程序中尝试选中所有复选框,但出现错误。如果单击顶部的完整选中/释放复选框,同时选中包含复选框的列,则选定区域不会改变。该如何解决? 上面的图片是点击完整版本之后的。

下面是本文的测试代码,函数 dat…

AB Download Manager v1.5.8 开源免费下载工具

下载文件是我们日常工作和生活中经常进行的操作。面对动辄数十GB的4K影片、设计素材包或开发工具,传统浏览器的单线程下载如同"涓涓细流",非常影响我们的效率和体验。

那么,一款高效且易用的下载工具至关重要。今天就让我们解锁这…

深度剖析:Dify+Sanic+Vue+ECharts 搭建 Text2SQL 项目 sanic-web 的 Debug 实战

目录 项目背景介绍sanic-web Dify\_service handle\_think\_tag报错NoneType问题描述debug Dify调用不成功,一直转圈圈问题描述debug 前端markdown格式只显示前5页问题描述debug1. 修改代码2.重新构建1.1.3镜像3.更新sanic-web/docker/docker-compose.yaml4. 重新部…

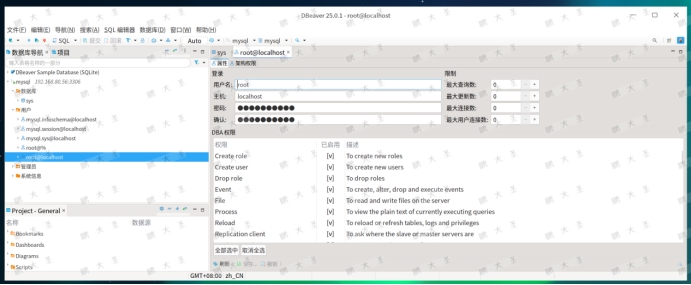

麒麟服务器操作系统安装 MySQL 8 实战指南

往期好文连接:统信UOS/麒麟KYLINOS安装JDBC驱动包

Hello,大家好啊,今天给大家带来一篇麒麟服务器操作系统上安装 MySQL 8 的文章,欢迎大家分享点赞,点个在看和关注吧!MySQL 作为主流开源数据库之一&#x…

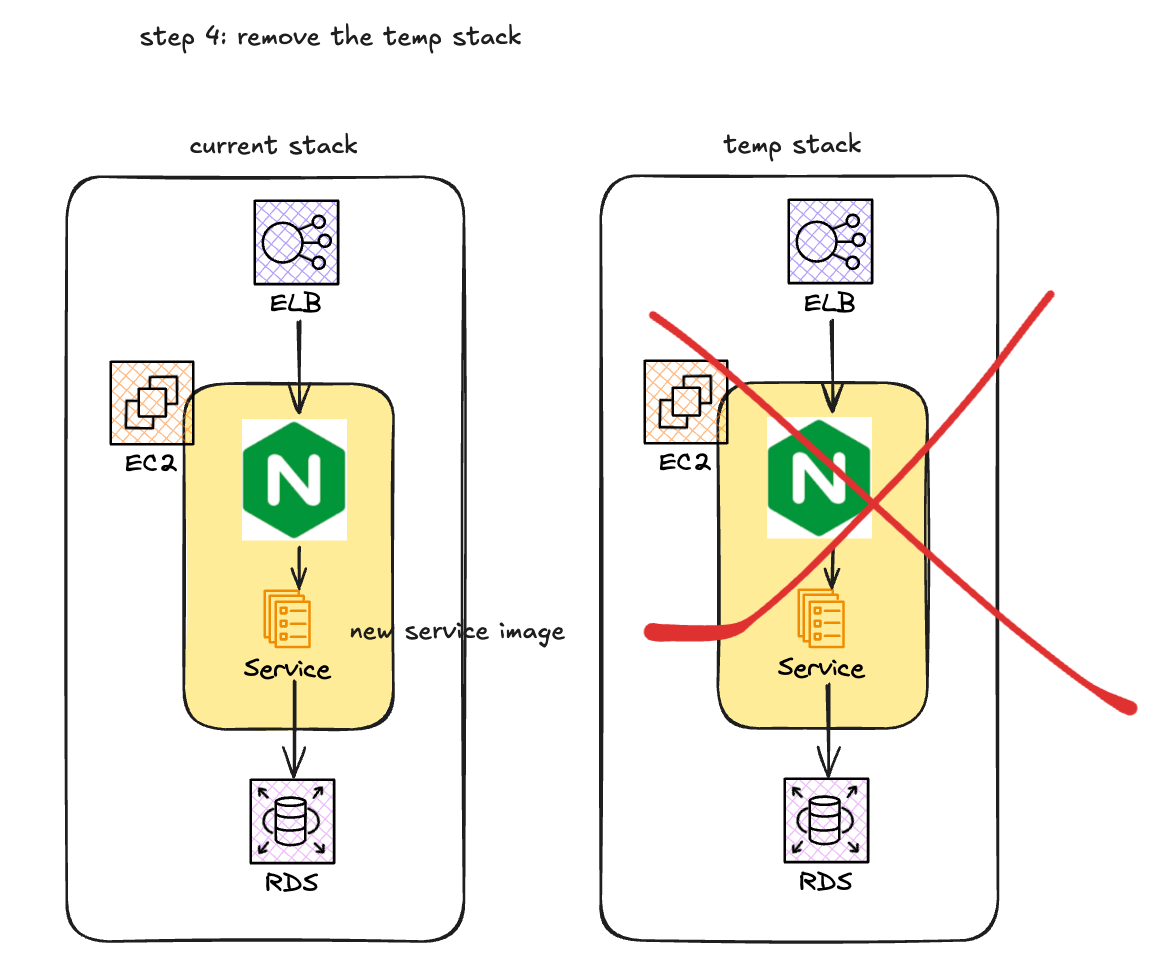

AWS EC2 微服务 金丝雀发布(Canary Release)方案

为什么需要实现金丝雀发布?

在当前项目的工程实践中, 已经有了充分的单元测试, 预发布环境测试, 但是还是会在线上环境出现非预期的情况, 导致线上事故, 因此, 为了提升服务质量, 需要线上能够有一个预验证的机制.

如何实现金丝雀发布?

使用AWS code deploy方案

AWS code…

支持蓝牙5.0和2.4G私有协议芯片-PHY6222

PHY6222QC-W04C 是一款适用于蓝牙低功耗(BLE)5.2 应用的片上系统(SoC)。它搭载 ARM Cortex™-M0 32 位处理器,配备 64KB SRAM、512K Flash、96KB ROM、256 bit efuse ,以及超低功耗、高性能的多模式射频模块…

金融合规革命:R²AIN SUITE 如何重塑银行业务智能

一、市场发展背景与核心驱动因素 信息过载:单家银行年均新增监管文件大量增加,人工解读效率极低。 客户体验升级:高净值客户期待“724小时专业级响应”,但客户经理难以实时掌握数百款产品动态。 风险防控:传…

论文阅读:Self-Collaboration Code Generation via ChatGPT

地址:Self-Collaboration Code Generation via ChatGPT

摘要

尽管大型语言模型(LLMs)在代码生成能力方面表现出色,但在处理复杂任务时仍存在挑战。在现实软件开发中,人类通常通过团队协作来应对复杂任务,…

2025年PMP 学习十五 第10章 项目资源管理

2025年PMP 学习十五 第10章 项目资源管理 序号过程过程组1规划沟通管理规划2管理沟通执行3监控沟通监控

项目沟通管理包括为确保项目的信 息及时且恰当地规划、收集、生成、发布、存储、检索、管理、控制、监 警和最终处理所需的过程; 项目经理绝大多数时间都用于与…

如何使用易路iBuilder智能体平台快速安全深入实现AI HR【实用帖】

随着企业组织经营对降本、增效、提质的需求日益迫切,越来越多企业启动人力资源数智化转型战略。而在AI战略实际推进过程中,企业组织往往在选型、搭建、使用、管控等问题上面临困惑:

如何快速、低成本接入AI能力,实现人力资源管理…

免费实用的远程办公方案

假如你需要快速检索出远程电脑文件并下载?

假如你需要访问远程电脑的共享文件夹?

假如你需要访问远程电脑的USB设备,例如软件加密狗、调试器、固件烧录器、U盘等?

本篇文章能够解决以上痛点。 这个方案非常实用,也很…

【springboot项目服务假死、内存溢出问题排查】

问题现象:springboot服务A刚启动时正常,但运行几个小时后就会接口请求无响应,但服务器网络、磁盘I/O和CPU都没有出现爆满的情况,且A服务日志没有异常报错。 线上SpringBoot假死现象 SpringBoot应用会出现无法访问的情况。具体的表…

Java 线程状态详解:从创建到销毁的完整旅途

前言

在 Java 多线程编程中,线程的状态管理是理解并发逻辑的核心。本文将用通俗的语言和代码示例,解析线程的6种状态及其转换条件,助你彻底掌握线程的生命周期。 一、线程的6种状态

状态含义NEW线程对象已创建,但未启动…

操作系统|| 虚拟内存页置换算法

题目

写一个程序来实现 FIFO 和 LRU 页置换算法。首先,产生一个随机的页面引用序列,页面数从 0~9。将这个序列应用到每个算法并记录发生的页错误的次数。实现这个算法时要将页帧的数量设为可变。假设使用请求调页。可以参考所示的抽象类。

抽象类&…

Maven 项目构建时编译错误问题排查与解决

1. 问题描述

Maven 项目执行命令 mvn clean package 时出现编译错误,如下图所示

2. 问题分析

由于是源码编译错误,于是通过查看项目 pom.xml 文件,得到项目源码使用的 Java 版本为 21

<project xmlns"http://maven.apache.org/P…

安全生产调度管理系统的核心功能模块

安全生产调度管理系统是运用现代信息技术构建的智能化管理平台,旨在实现生产安全风险的全面管控和应急资源的优化调度。该系统通过整合物联网、大数据、人工智能等前沿技术,建立起覆盖风险监测、预警预测、指挥调度、决策支持的全链条安全管理体系。

一…

Linux进程信号(一)之信号的入门

文章目录 信号入门1. 生活角度的信号2. 技术应用角度的信号3. 注意4. 信号概念5.用kill -l命令可以察看系统定义的信号列表6. 信号处理常见方式 信号入门 1. 生活角度的信号

你在网上买了很多件商品,再等待不同商品快递的到来。但即便快递没有到来,你也…