目录

1.人类对齐原理

1.1. 偏好学习(人类反馈,RLHF/DPO)

1.2. 奖励模型(AI的“打分老师”)

1.3. 价值观约束(如宪法AI)

2.如何人类对齐训练

2.1.对比学习(人类反馈 RLHF/DPO)

2.2.考试评分(奖励模型训练)

2.3.底线教育(安全防护)

2.4.持续优化(在线学习)

3.人类对齐实践

3.1.人类对齐数据集

3.2.训练代码

3.3.人类对齐训练

3.4.推理

4.如何选择模型

4.1. 模型能力(核心)

4.2. 模型规模(参数大小)

4.3. 对齐潜力(是否容易调整)

4.4. 训练资源需求

4.5. 安全与风险

4.6. 开源vs闭源

5.如何确定模型需要哪种训练

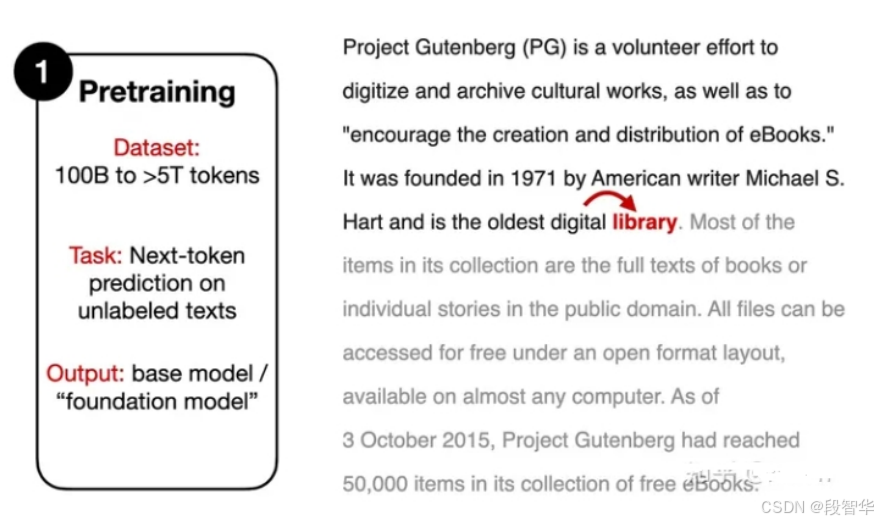

模型人类对齐(Human Alignment)旨在确保人工智能系统的行为与人类价值观、意图和社会规范保持一致。随着大语言模型等AI技术的快速发展,如何使模型输出更安全、可靠且符合人类期望成为关键挑战。对齐训练通常通过监督微调(SFT)、基于人类反馈的强化学习(RLHF)等方法实现,利用人类标注的偏好数据或指令数据优化模型响应。这一过程需解决多维度问题,例如:避免有害内容、减少偏见、提升有用性,同时平衡不同文化背景的价值观差异。对齐不仅是技术问题,更涉及伦理与社会协作,未来需持续跨学科探索,确保AI发展真正服务于人类福祉。

![[IMX] 02.GPIO 寄存器](https://i-blog.csdnimg.cn/direct/d8e69ec1a56841cc8d8dcb616936f599.png)