一、核心定义与基础概念

1. 目标追踪的定义

- 定义:在视频序列或连续图像中,对一个或多个感兴趣目标(如人、车辆、物体等)的位置、运动轨迹进行持续估计的过程。

- 核心任务:跨帧关联目标,解决“同一目标在不同帧中的对应关系”。

- 核心输入:视频序列(含帧图像、时间戳)、初始帧目标位置(单目标)或检测结果(多目标)。

2. 核心分类

按目标数量划分:

- 单目标追踪(Single Object Tracking, SOT):追踪单个已知初始位置的目标,重点处理外观变化、遮挡、尺度变化等。

典型场景:无人机跟拍、手术机器人目标追踪。 - 多目标追踪(Multi-Object Tracking, MOT):同时追踪多个未知初始关联的目标,核心是跨帧数据关联(Data Association)。

典型场景:安防监控、自动驾驶行人追踪。

按技术路线划分:

- 基于检测的追踪(Tracking-by-Detection, TBD):依赖目标检测结果,通过关联相邻帧检测框实现追踪(主流方法)。

- 端到端追踪(End-to-End Tracking):无需显式检测,直接通过网络学习目标在序列中的时空关联(如单目标中的孪生网络)。

二、单目标追踪(SOT)核心技术

1. 经典算法(2010年前)

(1)生成式方法(Generative Models)

- 核心思想:构建目标表观模型,在后续帧中搜索最匹配区域。

- 代表算法:

- Mean Shift:基于颜色直方图的局部密度估计,迭代搜索目标中心(实时性好,但易受遮挡影响)。

- 粒子滤波(Particle Filter):通过随机采样粒子表示目标状态分布,适用于非线性运动(计算复杂度高)。

(2)判别式方法(Discriminative Models)

- 核心思想:将追踪视为二分类问题(目标 vs 背景),学习区分目标与周围环境的特征。

- 代表算法:

- 相关滤波(Correlation Filter, CF)系列:

- MOSSE:基于快速傅里叶变换(FFT),实现亚像素级定位(首个实时追踪算法,300+ FPS)。

- KCF(Kernelized CF):引入核函数和循环矩阵,利用密集采样提升精度(2015年主流算法)。

- DSST/Staple:加入尺度估计和颜色空间特征(CN特征),解决尺度变化问题。

- 深度学习早期方法:

- MDNet:首个端到端深度网络,在线学习目标特定特征(应对外观剧变,但计算量大)。

- 相关滤波(Correlation Filter, CF)系列:

2. 深度学习时代(2016年至今)

(1)孪生网络(Siamese Network)

- 核心思想:通过孪生结构提取模板(初始帧目标)和搜索区域(当前帧候选区域)的特征,计算相似度匹配目标。

- 代表算法:

- SiameseFC(2016):首次将孪生网络引入追踪,使用AlexNet提取特征,实现离线训练+在线端到端匹配(开启高效追踪范式)。

- SiamRPN(2018):引入区域建议网络(RPN),预测目标边界框,提升定位精度(首次超越检测追踪方法)。

- SiamCAR(2020):基于中心点回归,避免锚框设计,提升尺度变化鲁棒性。

- 优势:离线训练无需在线学习,实时性强(50-100 FPS),适合资源受限场景(如无人机)。

(2)基于检测的单目标追踪

- 核心思想:结合目标检测和运动模型,逐帧定位目标。

- 代表算法:

- ATOM(2019):分离目标分类和边界框回归,使用IoUNet优化定位精度。

- TransT(2021):首个引入Transformer的追踪算法,建模目标全局上下文关系,解决复杂遮挡。

(3)在线学习与适应

- 关键问题:目标外观随时间变化(如光照、姿态),需在线更新模型。

- 解决方案:

- 增量学习:定期用当前帧目标更新模板(如DaSiamRPN)。

- 元学习(Meta-Learning):预训练模型快速适应新目标(如TAML)。

3. 关键技术点

(1)目标表示

- 外观特征:

- 手工特征:HOG、CN(颜色名称)、LBP(适用于早期轻量模型)。

- 深度特征:ResNet、Swin Transformer(提取语义和空间细节,抗遮挡能力强)。

- 多模态融合:结合RGB、红外、深度信息(提升夜间或复杂光照追踪效果)。

(2)尺度与姿态变化

- 尺度估计:构建多尺度金字塔(如DSST)或回归尺度因子(SiamRPN++)。

- 姿态鲁棒性:引入形变建模(如形变卷积)或注意力机制(聚焦目标关键部位)。

(3)遮挡处理

- 短期遮挡:依赖运动模型预测位置(如卡尔曼滤波),结合表观模型恢复(如相关滤波保留历史模板)。

- 长期遮挡:目标消失后重新检测(需与多目标追踪的重识别结合,如引入Re-ID特征)。

三、多目标追踪(MOT)核心技术

1. 经典框架:检测+数据关联

(1)目标检测前置

- 依赖:YOLO、Faster R-CNN、DETR等检测器提供各帧检测框(含类别、置信度、位置)。

- 挑战:检测漏检、误检直接影响追踪精度(需结合追踪结果反向优化检测,如Tracklet拼接)。

(2)数据关联(核心模块)

- 任务:将当前帧检测框与历史轨迹(Track)匹配,解决“同一目标跨帧对应”。

- 方法分类:

- 运动关联(短期匹配):

- 卡尔曼滤波(Kalman Filter):建模目标运动状态(位置、速度),预测下一帧位置,计算检测框与预测框的IoU相似度(如SORT算法)。

- 匈牙利算法(Hungarian Algorithm):求解二分图匹配最优解,处理多对多匹配问题(复杂度O(n³),n为目标数)。

- 外观关联(长期匹配):

- Re-ID特征:提取目标外观嵌入(如ResNet+Triplet Loss训练),计算余弦相似度(解决长时间遮挡后的重识别,如DeepSORT)。

- 时空特征融合:结合运动距离(如马氏距离)和外观距离,构建联合相似度矩阵(主流方法)。

- 运动关联(短期匹配):

(3)轨迹管理

- 轨迹初始化:新检测框创建新轨迹(需设置置信度阈值避免噪声)。

- 轨迹终止:连续N帧未匹配则终止(N=3-5,平衡漏检和虚警)。

- 轨迹碎片化处理:通过全局轨迹优化(如图优化、动态规划)连接断裂轨迹(如TrackEval中的MOTA指标优化)。

2. 主流算法演进

(1)传统方法(2015年前)

- SORT(2016):仅用IoU和匈牙利算法做短期匹配,实时性强(200+ FPS),但长期遮挡易丢失。

- DeepSORT(2017):加入Re-ID外观特征,提升长期追踪精度(MOTA提升10%+),成为多目标追踪基准框架。

(2)端到端深度学习方法(2018年后)

- JDE(2019):首个联合检测与追踪(Joint Detection and Embedding)模型,共享检测和Re-ID特征提取网络,提升效率(50 FPS,适合实时场景)。

- CenterTrack(2020):基于中心点检测(CenterNet),无需锚框,直接回归目标中心点和尺寸,简化关联计算(对密集目标更鲁棒)。

- TransTrack(2021):引入Transformer建模跨帧目标交互,捕捉长程依赖关系(如多目标遮挡时的全局关联)。

(3)无检测追踪(新兴方向)

- 基于分割的追踪(Tracking-by-Segmentation, TbS):结合实例分割(如Mask R-CNN),解决外观相似目标区分问题(如多行人追踪中的衣物颜色相近场景)。

- 自监督学习:利用无标签视频数据预训练关联模型(降低对人工标注的依赖,如MOTR3D)。

3. 关键技术点

(1)复杂场景处理

- 密集目标:高重叠率下的ID切换(需增强Re-ID特征判别力,如引入局部特征聚合)。

- 相似目标:利用运动模式差异(如行人步态、车辆行驶轨迹)辅助关联。

- 跨摄像头追踪(Multi-Camera MOT):解决不同视角、光照下的目标匹配,需额外校准相机参数和空间映射。

(2)评价指标

- 单目标追踪:

- 成功率(Success Rate):预测框与真值IoU≥0.5的帧占比。

- 精度(Precision Rate):预测中心与真值中心的平均像素距离。

- 多目标追踪:

- MOTA(Multiple Object Tracking Accuracy):综合考虑漏检、误检、ID切换,范围0-100%(越高越好)。

- IDF1(ID F1-Score):追踪ID与真值的匹配准确率,反映ID稳定性。

四、共性关键技术

1. 运动建模

- 线性模型:卡尔曼滤波(适用于匀速/匀加速运动,如公路车辆追踪)。

- 非线性模型:粒子滤波、交互式多模型(IMM,适应突然变向,如行人随机运动)。

- 深度学习建模:通过LSTM、图神经网络(GNN)学习目标运动规律(捕捉复杂交互,如人群中的相互遮挡)。

2. 实时性优化

- 模型轻量化:使用MobileNet、GhostNet替代ResNet,减少计算量(如YOLO-Track在嵌入式设备上达100 FPS)。

- 推理加速:模型量化(FP32→INT8)、剪枝、神经架构搜索(NAS)。

- 并行计算:利用GPU/TPU的并行处理能力,优化数据关联算法(如批处理匈牙利算法)。

3. 长期追踪与鲁棒性

- 目标重检测:当轨迹丢失时,触发全局搜索(如在全图重新检测目标类别,结合Re-ID恢复轨迹)。

- 记忆机制:存储目标历史外观模板(如最近5帧特征),应对外观突变(如换衣服、戴口罩)。

五、典型应用场景

1. 安防监控

- 需求:多目标实时追踪、跨摄像头轨迹关联、异常行为检测(如徘徊、聚集)。

- 挑战:复杂光照(夜晚红外追踪)、低分辨率(需超分辨率重建辅助)。

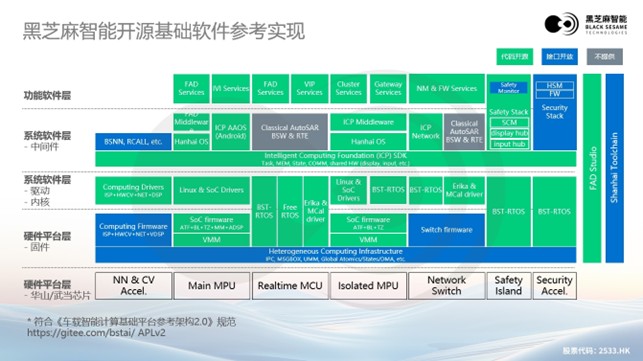

2. 自动驾驶

- 需求:车辆、行人、非机动车实时追踪,提供决策输入(如碰撞预警)。

- 技术:融合雷达点云与视觉数据(解决遮挡和低光照问题),低延迟模型(≤50ms延迟)。

3. 无人机与机器人

- 需求:单目标精准跟拍(如无人机跟拍运动员)、多目标避障(机器人集群协作)。

- 关键:轻量化模型(适应无人机有限算力),抗运动模糊(无人机高速飞行时图像模糊)。

4. 体育与娱乐

- 应用:运动员动作分析(轨迹追踪辅助战术评估)、虚拟主播追踪(实时驱动3D模型)。

- 技术:高精度姿态估计与轨迹关联(如OpenPose+DeepSORT)。

六、当前挑战与未来方向

1. 核心挑战

- 复杂遮挡:密集场景下目标长时间遮挡导致ID频繁切换(如早高峰十字路口)。

- 外观剧变:目标视角、光照、尺度快速变化(如自动驾驶中前车突然变道近景)。

- 计算资源限制:嵌入式设备(如手机、无人机)难以运行高算力模型。

- 跨模态对齐:多传感器(视觉、雷达、激光)数据时空同步误差(影响融合精度)。

2. 前沿研究方向

(1)模型架构创新

- Transformer与GNN:建模目标全局依赖关系(如TransTrack处理多目标交互)。

- 自监督/半监督学习:利用海量无标签视频数据预训练(减少人工标注成本,如MoCo追踪模型)。

(2)多技术融合

- 多模态融合:视觉+IMU+UWB定位,提升复杂环境鲁棒性(如AR设备目标追踪)。

- 检测-追踪-分割一体化:端到端模型同时输出检测框、轨迹ID、分割掩码(如TrackFormer)。

(3)轻量化与实时性

- 神经架构搜索(NAS):自动设计适合移动端的追踪模型(如MobileSiamNet)。

- 在线自适应:动态调整模型复杂度(如根据目标数量切换轻量/高精度模式)。

(4)跨领域拓展

- 3D目标追踪:自动驾驶中的3D空间轨迹预测(需处理点云与图像融合,如CenterPoint)。

- 长视频追踪:跨数小时视频的目标轨迹拼接(需解决长时间外观变化和跨摄像头关联)。

七、总结

目标追踪是计算机视觉的核心任务,从单目标的精准定位到多目标的全局关联,技术路线涵盖传统算法到深度学习,应用场景渗透安防、交通、机器人等领域。未来发展将聚焦于鲁棒性、实时性、多模态融合,以及与3D视觉、大模型的结合,推动从“追踪目标”到“理解目标行为”的跨越。