本文只针对图进行解释重要内容 这就是入门所需要掌握的大部分内容

对于不懂的名词或概念 你可以及时去查

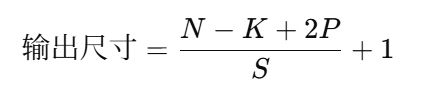

对于层数 标在上面 对于该层的第几个元素 标在下面 输入层算作第0层

对于第一层的w b 参数

维度如下w:4*3 b:4*1

这个叫做神经元 比如对于第一层的神经元

这里说的很清楚了 首先计算z 然后通过激活函数 计算出a

解释一下

为什么是四个w 因为第一层对应着四个神经元

比如w1对应第一层a11 w1的维度应该是(1,3)这与第0层的三个输入相对应 以计算三个输入对于a11的影响

而这样的神经元在第一层有四个 所以W的维度是(4*3)

激活函数并不会改变维度

这是对于多样本的书写方式

对于多样本 W是不需要改变的

W的维度是(4*3) 当我们的X变成多样本之后维度是(n,m) 这里n是3 依然可以和W维度匹配

这里的物理意义就是 对于第i个样本 可以通过W去调整你的参数

但你要知道最后的W是该特征m个输入样本的平均值决定的

这里确实很难理解 可以参考下图理解

对于激活函数 不只有relu 和sigmoid 很有很多其他的比如leaky relu tanh

曲线如下

为什么要激活函数 因为需要非线性 对于无限次的线性叠加 还是线性 这是无意义的

这个很好理解

与逻辑回归类似

注意的关键点是

W参数是M个样本的平均值 这里也有体现

对b参数是M个样本的平均值 得到一个常数

对于dz1的求解 把正向传播的1式代入3式可以看出

随机初始化

W的初始值不能全是0

这导致了隐藏层对称 进而隐藏层个数多也没有意义

训练多少次两个神经元都是相同的

所以随机初始化 一般是高斯分布