文章目录

- The Platonic Representation Hypothesis

- 概述

- 表征收敛的依据

- 表征收敛的原因

- 实验依据

- 未来发展的局限性

- Similarity of Neural Network Representations Revisited

- 概述

- 问题背景

- 相似性度量s的性质

- 可逆线性变换不变性

- 正交变换不变性

- 各向同性缩放不变性

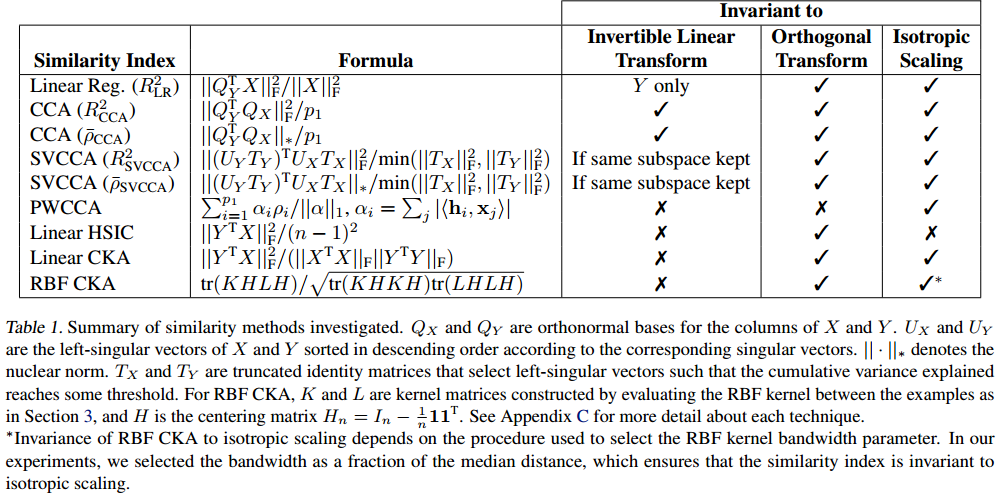

- 典型度量满足的性质

- 中心核对齐(CKA)

- 核心思想

- 数学表示

- 点积相似性

- 线性回归

- Hilbert-Schmidt Independence Criterion (HSIC):

- 典型相关分析(CCA)

- CKA的原理和关联

The Platonic Representation Hypothesis

原文链接

概述

论文提出了柏拉图表征假设(Platonic Representation Hypothesis),认为随着AI模型(特别是深度神经网络)的规模、数据和任务多样性增加,不同模型的表征方式正在收敛到一个共享的、反映现实统计模型的表征,称之为柏拉图表征。这种表征类似于柏拉图《洞穴寓言》中描述的理想现实,捕捉了生成观测数据的世界事件联合分布。

表征收敛的依据

(1)单模态收敛:不同架构、训练目标和数据集的神经网络表征趋于对齐。例如,研究通过模型拼接(model stitching)和核对齐度量(如CKA、互近邻)发现,训练于ImageNet和Places-365的视觉模型具有相似的表征。

(2)跨模态收敛:视觉模型和语言模型的表征在更大规模和更高性能下趋于对齐。例如,使用Wikipedia图像-文本数据集(WIT)测量,性能更强的语言模型与视觉模型的表征对齐度更高。

(3)与现实的对齐:神经网络的表征与人类视觉系统的表征表现出一致性,可能是因为两者面临相似的任务和数据约束。表征对齐度与下游任务性能(如Hellaswag、GSM8K)正相关,表明对齐的表征更接近现实的统计模型。

表征收敛的原因

随着数据和任务的扩展,满足这些约束的表示量必须按比例变小,模型被迫学习更通用的表征(Contravariance principle)

数据规模和模型性能之间存在幂律关系(Hestness等人,2017)。这意味着,有了足够的数据,表征应该收敛到一个具有不可约误差的非常小的解集。

多任务目标可能比单任务目标(例如ImageNet分类)更有效,因为它们对表示施加了更多的任务约束,导致更小、更高质量的解决方案空间

对比学习目标(如InfoNCE)通过学习点互信息(PMI)捕获数据间的统计结构,促进表征对齐现实分布。

一些假说:

(1)简单性偏差假说:较大的模型对拟合相同数据的所有可能方法的覆盖范围更大。然而,深度网络的隐含简单性偏差鼓励更大的模型找到这些解决方案中最简单的一个。

(2)容量假说:与较小的模型相比,较大的模型更有可能收敛到共享表示。

(3)Occam’s razor:如果有两个模型都能解释数据,优先选择更简单的那个(参数更少、假设更少)。简单模型通常泛化能力更强,减少过拟合风险。

实验依据

(1)视觉-视觉对齐实验 (Vision-Vision Alignment):验证不同视觉模型的表示是否趋同,以及这种趋同是否与模型性能相关。

(2)跨模态对齐实验 (Cross-Modal Alignment):验证视觉模型和语言模型的表示是否趋同,以及这种对齐是否随着模型性能提升而增强。

(3)颜色共现实验 (Color Cooccurrence Experiment):验证视觉和语言模型是否通过共现关系学习到相似的表示,具体以颜色表示为例。

(4)字幕密度实验 (Caption Density Experiment):验证更密集的图像字幕是否提高视觉-语言表示对齐。

未来发展的局限性

(1)模态差异:不同模态的传感器可能捕捉不同信息(如触觉无法捕捉颜色),可能限制完全趋同。

(2)任务特定性:某些任务可能需要特定的表示,阻碍通用表示的形成。

(3)实际约束:现实中数据和计算资源的有限性可能限制模型逼近柏拉图表示。

Similarity of Neural Network Representations Revisited

原文链接

概述

论文主要探讨了如何比较和分析深度神经网络的表示(representations),提出了一种新的相似性度量方法——中心核对齐(Centered Kernel Alignment, CKA),并将其与传统方法如canonical correlation analysis (CCA)进行了对比。

问题背景

给定两个神经网络的激活矩阵 X ∈ R n × p 1 X \in \mathbb{R}^{n\times p_1} X∈Rn×p1, Y ∈ R n × p 2 Y \in \mathbb{R}^{n\times p_2} Y∈Rn×p2, n n n是样本数, p 1 , p 2 p_1, p_2 p1,p2是神经元数。假设矩阵已中心化且 p 1 ≤ p 2 p_1 \le p_2 p1≤p2,目标是设计和分析一个标量相似性度量 s ( X , Y ) s(X, Y) s(X,Y),用于比较神经网络内部和跨网络的表示,以帮助可视化和理解深度学习中不同变因的影响。

相似性度量s的性质

在探索最合理的度量 s s s的过程中,科学家提出了许多 s s s应满足的性质的假设,并基于此提出了许多理论。然而,这些理论都有一定的局限性。

可逆线性变换不变性

定义:若相似性度量 s ( X , Y ) = s ( X A , Y B ) s(X,Y) = s(XA,YB) s(X,Y)=s(XA,YB),其中 A , B A,B A,B是任意满秩矩阵,则该度量对可逆线性变换不变。

直观理解:在全连接层 f ( X ) = σ ( X W + β ) f(X) = \sigma(XW+\beta) f(X)=σ(XW+β)中,激活 X X X右乘可逆矩阵 A A A,同时权重 W W W左乘 A − 1 A^{-1} A−1,不会改变网络输出。因此,某些研究(如Raghu et al., 2017)认为相似性度量应对可逆线性变换不变。

局限性:当表示维度 p ≥ n p \ge n p≥n时,度量无法区分高维表示的差异。许多神经网络(尤其是卷积网络)的层神经元数量远超训练数据点数量(如Springenberg et al., 2015);此外,神经网络训练对输入或激活的线性变换敏感。例如,梯度下降首先沿输入协方差矩阵的最大特征值方向收敛(LeCun et al., 1991),批归一化(Ioffe & Szegedy, 2015)也表明尺度信息对训练至关重要。因此,忽略尺度信息的度量(如CCA)会丢失关键信息。

正交变换不变性

定义:若

s

(

X

,

Y

)

=

s

(

X

U

,

Y

V

)

s(X, Y)=s(XU, YV)

s(X,Y)=s(XU,YV),其中

U

,

V

U, V

U,V是正交矩阵(满足

U

T

U

=

I

U^TU=I

UTU=I),则度量对正交变换不变。

解决的问题:

(1)正交变换保留欧几里得距离和标量积,适合捕捉表示的几何结构。

(2)当表示维度

p

≥

n

p \ge n

p≥n时,正交变换不变的度量仍然有效,克服了可逆线性变换不变性的局限。

(3)正交变换不变性包含排列不变性,适应神经网络的对称性(Chen et al., 1993)。

将

X

,

Y

X,Y

X,Y进行QR分解,即

X

=

Q

X

R

X

,

Y

=

Q

Y

R

Y

X = Q_XR_X, Y=Q_YR_Y

X=QXRX,Y=QYRY,

Q

∈

R

n

×

p

Q \in \mathbb{R}^{n \times p}

Q∈Rn×p是列正交矩阵(

Q

T

Q

=

I

Q^TQ=I

QTQ=I),

R

X

∈

R

p

×

p

R_X \in \mathbb{R}^{p \times p}

RX∈Rp×p是上三角矩阵。

我们可以构造新度量

s

′

(

X

,

Y

)

=

s

(

Q

X

,

Q

Y

)

s'(X,Y)=s(Q_X, Q_Y)

s′(X,Y)=s(QX,QY),则

s

′

s'

s′具有可逆线性变换不变性。

各向同性缩放不变性

定义:若

s

(

X

,

Y

)

=

s

(

α

X

,

β

Y

)

s(X, Y)=s(\alpha X, \beta Y)

s(X,Y)=s(αX,βY),其中

α

,

β

∈

R

+

\alpha, \beta \in \mathbb{R}^{+}

α,β∈R+,则度量对各向同性缩放不变。

直观理解:各向同性缩放仅改变表示的整体尺度,不影响其相对结构,因此度量应对其不变。

若度量同时对正交变换和非各向同性缩放(即特征维度的独立缩放)不变,则等价于对可逆线性变换不变(由奇异值分解可推导)。因此,论文关注对各向同性缩放不变但对非各向同性缩放敏感的度量。

典型度量满足的性质

中心核对齐(CKA)

核心思想

论文提出与其直接比较两个表示 X ∈ R n × p 1 X \in \mathbb{R}^{n \times p_1} X∈Rn×p1和 Y ∈ R n × p 2 Y \in \mathbb{R}^{n \times p_2} Y∈Rn×p2的特征向量,不如比较它们各自的表示相似性矩阵(RSMs),即样本间的内积矩阵 X X T XX^T XXT和 Y Y T YY^T YYT。这种方法受神经科学的启发(Kriegeskorte et al., 2008a),通过样本间的相似性结构间接比较表示。

数学表示

点积相似性

样本间内积矩阵的元素 ( X X T ) i j (XX^T)_{ij} (XXT)ij表示第 i i i个样本和第 j j j个样本在表示 X X X中的相似性。比较 X X T XX^T XXT和 Y Y T YY^T YYT的相似性等价于比较特征间的内积:

⟨ vec ( X X ⊤ ) , vec ( Y Y ⊤ ) ⟩ = tr ( X X ⊤ Y Y ⊤ ) = ∥ Y ⊤ X ∥ F 2 \left\langle\operatorname{vec}\left(X X^{\top}\right), \operatorname{vec}\left(Y Y^{\top}\right)\right\rangle=\operatorname{tr}\left(X X^{\top} Y Y^{\top}\right)=\left\|Y^{\top} X\right\|_{F}^{2} ⟨vec(XX⊤),vec(YY⊤)⟩=tr(XX⊤YY⊤)= Y⊤X F2

其中 ∣ ∣ ⋅ ∣ ∣ F ||\cdot||_F ∣∣⋅∣∣F是Frobenius范数。

线性回归

R LR 2 = ∥ X ^ − X ∥ F 2 ∥ X ∥ F 2 R_{\text{LR}}^2 = \frac{\|\hat{X} - X\|_F^2}{\|X\|_F^2} RLR2=∥X∥F2∥X^−X∥F2

其中

X

^

\hat{X}

X^是

Y

Y

Y对

X

X

X的线性拟合。

局限性:不对称,仅衡量单向拟合能力;对正交变换和各向同性缩放不变,但忽略双向相似性。

Hilbert-Schmidt Independence Criterion (HSIC):

HSIC(Gretton et al., 2005)是衡量两个核矩阵 K K K和 L L L相关性的统计量。对于线性核 K = X X T K=XX^T K=XXT和 L = Y Y T L=YY^T L=YYT,HSIC为:

HSIC ( K , L ) = 1 ( n − 1 ) 2 t r ( K H L H ) \text{HSIC}(K,L)=\frac{1}{(n-1)^2}tr(KHLH) HSIC(K,L)=(n−1)21tr(KHLH)

其中

H

n

=

I

n

−

1

n

1

1

T

H_n=I_n - \frac{1}{n}11^T

Hn=In−n111T是中心化矩阵。

对中心化的

X

X

X和

Y

Y

Y,HSIC等价于跨协方差矩阵的Frobenius范数的平方:

HSIC ( K , L ) = ∥ cov ( X ⊤ , Y ⊤ ) ∥ F 2 \text{HSIC}(K,L)=\left\|\text{cov}(X^{\top}, Y^{\top})\right\|_{F}^{2} HSIC(K,L)= cov(X⊤,Y⊤) F2

典型相关分析(CCA)

R CCA 2 = ∑ i = 1 p 1 ρ i 2 p 1 = ∥ Q Y ⊤ Q X ∥ F 2 p 1 , ρ ~ CCA = ∑ i = 1 p 1 ρ i p 1 = ∥ Q Y ⊤ Q X ∥ ∗ p 1 R_{\text{CCA}}^2 = \frac{\sum_{i=1}^{p_1} \rho_i^2}{p_1} = \frac{\|Q_Y^\top Q_X\|_F^2}{p_1}, \quad \tilde{\rho}_{\text{CCA}} = \frac{\sum_{i=1}^{p_1} \rho_i}{p_1} = \frac{\|Q_Y^\top Q_X\|_*}{p_1} RCCA2=p1∑i=1p1ρi2=p1∥QY⊤QX∥F2,ρ~CCA=p1∑i=1p1ρi=p1∥QY⊤QX∥∗

其中

ρ

i

\rho_i

ρi是典型相关性(canonical correlations),

∥

⋅

∥

∗

\|\cdot\|_*

∥⋅∥∗是核范数。

局限性:对可逆线性变换不变,忽略尺度信息;在高维表示或条件数大时不稳定(Golub & Zha, 1995)。

变体SVCCA通过截断奇异值分解保留固定方差比例的成分(Raghu et al., 2017),仅在保留子空间不变时对可逆线性变换不变,但仍受限于CCA的本质。

变体PWCCA对CCA进行加权,与线性回归密切相关,但不对称且鲁棒性有限。

ρ PW = ∑ i = 1 c α i ρ i ∑ i = 1 c α i , α i = ∑ j ∣ ⟨ h i , x j ⟩ ∣ \rho_{\text{PW}} = \frac{\sum_{i=1}^c \alpha_i \rho_i}{\sum_{i=1}^c \alpha_i}, \quad \alpha_i = \sum_j |\langle \mathbf{h}_i, \mathbf{x}_j \rangle| ρPW=∑i=1cαi∑i=1cαiρi,αi=∑j∣⟨hi,xj⟩∣

CKA的原理和关联

HSIC对各向同性缩放不不变,因此通过归一化得到CKA:

CKA ( K , L ) = HSIC ( K , L ) HSIC ( K , K ) HSIC ( L , L ) \text{CKA}(K, L) = \frac{\text{HSIC}(K, L)}{\sqrt{\text{HSIC}(K,K)\text{HSIC}(L, L)}} CKA(K,L)=HSIC(K,K)HSIC(L,L)HSIC(K,L)

CKA的值在

[

0

,

1

]

[0,1]

[0,1]内,1表示完全相似,0表示完全不相似。

对于线性核,CKA等价于:

CKA ( X X ⊤ , Y Y ⊤ ) = ∥ Y ⊤ X ∥ F 2 ∥ X ⊤ X ∥ F ∥ Y ⊤ Y ∥ F \text{CKA}(XX^\top, YY^\top) = \frac{\|Y^\top X\|_F^2}{\|X^\top X\|_F \|Y^\top Y\|_F} CKA(XX⊤,YY⊤)=∥X⊤X∥F∥Y⊤Y∥F∥Y⊤X∥F2

当 X X X与 Y Y Y中心化时,CKA与CCA有以下关系:

R CCA 2 = CKA ( Q X Q X ⊤ , Q Y Q Y ⊤ ) p 2 p 1 R_{\text{CCA}}^2 = \text{CKA}(Q_X Q_X^\top, Q_Y Q_Y^\top) \sqrt{\frac{p_2}{p_1}} RCCA2=CKA(QXQX⊤,QYQY⊤)p1p2

CKA通过特征值加权(反映方差贡献)改进了CCA,强调重要子空间的作用。

线性回归 R L R 2 R^2_{LR} RLR2与CKA的关系为:

R LR 2 = CKA ( X X ⊤ , Q Y Q Y ⊤ ) p 1 ∥ X ⊤ X ∥ F ∥ X ∥ F 2 R_{\text{LR}}^2 = \text{CKA}(XX^\top, Q_Y Q_Y^\top) \frac{\sqrt{p_1} \|X^\top X\|_F}{\|X\|_F^2} RLR2=CKA(XX⊤,QYQY⊤)∥X∥F2p1∥X⊤X∥F

CKA对称地处理两个表示,而线性回归是不对称的。

CKA的优越性有:

(1)对称性:平等对待两个表示。

(2)加权机制:通过特征值加权,强调重要子空间。

(3)灵活性:支持线性核和非线性核(如RBF核),适应不同表示结构。

(4)鲁棒性:在高维表示和数据点不足时仍有效。

(5)实践:实验证明,CKA能可靠识别不同初始化、不同架构和不同数据集下网络层的对应关系,准确率接近99%。

![Vue3 + TypeScript,关于item[key]的报错处理方法](https://i-blog.csdnimg.cn/direct/27de1eb52d7d48ccab56a9f035156e49.png)