育人为本,国之根本,高校从理论教学到实操教学,从教室到实验室,改变了传统的教学模式,以数据的力量塑造新技术型高科技人才。随着科研项目多元化与数据量的增多,对计算速度与存储空间的要求不断提升,在科研式教学模式的驱动下,创建一个高效可靠的数据计算平台,成为高校信息发展的重中之重。近十年来,HPC在高校学术研究和创新科研人才培养中扮演着重要角色。帮助金融、物理、生物、天文、气象、化学、数学等院系的科研提供了高效的计算能力。

针对高校科研不同的应用环境,HPC对应的存储解决方案也多种多样。有适用于大型密集型数据计算的StorNext/Lustre HPC高性能解决方案;适用于小组科研的NAS HPC高性能解决方案。所以应用在高校科研的HPC存储,应以科研需求的带宽、容量及预算为出发点,提供各种性能、容量、数据安全的解决方案,帮助高校选择适配的HPC存储产品,助力科研人员通过高效的数据分析验证研究理论。下面我们就以Infortrend存储为例,来分析HPC存储应如何在高校科研部署,及实施相应的方案。

方案一:Block存储大型密集型数据计算HPC

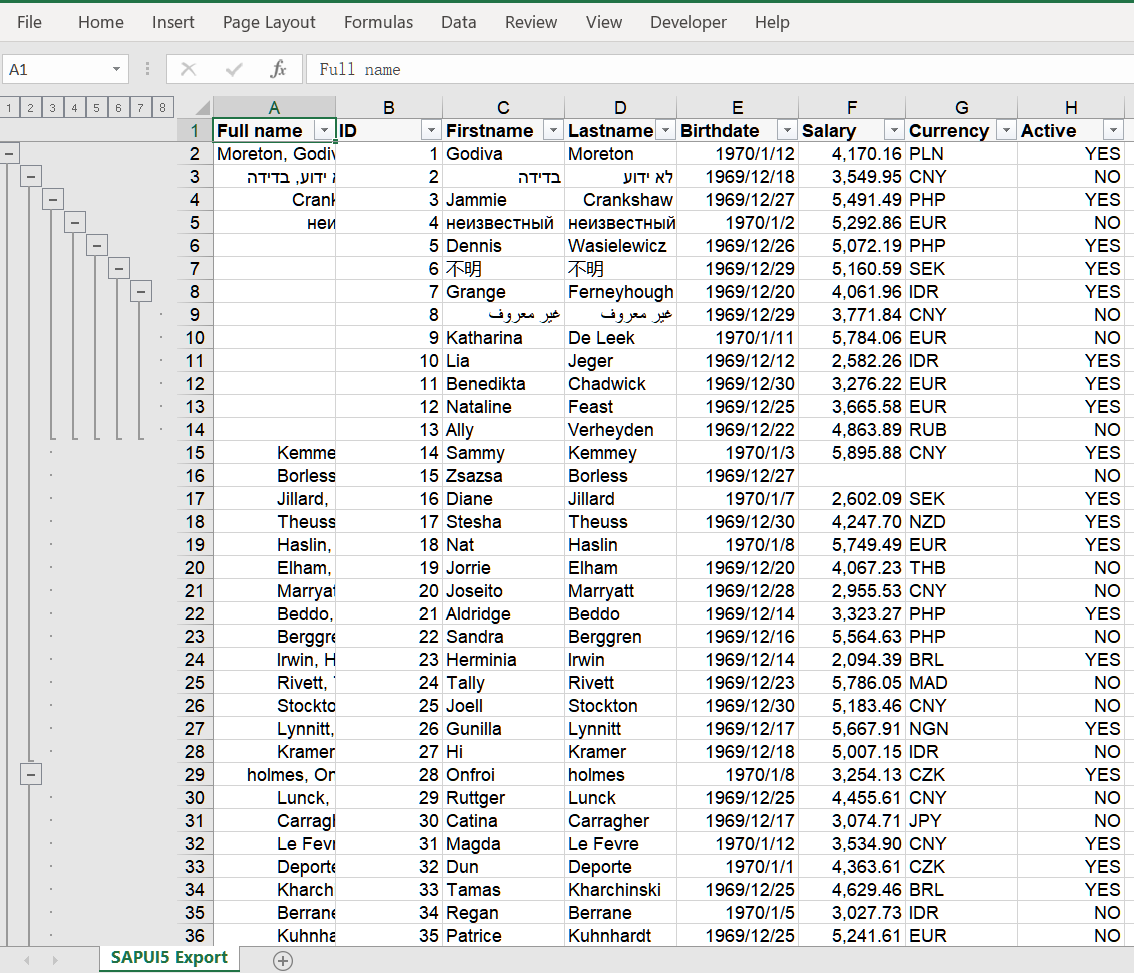

该存储解决方案(GS G3/GS U.2)支持Lustre并行文件系统进行HPC高性能计算,提供持续稳定10GB—900GB超高读写带宽及PB级存储空间,为客户提供统一的高性能、大数据计算和存储服务。适合数据量极大,需要超高的存储性能作为运算支撑,并且数据量持续增长的科研项目,如物理,天文、气象、生物研究。此方案通过25-100GbE RDMA或56-200Gb IB低延迟计算网络结构,单个节点提供 12GB/s的写、22GB /s的读、10GB—900GB超高读写带宽,可以用数分钟就完成以往需要数天才能完成的计算工作。高密机型(4U60/90盘位)容量大,60颗18TB硬盘既可提供1PB存储容量,而且多台存储节点可通过Lustre系统绑定,进行扩容应对业务增长。Lustre开源并行文件系统支持使用Linux系统开发平台的科研项目或高校科研机构,通过Lustre开源并行文件系统,建立统一的HPC公共计算平台,可以提供超高的HPC计算能力。

方案二:Block存储大型密集型数据计算HPC(II)

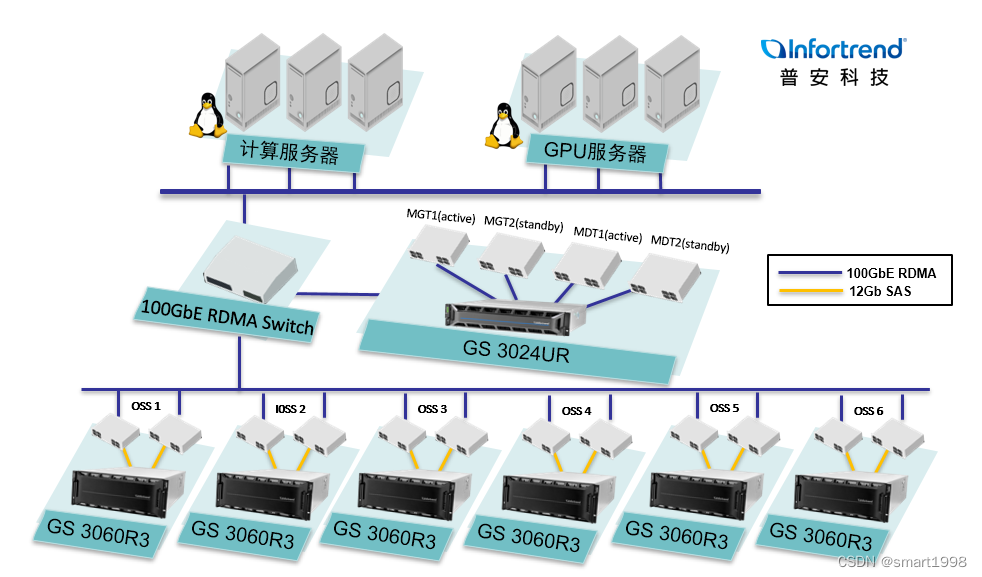

该存储解决方案(GS)也支持StorNext并行文件系统进行密集型HPC计算计算,StorNext作为付费并行文件系统,能更好地保障系统运行及数据安全。适合使用Windows,Linux跨平台系统开发环境下的科研项目或高校科研机构。单台存储节点(GS G3) 60颗HDD即10GB/s写带宽(90颗 12GB/s), 当算力不足时,可通过StorNext系统绑定多台存储节点(GS),加速计算运行速度,持续稳定提供10GB—900GB超高读写带宽,该方案(GS G3/GS U.2)还需要支持100GbE IPSAN RDMA以太网络,单个节点提供12GB/s写入速度与 22GB/s的读性能,为数据密集型计算任务提供了超低的数据延迟和高效的网络资源利用率。

方案三:NAS HPC高性能解决方案

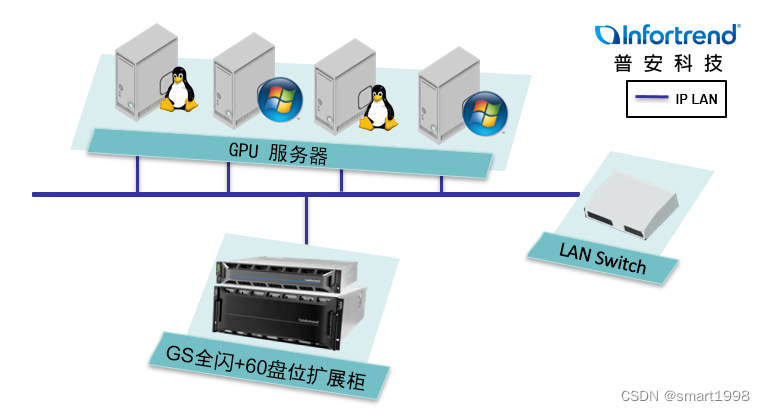

NAS存储HPC应用方案(GS G3/GS U.2)适合使用Linux,windows,Mac系统平台的小组科研项目,支持NFS,SMB,FTP等多种存储协议直连GPU服务器组成计算群组,且不需要使用其它并行文件系统,能有效地降低构建成本。在此方案中以U.2 NVMe SSD全闪主机配高密度HDD扩展柜(60盘位),8颗NVME SSD持续稳定即可提供5GB/s的写带宽,后端连接HDD高密度扩展柜,通过自动分层功能,将热数据存放到 SSD,冷数据存放到 HDD,兼得高性能和大容量需求。提供PB的存储空间满足计算数据存储需求。并且可以横向扩展,随节点的增加性能与容量都线性增长。非常适用于小型项目HPC高性能计算需求。

高校教学与科研工作搭建HPC集群,要想高效稳定的运行,后端的存储在容量、性能、扩展和管理等方面必须满足大型密集型或小组项目型HPC计算需求,为科研人员解决数据存储、数据分析性能等方面的挑战,让数据更好地为科研所用。

![[附源码]java毕业设计企业物资信息管理系统](https://img-blog.csdnimg.cn/7a65172206d64983bf3136dbbf52749b.png)