FM部分

- 什么是FM

FM是factor machine的简写,中文翻译为因子分解机。 - 为什么需要FM

在进行特征建模的过程中,经常会遇到两种情况:- 对特征直接进行建模,未考虑特征之间的关联信息;

- 特征高维稀疏,导致计算量大,特征权值更新缓慢;

FM正好能解决特征交互问题;另外FM 通过引入隐向量,能够降低稀疏特征的维度;提高交互特征参数评估;

- FM长啥样

- 特征组合

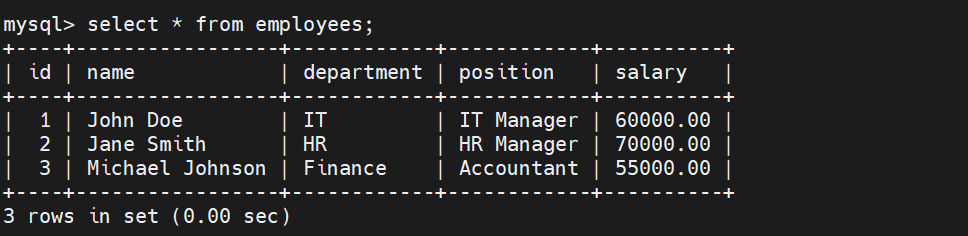

矩阵分解提供了一种解决思路。在model-based的协同过滤中,一个rating矩阵可以分解为user矩阵和item矩阵,每个user和item都可以采用一个隐向量表示。比如在下图中的例子中,我们把每个user表示成一个二维向量,同时把每个item表示成一个二维向量,两个向量的点积就是矩阵中user对item的打分。

上图中n个user,经过one-hot编码,变成n1n维,属于高度稀疏矩阵;为了减少维度,可以通过引入隐向量,将每个user映射为k维,则特征矩阵维度变为n1k维,即上图中的表示形式。

类似地,所有二次项参数 <Vi,Vj>可以组成一个对称阵 W(为了方便说明FM的由来,对角元素可以设置为正实数),那么这个矩阵就可以分解为 W=Vt*V,V 的第 j列( vj)便是第 j维特征( xj)的隐向量。换句话说,特征分量xj 和xi 的交叉项系数就等于xi对应的隐向量与xj对应的隐向量的内积,即每个参数 wij=<vi,vj>,这就是FM模型的核心思想。

关于隐向量,这里的 vi是xi 特征的低纬稠密表达,实际中隐向量的长度通常远小于特征维度N,在我做的实验中长度都是4。在实际的CTR场景中,数据都是很稀疏的category特征,通常表示成离散的one-hot形式,这种编码方式,使得one-hot vector非常长,而且很稀疏,同时特征总量也骤然增加,达到千万级甚至亿级别都是有可能的,而实际上的category特征数目可能只有几百维。FM学到的隐向量可以看做是特征的一种embedding表示,把离散特征转化为Dense Feature,这种Dense Feature还可以后续和DNN来结合,作为DNN的输入,事实上用于DNN的CTR也是这个思路来做的。

-

FM应用场景

-

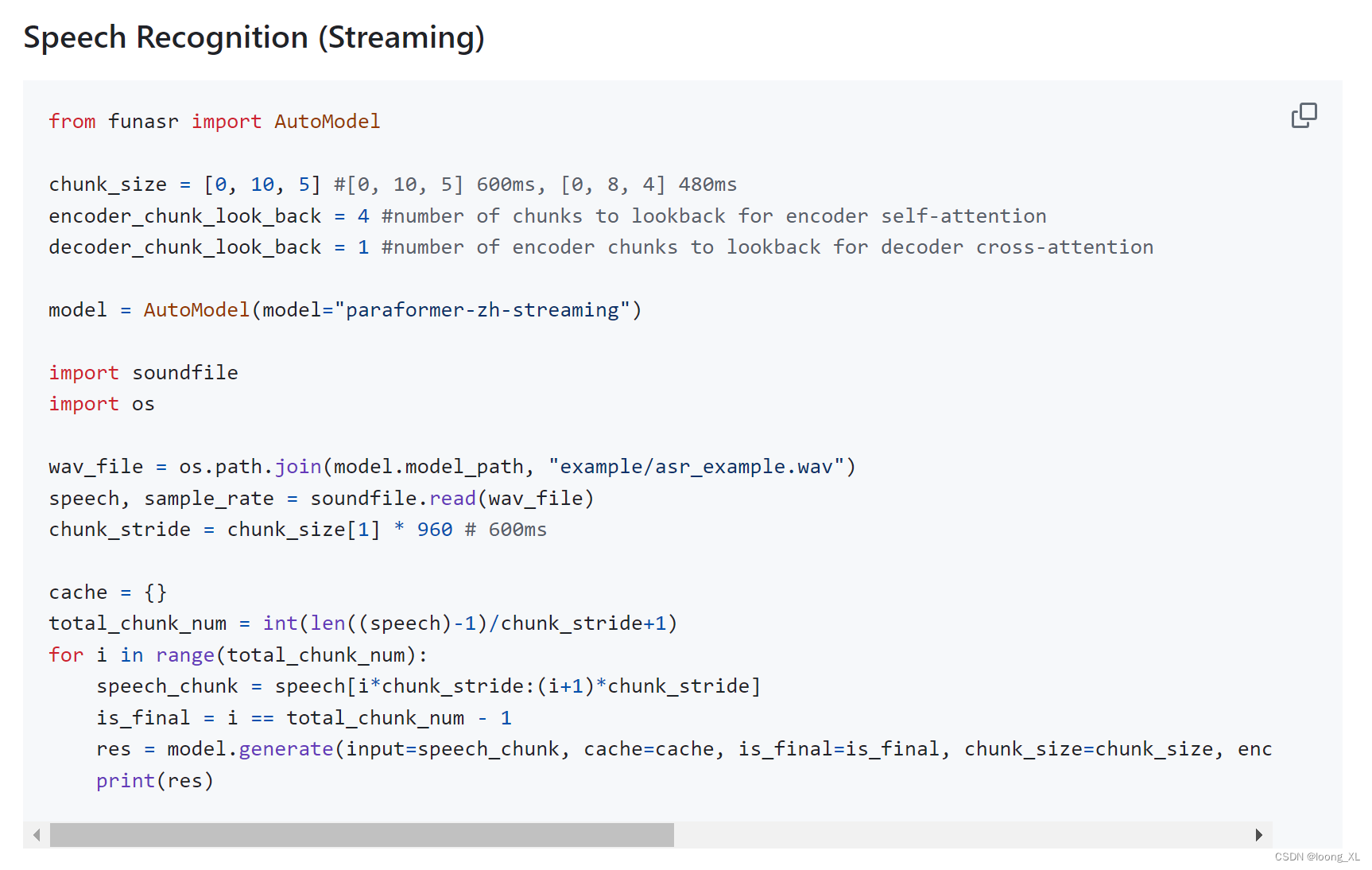

FM code实现

# -*- coding: utf-8 -*-

from __future__ import division

from math import exp

from numpy import *

from random import normalvariate # 正态分布

from sklearn import preprocessing

import numpy as np

'''

data : 数据的路径

feature_potenital : 潜在分解维度数

alpha : 学习速率

iter : 迭代次数

_w,_w_0,_v : 拆分子矩阵的weight

with_col : 是否带有columns_name

first_col : 首列有价值的feature的index

'''

class fm(object):

def __init__(self):

self.data = None

self.feature_potential = None

self.alpha = None

self.iter = None

self._w = None

self._w_0 = None

self.v = None

self.with_col = None

self.first_col = None

def min_max(self, data):

self.data = data

min_max_scaler = preprocessing.MinMaxScaler()

return min_max_scaler.fit_transform(self.data)

def loadDataSet(self, data, with_col=True, first_col=2):

# 我就是闲的蛋疼,明明pd.read_table()可以直接度,非要搞这样的,显得代码很长,小数据下完全可以直接读嘛,唉~

self.first_col = first_col

dataMat = []

labelMat = []

fr = open(data)

self.with_col = with_col

if self.with_col:

N = 0

for line in fr.readlines():

# N=1时干掉列表名

if N > 0:

currLine = line.strip().split()

lineArr = []

featureNum = len(currLine)

for i in range(self.first_col, featureNum):

lineArr.append(float(currLine[i]))

dataMat.append(lineArr)

labelMat.append(float(currLine[1]) * 2 - 1)

N = N + 1

else:

for line in fr.readlines():

currLine = line.strip().split()

lineArr = []

featureNum = len(currLine)

for i in range(2, featureNum):

lineArr.append(float(currLine[i]))

dataMat.append(lineArr)

labelMat.append(float(currLine[1]) * 2 - 1)

return mat(self.min_max(dataMat)), labelMat

def sigmoid(self, inx):

# return 1.0/(1+exp(min(max(-inx,-10),10)))

return 1.0 / (1 + exp(-inx))

# 得到对应的特征weight的矩阵

def fit(self, data, feature_potential=8, alpha=0.01, iter=100):

# alpha是学习速率

self.alpha = alpha

self.feature_potential = feature_potential

self.iter = iter

# dataMatrix用的是mat, classLabels是列表

dataMatrix, classLabels = self.loadDataSet(data)

print('dataMatrix:',dataMatrix.shape)

print('classLabels:',classLabels)

k = self.feature_potential

m, n = shape(dataMatrix)

# 初始化参数

w = zeros((n, 1)) # 其中n是特征的个数

w_0 = 0.

v = normalvariate(0, 0.2) * ones((n, k))

for it in range(self.iter): # 迭代次数

# 对每一个样本,优化

for x in range(m):

# 这边注意一个数学知识:对应点积的地方通常会有sum,对应位置积的地方通常都没有,详细参见矩阵运算规则,本处计算逻辑在:http://blog.csdn.net/google19890102/article/details/45532745

# xi·vi,xi与vi的矩阵点积

inter_1 = dataMatrix[x] * v

# xi与xi的对应位置乘积 与 xi^2与vi^2对应位置的乘积 的点积

inter_2 = multiply(dataMatrix[x], dataMatrix[x]) * multiply(v, v) # multiply对应元素相乘

# 完成交叉项,xi*vi*xi*vi - xi^2*vi^2

interaction = sum(multiply(inter_1, inter_1) - inter_2) / 2.

# 计算预测的输出

p = w_0 + dataMatrix[x] * w + interaction

print('classLabels[x]:',classLabels[x])

print('预测的输出p:', p)

# 计算sigmoid(y*pred_y)-1

loss = self.sigmoid(classLabels[x] * p[0, 0]) - 1

if loss >= -1:

loss_res = '正方向 '

else:

loss_res = '反方向'

# 更新参数

w_0 = w_0 - self.alpha * loss * classLabels[x]

for i in range(n):

if dataMatrix[x, i] != 0:

w[i, 0] = w[i, 0] - self.alpha * loss * classLabels[x] * dataMatrix[x, i]

for j in range(k):

v[i, j] = v[i, j] - self.alpha * loss * classLabels[x] * (

dataMatrix[x, i] * inter_1[0, j] - v[i, j] * dataMatrix[x, i] * dataMatrix[x, i])

print('the no %s times, the loss arrach %s' % (it, loss_res))

self._w_0, self._w, self._v = w_0, w, v

def predict(self, X):

if (self._w_0 == None) or (self._w == None).any() or (self._v == None).any():

raise NotFittedError("Estimator not fitted, call `fit` first")

# 类型检查

if isinstance(X, np.ndarray):

pass

else:

try:

X = np.array(X)

except:

raise TypeError("numpy.ndarray required for X")

w_0 = self._w_0

w = self._w

v = self._v

m, n = shape(X)

result = []

for x in range(m):

inter_1 = mat(X[x]) * v

inter_2 = mat(multiply(X[x], X[x])) * multiply(v, v) # multiply对应元素相乘

# 完成交叉项

interaction = sum(multiply(inter_1, inter_1) - inter_2) / 2.

p = w_0 + X[x] * w + interaction # 计算预测的输出

pre = self.sigmoid(p[0, 0])

result.append(pre)

return result

def getAccuracy(self, data):

dataMatrix, classLabels = self.loadDataSet(data)

w_0 = self._w_0

w = self._w

v = self._v

m, n = shape(dataMatrix)

allItem = 0

error = 0

result = []

for x in range(m):

allItem += 1

inter_1 = dataMatrix[x] * v

inter_2 = multiply(dataMatrix[x], dataMatrix[x]) * multiply(v, v) # multiply对应元素相乘

# 完成交叉项

interaction = sum(multiply(inter_1, inter_1) - inter_2) / 2.

p = w_0 + dataMatrix[x] * w + interaction # 计算预测的输出

pre = self.sigmoid(p[0, 0])

result.append(pre)

if pre < 0.5 and classLabels[x] == 1.0:

error += 1

elif pre >= 0.5 and classLabels[x] == -1.0:

error += 1

else:

continue

# print(result)

value = 1 - float(error) / allItem

return value

class NotFittedError(Exception):

"""

Exception class to raise if estimator is used before fitting

"""

pass

if __name__ == '__main__':

fm()

参考连接

- https://zhuanlan.zhihu.com/p/3796326

- https://www.jianshu.com/p/9a3416ed683b

- https://www.cnblogs.com/wkang/p/9588360.html