1、参考地址

(1)blibli网站地址

251-03_PaddlePaddle求解线性模型_dec_哔哩哔哩_bilibili

(2)波士顿数据集介绍参考了

机器学习:波士顿房价数据集_mjiansun的博客-CSDN博客

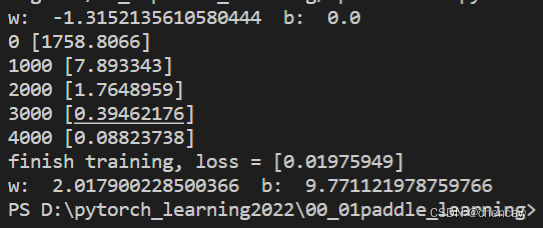

2、简单线性回归

(1)测试一个简单线性回归例子

y = 2*x + 10

(2)测试代码如下

import paddle

# test y = 2x +10

#线性回归例子

x_data = paddle.to_tensor([[1.0],[3.0],[5.0],[9.0],[10.0],[20.0]])

y_data = paddle.to_tensor([[12.0],[16.0],[20.0],[28.0],[30.0],[50.0]])

linear = paddle.nn.Linear(in_features=1, out_features=1)

w_before_opt = linear.weight.numpy().item()

b_before_opt = linear.bias.numpy().item()

print("w: ",w_before_opt," b: ", b_before_opt)

mse_loss = paddle.nn.MSELoss()

sgd_optimizer = paddle.optimizer.SGD(learning_rate=0.001, parameters=linear.parameters())

total_epoch = 5000

for i in range(total_epoch):

y_predict = linear(x_data)

loss = mse_loss(y_predict, y_data)

loss.backward()

sgd_optimizer.step()

sgd_optimizer.clear_gradients()

if i % 1000 == 0:

print(i, loss.numpy())

print("finish training, loss = {}".format(loss.numpy()))

w_finial_opt = linear.weight.numpy().item()

b_finial_opt = linear.bias.numpy().item()

print("w: ",w_finial_opt," b: ", b_finial_opt)

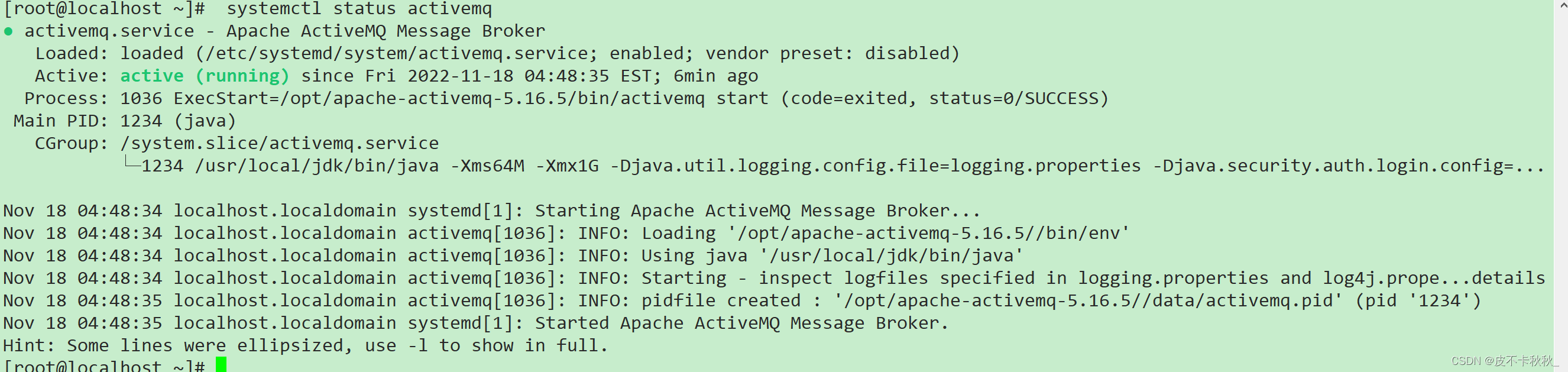

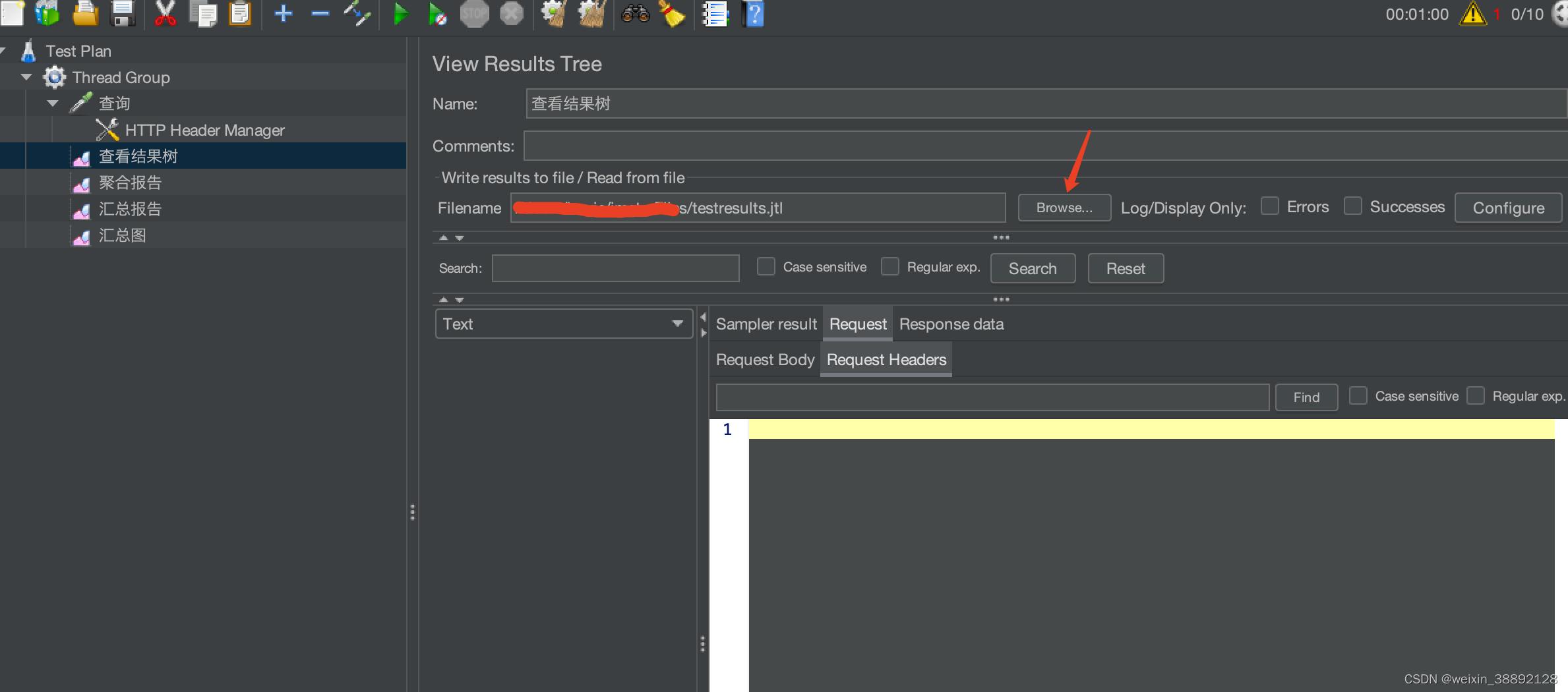

(3)测试效果图

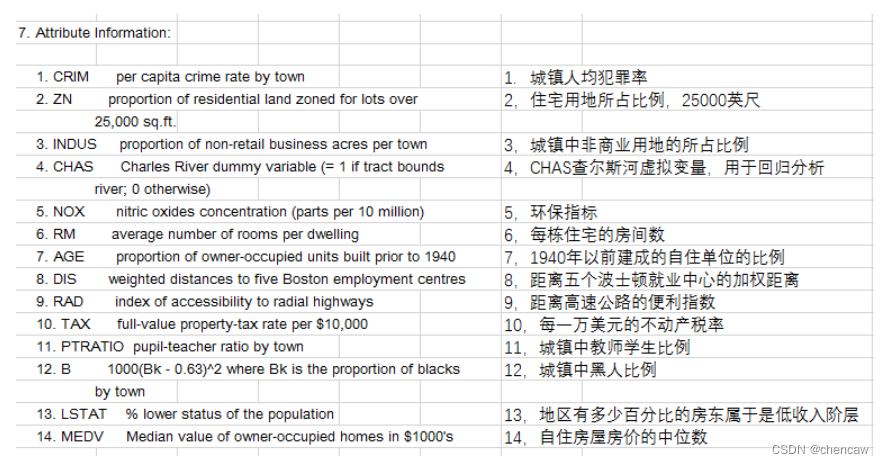

3、波士顿房价数据集

(1)数据集下载地址

https://archive.ics.uci.edu/ml/machine-learning-databases/housing/housing.data

(2)数据集内容

该数据集是一个回归问题。每个类的观察值数量是均等的,共有 506 个观察,13 个输入变量和1个输出变量。每条数据包含房屋以及房屋周围的详细信息。其中包含城镇犯罪率,一氧化氮浓度,住宅平均房间数,到中心区域的加权距离以及自住房平均房价等等。

CRIM:城镇人均犯罪率。

ZN:住宅用地超过 25000 sq.ft. 的比例。

INDUS:城镇非零售商用土地的比例。

CHAS:查理斯河空变量(如果边界是河流,则为1;否则为0)。

NOX:一氧化氮浓度。

RM:住宅平均房间数。

AGE:1940 年之前建成的自用房屋比例。

DIS:到波士顿五个中心区域的加权距离。

RAD:辐射性公路的接近指数。

TAX:每 10000 美元的全值财产税率。

PTRATIO:城镇师生比例。

B:1000(Bk-0.63)^ 2,其中 Bk 指代城镇中黑人的比例。

LSTAT:人口中地位低下者的比例。

MEDV:自住房的平均房价,以千美元计。

预测平均值的基准性能的均方根误差(RMSE)是约 9.21 千美元。

注意: 因为涉及种族问题(有一个和黑人人口占比相关的变量B),请大家保持理性,认真严肃对待:(。

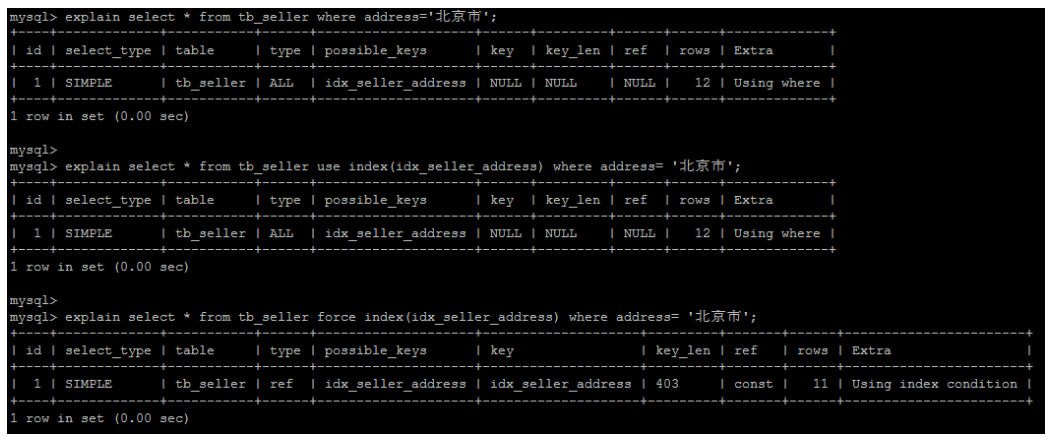

(3)用notepad++打开这个.data的数据集,如下图所示

(4)代码实现,感觉效果不好

import paddle

from paddle.nn import Linear

import paddle.nn.functional as F

import numpy as np

import os

import random

def load_data():

#从文件道路数据

datafile = './housing.data'

data = np.fromfile(datafile, sep=' ', dtype=np.float32)

#每条数据包括14项,其中前面13项是影响因素,第14项是相应的房屋价格中位数

feature_names = ['CRIM','ZN','INDUS','CHAS','NOX','RM','AGE',

'DIS','RAD','TAX','PTRATIO','B','LSTAT','MEDV']

feature_num = len(feature_names)

#将原始数据进行Reshape,变成[N, 14]这样的形状

data = data.reshape([data.shape[0] // feature_num, feature_num])

#将原始数据集拆分成训练集和测试集

#这里使用80%的数据做训练,20%的数据做测试

# 测试集和训练集必须是没有交集的

ratio = 0.8

offset = int(data.shape[0] * ratio)

training_data = data[:offset]

#计算train数据集的最大值,最小值,平均值

maximums, minimums, avgs = training_data.max(axis=0),training_data.min(axis=0), \

training_data.sum(axis=0)/training_data.shape[0]

print(maximums.shape)

# 记录数据的归一化参数,在预测时对数据做归一化

# global max_values

# global min_values

# global avg_values

max_values = maximums

min_values = minimums

avg_values = avgs

#对所有的数据进行归一化处理

for i in range(feature_num):

data[:, i] = (data[:, i] - avgs[i]) / (maximums[i] - minimums[i])

#训练集合测试集的划分比例

training_data = data[:offset]

test_data = data[offset:]

return training_data, test_data, max_values, min_values, avg_values, feature_num

class Regressor(paddle.nn.Layer):

#self代表类的实例自身

def __init__(self) -> None:

#初始化父类中的一些参数

super(Regressor, self).__init__()

#定义一层全连接层,输入维度是13,输出维度是1

self.fc = Linear(in_features=13, out_features=1)

#网络的前向计算

def forward(self, inputs):

x = self.fc(inputs)

return x

#陈修改

def load_one_test(testdata):

#从测试数据中,随机选择一条数据作为测试数据

idx = np.random.randint(0,testdata.shape[0])

# idx = -10 # 或者直接指定

one_data, label = testdata[idx, :-1], testdata[idx, -1]

print("one_data.shape: ",one_data.shape)

#修改该条数据shape为[1,13]

one_data = one_data.reshape([1,-1])

print("one_data.shape: ",one_data.shape)

return one_data,label

def house_price():

# 定义线性模型

model = Regressor()

#开启模型训练模式

model.train()

# 加载数据

training_data, test_data, max_values, min_values, avg_values, feature_num = load_data()

#定义优化算法,使用随机梯度下降SGD

#学习率设置为0.01

opt = paddle.optimizer.SGD(learning_rate=0.01, parameters=model.parameters())

EPOCH_NUM = 10 #总共多少轮训练

BATCH_SIZE = 10 #batch siza大小

#每一轮训练

for epoch_id in range(EPOCH_NUM):

#在每轮迭代开始之前,将训练数据的顺序随机的打乱

np.random.shuffle(training_data)

#将训练数据进行拆分,每个batch包含10条数据

mini_batches = [training_data[k:k+BATCH_SIZE] for k in range(0, len(training_data), BATCH_SIZE)]

#每一轮训练中,每个batch训练一遍

for iter_id, mini_batch in enumerate(mini_batches):

x = np.array(mini_batch[:,:-1]) #获得当前批次训练数据,前面13个值

y = np.array(mini_batch[:,-1:]) #获得当前批次训练标签(真实放假),最后一个房价值

#将numpy数据转为paddle的tensor形式

house_features = paddle.to_tensor(x)

prices = paddle.to_tensor(y)

#前向计算

predicts = model(house_features)

#计算损失

loss = F.square_error_cost(predicts,label=prices)

avg_loss = paddle.mean(loss)

if iter_id % 20 == 0:

print("epoch:{}, iter:{}, loss is: {}".format(epoch_id, iter_id, avg_loss.numpy()))

#反向传播

avg_loss.backward()

#最小化loss,更新参数

opt.step()

#清除梯度

opt.clear_grad()

#保存模型参数

paddle.save(model.state_dict(), 'LR_model.pdparams')

print("模型已保存,文件为LR_model.pdparams")

#-------------------------------------------------------

#读取模型

model_dict = paddle.load('LR_model.pdparams')

model.load_dict(model_dict)

#设置为测试模式

model.eval

#获取测试数据,注意要做归一化

one_data, label = load_one_test(test_data)

#转为tensor

one_data = paddle.to_tensor(one_data)

predict = model(one_data)

#对结果做反向归一化处理

predict = predict *(max_values[-1] - min_values[-1]) + avg_values[-1]

#对label数据做反向归一化处理

label = label * (max_values[-1] - min_values[-1]) + avg_values[-1]

print("Inference result is{}, the corresponding label is{}".format(predict.numpy(),label))

if __name__ == "__main__":

house_price()

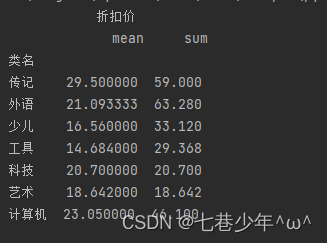

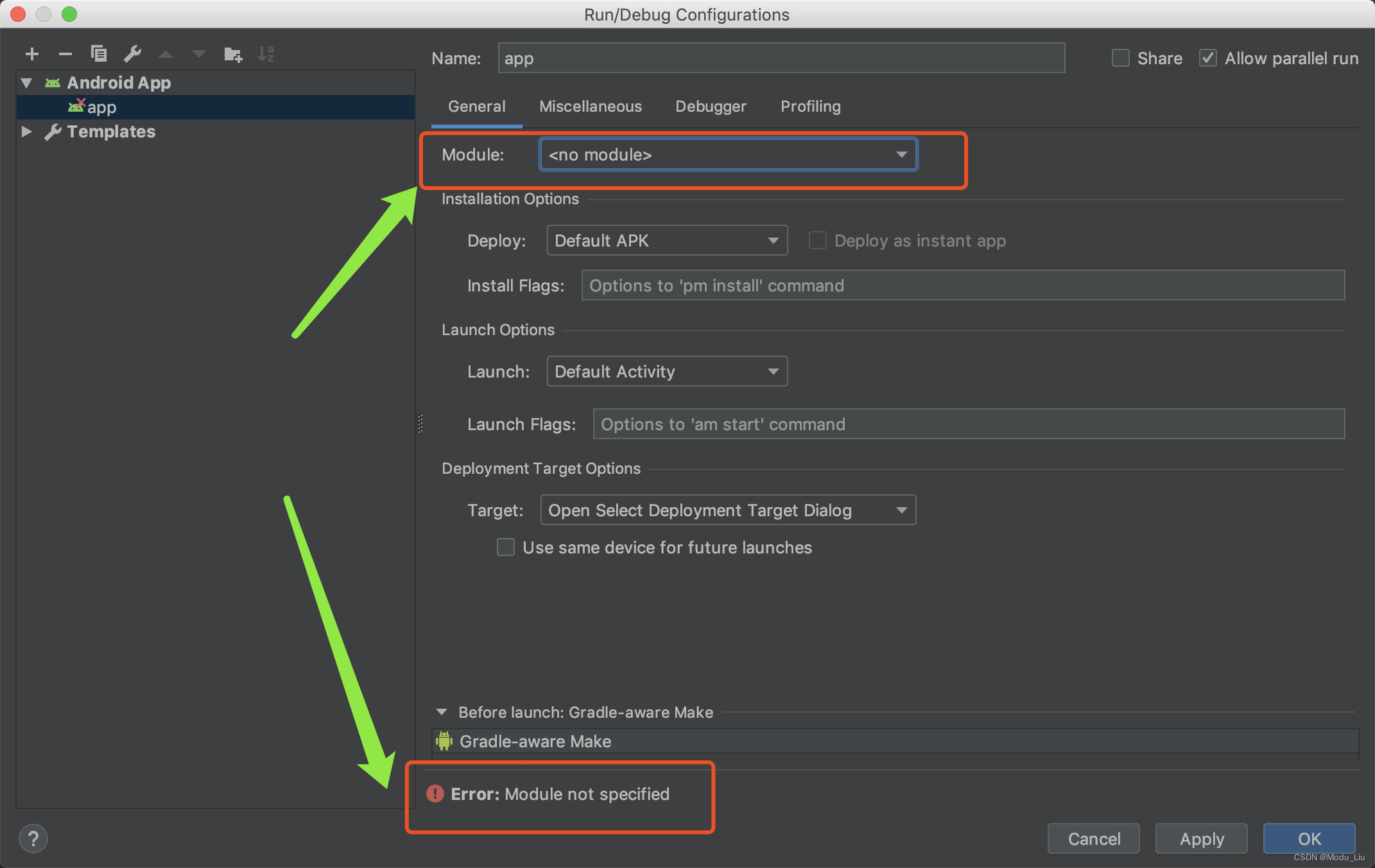

(5)改进一下,修改神经网络为2层,训练100epoch,效果看看还可以,如下

import paddle

from paddle.nn import Linear

import paddle.nn.functional as F

import numpy as np

import os

import random

def load_data():

#从文件道路数据

datafile = './housing.data'

data = np.fromfile(datafile, sep=' ', dtype=np.float32)

#每条数据包括14项,其中前面13项是影响因素,第14项是相应的房屋价格中位数

feature_names = ['CRIM','ZN','INDUS','CHAS','NOX','RM','AGE',

'DIS','RAD','TAX','PTRATIO','B','LSTAT','MEDV']

feature_num = len(feature_names)

#将原始数据进行Reshape,变成[N, 14]这样的形状

data = data.reshape([data.shape[0] // feature_num, feature_num])

#将原始数据集拆分成训练集和测试集

#这里使用80%的数据做训练,20%的数据做测试

# 测试集和训练集必须是没有交集的

ratio = 0.8

offset = int(data.shape[0] * ratio)

training_data = data[:offset]

#计算train数据集的最大值,最小值,平均值

maximums, minimums, avgs = training_data.max(axis=0),training_data.min(axis=0), \

training_data.sum(axis=0)/training_data.shape[0]

print(maximums.shape)

# 记录数据的归一化参数,在预测时对数据做归一化

# global max_values

# global min_values

# global avg_values

max_values = maximums

min_values = minimums

avg_values = avgs

#对所有的数据进行归一化处理

for i in range(feature_num):

data[:, i] = (data[:, i] - avgs[i]) / (maximums[i] - minimums[i])

#训练集合测试集的划分比例

training_data = data[:offset]

test_data = data[offset:]

return training_data, test_data, max_values, min_values, avg_values, feature_num

class Regressor(paddle.nn.Layer):

#self代表类的实例自身

def __init__(self) -> None:

#初始化父类中的一些参数

super(Regressor, self).__init__()

#定义一层全连接层,输入维度是13,输出维度是1

self.fc1 = Linear(in_features=13, out_features=20)

self.fc2 = Linear(in_features=20, out_features=1)

#网络的前向计算

def forward(self, inputs):

x1 = self.fc1(inputs)

x2 = self.fc2(x1)

return x2

#陈修改

def load_one_test(testdata):

#从测试数据中,随机选择一条数据作为测试数据

idx = np.random.randint(0,testdata.shape[0])

# idx = -10 # 或者直接指定

one_data, label = testdata[idx, :-1], testdata[idx, -1]

print("one_data.shape: ",one_data.shape)

#修改该条数据shape为[1,13]

one_data = one_data.reshape([1,-1])

print("one_data.shape: ",one_data.shape)

return one_data,label

def house_price():

# 定义线性模型

model = Regressor()

#开启模型训练模式

model.train()

# 加载数据

training_data, test_data, max_values, min_values, avg_values, feature_num = load_data()

#定义优化算法,使用随机梯度下降SGD

#学习率设置为0.01

opt = paddle.optimizer.SGD(learning_rate=0.01, parameters=model.parameters())

EPOCH_NUM = 100 #总共多少轮训练

BATCH_SIZE = 10 #batch siza大小

#每一轮训练

for epoch_id in range(EPOCH_NUM):

#在每轮迭代开始之前,将训练数据的顺序随机的打乱

np.random.shuffle(training_data)

#将训练数据进行拆分,每个batch包含10条数据

mini_batches = [training_data[k:k+BATCH_SIZE] for k in range(0, len(training_data), BATCH_SIZE)]

#每一轮训练中,每个batch训练一遍

for iter_id, mini_batch in enumerate(mini_batches):

x = np.array(mini_batch[:,:-1]) #获得当前批次训练数据,前面13个值

y = np.array(mini_batch[:,-1:]) #获得当前批次训练标签(真实放假),最后一个房价值

#将numpy数据转为paddle的tensor形式

house_features = paddle.to_tensor(x)

prices = paddle.to_tensor(y)

#前向计算

predicts = model(house_features)

#计算损失

loss = F.square_error_cost(predicts,label=prices)

avg_loss = paddle.mean(loss)

if iter_id % 20 == 0:

print("epoch:{}, iter:{}, loss is: {}".format(epoch_id, iter_id, avg_loss.numpy()))

#反向传播

avg_loss.backward()

#最小化loss,更新参数

opt.step()

#清除梯度

opt.clear_grad()

#保存模型参数

paddle.save(model.state_dict(), 'LR_model.pdparams')

print("模型已保存,文件为LR_model.pdparams")

#-------------------------------------------------------

#读取模型

model_dict = paddle.load('LR_model.pdparams')

model.load_dict(model_dict)

#设置为测试模式

model.eval

#获取测试数据,注意要做归一化

one_data, label = load_one_test(test_data)

#转为tensor

one_data = paddle.to_tensor(one_data)

predict = model(one_data)

#对结果做反向归一化处理

predict = predict *(max_values[-1] - min_values[-1]) + avg_values[-1]

#对label数据做反向归一化处理

label = label * (max_values[-1] - min_values[-1]) + avg_values[-1]

print("Inference result is{}, the corresponding label is{}".format(predict.numpy(),label))

if __name__ == "__main__":

house_price()