注意力机制拓展

- 1 注意力机制原理

-

- 1.1 注意力机制示意图

- 1.2 Attention计算过程

- 1.3 Attention计算逻辑

- 1.4 有无attention模型对比

-

- 1.4.1 无attention机制的模型

- 1.4.2 有attention机制的模型

1 注意力机制原理

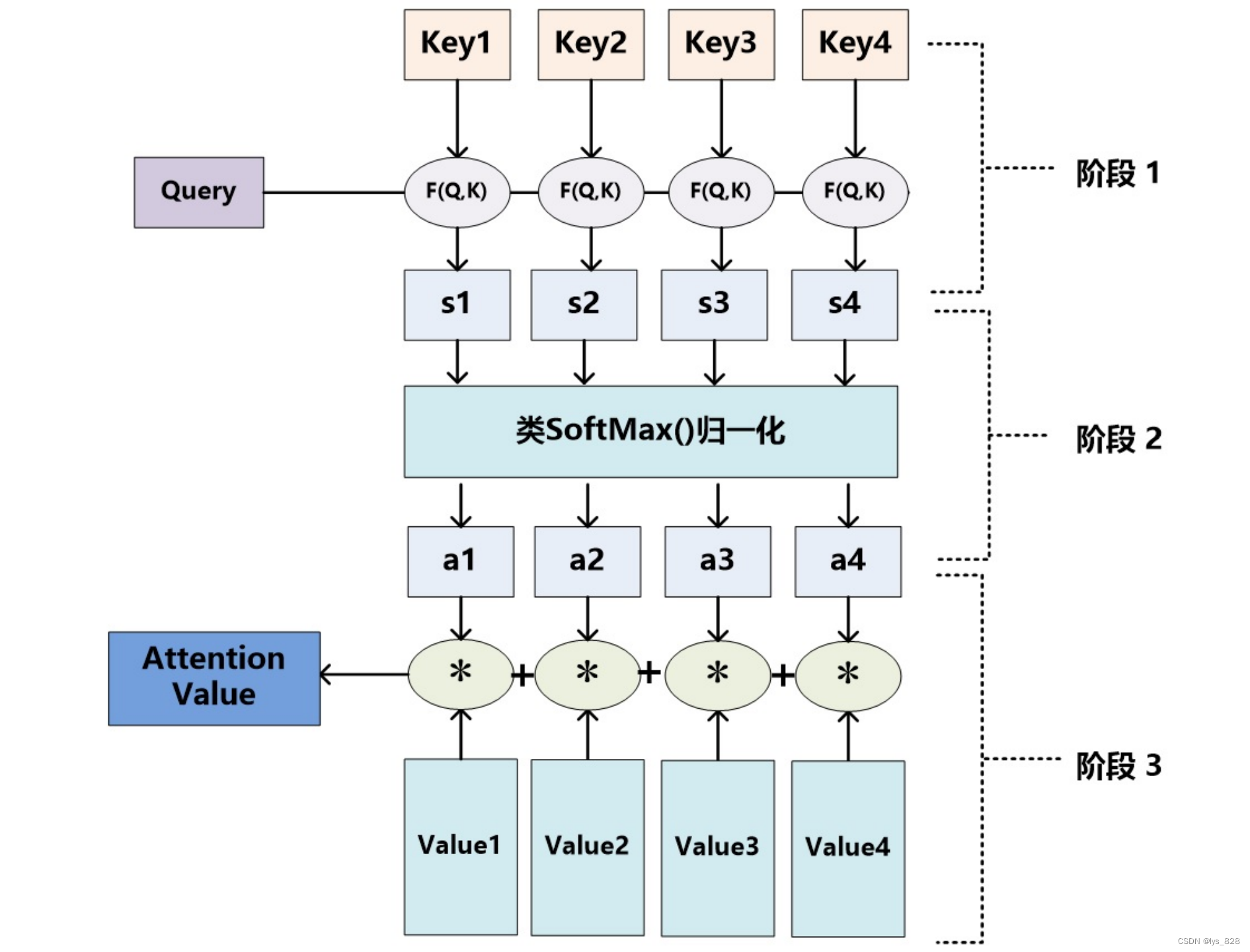

1.1 注意力机制示意图

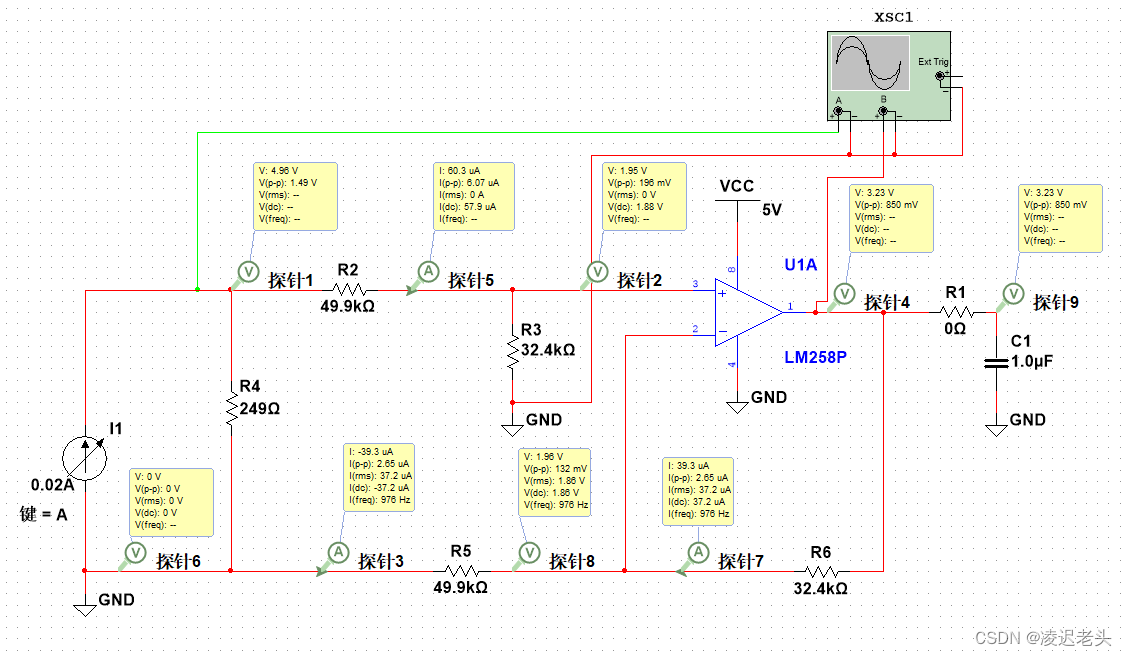

Attention机制的工作原理并不复杂,我们可以用下面这张图做一个总结

1.2 Attention计算过程

- 阶段一: query 和 key 进行相似度计算,得到一个query 和 key 相关性的分值

- 阶段二: 将这个分值进行归一化(softmax),得到一个注意力的分布

- 阶段三: 使用注意力分布和 value 进行计算,得到一个融合注意力的更好的 value 值

为了更好的说明上面的情况, 我们通过注意力来做一个机器

![④【Set】Redis常用数据类型: Set [使用手册]](https://img-blog.csdnimg.cn/20a7f1b58dfb4660b75d7f021c157d57.png#pic_center)

![洛谷 P4552 [Poetize6] IncDec Sequence](https://img-blog.csdnimg.cn/7c9e467d885d4d26899b4b3082a6d362.png)