沐神版《动手学深度学习》学习笔记,记录学习过程,详细的内容请大家购买书籍查阅。

b站视频链接

开源教程链接

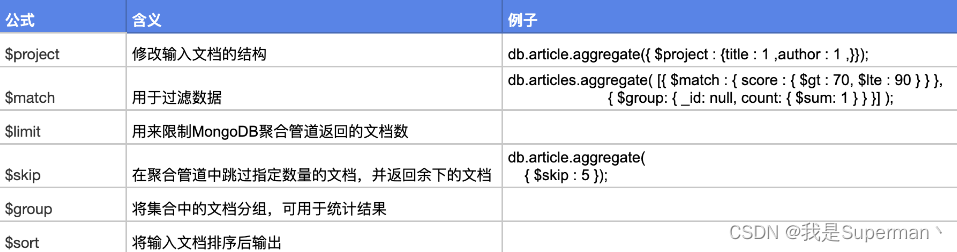

卷积

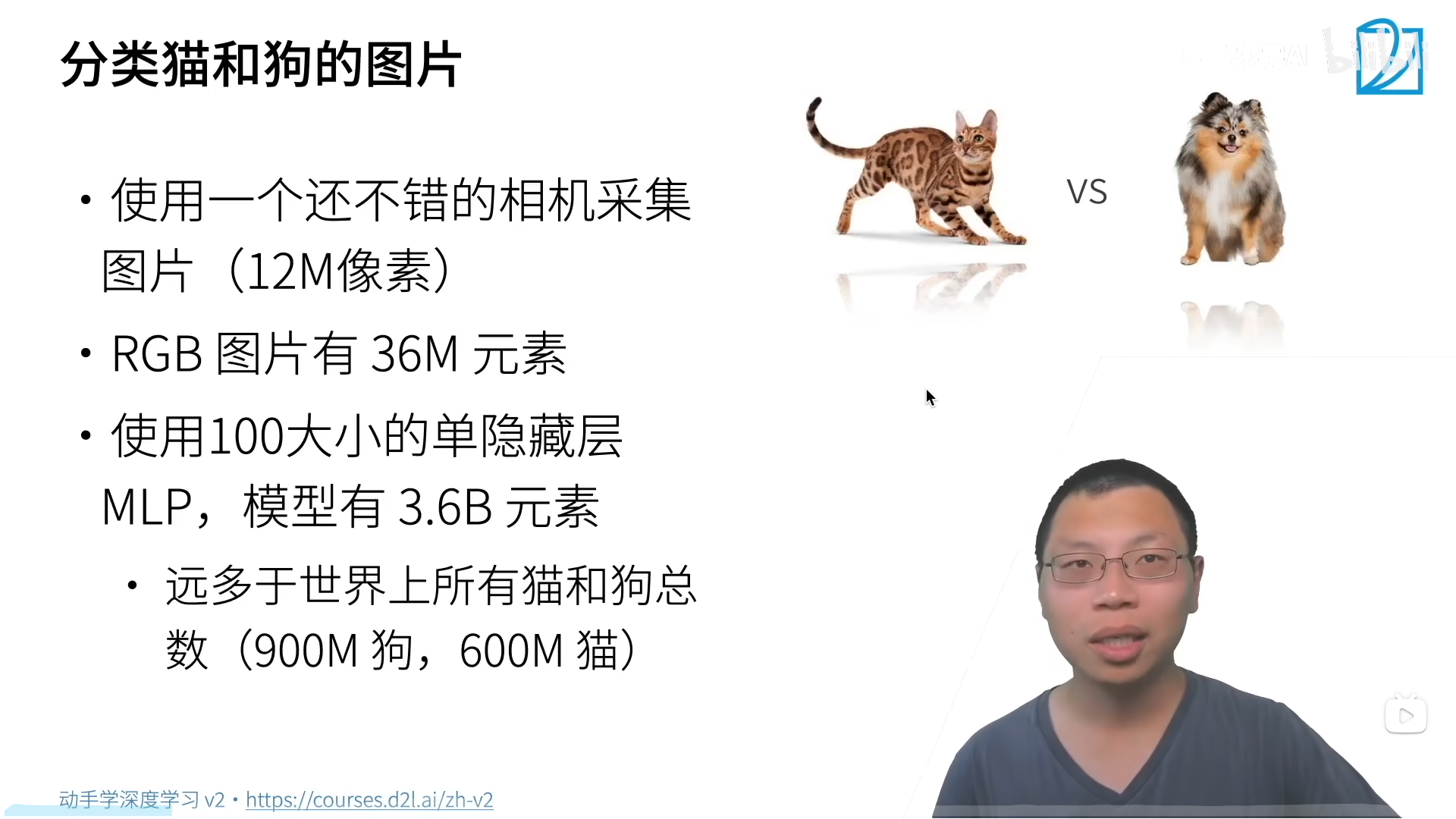

使用一个12M像素的相机采集图片,因为是RGB图片所以有36M元素。

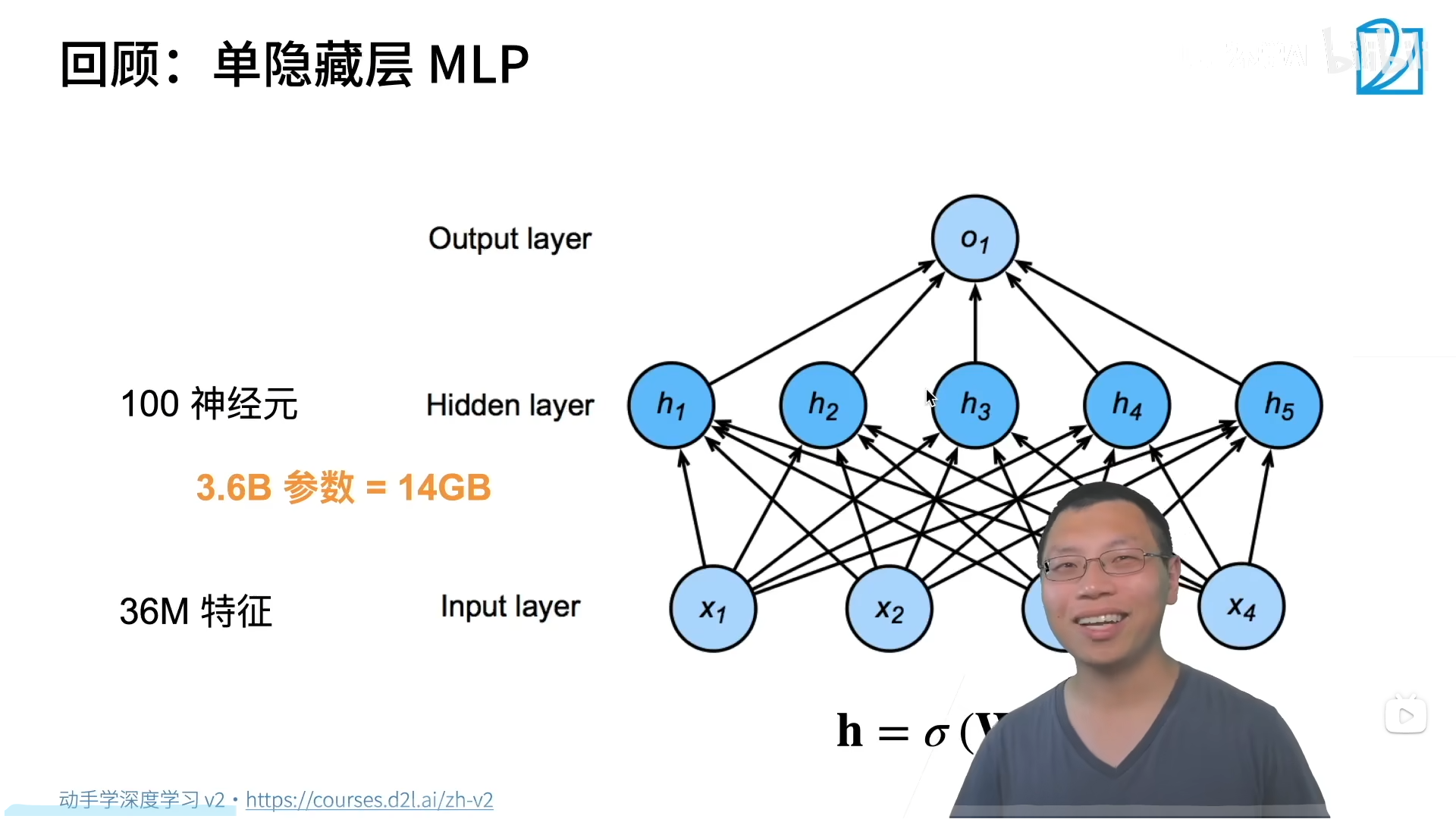

使用MLP来做分类会遇到的问题:

参数太大,GPU连参数都存不下:

引入卷积:

在图片里找模式的原则,启发了卷积的设计:

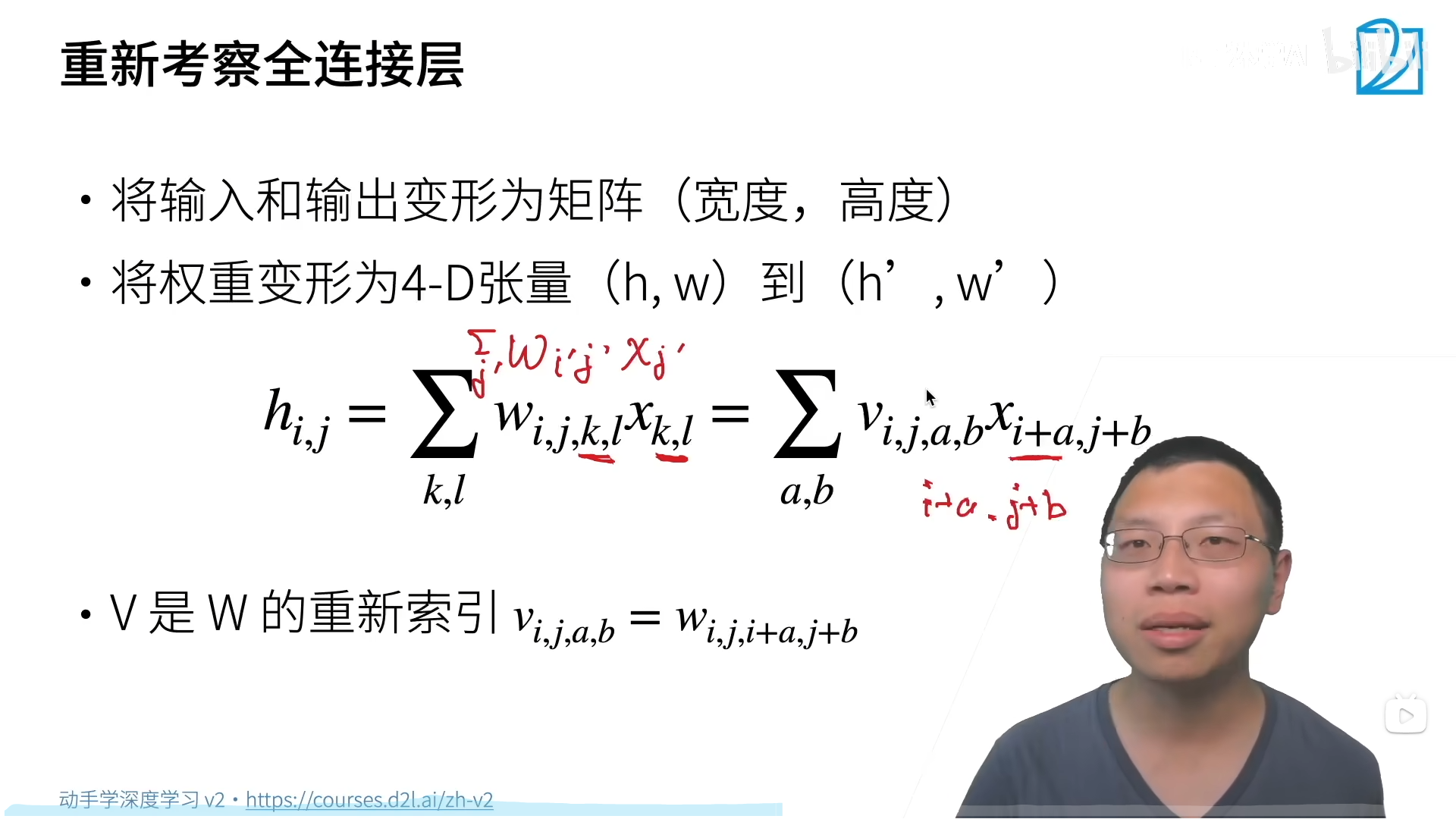

将全连接层重新变换一下,做成一个二维的输入输出。

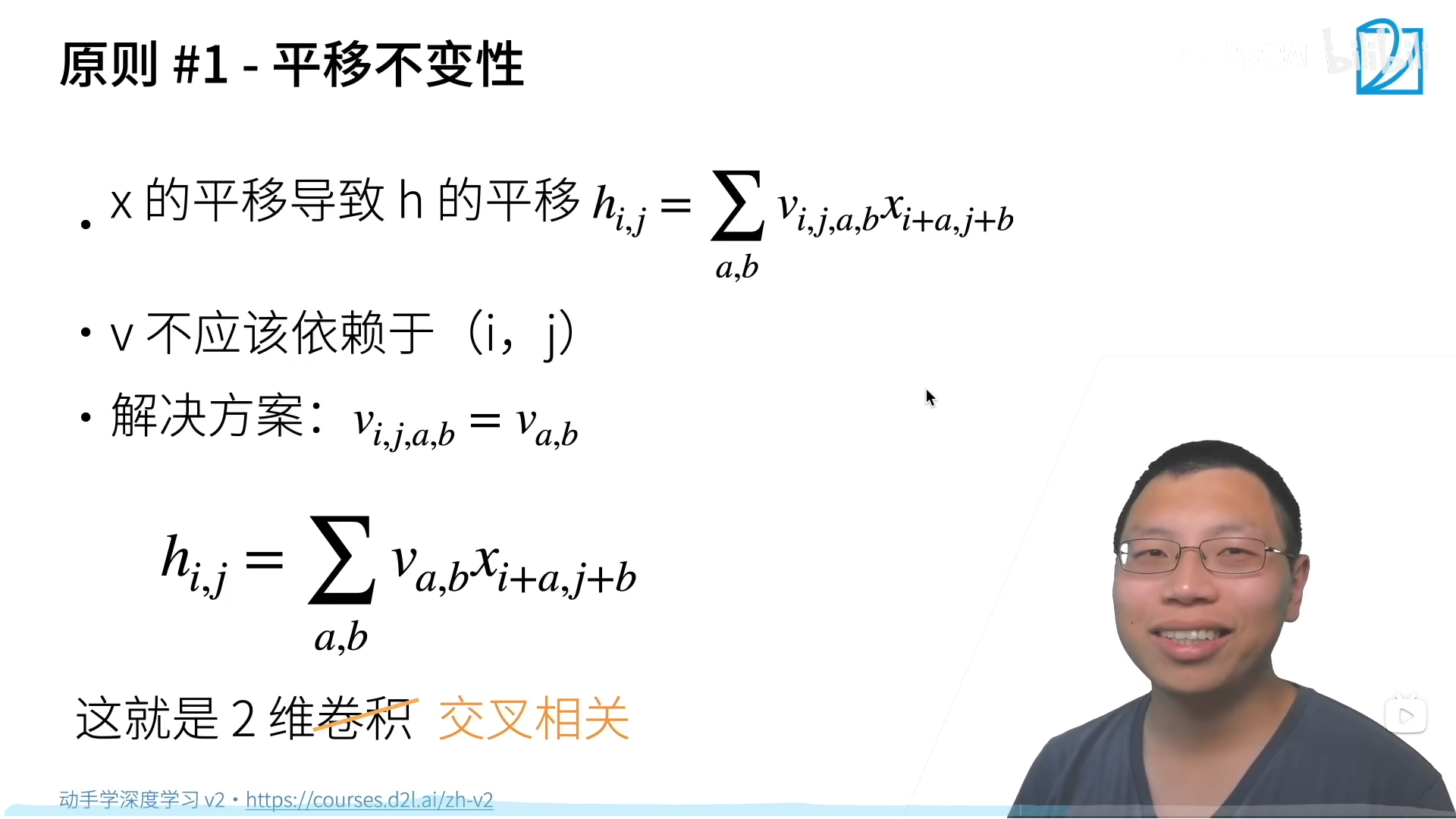

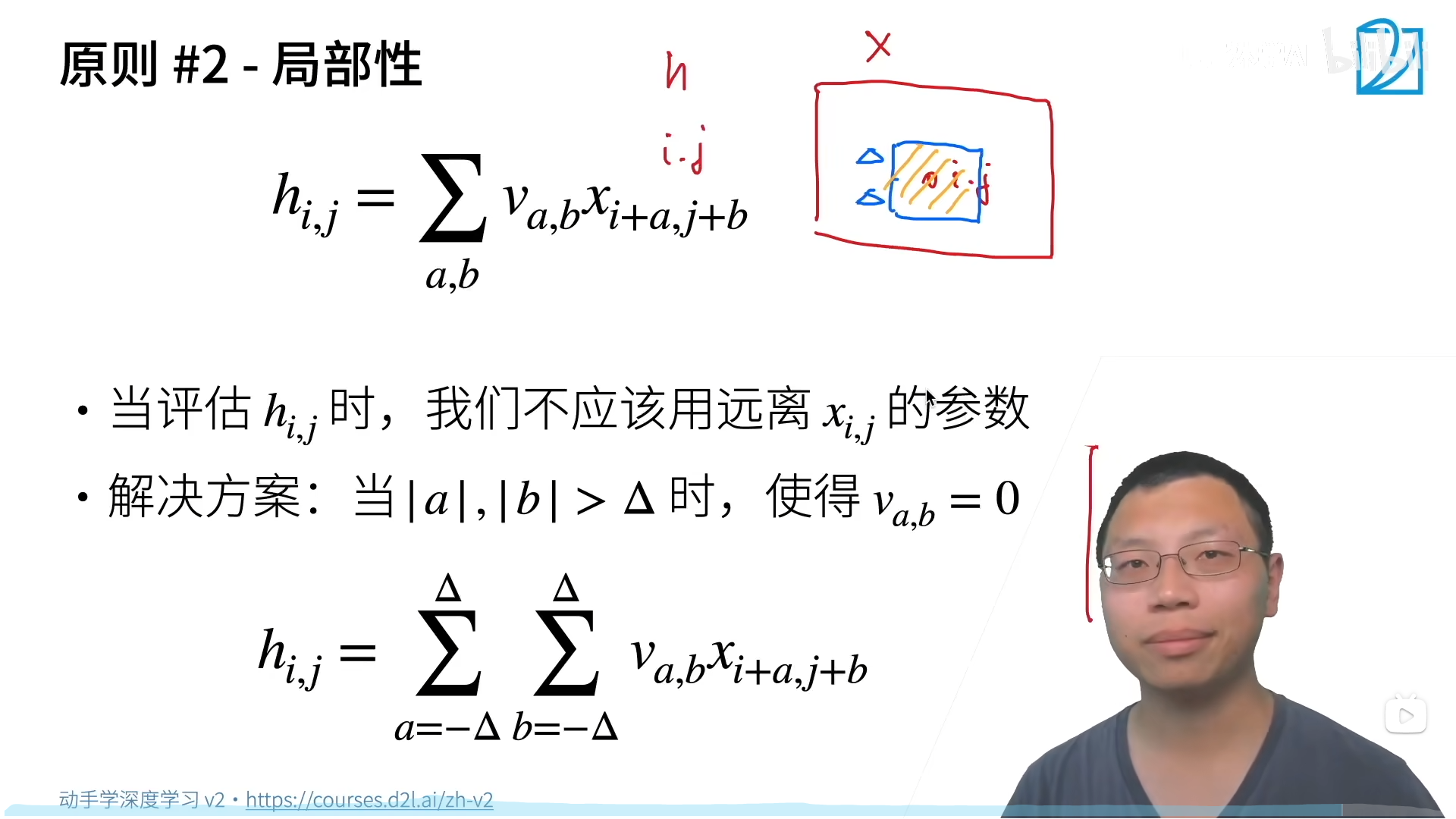

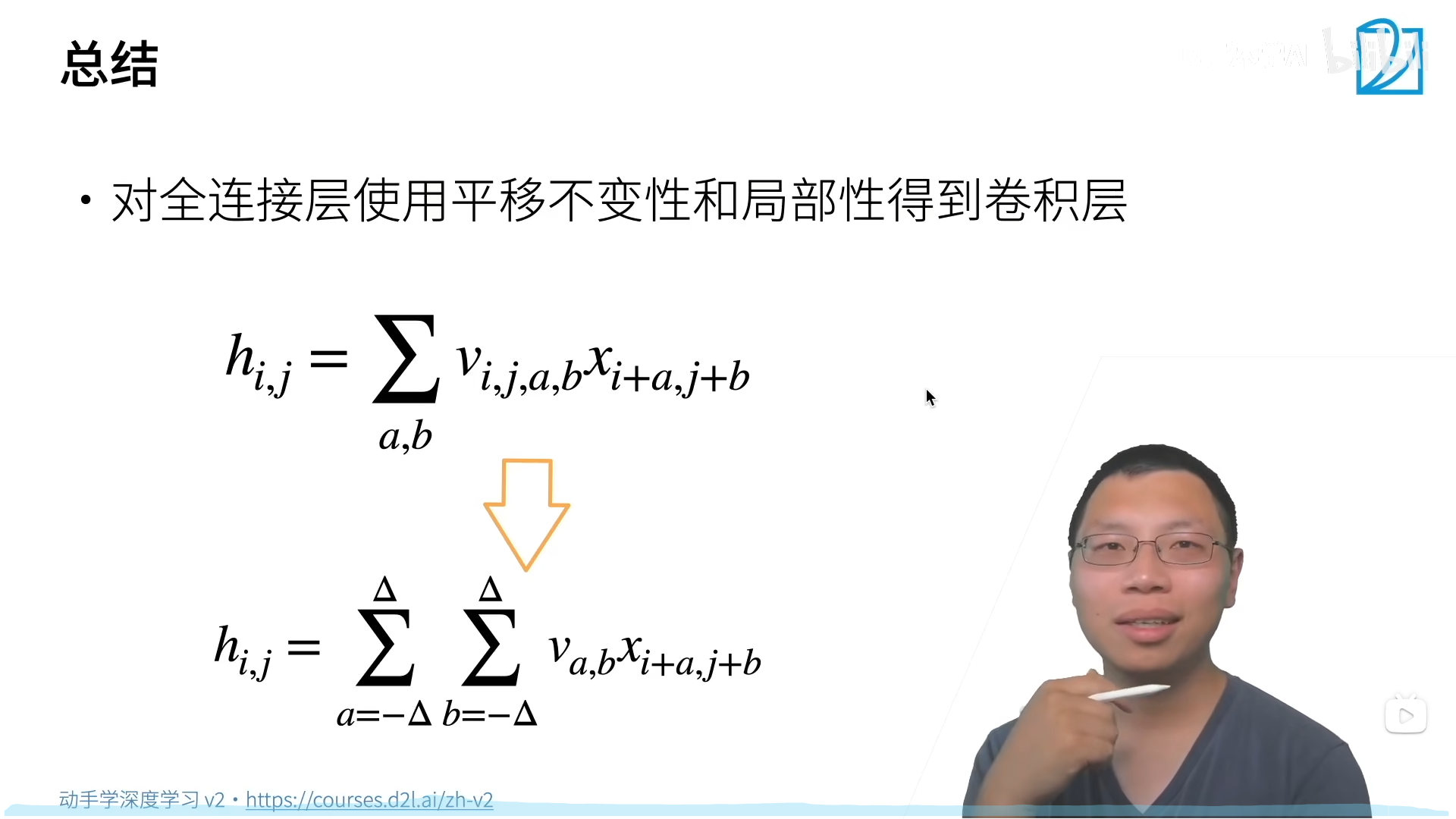

按照MLP的思想要为每一个卷积核大小的像素区域分配一个卷积核,而添加平移不变性和局部性,使得卷积核可以进行移动(模式/识别器不变),同时降低了参数量。

总结

卷积是一个特殊的全连接层:

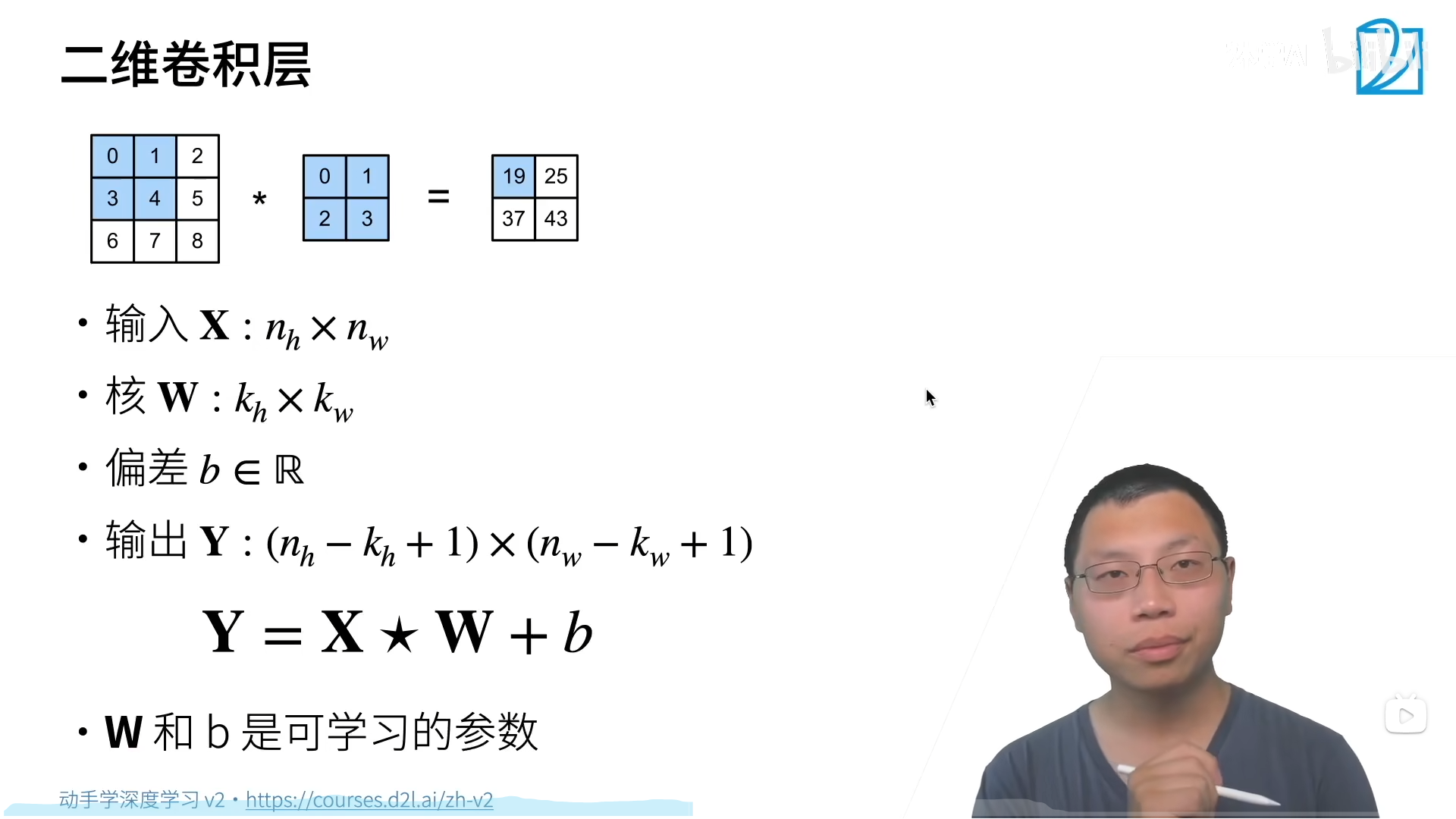

卷积层

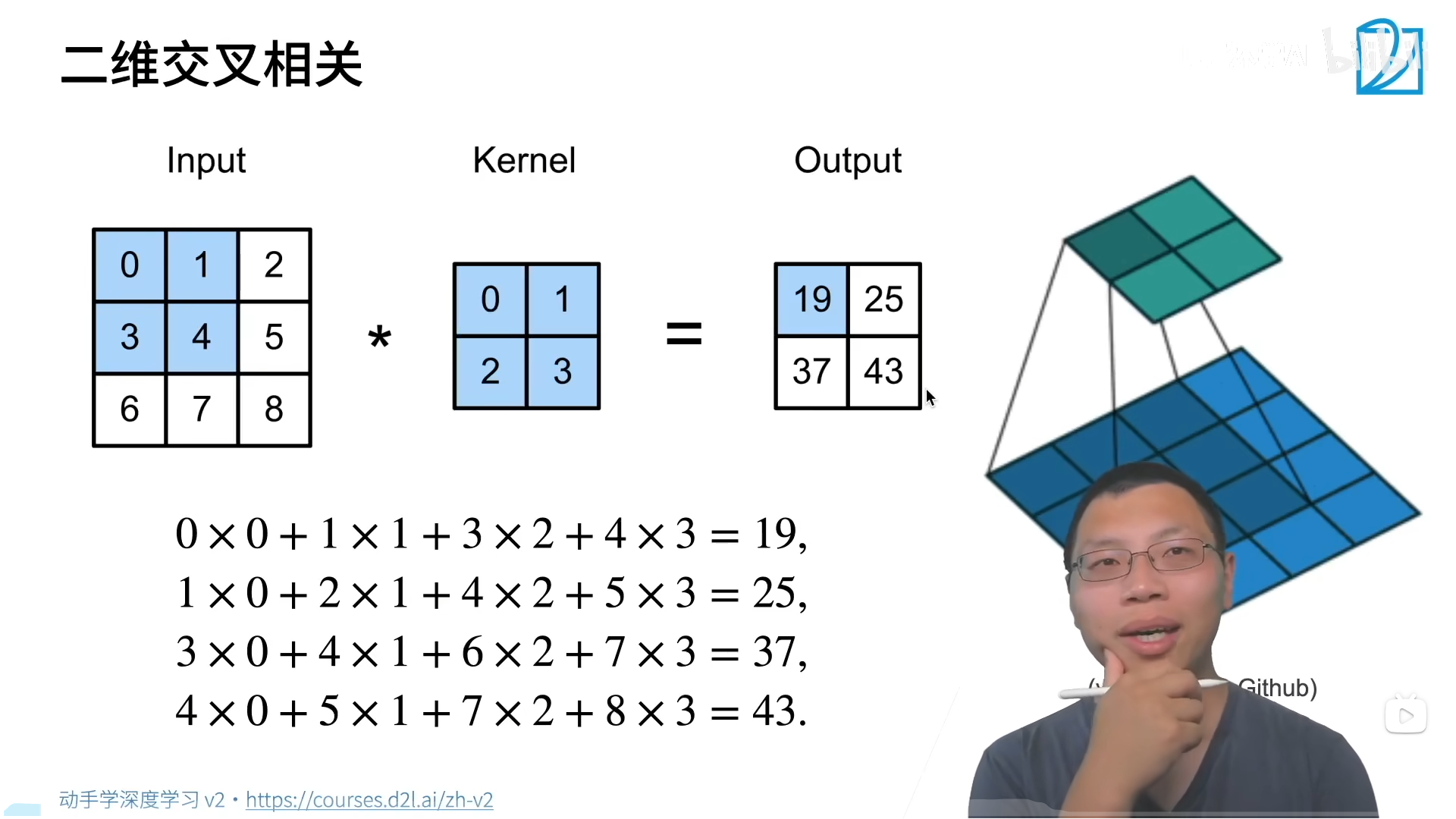

卷积计算,卷积核2*2:

二维卷积层,输出Y:

(

n

k

−

k

h

+

1

)

∗

(

n

w

−

k

w

+

1

)

(n_k-k_h+1)*(n_w-k_w+1)

(nk−kh+1)∗(nw−kw+1),少了

k

−

1

k-1

k−1:

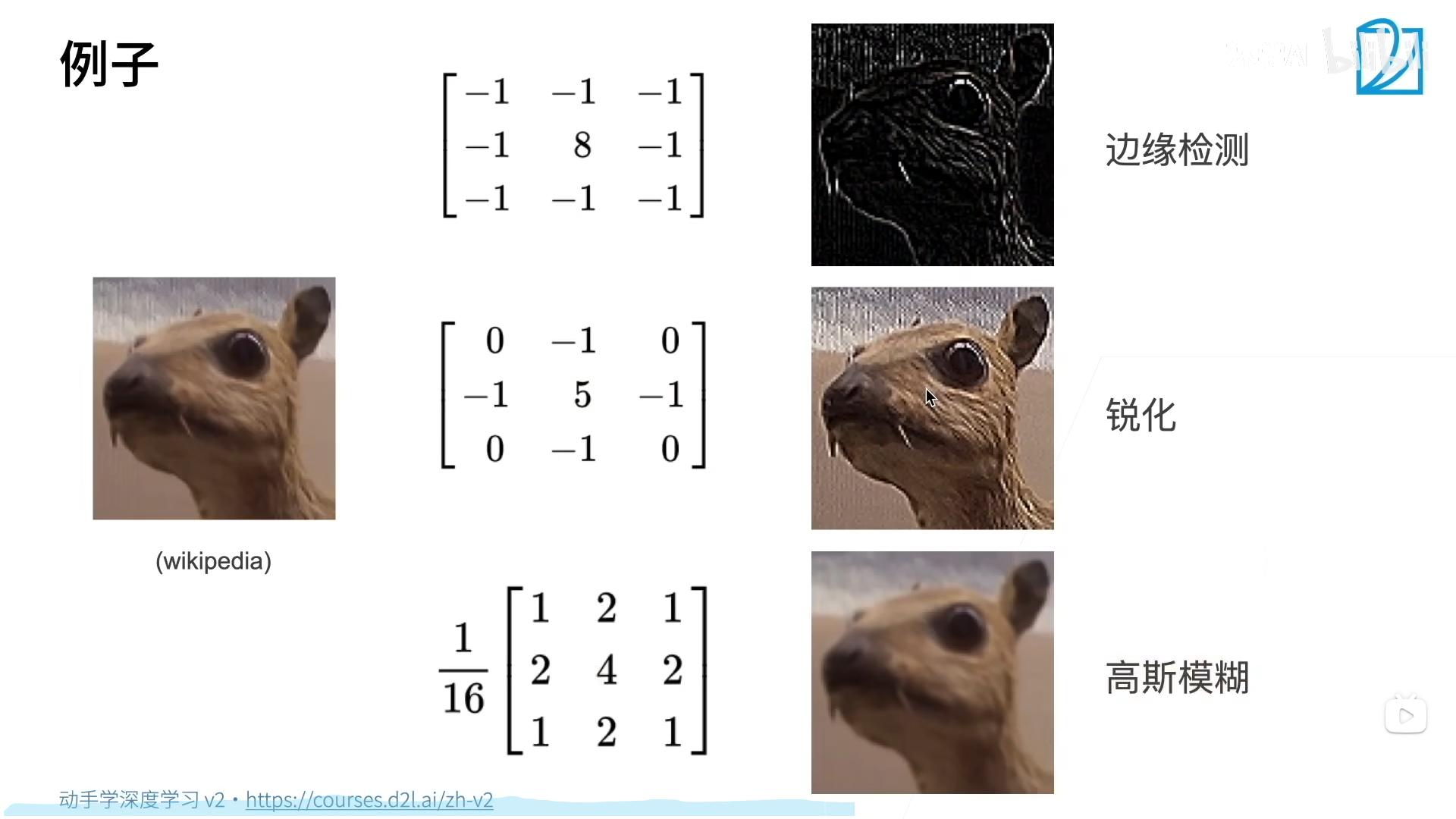

不同卷积核带来的效果,不同的任务决定最后卷积核的样子:

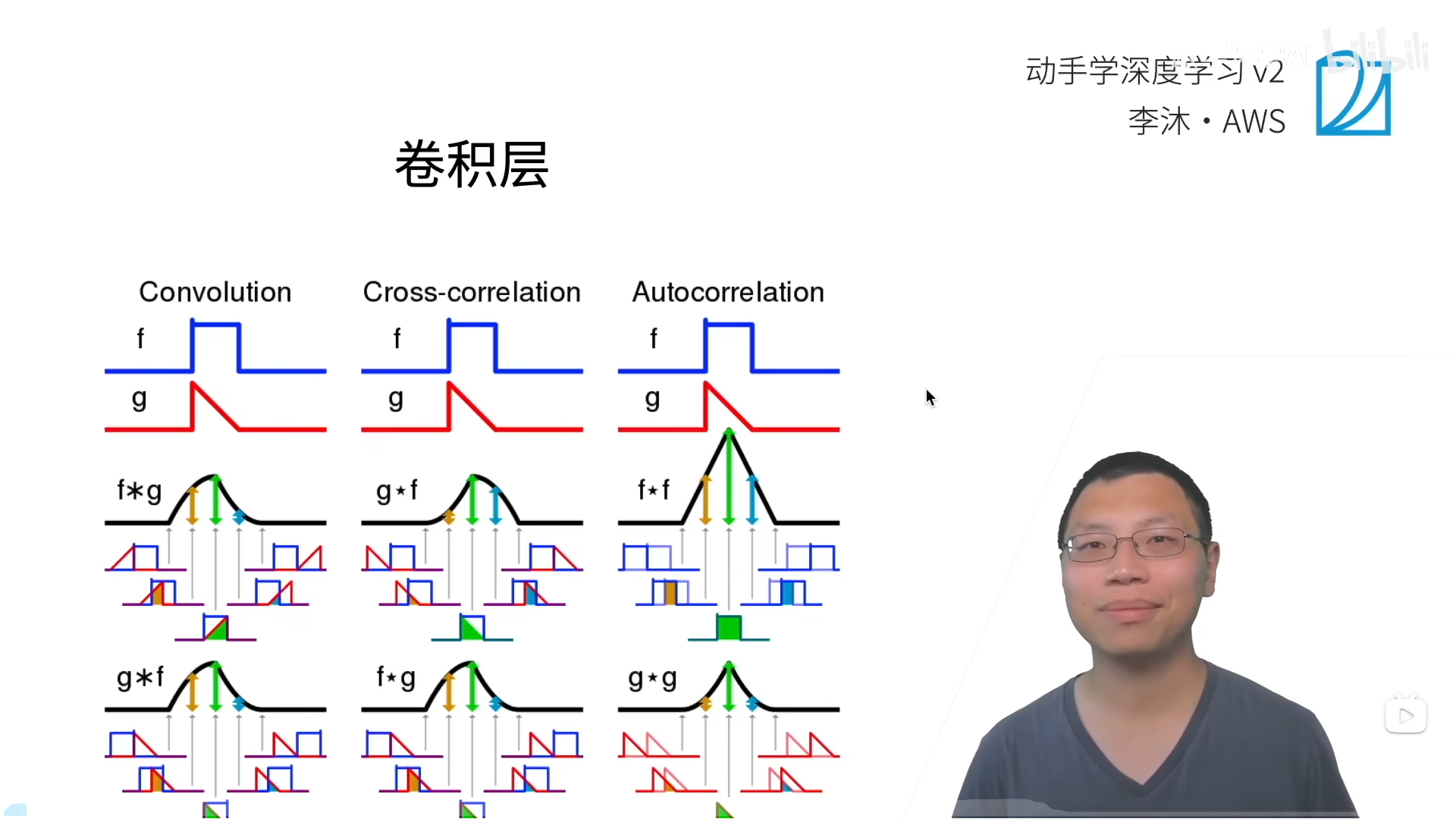

虽然说是卷积层,实现时其实是交叉相关:

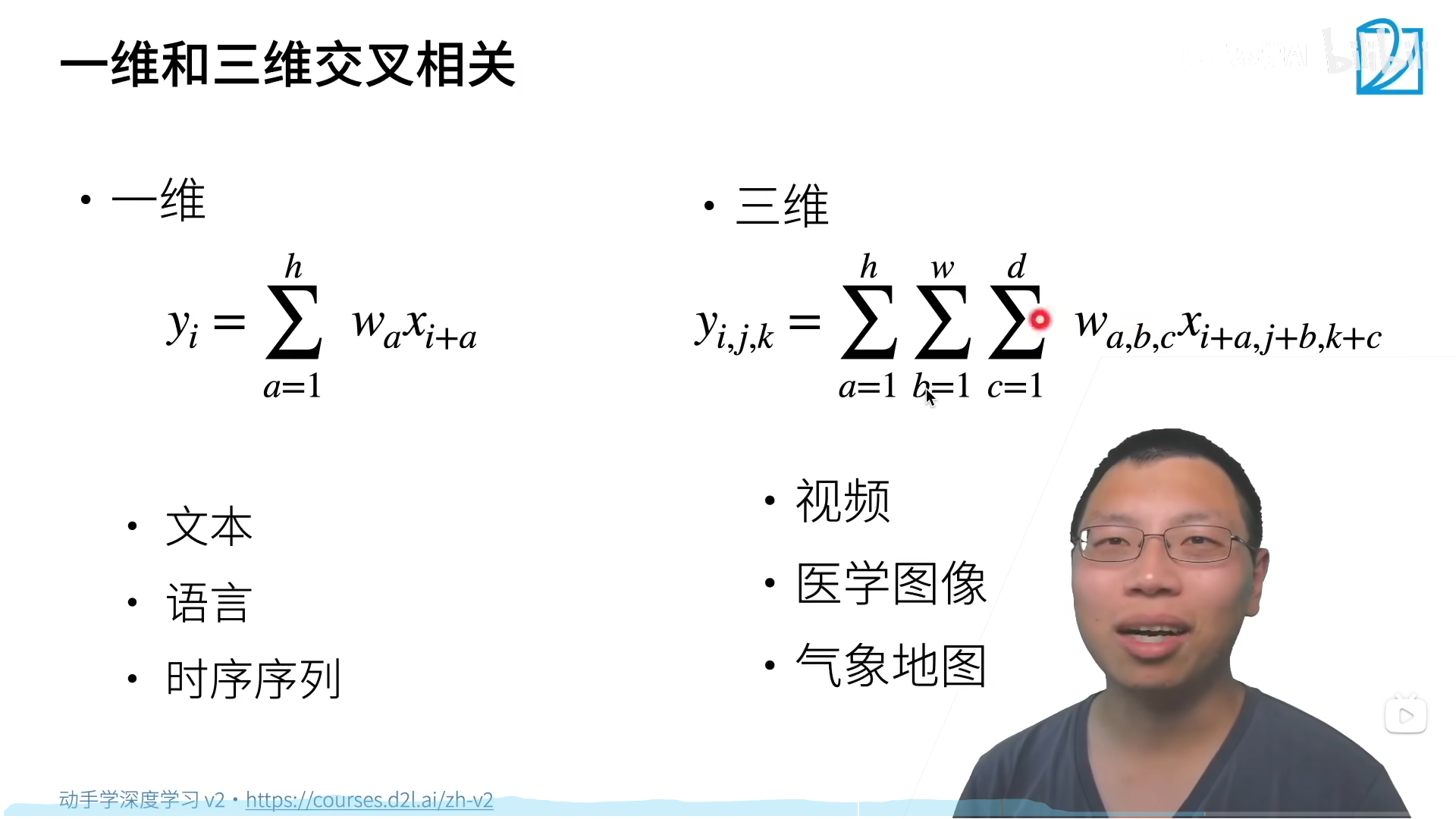

一维卷积与三维卷积:

卷积核的大小控制了局部性,是超参数:

动手学

互相关运算

import torch

from torch import nn

from d2l import torch as d2l

def corr2d(X, K): #@save

"""计算二维互相关运算"""

h, w = K.shape

Y = torch.zeros((X.shape[0] - h + 1, X.shape[1] - w + 1))

for i in range(Y.shape[0]):

for j in range(Y.shape[1]):

Y[i, j] = (X[i:i + h, j:j + w] * K).sum()

return Y

X = torch.tensor([[0.0, 1.0, 2.0], [3.0, 4.0, 5.0], [6.0, 7.0, 8.0]])

K = torch.tensor([[0.0, 1.0], [2.0, 3.0]])

corr2d(X, K)

tensor([[19., 25.],

[37., 43.]])

实现二维卷积层

class Conv2D(nn.Module):

def __init__(self, kernel_size):

super().__init__()

self.weight = nn.Parameter(torch.rand(kernel_size)) # 0-1

self.bias = nn.Parameter(torch.zeros(1))

def forward(self, x):

return corr2d(x, self.weight) + self.bias

图像中目标的边缘检测

X = torch.ones((6, 8)) # 图像

X[:, 2:6] = 0

X

tensor([[1., 1., 0., 0., 0., 0., 1., 1.],

[1., 1., 0., 0., 0., 0., 1., 1.],

[1., 1., 0., 0., 0., 0., 1., 1.],

[1., 1., 0., 0., 0., 0., 1., 1.],

[1., 1., 0., 0., 0., 0., 1., 1.],

[1., 1., 0., 0., 0., 0., 1., 1.]])

K = torch.tensor([[1.0, -1.0]]) # 卷积核

K

tensor([[ 1., -1.]])

Y = corr2d(X, K)

Y

tensor([[ 0., 1., 0., 0., 0., -1., 0.],

[ 0., 1., 0., 0., 0., -1., 0.],

[ 0., 1., 0., 0., 0., -1., 0.],

[ 0., 1., 0., 0., 0., -1., 0.],

[ 0., 1., 0., 0., 0., -1., 0.],

[ 0., 1., 0., 0., 0., -1., 0.]])

corr2d(X.t(), K) # 无法做垂直检测

tensor([[0., 0., 0., 0., 0.],

[0., 0., 0., 0., 0.],

[0., 0., 0., 0., 0.],

[0., 0., 0., 0., 0.],

[0., 0., 0., 0., 0.],

[0., 0., 0., 0., 0.],

[0., 0., 0., 0., 0.],

[0., 0., 0., 0., 0.]])

学习卷积核

# 构造一个二维卷积层,它具有1个输出通道和形状为(1,2)的卷积核

conv2d = nn.Conv2d(1,1, kernel_size=(1, 2), bias=False)

# 这个二维卷积层使用四维输入和输出格式(批量大小、通道、高度、宽度),

# 其中批量大小和通道数都为1

X = X.reshape((1, 1, 6, 8))

Y = Y.reshape((1, 1, 6, 7))

lr = 3e-2 # 学习率

for i in range(10):

Y_hat = conv2d(X)

l = (Y_hat - Y) ** 2

conv2d.zero_grad()

l.sum().backward()

# 迭代卷积核

conv2d.weight.data[:] -= lr * conv2d.weight.grad

if (i + 1) % 2 == 0:

print(f'epoch {i+1}, loss {l.sum():.3f}')

epoch 2, loss 2.274

epoch 4, loss 0.508

epoch 6, loss 0.137

epoch 8, loss 0.044

epoch 10, loss 0.016

conv2d.weight.data.reshape((1, 2))

tensor([[ 0.9806, -1.0056]])