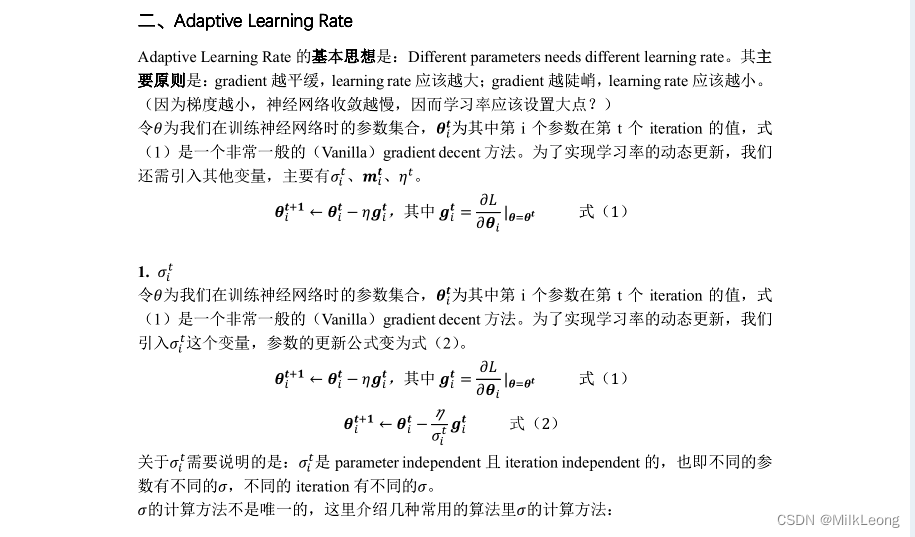

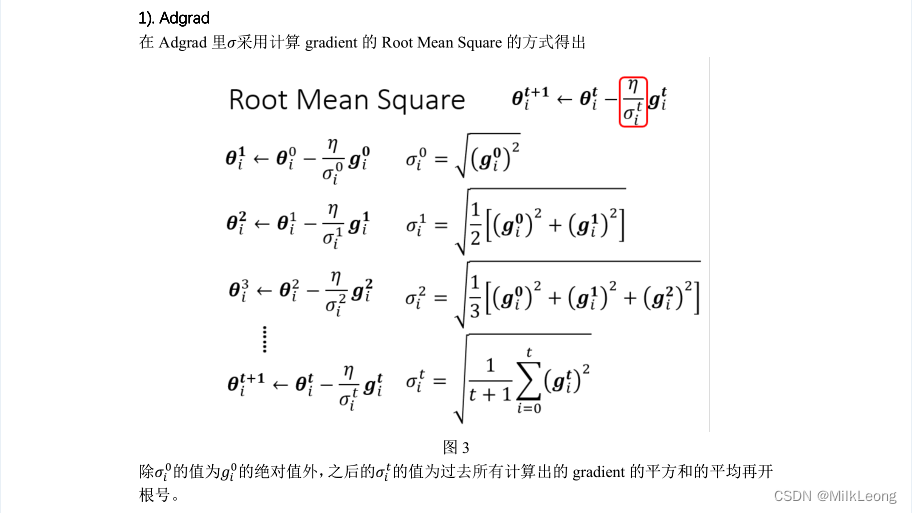

本节课主要介绍了Adaptive Learning Rate的基本思想和方法。通过使用Adaptive Learning Rate的策略,在训练深度神经网络时程序能实现在不同参数、不同iteration中,学习率不同。

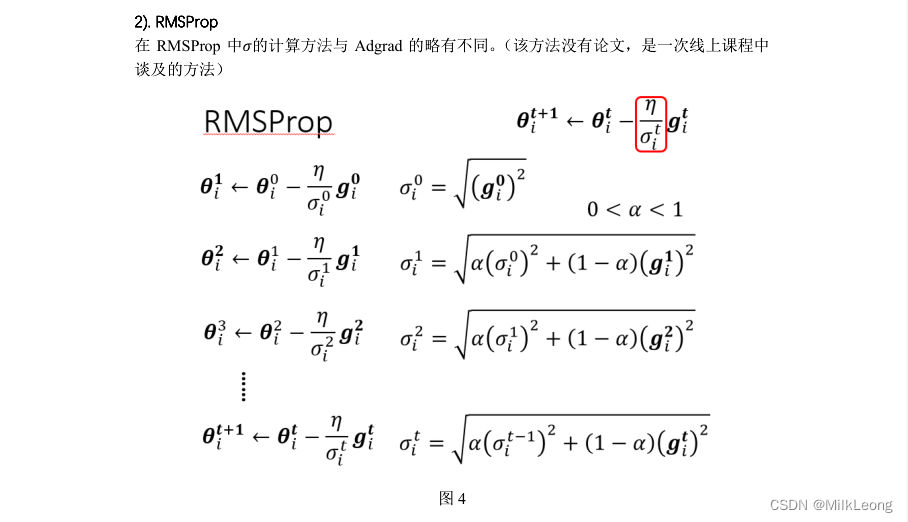

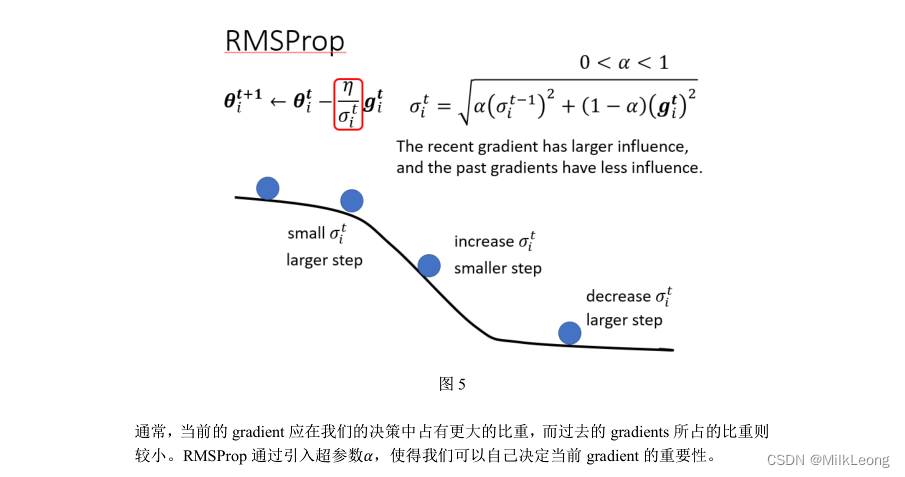

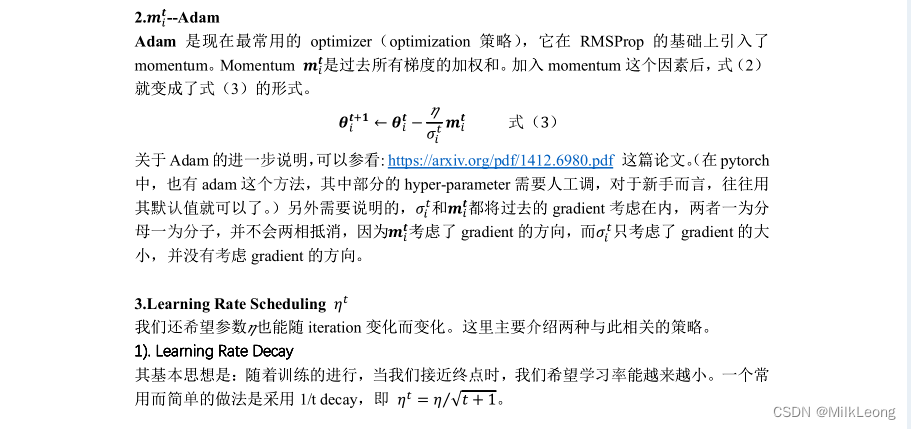

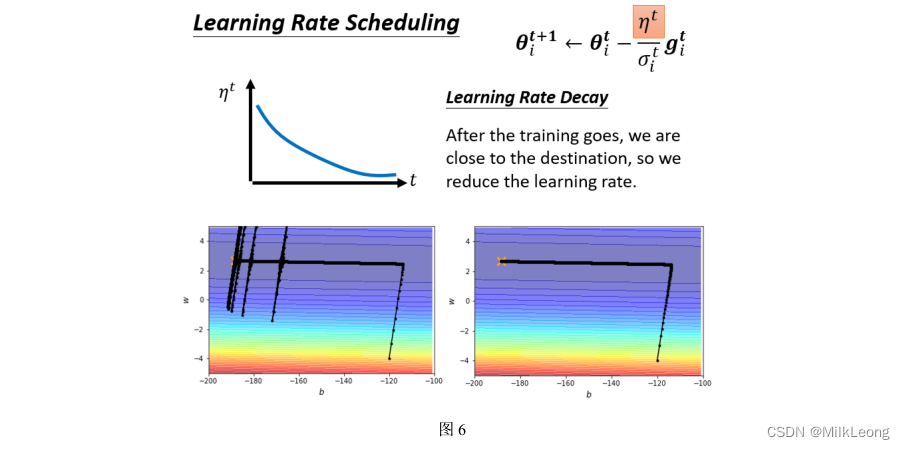

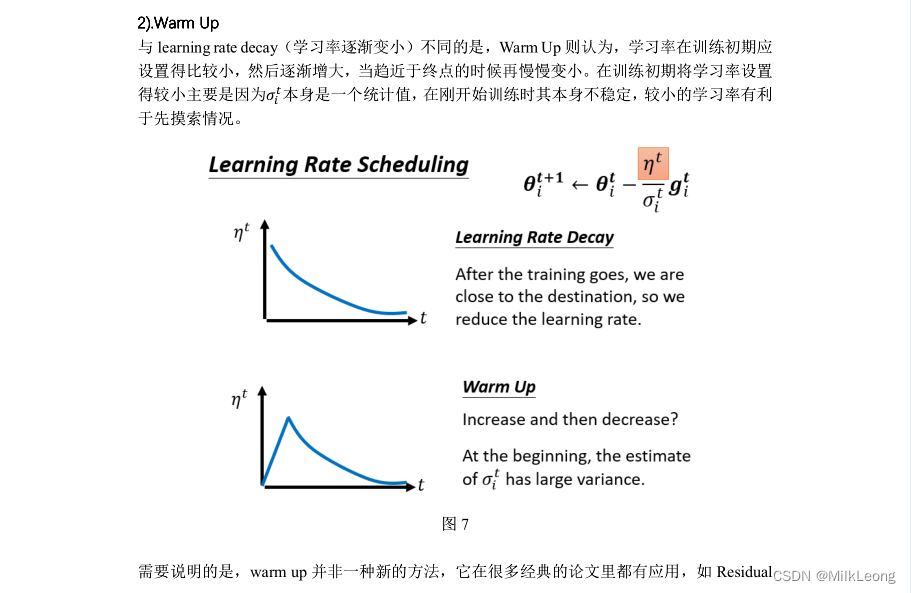

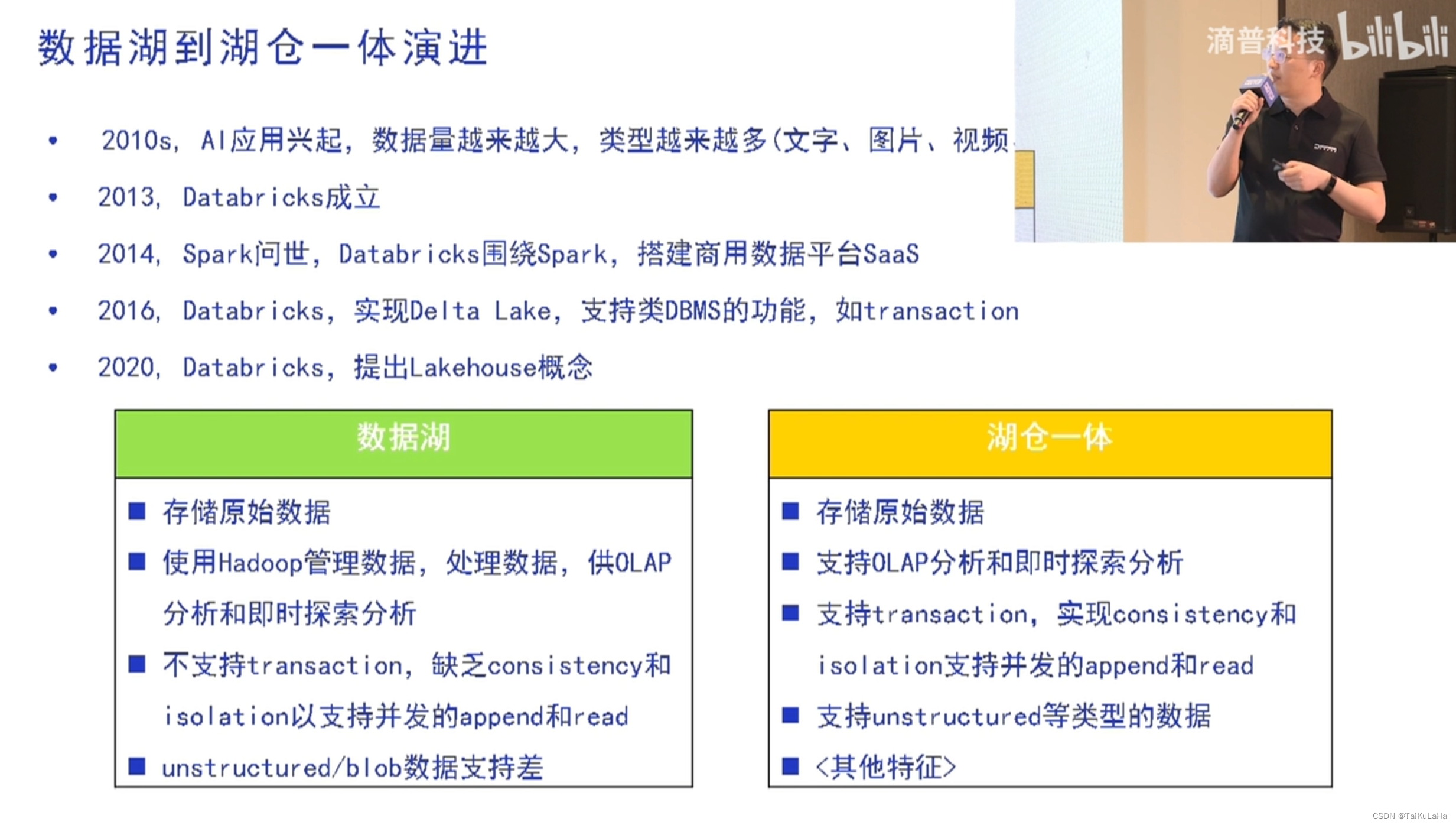

本节课涉及到的算法或策略有:Adgrad、RMSProp、Adam、Learning Rate Decay、Warm Up。

本节课参考的资料有:

MIT-Deep Learning:https://www.deeplearningbook.org/

Adam:https://arxiv.org/pdf/1412.6980.pdf

Residual Network:https://arxiv.org/abs/1512.03385

Transformer:https://arxiv.org/abs/1706.03762

RAdam:https://arxiv.org/abs/1908.03265