contents

- hw12 - 不知道该起个什么名字

- task1

- 题目内容

- 题目分析+题目解答

- 题目总结

- task2

- 题目内容

- 题目分析+题目解答

- 题目总结

- task3

- 题目内容

- 题目分析+题目解答

- 题目总结

- 写在最后

hw12 - 不知道该起个什么名字

task1

题目内容

在小批量梯度下降中,尝试分析为什么学习率要和批量大小成正比。

题目分析+题目解答

首先是小批量梯度下降的中有:

g

t

(

θ

)

=

1

K

∑

(

x

,

y

)

∈

S

t

∂

L

(

y

,

f

(

x

;

θ

)

∂

θ

g_t(\theta)=\frac{1}{K}\sum_{(x,y) \in S_t} \frac{\partial L(y, f(x;\theta)}{\partial \theta}

gt(θ)=K1(x,y)∈St∑∂θ∂L(y,f(x;θ)

θ

t

=

θ

t

−

1

−

α

g

t

\theta_t = \theta_{t-1} - \alpha g_t

θt=θt−1−αgt

==>

θ

t

=

θ

t

−

1

−

α

K

∑

(

x

,

y

)

∈

S

t

∂

L

(

y

,

f

(

x

;

θ

)

∂

θ

\theta_t = \theta_{t-1} - \frac{\alpha}{K}\sum_{(x,y) \in S_t} \frac{\partial L(y, f(x;\theta)}{\partial \theta}

θt=θt−1−Kα(x,y)∈St∑∂θ∂L(y,f(x;θ)

不难发现

α

∝

α

K

∝

θ

t

\alpha \propto \frac{\alpha}{K} \propto \theta_t

α∝Kα∝θt,学习率和批量大小成正比时效果最好。

□

\square

□

题目总结

本题考查的是梯度下降中梯度和参数更新的公式,以及对于公式的理解。

task2

题目内容

在Adam算法中,说明指数加权平均的偏差修正的合理性。

题目分析+题目解答

我们知道Adam算法的算法逻辑和更新规则:

不难发现,当

ρ

1

→

1

且

ρ

2

→

1

\rho_1→1且\rho_2→1

ρ1→1且ρ2→1时,

lim

ρ

1

→

1

s

t

=

s

t

−

1

,

lim

ρ

2

→

1

r

t

=

r

t

−

1

\lim_{\rho_1→1}s_t=s_{t-1},\lim_{\rho_2→1}r_t=r_{t-1}

limρ1→1st=st−1,limρ2→1rt=rt−1,此时梯度消失,指数加权平均需要进行偏差修正。

□

\square

□

题目总结

本题考查的是Adam算法更新参数的过程,以及其存在的梯度消失问题和偏差修正算法。

task3

题目内容

证明在标准的随机梯度下降中,权重衰减正则化和 l 2 l2 l2正则化的效果相同。并分析这一结论在动量法和Adam算法中是否依然成立。

题目分析+题目解答

设

L

0

L_0

L0为第t步时的损失函数,则

L

t

=

L

0

+

λ

Ω

(

θ

)

=

λ

2

∣

∣

ω

∣

∣

2

L_t = L_0 + \lambda \Omega(\theta)=\frac{\lambda}{2}||\omega||^2

Lt=L0+λΩ(θ)=2λ∣∣ω∣∣2

∂

L

∂

ω

=

∂

L

0

∂

ω

+

λ

ω

,

∂

L

∂

b

=

∂

L

0

∂

b

\frac{\partial L}{\partial \omega} = \frac{\partial L_0}{\partial \omega} + \lambda \omega, \frac{\partial L}{\partial b} = \frac{\partial L_0}{\partial b}

∂ω∂L=∂ω∂L0+λω,∂b∂L=∂b∂L0

进行SGD,可得:

ω

n

e

w

←

ω

−

η

(

∂

L

0

∂

ω

+

λ

ω

)

\omega_{new}←\omega - \eta(\frac{\partial L_0}{\partial \omega} + \lambda \omega)

ωnew←ω−η(∂ω∂L0+λω)

=

(

1

−

η

λ

)

ω

−

η

∂

L

0

∂

ω

=(1-\eta\lambda)\omega-\eta\frac{\partial L_0}{\partial \omega}

=(1−ηλ)ω−η∂ω∂L0

同理,

b

n

e

w

←

b

−

η

∂

L

0

∂

b

b_{new}←b-\eta\frac{\partial L_0}{\partial b}

bnew←b−η∂b∂L0

可得:

θ

t

←

(

1

−

β

)

θ

t

−

1

−

α

g

t

\theta_t←(1-\beta)\theta_{t-1}-\alpha g_t

θt←(1−β)θt−1−αgt

令

β

=

η

λ

\beta=\eta\lambda

β=ηλ或令

λ

=

η

β

\lambda=\frac{\eta}{\beta}

λ=βη可使权重衰减正则化和

l

2

l2

l2正则化的效果相同。

□

\square

□

对于Adam算法,L2正则化梯度更新的方向取决于最近一段时间内梯度的加权平均值。当与自适应梯度相结合时(动量法和Adam算法),L2正则化导致导致具有较大历史参数 (和/或) 梯度振幅的权重被正则化的程度小于使用权值衰减时的情况。

题目总结

本题考查的是正则化的计算和参数更新的过程,以及其在特殊情况下的等价情况。

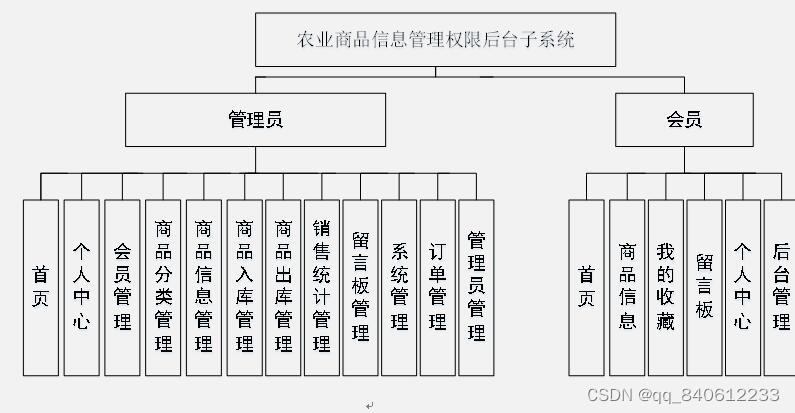

写在最后

本章介绍了网络正则化和网络优化的相关知识,通过学习这些内容,我们能够对于网络的优化问题有一个很好的认识,这边给出这一章的思维导图:

![[附源码]Python计算机毕业设计大学生心理健康管理系统Django(程序+LW)](https://img-blog.csdnimg.cn/369126f18532485a9c75937bc916f9fb.png)