本笔记内容为黑马头条项目的新需求-自管理敏感词部分

目录

一、需求分析

二、敏感词-过滤

三、DFA实现原理

SensitiveWordUtil工具类

四、自管理敏感词集成到文章审核中

一、需求分析

文章审核功能已经交付了,文章也能正常发布审核。突然,产品经理过来说要开会。

会议的内容核心有以下内容:

-

文章审核不能过滤一些敏感词:

私人侦探、针孔摄象、信用卡提现、广告代理、代开发票、刻章办、出售答案、小额贷款…

需要完成的功能:

需要自己维护一套敏感词,在文章审核的时候,需要验证文章是否包含这些敏感词

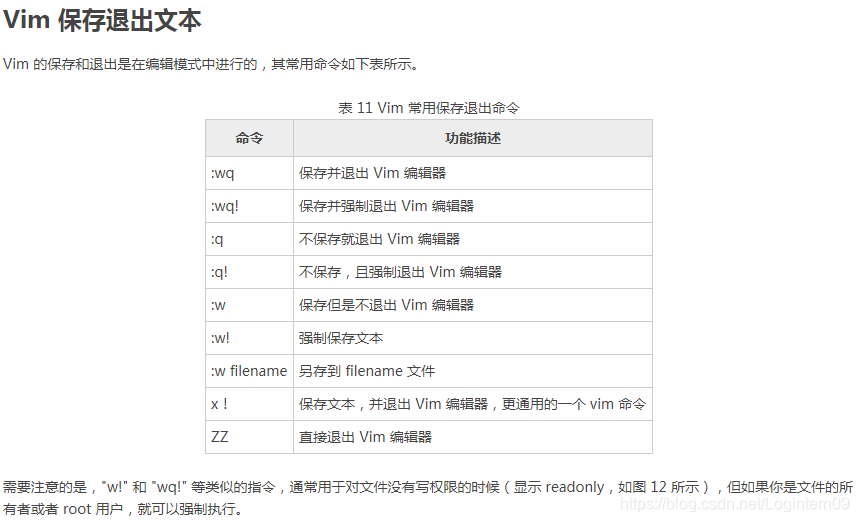

二、敏感词-过滤

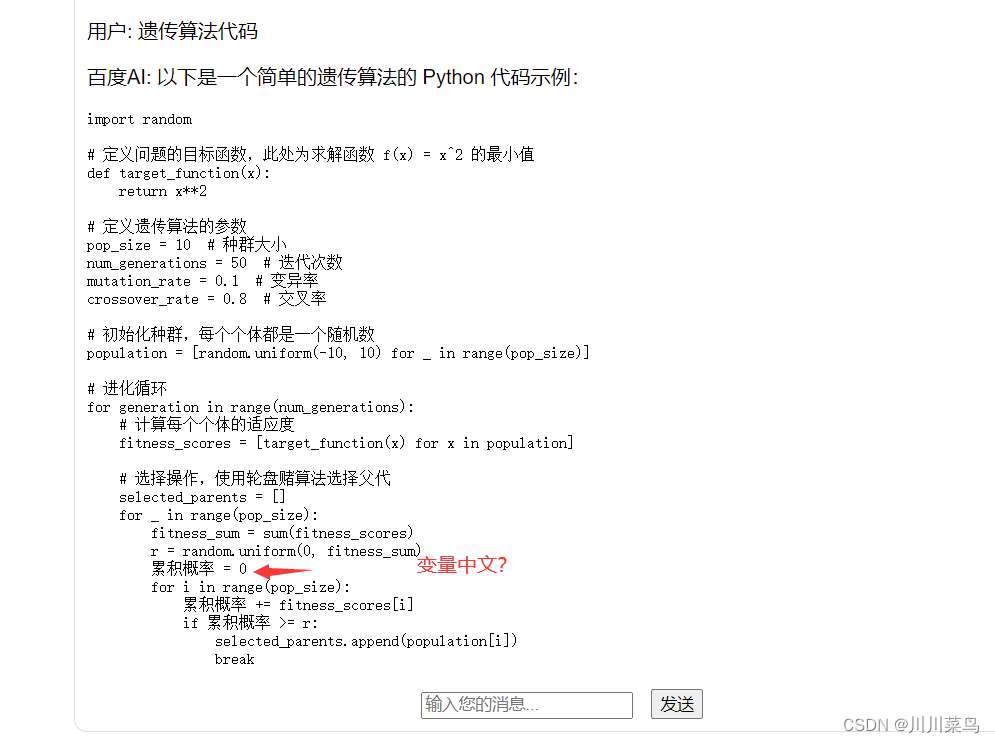

技术选型

| 方案 | 说明 |

|---|---|

| 数据库模糊查询 | 效率太低 |

| String.indexOf("")查找 | 数据库量大的话也是比较慢 |

| 全文检索 | 分词再匹配 |

| DFA算法 | 确定有穷自动机(一种数据结构) |

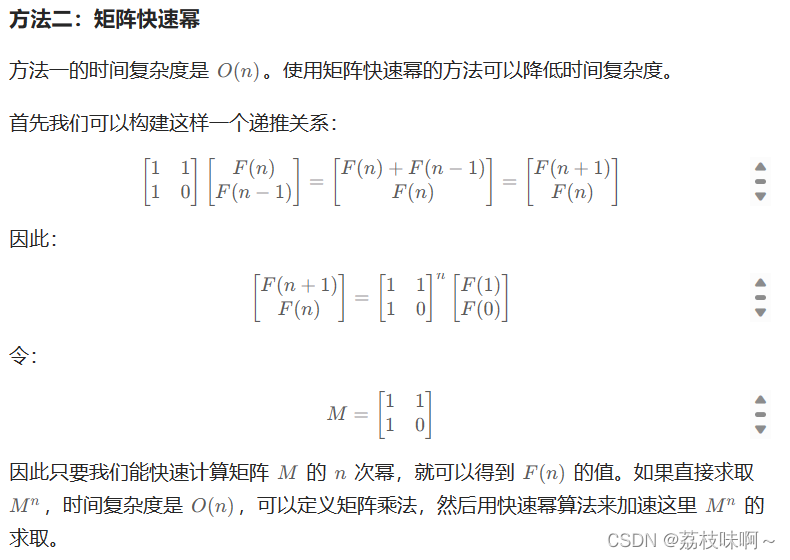

三、DFA实现原理

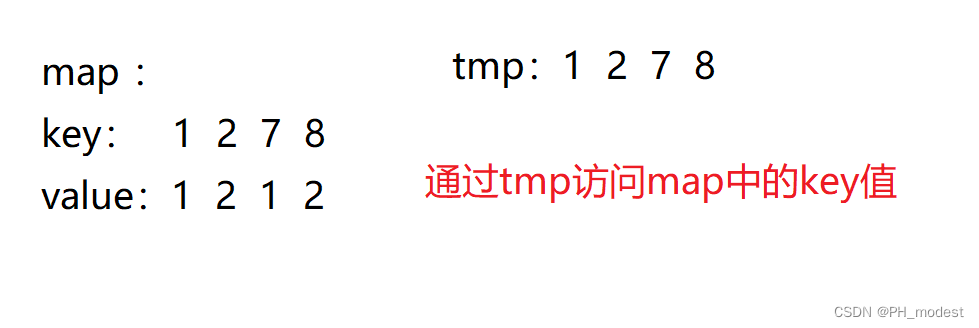

DFA全称为:Deterministic Finite Automaton,即确定有穷自动机。

存储:一次性的把所有的敏感词存储到了多个map中,就是下图表示这种结构

敏感词:冰毒、大麻、大坏蛋

检索的过程

SensitiveWordUtil工具类

package com.heima.utils.common;

import java.util.*;

public class SensitiveWordUtil {

public static Map<String, Object> dictionaryMap = new HashMap<>();

/**

* 生成关键词字典库

* @param words

* @return

*/

public static void initMap(Collection<String> words) {

if (words == null) {

System.out.println("敏感词列表不能为空");

return ;

}

// map初始长度words.size(),整个字典库的入口字数(小于words.size(),因为不同的词可能会有相同的首字)

Map<String, Object> map = new HashMap<>(words.size());

// 遍历过程中当前层次的数据

Map<String, Object> curMap = null;

Iterator<String> iterator = words.iterator();

while (iterator.hasNext()) {

String word = iterator.next();

curMap = map;

int len = word.length();

for (int i =0; i < len; i++) {

// 遍历每个词的字

String key = String.valueOf(word.charAt(i));

// 当前字在当前层是否存在, 不存在则新建, 当前层数据指向下一个节点, 继续判断是否存在数据

Map<String, Object> wordMap = (Map<String, Object>) curMap.get(key);

if (wordMap == null) {

// 每个节点存在两个数据: 下一个节点和isEnd(是否结束标志)

wordMap = new HashMap<>(2);

wordMap.put("isEnd", "0");

curMap.put(key, wordMap);

}

curMap = wordMap;

// 如果当前字是词的最后一个字,则将isEnd标志置1

if (i == len -1) {

curMap.put("isEnd", "1");

}

}

}

dictionaryMap = map;

}

/**

* 搜索文本中某个文字是否匹配关键词

* @param text

* @param beginIndex

* @return

*/

private static int checkWord(String text, int beginIndex) {

if (dictionaryMap == null) {

throw new RuntimeException("字典不能为空");

}

boolean isEnd = false;

int wordLength = 0;

Map<String, Object> curMap = dictionaryMap;

int len = text.length();

// 从文本的第beginIndex开始匹配

for (int i = beginIndex; i < len; i++) {

String key = String.valueOf(text.charAt(i));

// 获取当前key的下一个节点

curMap = (Map<String, Object>) curMap.get(key);

if (curMap == null) {

break;

} else {

wordLength ++;

if ("1".equals(curMap.get("isEnd"))) {

isEnd = true;

}

}

}

if (!isEnd) {

wordLength = 0;

}

return wordLength;

}

/**

* 获取匹配的关键词和命中次数

* @param text

* @return

*/

public static Map<String, Integer> matchWords(String text) {

Map<String, Integer> wordMap = new HashMap<>();

int len = text.length();

for (int i = 0; i < len; i++) {

int wordLength = checkWord(text, i);

if (wordLength > 0) {

String word = text.substring(i, i + wordLength);

// 添加关键词匹配次数

if (wordMap.containsKey(word)) {

wordMap.put(word, wordMap.get(word) + 1);

} else {

wordMap.put(word, 1);

}

i += wordLength - 1;

}

}

return wordMap;

}

//测试

public static void main(String[] args) {

List<String> list = new ArrayList<>();

list.add("法轮");

list.add("法轮功");

list.add("冰毒");

initMap(list);

String content="我是一个好人,并不会卖冰毒,也不操练法轮功,我真的不卖冰毒";

Map<String, Integer> map = matchWords(content);

System.out.println(map);

}

}

四、自管理敏感词集成到文章审核中

①:创建敏感词表,导入资料中wm_sensitive到leadnews_wemedia库中

(在表里面存入要过滤的敏感词数据)

package com.heima.model.wemedia.pojos;

import com.baomidou.mybatisplus.annotation.IdType;

import com.baomidou.mybatisplus.annotation.TableField;

import com.baomidou.mybatisplus.annotation.TableId;

import com.baomidou.mybatisplus.annotation.TableName;

import lombok.Data;

import java.io.Serializable;

import java.util.Date;

/**

* <p>

* 敏感词信息表

* </p>

*

* @author itheima

*/

@Data

@TableName("wm_sensitive")

public class WmSensitive implements Serializable {

private static final long serialVersionUID = 1L;

/**

* 主键

*/

@TableId(value = "id", type = IdType.AUTO)

private Integer id;

/**

* 敏感词

*/

@TableField("sensitives")

private String sensitives;

/**

* 创建时间

*/

@TableField("created_time")

private Date createdTime;

}②:拷贝对应的wm_sensitive的mapper到项目中

package com.heima.wemedia.mapper;

import com.baomidou.mybatisplus.core.mapper.BaseMapper;

import com.heima.model.wemedia.pojos.WmSensitive;

import org.apache.ibatis.annotations.Mapper;

@Mapper

public interface WmSensitiveMapper extends BaseMapper<WmSensitive> {

}③:在文章审核的代码中添加自管理敏感词审核

第一:在WmNewsAutoScanServiceImpl中的autoScanWmNews方法上添加如下代码

//从内容中提取纯文本内容和图片

//.....省略

//自管理的敏感词过滤

boolean isSensitive = handleSensitiveScan((String) textAndImages.get("content"), wmNews);

if(!isSensitive) return;

//2.审核文本内容 阿里云接口

//.....省略新增自管理敏感词审核代码(获取数据库的敏感词对文章内容进行过滤)

@Autowired

private WmSensitiveMapper wmSensitiveMapper;

/**

* 自管理的敏感词审核

* @param content

* @param wmNews

* @return

*/

private boolean handleSensitiveScan(String content, WmNews wmNews) {

boolean flag = true;

//获取所有的敏感词

List<WmSensitive> wmSensitives = wmSensitiveMapper.selectList(Wrappers.<WmSensitive>lambdaQuery().select(WmSensitive::getSensitives));

List<String> sensitiveList = wmSensitives.stream().map(WmSensitive::getSensitives).collect(Collectors.toList());

//初始化敏感词库

SensitiveWordUtil.initMap(sensitiveList);

//查看文章中是否包含敏感词

Map<String, Integer> map = SensitiveWordUtil.matchWords(content);

if(map.size() >0){

updateWmNews(wmNews,(short) 2,"当前文章中存在违规内容"+map);

flag = false;

}

return flag;

}