目录

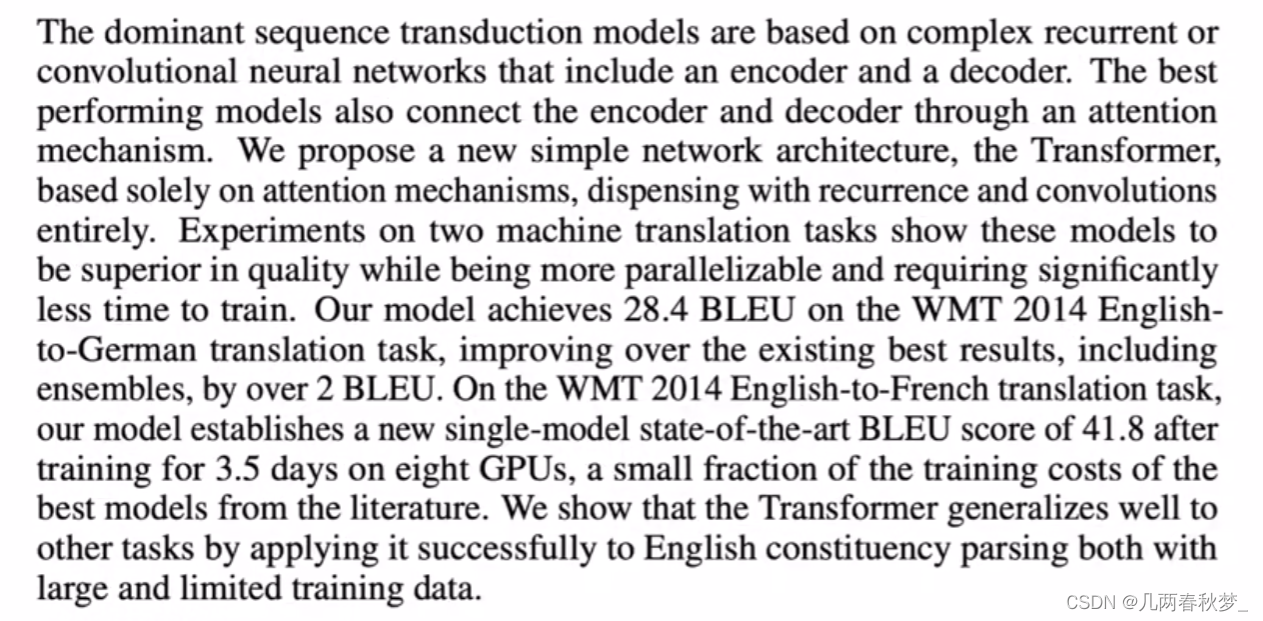

Abstract

Conclusion

Introduction

Background

Training

Abstract

在一个序列转录模型中,在编码器与译码器之间使用一个“注意力机制”的东西,做了两个机器翻译的实验,效果较其他模型效果更好。

Conclusion

Transformer是第一个用于序列转录的模型,仅仅使用注意力机制。在机器翻译模型上,Transformer要比其他架构快很多,而且效果更好。

Introduction

讲述了RNN的缺点 ,在RNN模型中把之前的信息全部放入隐藏状态下,在时间上无法并行,使得在计算上性能比较差。

这一段讲述了Transformer不再使用之前的循环神经层 ,而是纯基于注意力机制,所以并行度比较高,在短时间内做出做到一个更好的结果。

Background

提出了如何使用卷积神经网络来替换掉你的循环神经网络使得减少时序的计算,同时提出卷积可以做多个输出通道,一个输出通道可认为它可以去识别不一样的模式

Training

训练数据集的来源及处理

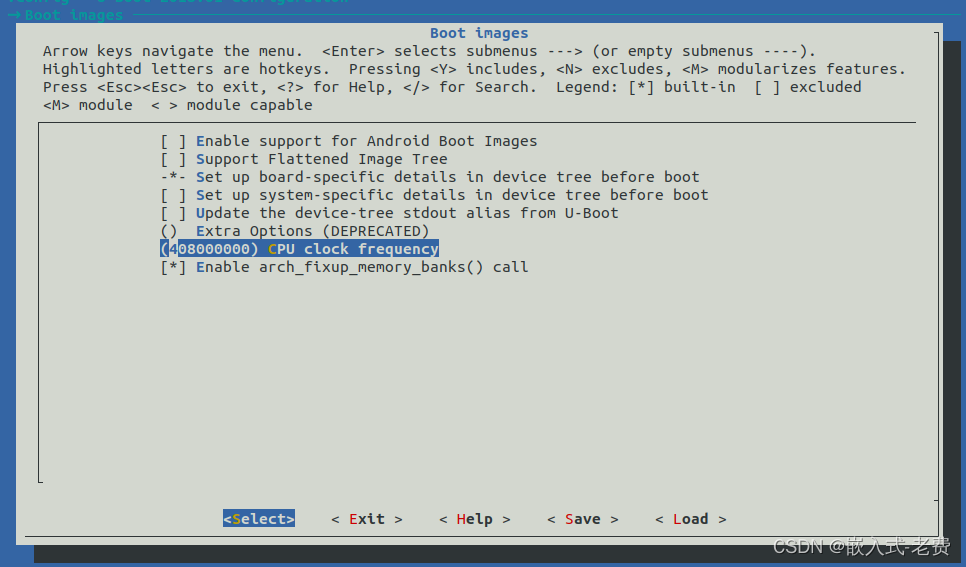

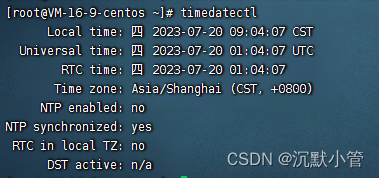

使用设备部分,训练使用了8个P100DE的GPU,在8个GPU上共训练了12个小时。

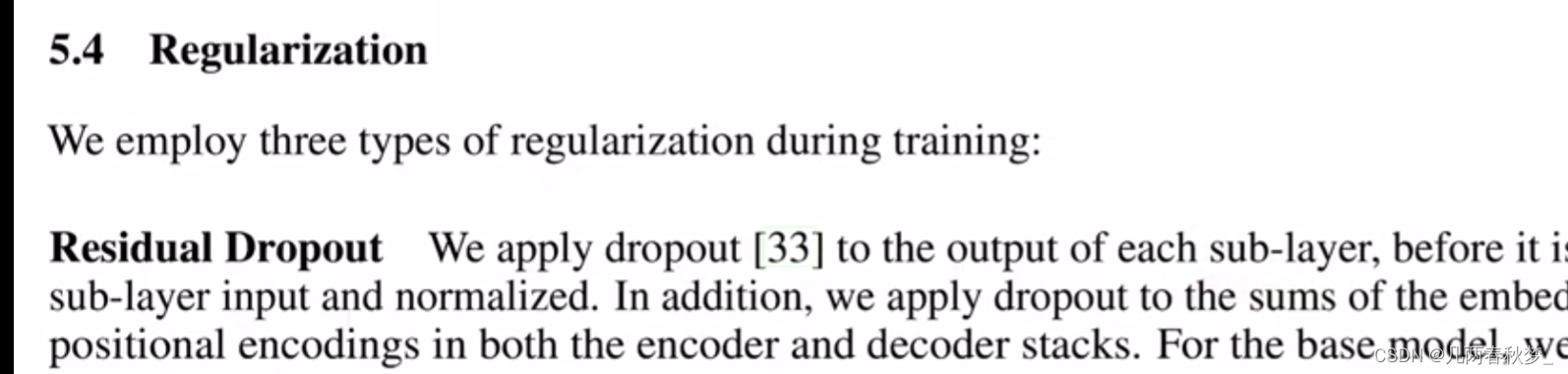

正则化,使用大量的dropout层来对模型进行正则化

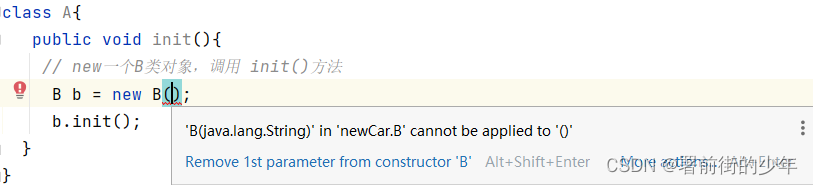

![Type [unknown] not present(主要问题是jar冲突)](https://img-blog.csdnimg.cn/7e09d719aff34c0ba35e9cc5881c00cc.png)