第六章. Theory of Generalization

上一章节我们主要探讨了M数值的大小对机器学习的影响。若M很大,我们就不能保证机器学习有很好的泛化能力,所以我们的问题就转换成验证M有限,最好是按照多项式成长,然后引入了成长函数mH(N)和二分类以及break point的概念,提出2D perceptrons的成长函数mH(N)是多项式级别的猜想。本章节将深入探讨和证明这部分内容。

6.1 Restriction of Break Point

1.统计学层面机器学习流程图

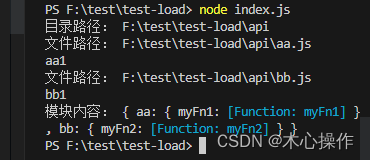

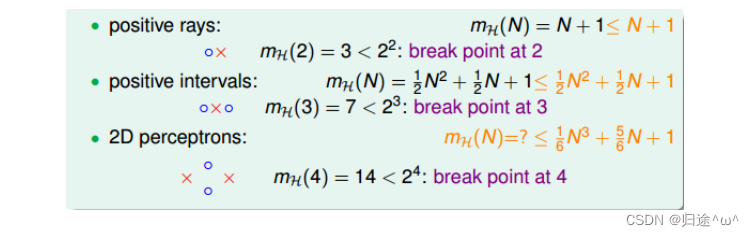

1).4种成长函数与break point的关系:

2).示例

·示例:

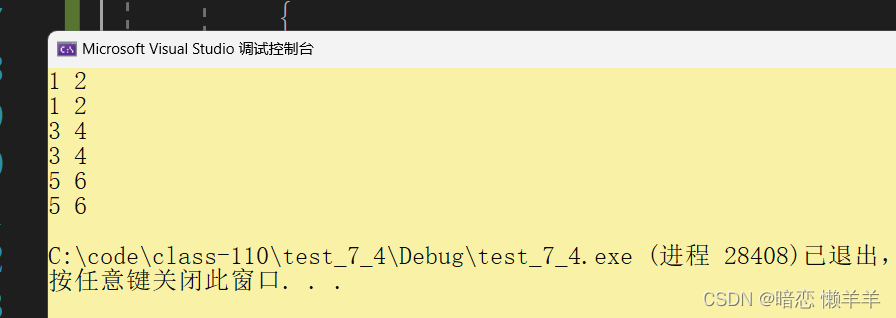

若k=2(k为break point出现的位置),那么当N(点的数量)取不同值时,计算成长函数mH(N)的值。

①.当N=1时,mH(N)=2;

②.当N=2时,mH(N)=3;

③.当N=3时,mH(N)=4;

·总结:

a).当N>k时,break point就会限制mH(N)的大小,影响成长函数mH(N)的主要因素有两个:

①.抽样数据集N

②.break point k

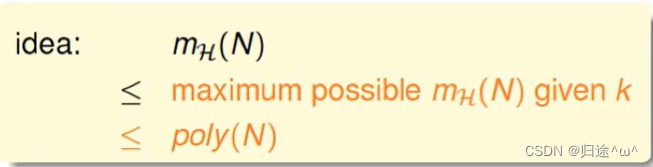

b).若给定N和k,能够证明成长函数mH(N)最大值的上界是多项式,在根据Hoeffding’s inequality,就能用mH(N)来代替M,证明机器学习是可行的,所以证明成长函数mH(N)的上界是多项式poly(N),就是我们的目标。

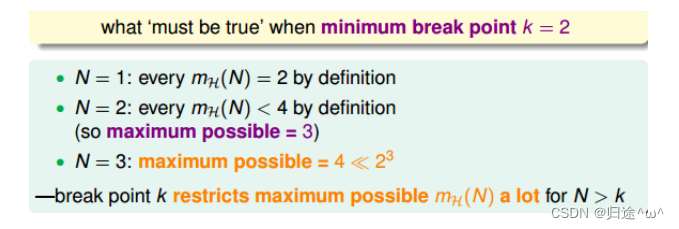

6.2 Bounding Function: Basic Cases

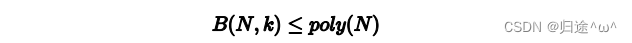

1.bounding function

1).定义

·bounding function:当break point=k时,成长函数mH(N)可能出现的最大值 ,简写为B(N,k),就是mH(N)的上界,对应mH(N)最多有多少种dichotomy,我们的目标就是证明:

注意: B(N,k)的引入不考虑是1D postive intrervals问题还是2Dperceptrons问题,而只关心成长函数的上界是多少,目的是为了简化问题的复杂度。

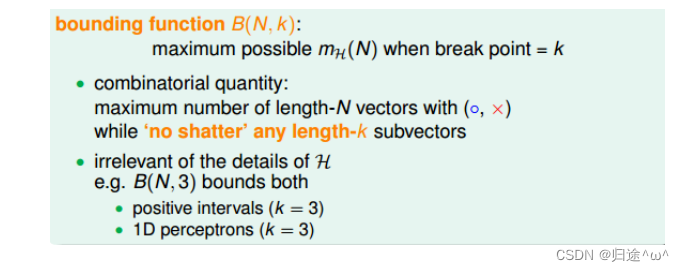

2).B(N,k)的计算

·当k=1时,B(N,1)恒为1。

·当N < k时,根据break point的定义,B(N,k)=2N 。

·当N = k时,此时的N是第一次出现不能被shatter的情况,所以最多只能有2N-1个dichotomies,则 B(N,k)=2N-1。

·当N > k的情况比较复杂,在6.3中说明。

6.3 Bounding Function: Inductive Cases

1.在N > k的情况下,B(N,k)的计算推导

1).以B(4,3)为例进行说明:看能否构建B(4,3)与B(3,x)之间的关系?

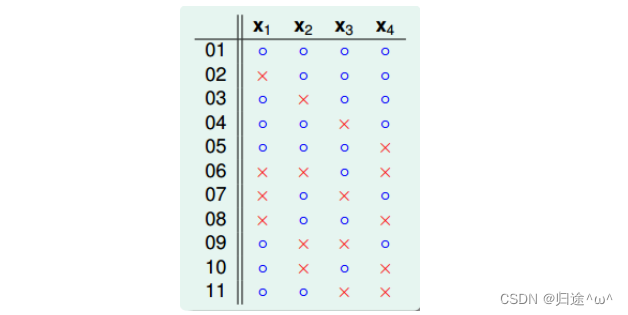

①.B(4,3)所有的情况共有11种。

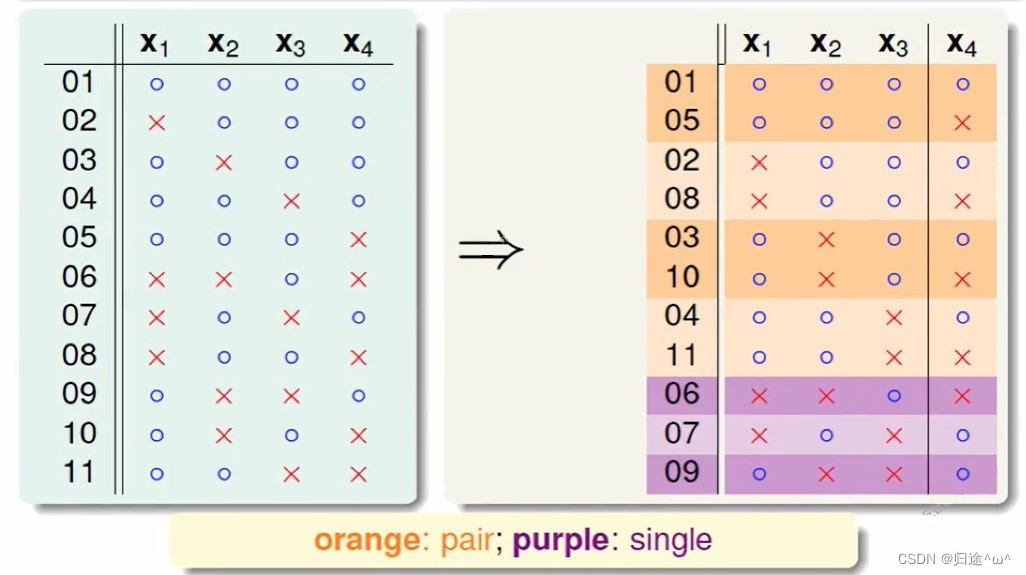

②.将这11种二分类,分成两组:orange和purple,orange的特点是x1,x2,x3是一致的,x4不同并成对,例如01和05;purple的特点是单一的,x1,x2,x3都不同,例如06,07,09。

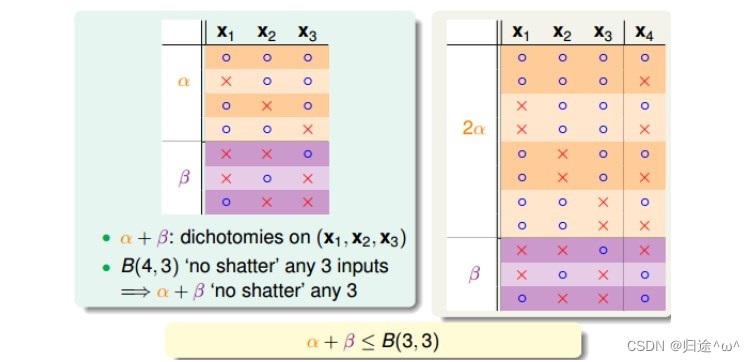

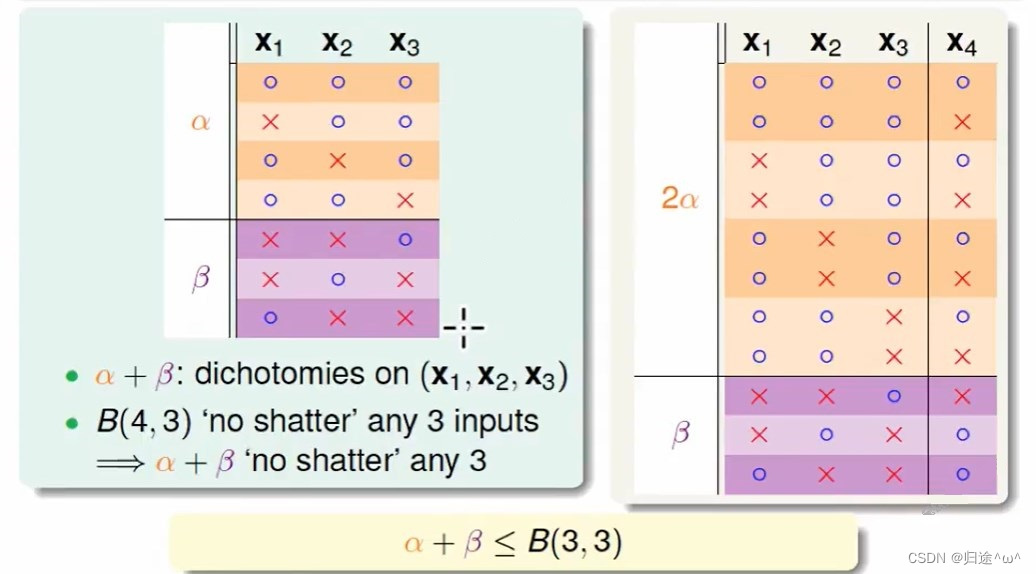

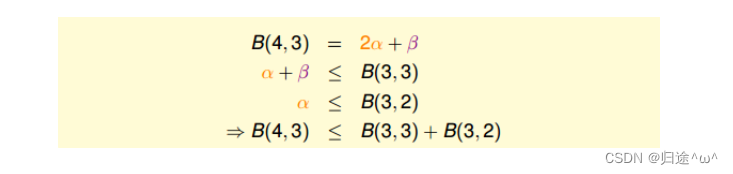

③.Orange是成对出现的,去重后得到4个不同的vector并成为α,purple为β,那么B(4,3)=2α+β,这个是直接转化。

④.由定义可知,B(4,3)是不能允许任意三点shatter的,所以由α和β构成的所有三点组合也不能被shatter,α经过去重,即α+β≤B(3,3)。

⑤.由于α是成对出现的,且α是不能被任意三点shatter的,则推导出α是不能被任意两点shatter的,这是因为如果α不能被任意两点shatter,而α又是成对出现的,那么x1、x2、x3、x4组成的α必然能被三个点shatter,这违背了条件的设定,这个地方的推导非常巧妙,也解释了为什么这样分组,得到的结论是α≤B(3,2)。

⑥.由此可以得出B(4,3)与B(3,x)的关系:

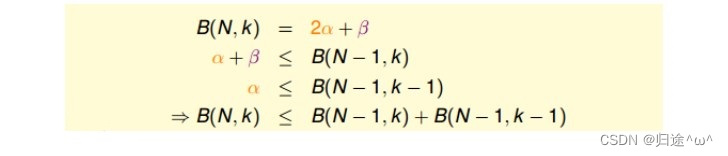

⑦.以此推导出一般式:

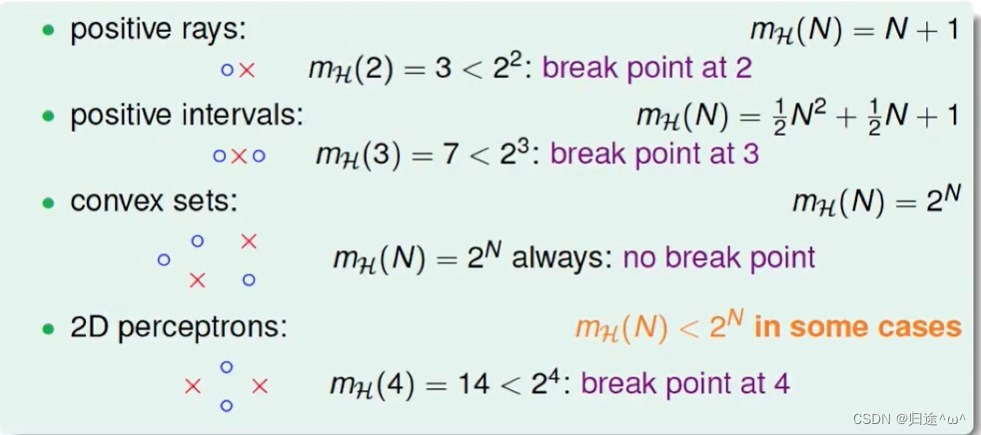

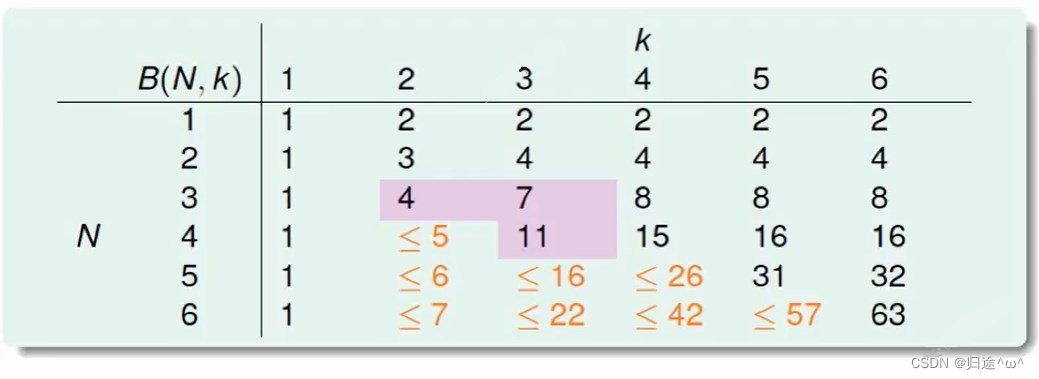

⑧.根据推导公式,下表给出B(N,k)值:

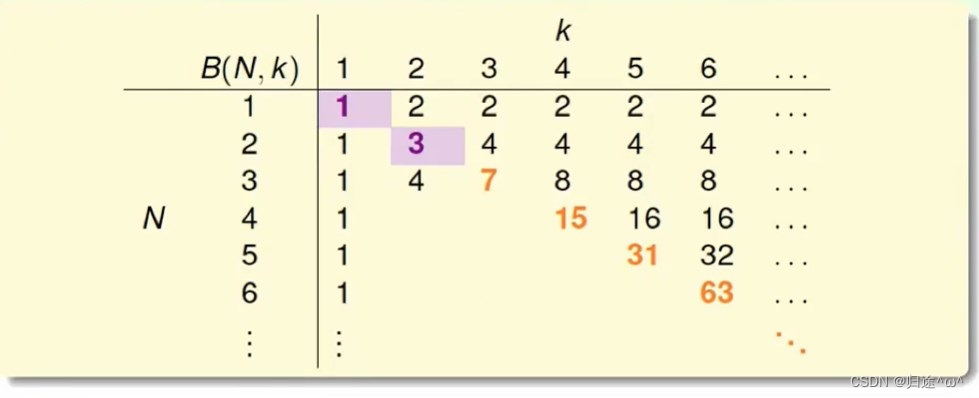

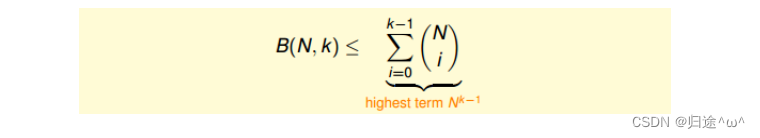

⑨.根据推导公式,推导出B(N,k)满足下列不等式:

描述:

上述不等式的右侧最高阶为Nk-1,也就是说成长函数mH(N)的上界B(N,k),B(N,k)的上界满足多项式分布poly(N).这就是我们想要的结果。(实际上我们可以换一种证明方式证明出,B(N,k)=Nk-1,这里就不说明了)

⑩.成长函数mH(N)的上界B(N,k),B(N,k)的上界满足多项式分布poly(N),再来看之前介绍的成长函数mH(N)与break point的关系:

2.结论

对于2D perceptrons,break point为k=4时,mH(N)的上界是Nk-1;推到后,如果能找到一个模型的break point,且是有限的,那么就能推导出成长函数mH(N)有界。

6.4 A Pictorial Proof

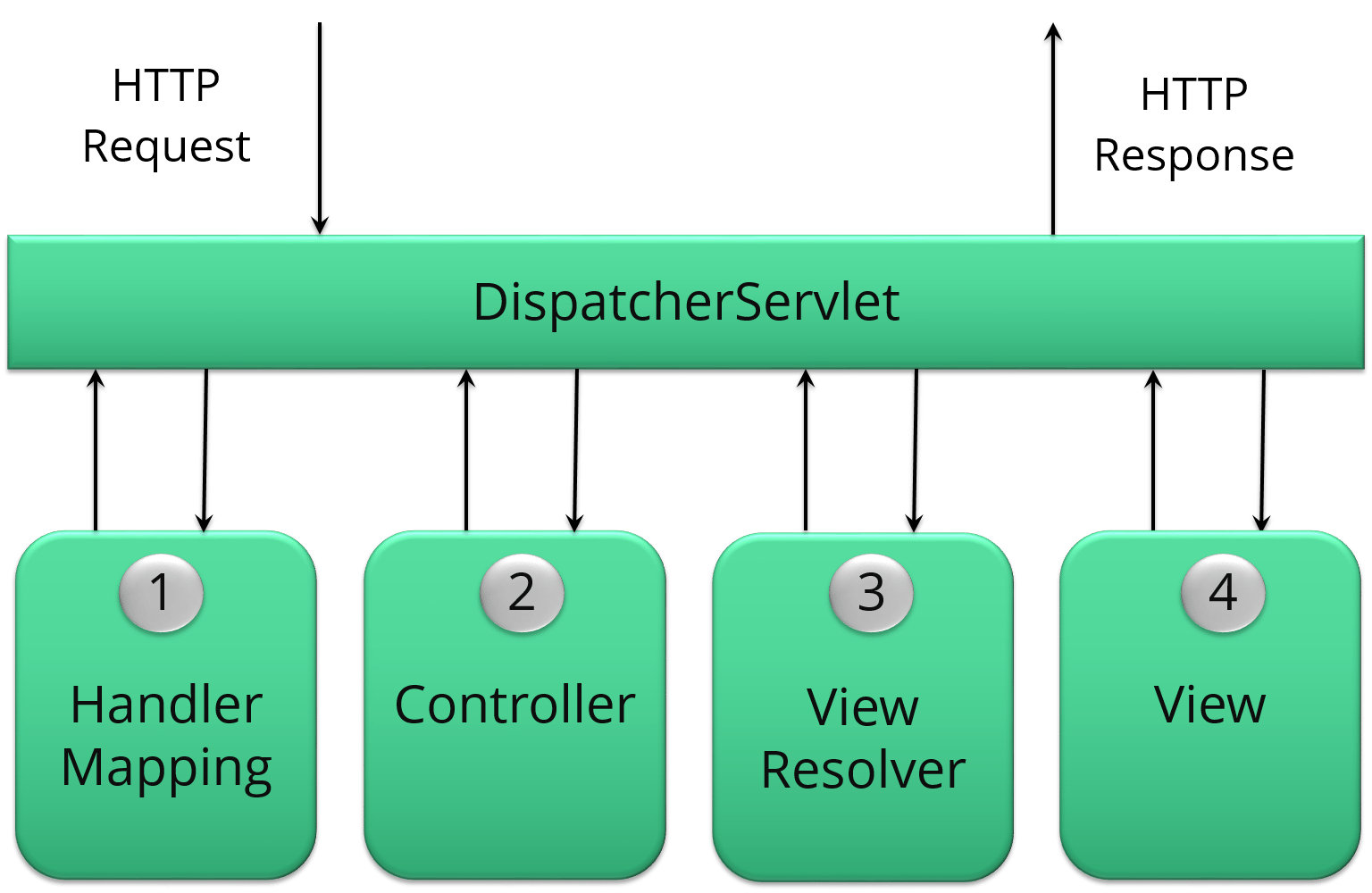

1.如何用mH(N)代替Hoffding不等式中的M?

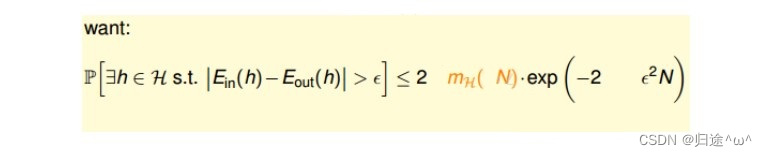

1).如果能够将mH(N)代替M,代入到Hoffding不等式中,就能得到Ein≈Eout:

①.我们想象中的是直接取代:

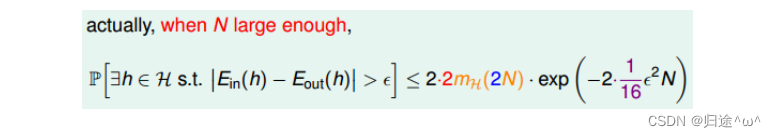

②.实际上并不是简单的替换就可以,正确的表达式为:

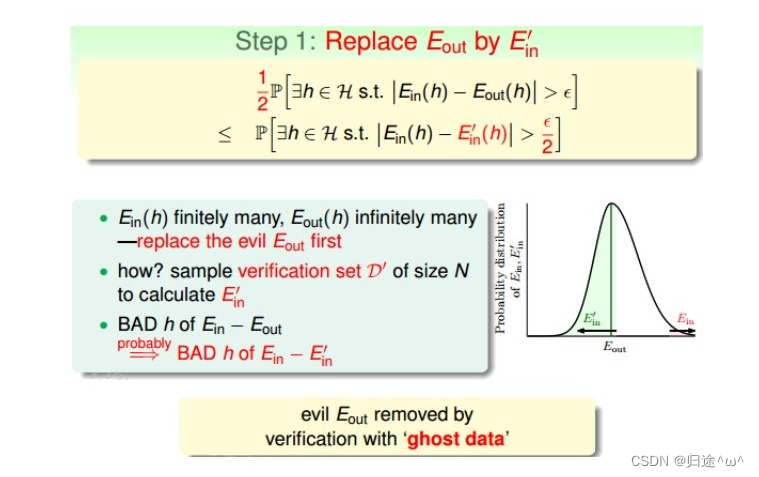

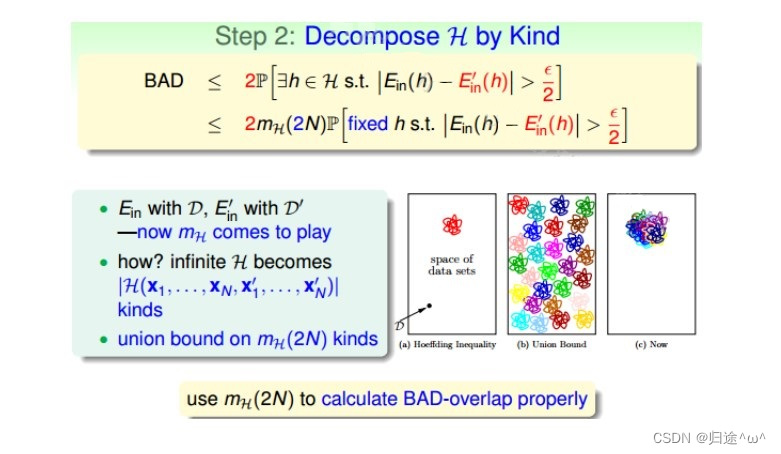

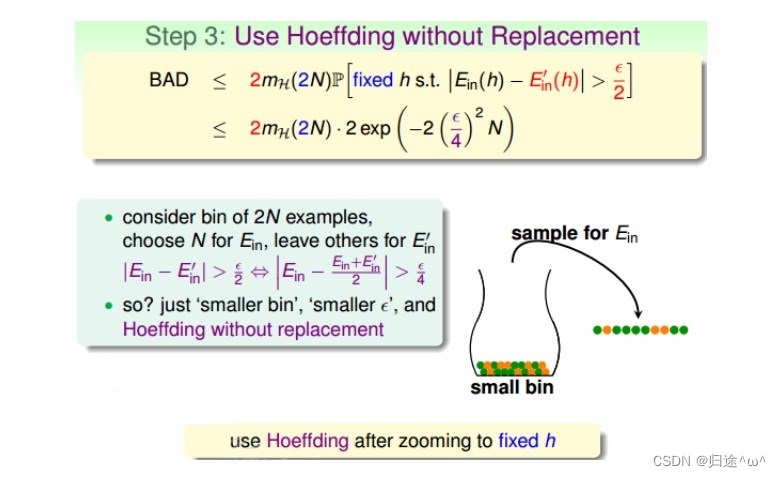

2).推导证明:

①.

②.

③.

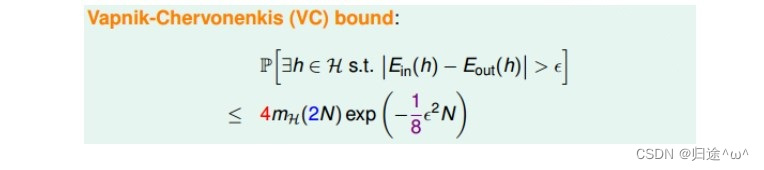

3).我们通过引入成长函数,得到了新的不等式,称为VapnikChervonenkis(VC) bound:

4).总结:

对于2D perceptrons,它的break point是4,那么成长函数mH(N)=O(N3),所以我们可以说2D perceptrons是可以进行机器学习的,只要找到hypothesis能让Ein≈0,就能保证Ein≈Eout。

6.5 总结

本章节主要介绍了只要存在break point,那么成长函数mH(N)就满足ploy(N),推导过程中引入了mH(N)的上界B(N,k),B(N,k)的上界是Nk-1,从而得到了mH(N)的上界是Nk-1,最终证明了只要break point存在,那么机器学习就是可行的。