前馈神经网络

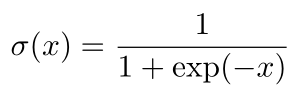

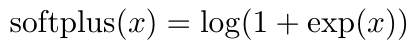

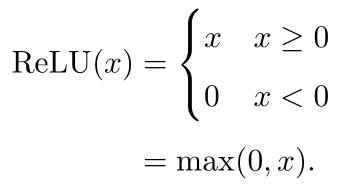

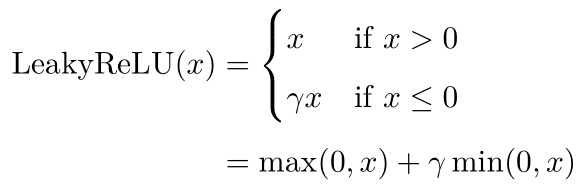

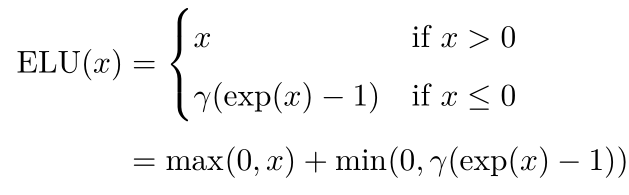

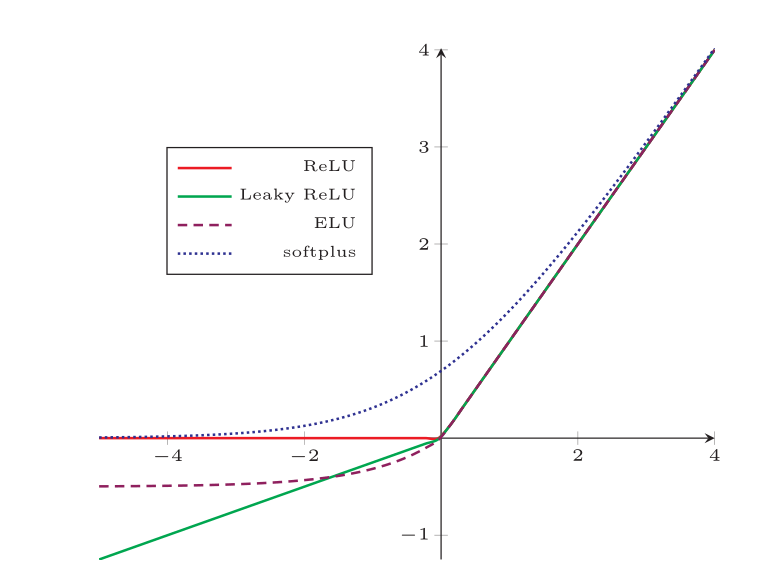

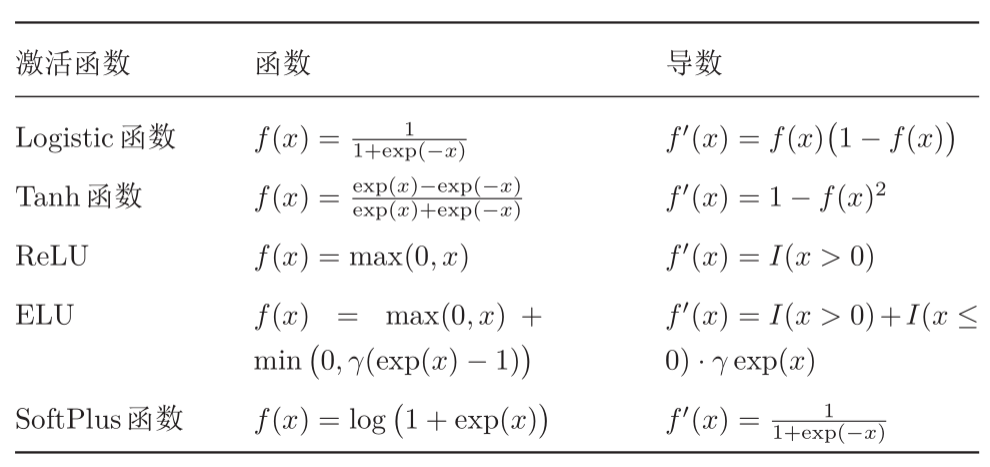

常见激活函数

- sigmoid函数

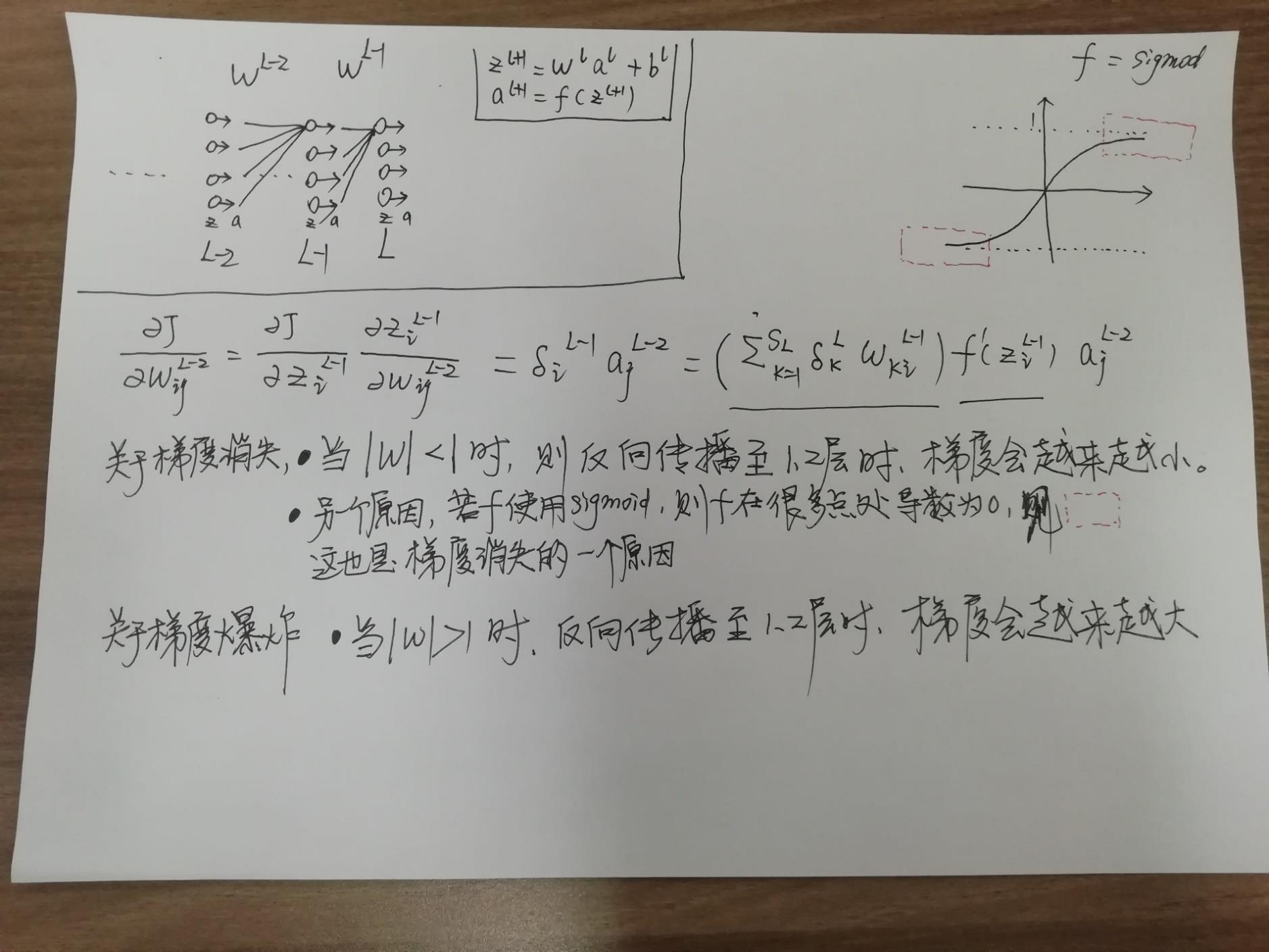

梯度消失与爆炸

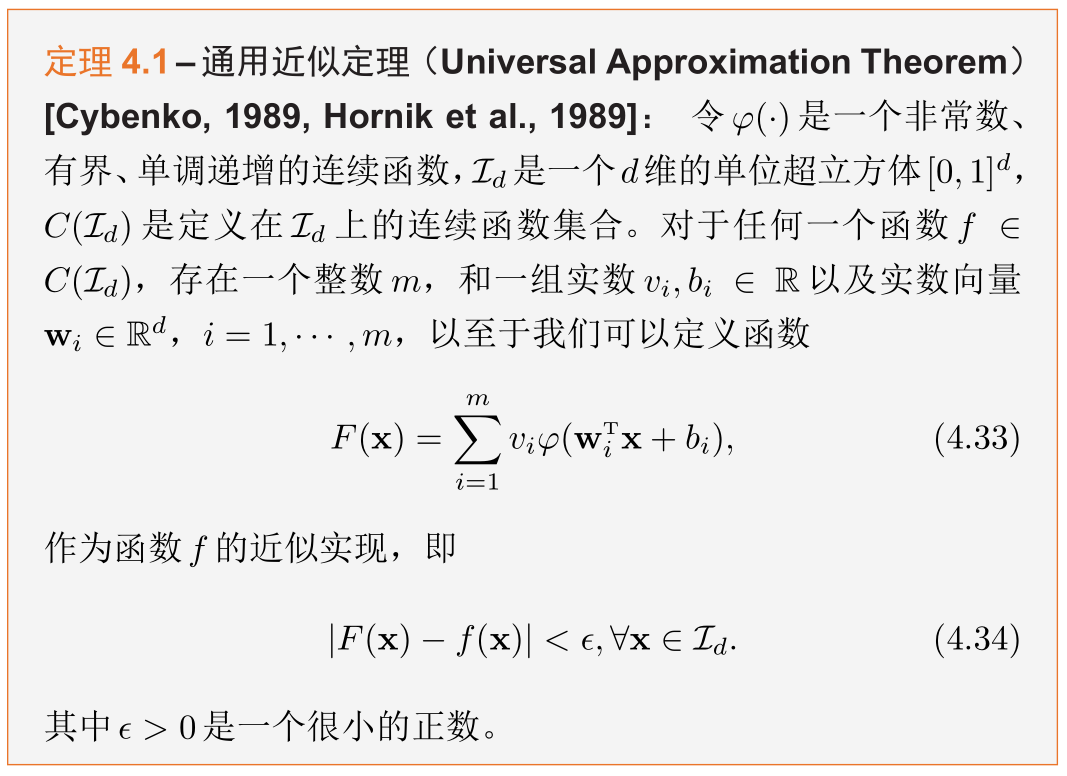

通用逼近定理

根据通用近似定理,对于具有线性输出层和至少一个使用“挤压”性质的激活函数的隐藏层组成的前馈神经网络

- 只要其隐藏层神经元的数量足够,它可以以任意的精度来近似任何从一个定义在实数空间中的有界闭集函数。

- 隐含层的数量不是越多越好,层数和特征的个数太多,会造成优化的难度和出现过拟合的现象

- 只需要输入最基本的特征x1, x2, 只要给予足够多层的神经网络和神经元,神经网络会自己组合出最有用的特征

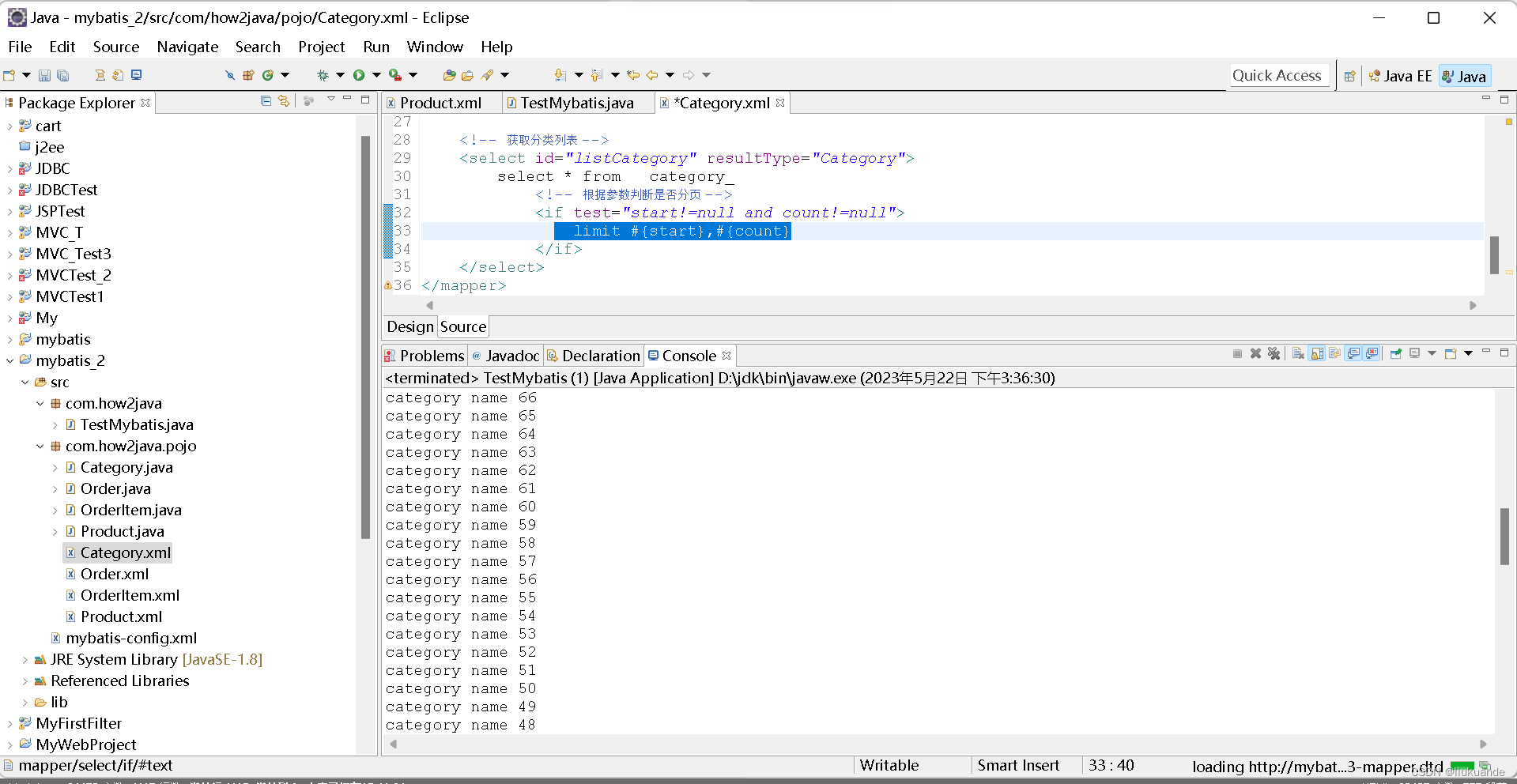

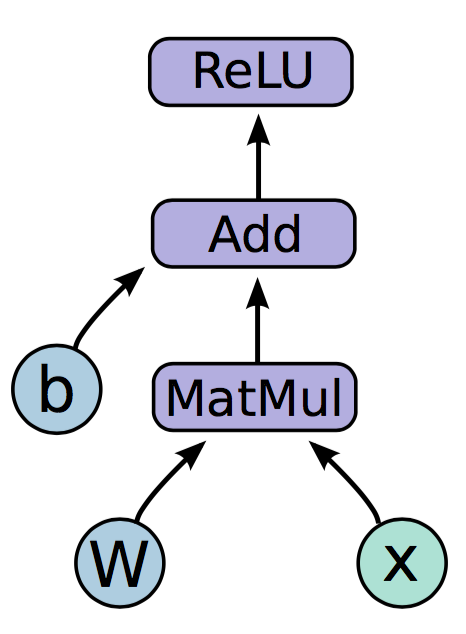

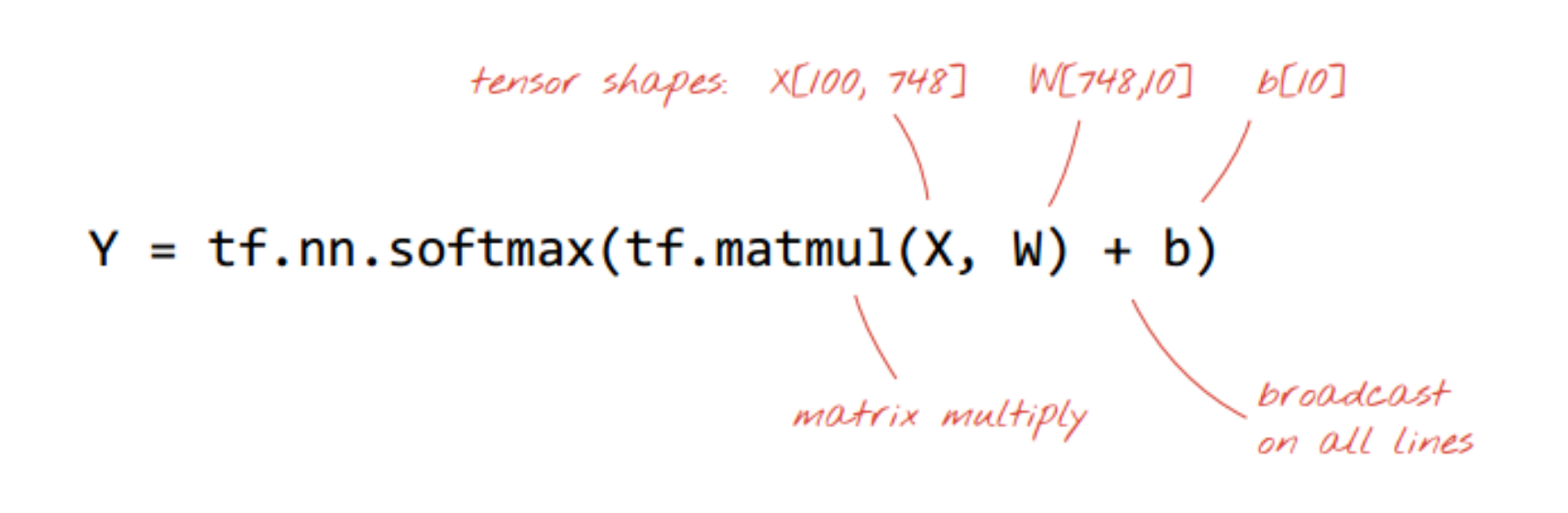

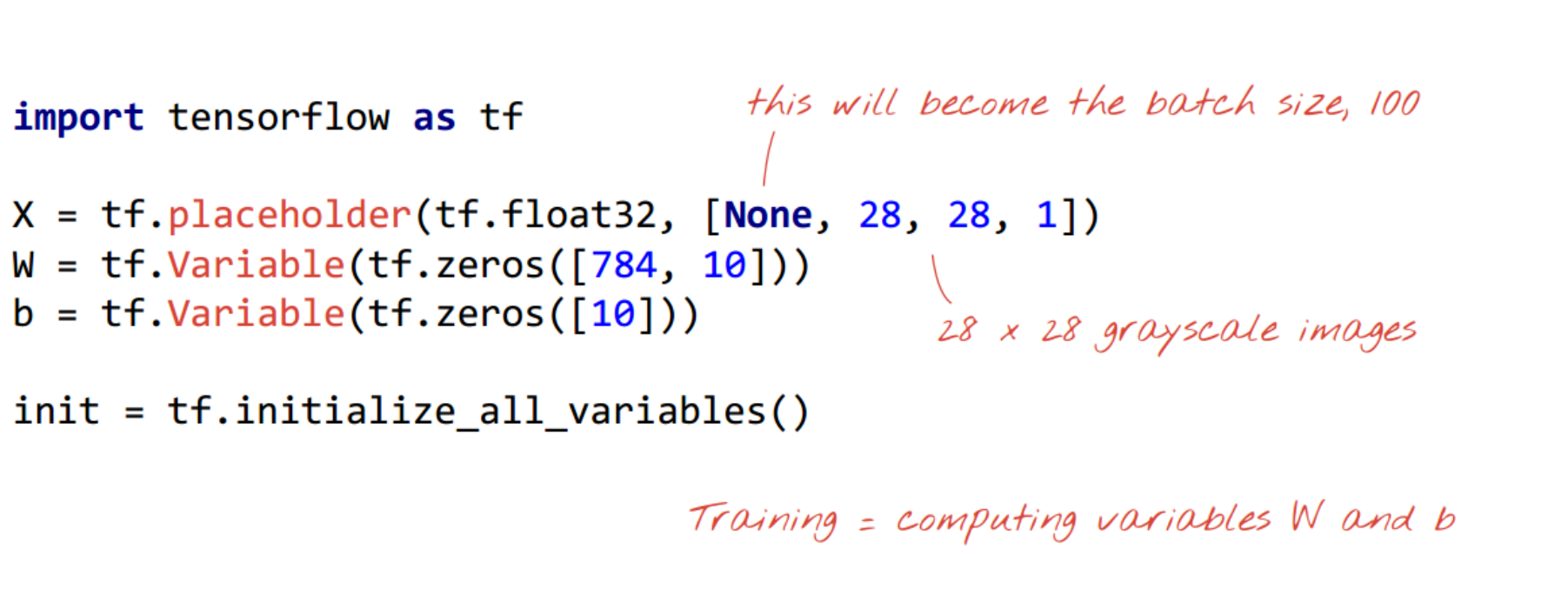

tensorflow实现

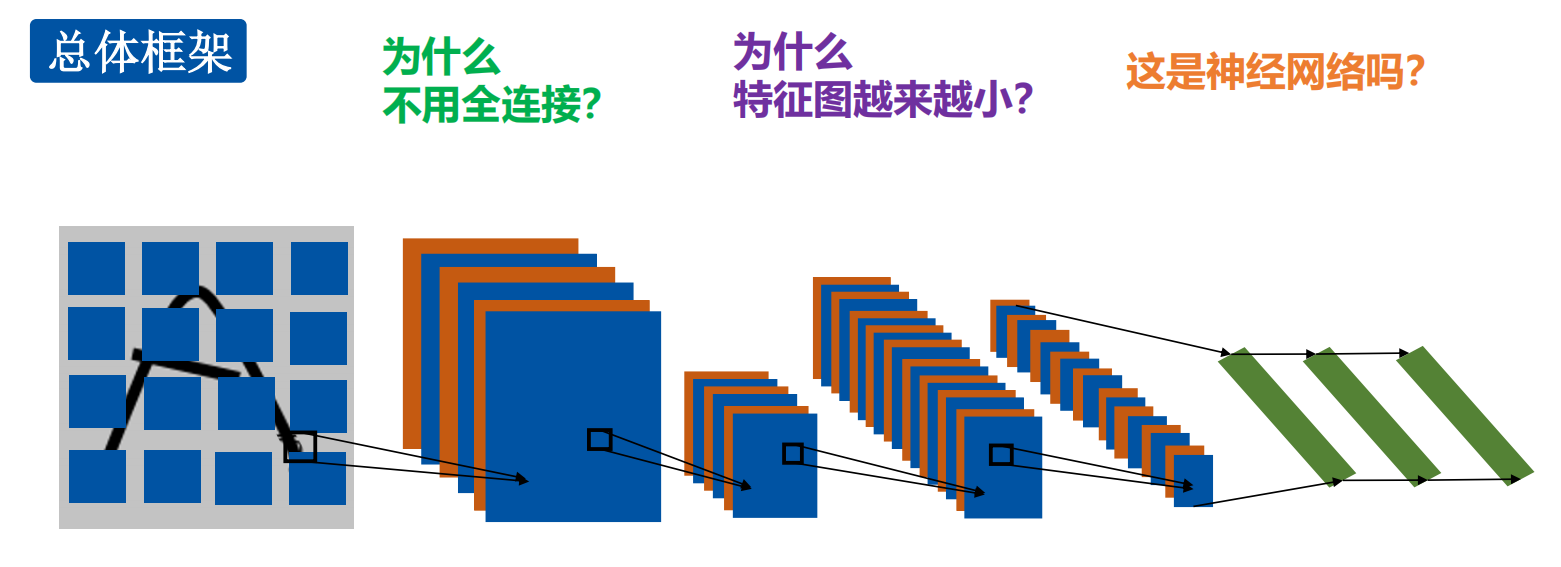

- 一张图片-个滤波器,得一个特征图

- 为什么不用全连接?

计算量太大,容易过拟合 - 为什么特征图越来越小?

下采样,即池化会让特征图尺寸变小 - 这是神经网络么?是的

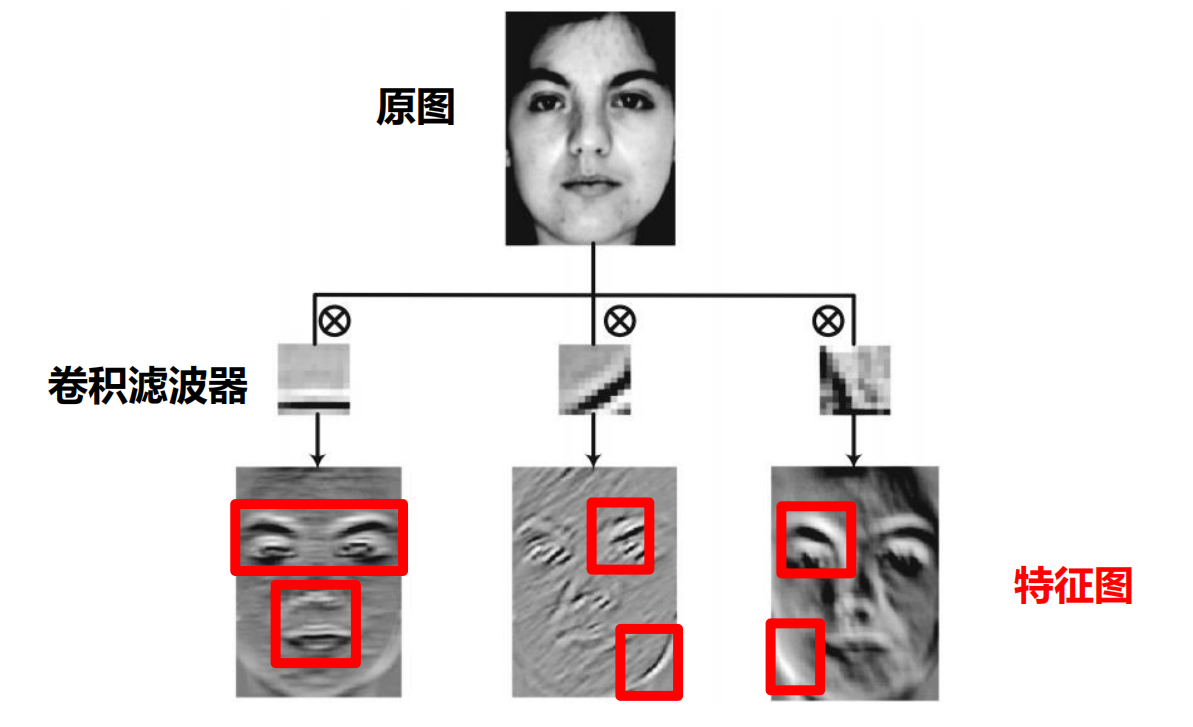

CNN的由来:

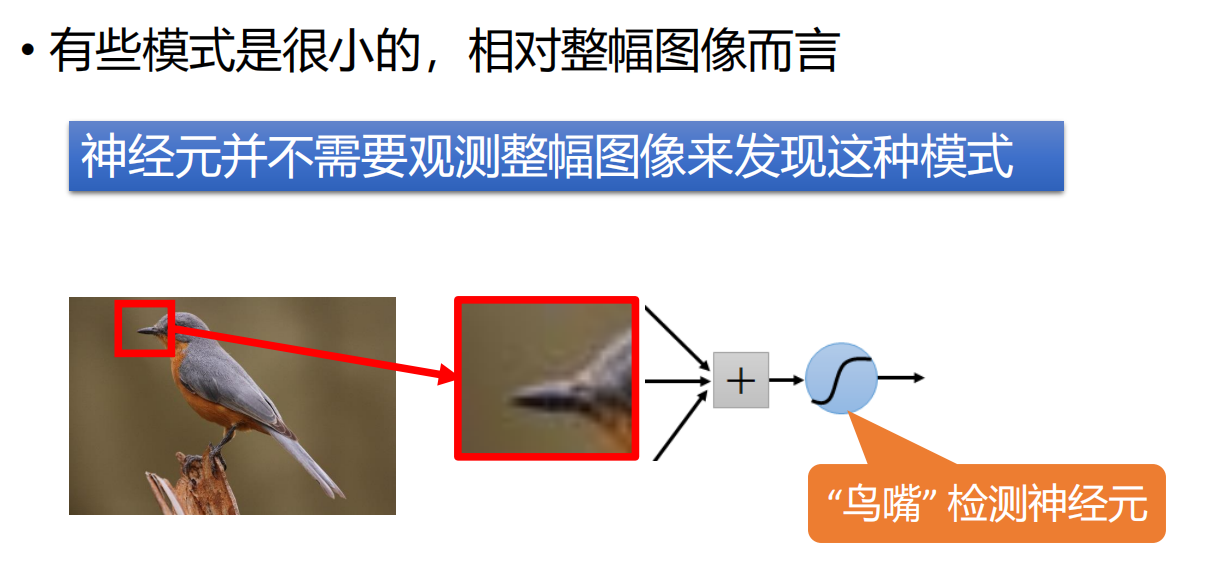

- 引出,CNN的第一个特点:局部感知

- 引导出第二个特征:权重共享

- 第三个特征:池化,下采样

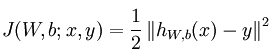

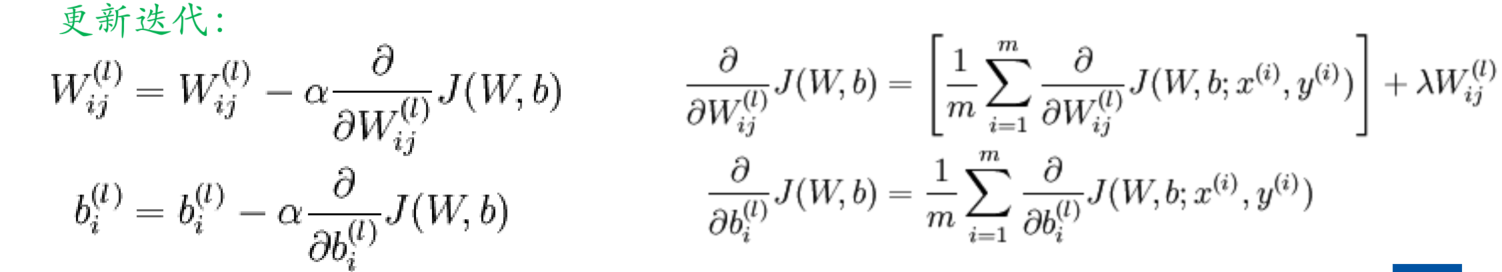

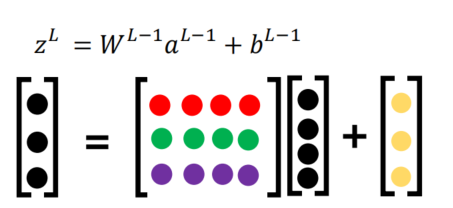

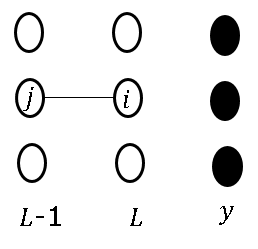

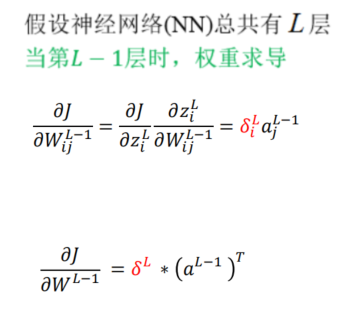

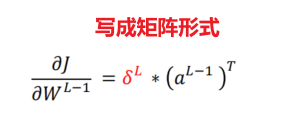

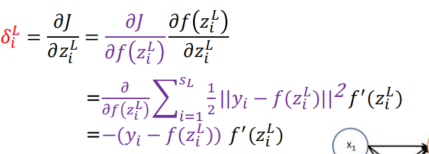

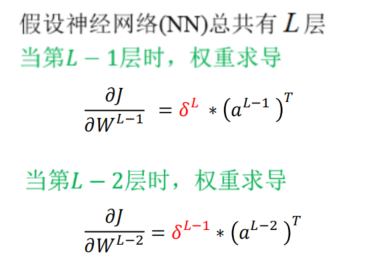

全连接网络的BP算法

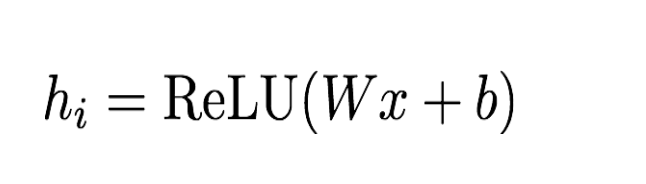

- 模型函数表达式

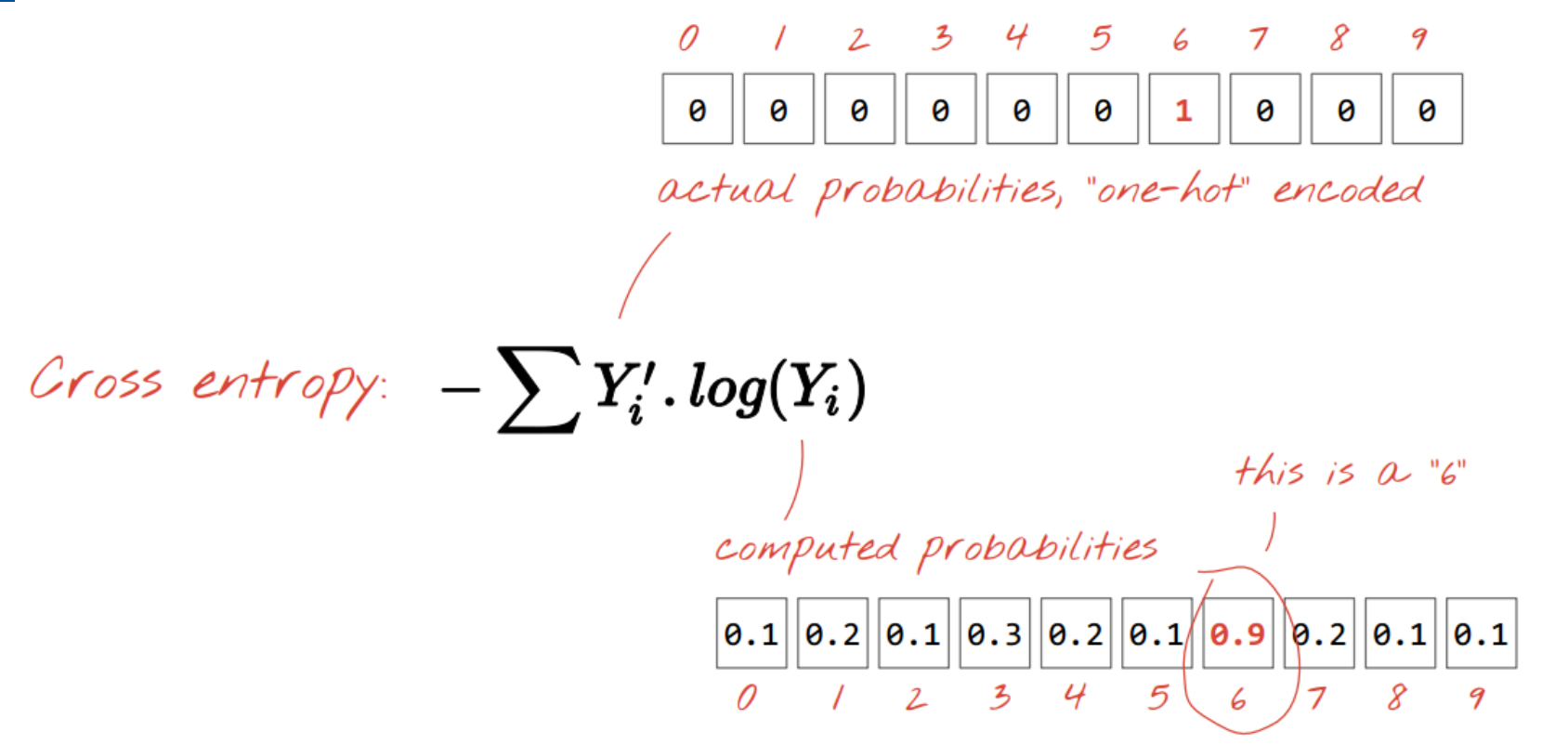

- 带上损失函数进行求导

- L-2层同理

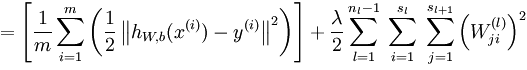

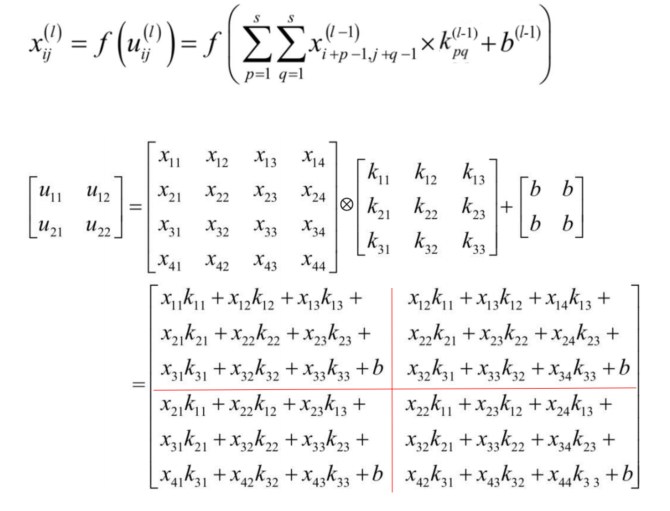

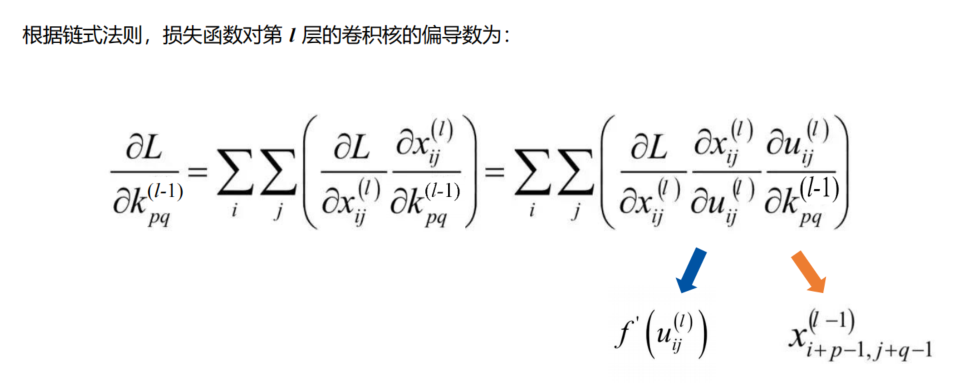

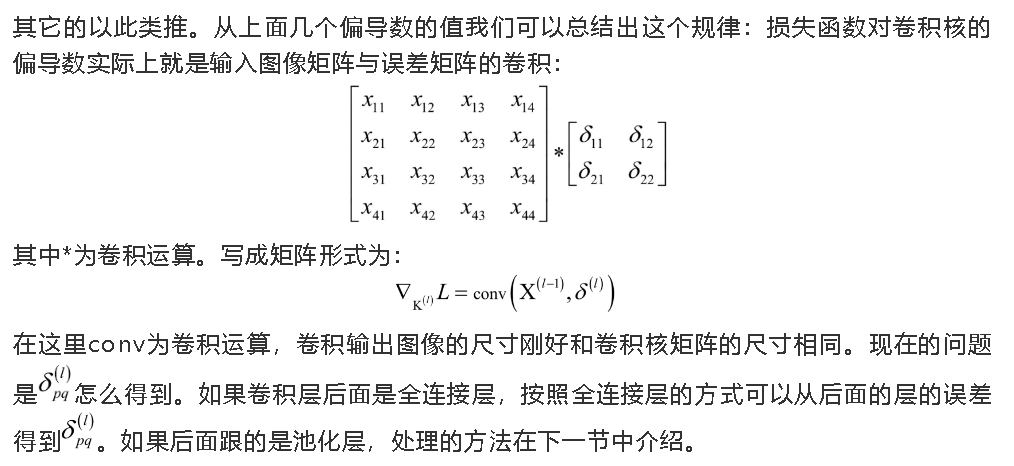

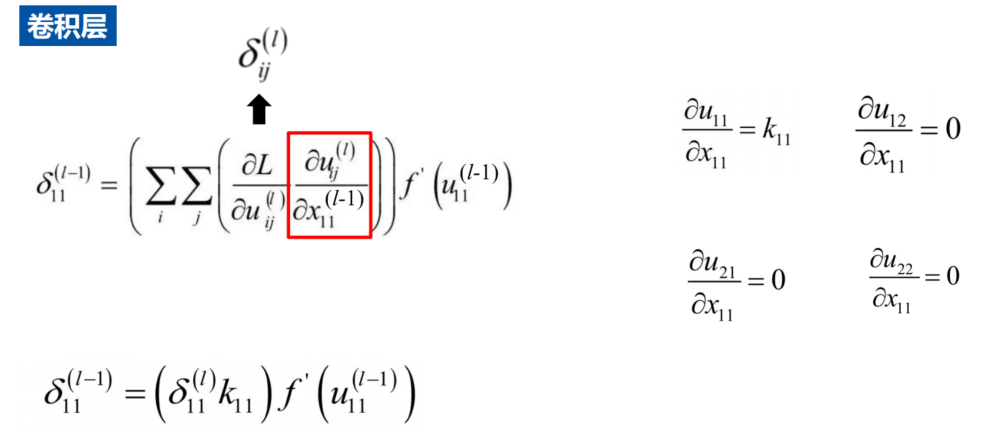

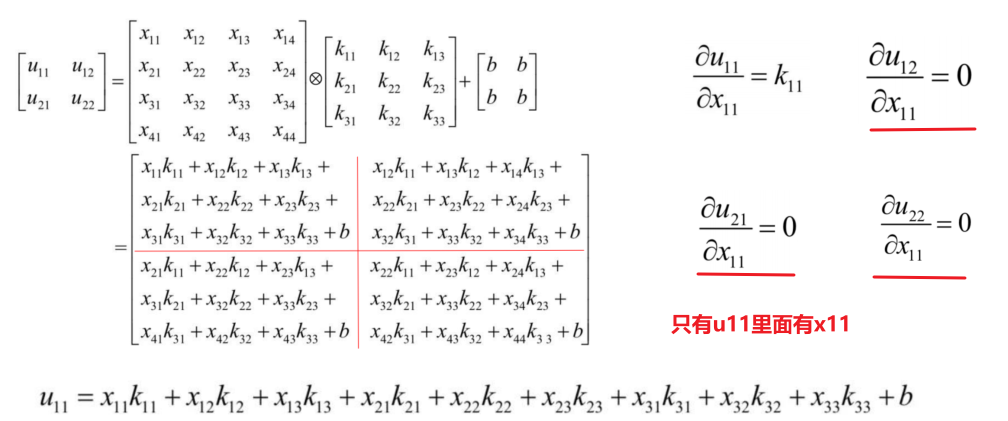

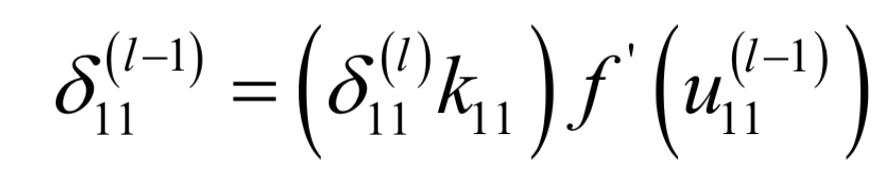

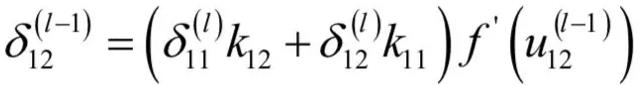

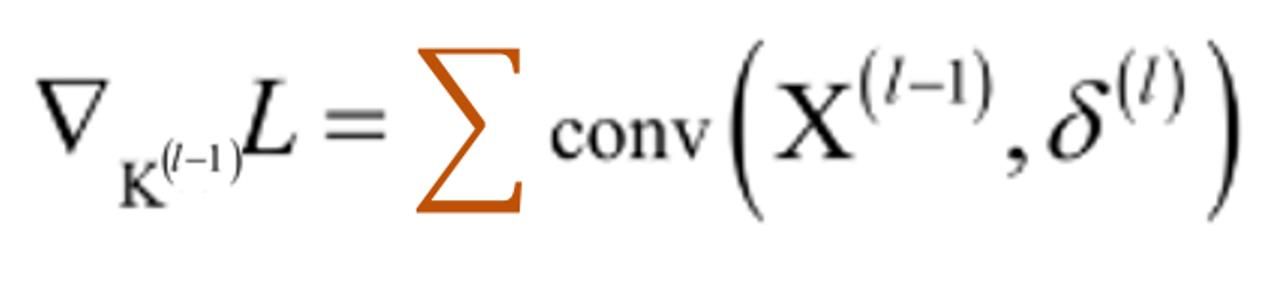

CNN的卷积BP算法

-

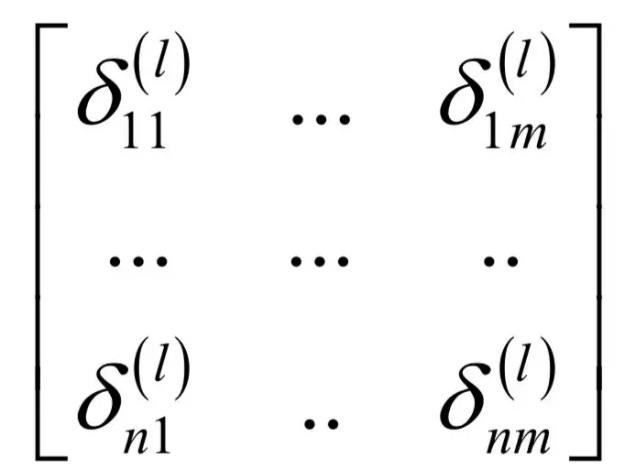

δ

\delta

δ是误差矩阵

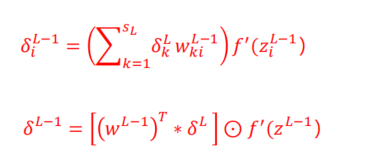

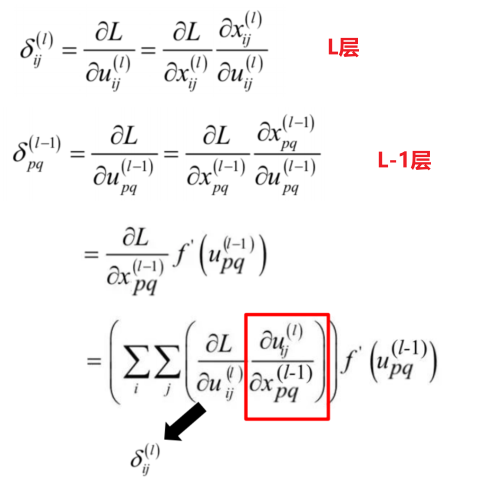

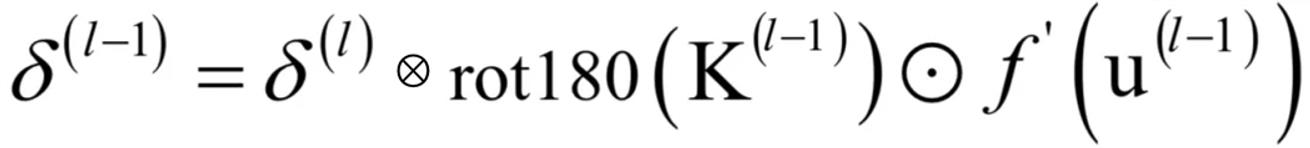

残差如何传递?

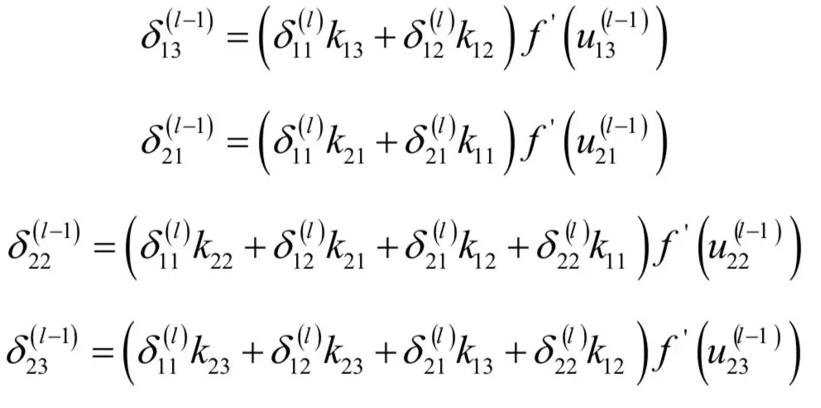

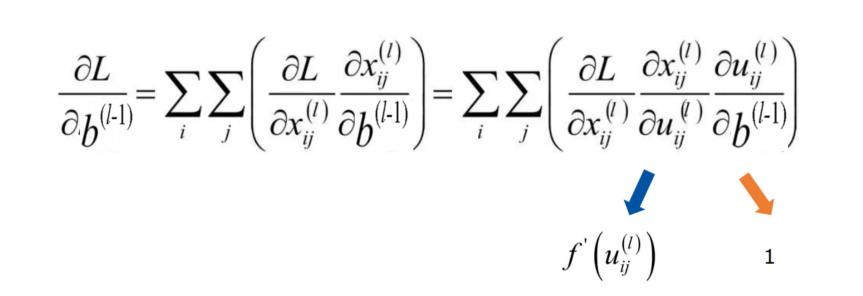

δ \delta δ求解详细过程

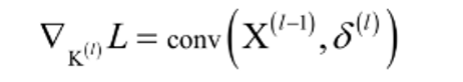

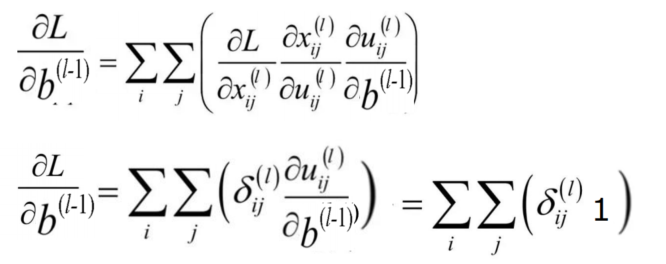

- 关键核心公式

- 误差项,求完导是1,所以残差项传递与bias项无关

- 多个特征图可以并行卷积

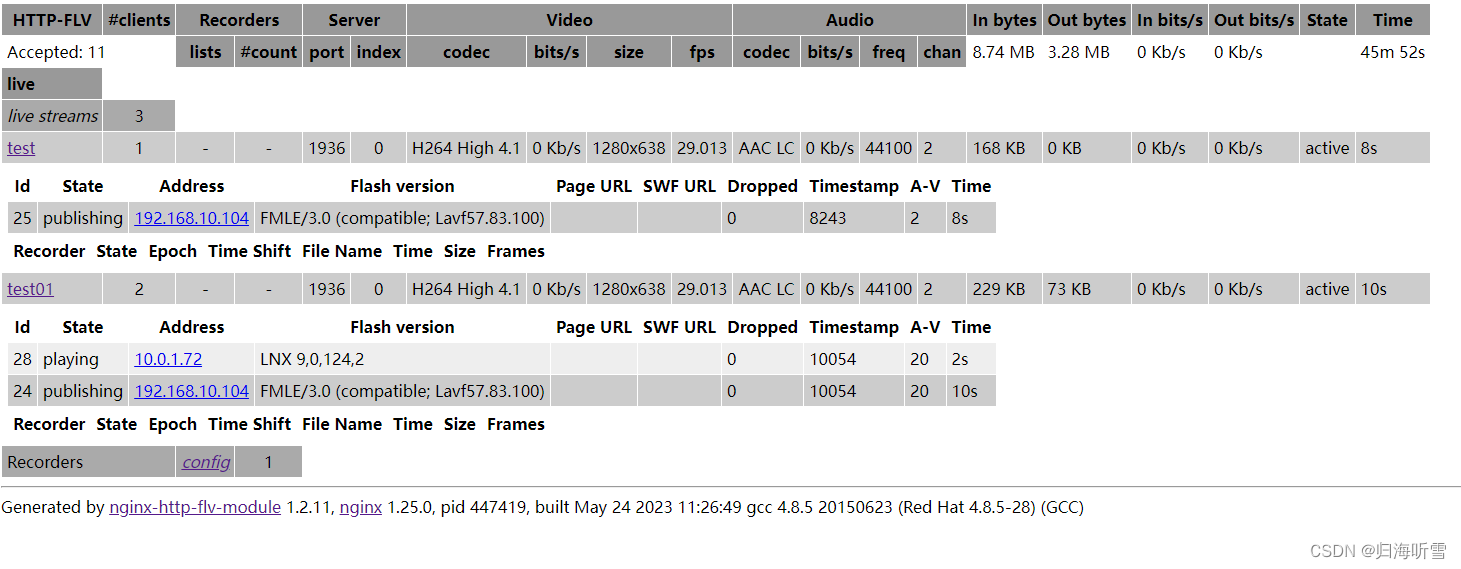

![[LitCTF 2023]easy_shark](https://img-blog.csdnimg.cn/a3c960aa7fc74d6c935871c5f5447dda.png)