BERT & GPT

近年来,随着大规模预训练语言模型的发展,自然语言处理领域发生了巨大变革。BERT 和 GPT 是其中最流行且最有影响力的两种模型。在本篇博客中,我们将讨论 BERT 和 GPT 之间的区别以及它们的演变过程。

1.起源

2018

2018

2018 年,

G

o

o

g

l

e

Google

Google 首次推出 BERT(Bidirectional Encoder Representations from Transformers)。该模型是在大量文本语料库上结合无监督和监督学习进行训练的。 BERT 的目标是创建一种语言模型,可以理解句子中单词的上下文和含义,同时考虑到它前后出现的单词。

2018

2018

2018 年,

O

p

e

n

A

I

OpenAI

OpenAI 首次推出 GPT(Generative Pre-trained Transformer)。与 BERT 一样,GPT 也是一种大规模预训练语言模型。但是,GPT 是一种生成模型,它能够自行生成文本。 GPT 的目标是创建一种语言模型,该模型可以生成连贯且适当的上下文文本。

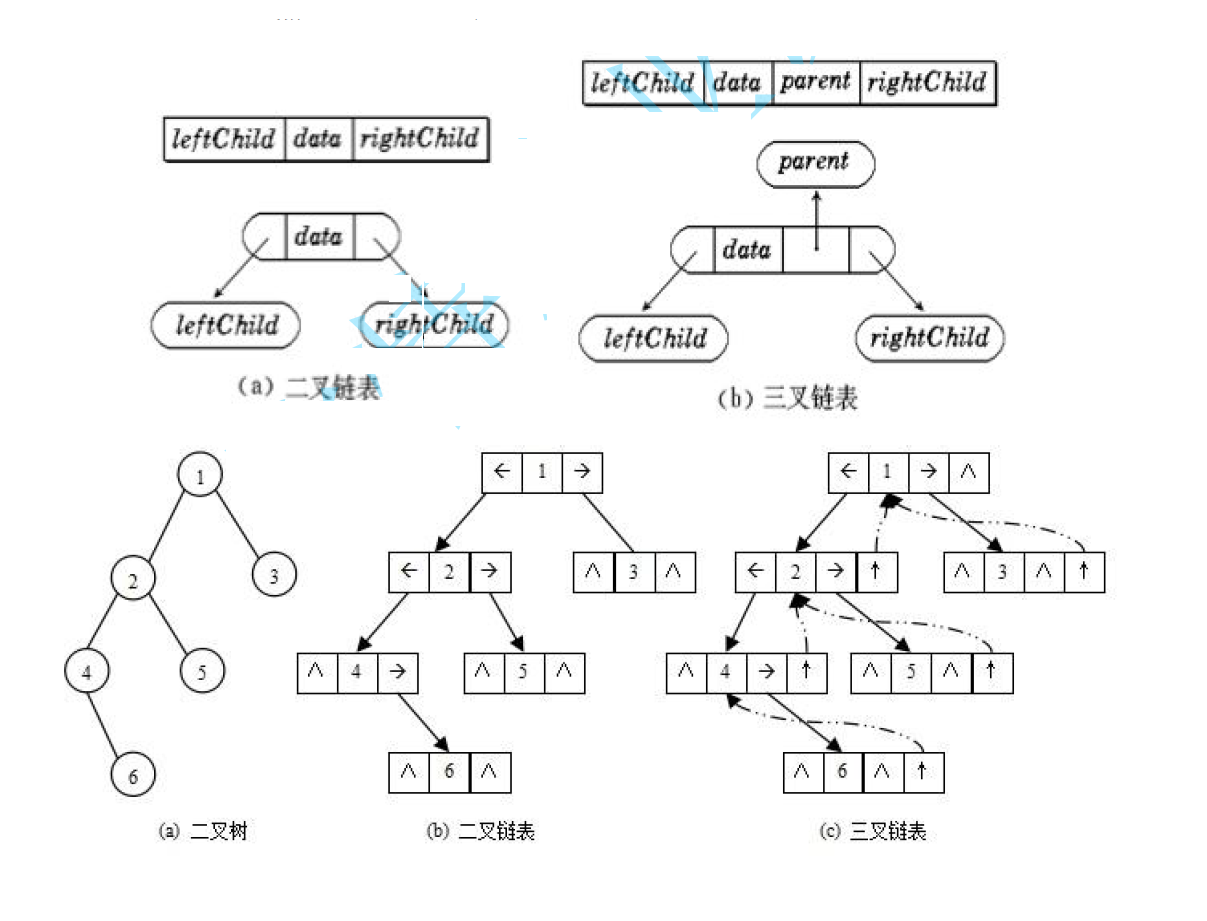

2.架构

BERT 和 GPT 都是基于 Transformer 架构构建的。Transformer 架构于

2017

2017

2017 年由

V

a

s

w

a

n

i

Vaswani

Vaswani 等人首次提出,作为一种神经网络结构,其旨在处理序列数据,例如文本。

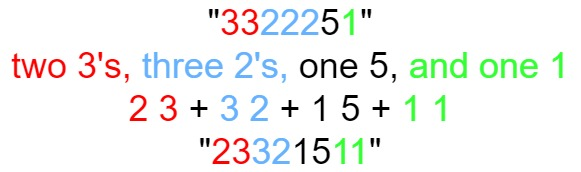

BERT 和 GPT 的主要区别在于它们的训练方式。 BERT 使用一种名为 掩码语言建模(Masked Language Modeling,MLM)的技术进行训练。在 MLM 中,模型经过训练以预测句子中缺失的单词。例如,给定句子The cat ___ on the mat,可能会要求模型预测缺失的单词 sits。这有助于模型学习理解句子中单词的上下文和含义。

另一方面,GPT 使用一种名为 自回归语言建模(ALM)的技术进行训练。在 ALM 中,模型通过训练为在给定所有先前单词的情况下预测句子中的下一个单词。例如,给定句子 The cat sat on the ___,可能会要求模型预测缺失的单词 mat。这有助于模型学习生成连贯且适当的上下文文本。

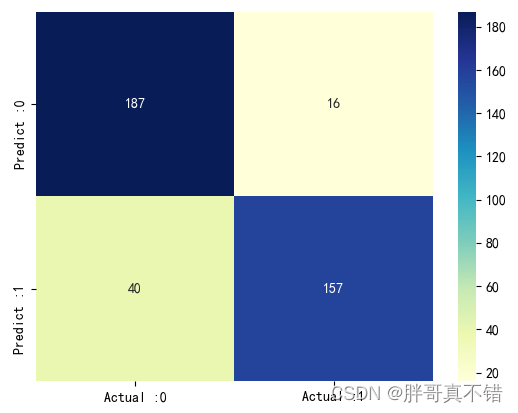

3.性能

BERT 和 GPT 在各种 NLP 任务中都取得了非常好的效果。尤其是 BERT,它在很多任务中都取得了最先进的成果,包括情感分析、问答和自然语言推理。

GPT 也取得了令人瞩目的成果,尤其是在与文本生成相关的任务中。目前,该模型已被广泛应用于诸如新闻、诗歌等领域的生成任务中。

4.演变

自最初发布以来,BERT 和 GPT 都在不断发展和改进。

2019

2019

2019 年,

G

o

o

g

l

e

Google

Google 发布了 BERT 的更新版本 RoBERTa(Robustly Optimized BERT Pretraining Approach)。 RoBERTa 使用更大的文本语料库和更复杂的训练过程进行训练,从而获得了比原始 BERT 模型更好的性能。

与此同时,

O

p

e

n

A

I

OpenAI

OpenAI 发布了几个新版本的 GPT,包括 GPT-2 和 GPT-3。

2019

2019

2019 年发布的 GPT-2 接受了比原始 GPT 模型更大的文本语料库的训练。

2020

2020

2020 年发布的 GPT-3 是目前最大、最强的语言模型之一,拥有

1750

1750

1750 亿个参数。

5.结论

综上所述,BERT 和 GPT 是现代 NLP 中最具影响力的两种语言模型。它们都是使用 Transformer 架构构建的,并使用不同的技术进行训练。BERT 使用掩码语言建模进行训练,专注于理解句子中单词的上下文和含义,而 GPT 使用自回归语言建模进行训练,专注于生成连贯且上下文适当的文本。

这两种模型在各种 NLP 任务中都取得了令人难以置信的成功,并且自首次发布以来一直在不断发展和改进。 BERT 已更新为 RoBERTa,而 GPT 已更新为 GPT-2 和 GPT-3,这是目前最大、最强的语言模型之一。

这些模型的发展为 NLP 领域带来了重大进步,它们将继续应用于聊天机器人、机器翻译等各种程序中。随着 NLP 领域的不断发展和演变,这些模型将如何发展?它们可能带来哪些新的突破?我们拭目以待吧!