机器学习入门核心算法:GBDT(Gradient Boosting Decision Tree)

- 1. 算法逻辑

- 2. 算法原理与数学推导

- 2.1 目标函数

- 2.2 负梯度计算

- 2.3 决策树拟合

- 2.4 叶子权重计算

- 2.5 模型更新

- 3. 模型评估

- 评估指标

- 防止过拟合

- 4. 应用案例

- 4.1 金融风控

- 4.2 推荐系统

- 4.3 计算机视觉

- 5. 面试题及答案

- 6. 优缺点分析

- 优点

- 缺点

- 7. 数学推导示例(回归问题)

1. 算法逻辑

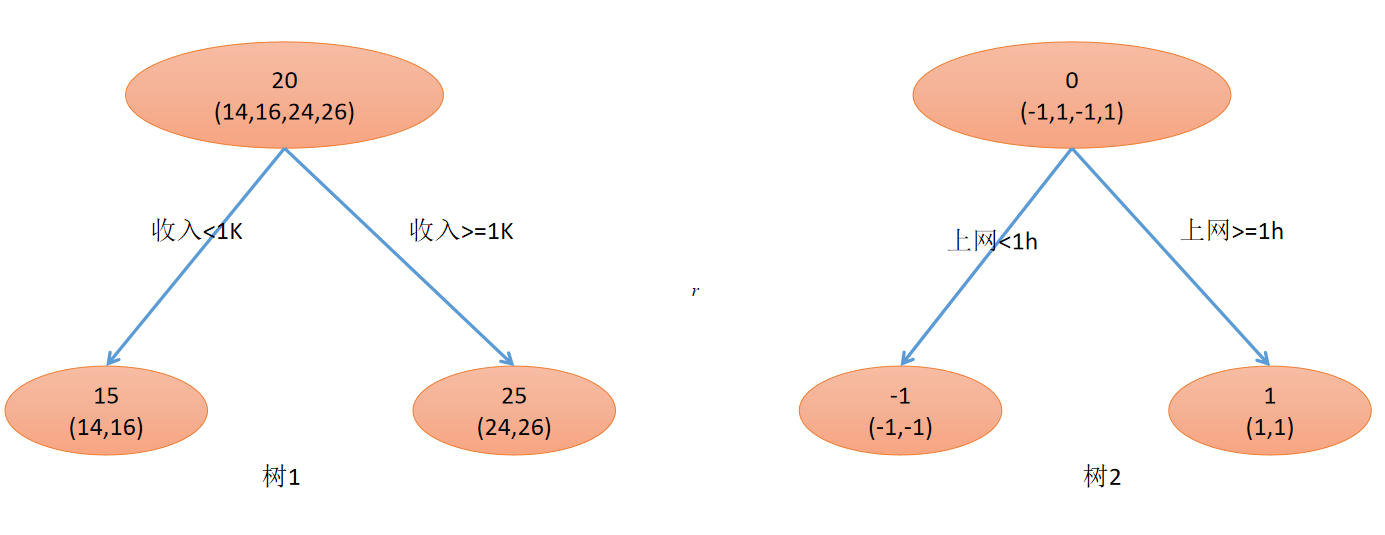

GBDT 是一种基于决策树的集成学习算法,属于 Boosting 家族。其核心思想是串行训练多个弱学习器(决策树),每棵树学习前序模型残差的负梯度,最终通过加权求和得到强学习器。核心逻辑如下:

- 初始化:用常数值初始化模型(如目标均值)

F 0 ( x ) = arg min γ ∑ i = 1 n L ( y i , γ ) F_0(x) = \arg\min_\gamma \sum_{i=1}^n L(y_i, \gamma) F0(x)=argγmini=1∑nL(yi,γ) - 迭代训练:

- 计算当前模型的伪残差(负梯度)

- 训练新树拟合该残差

- 更新模型: F m ( x ) = F m − 1 ( x ) + ν h m ( x ) F_m(x) = F_{m-1}(x) + \nu h_m(x) Fm(x)=Fm−1(x)+νhm(x)( ν \nu ν为学习率)

- 最终输出:加权树组合

F ( x ) = ∑ m = 0 M ν h m ( x ) F(x) = \sum_{m=0}^M \nu h_m(x) F(x)=m=0∑Mνhm(x)

2. 算法原理与数学推导

2.1 目标函数

设训练集

{

(

x

i

,

y

i

)

}

i

=

1

n

\{(x_i,y_i)\}_{i=1}^n

{(xi,yi)}i=1n,损失函数

L

(

y

,

F

(

x

)

)

L(y, F(x))

L(y,F(x)),目标是最小化正则化目标函数:

L

=

∑

i

=

1

n

L

(

y

i

,

F

(

x

i

)

)

+

∑

m

=

1

M

Ω

(

h

m

)

\mathcal{L} = \sum_{i=1}^n L(y_i, F(x_i)) + \sum_{m=1}^M \Omega(h_m)

L=i=1∑nL(yi,F(xi))+m=1∑MΩ(hm)

其中

Ω

(

h

m

)

=

γ

T

+

1

2

λ

∥

w

∥

2

\Omega(h_m) = \gamma T + \frac{1}{2}\lambda \|w\|^2

Ω(hm)=γT+21λ∥w∥2(

T

T

T为叶子数,

w

w

w为叶子权重)

2.2 负梯度计算

在第

m

m

m 次迭代,计算伪残差:

r

i

m

=

−

[

∂

L

(

y

i

,

F

(

x

i

)

)

∂

F

(

x

i

)

]

F

(

x

)

=

F

m

−

1

(

x

)

r_{im} = -\left[ \frac{\partial L(y_i, F(x_i))}{\partial F(x_i)} \right]_{F(x)=F_{m-1}(x)}

rim=−[∂F(xi)∂L(yi,F(xi))]F(x)=Fm−1(x)

| 损失函数 | 伪残差 r i m r_{im} rim |

|---|---|

| 平方损失 | y i − F m − 1 ( x i ) y_i - F_{m-1}(x_i) yi−Fm−1(xi) |

| 绝对损失 | sign ( y i − F m − 1 ( x i ) ) \text{sign}(y_i - F_{m-1}(x_i)) sign(yi−Fm−1(xi)) |

| Huber损失 | 分段函数 |

| 对数损失(分类) | y i − 1 1 + e − F m − 1 ( x i ) y_i - \frac{1}{1+e^{-F_{m-1}(x_i)}} yi−1+e−Fm−1(xi)1 |

2.3 决策树拟合

训练新树 h m h_m hm 拟合伪残差 { ( x i , r i m ) } \{(x_i, r_{im})\} {(xi,rim)},通过递归分裂节点:

- 分裂准则:最大化增益(Gain)

Gain = 1 2 [ G L 2 H L + λ + G R 2 H R + λ − ( G L + G R ) 2 H L + H R + λ ] − γ \text{Gain} = \frac{1}{2} \left[ \frac{G_L^2}{H_L + \lambda} + \frac{G_R^2}{H_R + \lambda} - \frac{(G_L+G_R)^2}{H_L+H_R+\lambda} \right] - \gamma Gain=21[HL+λGL2+HR+λGR2−HL+HR+λ(GL+GR)2]−γ

其中 G = ∑ i ∈ I g i G = \sum_{i \in I} g_i G=∑i∈Igi, H = ∑ i ∈ I h i H = \sum_{i \in I} h_i H=∑i∈Ihi( g i g_i gi为一阶导, h i h_i hi为二阶导)

2.4 叶子权重计算

对叶子节点

j

j

j,最优权重为:

w

j

∗

=

−

∑

i

∈

I

j

g

i

∑

i

∈

I

j

h

i

+

λ

w_j^* = -\frac{\sum_{i \in I_j} g_i}{\sum_{i \in I_j} h_i + \lambda}

wj∗=−∑i∈Ijhi+λ∑i∈Ijgi

2.5 模型更新

F m ( x ) = F m − 1 ( x ) + ν ∑ j = 1 J w j 1 ( x ∈ R j ) F_m(x) = F_{m-1}(x) + \nu \sum_{j=1}^J w_j \mathbf{1}(x \in R_j) Fm(x)=Fm−1(x)+νj=1∑Jwj1(x∈Rj)

3. 模型评估

评估指标

| 任务类型 | 常用指标 |

|---|---|

| 回归 | MSE, MAE, R 2 R^2 R2 |

| 分类 | Accuracy, F1-Score, AUC-ROC |

| 排序 | NDCG, MAP |

防止过拟合

- 早停法:验证集性能不再提升时停止迭代

- 正则化:通过 γ \gamma γ, λ \lambda λ 控制复杂度

- 子采样:每次迭代随机选择部分样本或特征

4. 应用案例

4.1 金融风控

- 场景:信用评分卡

- 特征:收入、负债比、交易频率

- 效果:AUC 提升 12% 对比逻辑回归

4.2 推荐系统

- 场景:电商点击率预测

- 特征组合:自动学习“用户年龄×商品类别”等交叉特征

- 优势:处理高维稀疏特征优于协同过滤

4.3 计算机视觉

- 场景:图像语义分割

- 做法:GBDT 处理 CNN 提取的特征向量

- 结果:在 Pascal VOC 上 mIOU 提升 3.2%

5. 面试题及答案

Q1:GBDT 为什么拟合负梯度?

A:通过梯度下降在函数空间优化,负梯度是损失下降最快的方向。

Q2:如何处理分类特征?

A:最佳实践是使用直方图算法(如 LightGBM):

- 按特征取值排序

- 根据梯度直方图寻找最优分裂点

- 复杂度从 O ( # categories ) O(\#\text{categories}) O(#categories) 降至 O ( bin ) O(\text{bin}) O(bin)

Q3:GBDT vs Random Forest?

| 维度 | GBDT | Random Forest |

|---|---|---|

| 基学习器关系 | 串行依赖 | 并行独立 |

| 偏差-方差 | 低偏差 | 低方差 |

| 过拟合 | 易过拟合(需早停) | 抗过拟合能力强 |

| 数据敏感度 | 需特征缩放 | 无需特征缩放 |

6. 优缺点分析

优点

- 非线性能力强:自动捕捉高阶交互特征

- 鲁棒性好:对异常值和缺失值不敏感

- 可解释性:可通过特征重要性分析(累积分裂增益)

Importance j = ∑ splits ( j ) Gain \text{Importance}_j = \sum_{\text{splits}(j)} \text{Gain} Importancej=splits(j)∑Gain - 适用广泛:支持回归/分类/排序任务

缺点

- 训练效率低:串行训练无法并行化(改进:LightGBM 用 leaf-wise 生长)

- 高维稀疏数据:文本数据表现不如神经网络

- 超参敏感:需精细调参(树深度、学习率等)

7. 数学推导示例(回归问题)

目标:最小化平方损失

L

=

1

2

(

y

i

−

F

(

x

i

)

)

2

L = \frac{1}{2}(y_i - F(x_i))^2

L=21(yi−F(xi))2

伪残差:

r

i

=

−

∂

L

∂

F

∣

F

=

F

m

−

1

=

y

i

−

F

m

−

1

(

x

i

)

r_i = -\frac{\partial L}{\partial F} \bigg|_{F=F_{m-1}} = y_i - F_{m-1}(x_i)

ri=−∂F∂L

F=Fm−1=yi−Fm−1(xi)

叶子权重(设

λ

=

0

\lambda=0

λ=0):

w

j

∗

=

∑

i

∈

R

j

r

i

∣

R

j

∣

=

残差的均值

w_j^* = \frac{\sum_{i \in R_j} r_i}{|R_j|} = \text{残差的均值}

wj∗=∣Rj∣∑i∈Rjri=残差的均值

模型更新:

F

m

(

x

)

=

F

m

−

1

(

x

)

+

ν

∑

j

=

1

J

w

j

1

(

x

∈

R

j

)

F_m(x) = F_{m-1}(x) + \nu \sum_{j=1}^J w_j \mathbf{1}(x \in R_j)

Fm(x)=Fm−1(x)+νj=1∑Jwj1(x∈Rj)

💡 关键洞察:GBDT 将优化问题转化为函数空间的梯度下降,每棵树对应一次梯度更新。实际应用优先选择改进算法(XGBoost/LightGBM/CatBoost),它们在效率、准确性和工程实现上均有显著提升。