第64篇:构建你的第一个大模型 Chatbot

手把手教你从零开始搭建一个基于大模型的聊天机器人

摘要

你是否想过,自己也能构建一个像 ChatGPT 一样能对话、能思考的聊天机器人(Chatbot)?别担心,这并不需要你是 AI 博士或资深工程师。

本文将手把手带你完成 从零到一构建一个完整的大模型 Chatbot 的全过程。我们将使用 Python + FastAPI 构建后端服务,通过 OpenAI API 接入 GPT-3.5 或 GPT-4 大模型,并结合 Streamlit 实现前端交互界面,最后教你在本地和云端部署上线。

无论你是 AI 初学者还是有一定编程基础的开发者,这篇文章都将为你打开通往 AI 应用开发的大门。

核心概念与知识点

1. Chatbot 基础架构

大模型的选择

| 模型名称 | 提供方 | 是否开源 | 特点 |

|---|---|---|---|

| GPT-3.5 / GPT-4 | OpenAI | 否 | 表现优秀,适合商用 |

| Llama / Llama2 | Meta | 是 | 可本地部署,性能强 |

| ChatGLM | Zhipu AI | 是 | 中文友好,推理速度快 |

✅ 本文以 OpenAI 的 GPT-3.5-turbo 为例,便于快速上手。

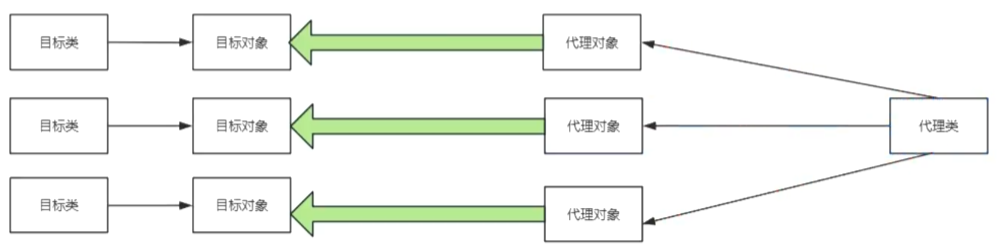

前后端通信机制

- 前端(用户输入 → 发送请求)

- 后端(调用模型 → 返回结果)

- 使用 RESTful API 进行通信(JSON 格式)

对话状态管理策略

- 简单实现:每次只传当前消息

- 高级实现:维护历史记录,传递上下文(

messages数组)

2. 核心功能实现【实战部分】

初始化项目环境(Python + FastAPI)

安装依赖:

pip install fastapi uvicorn openai streamlit

创建目录结构:

chatbot/

├── backend/

│ └── main.py # FastAPI 主程序

├── frontend/

│ └── app.py # Streamlit 前端

└── requirements.txt

集成大模型 API(如 OpenAI)

# backend/main.py

import openai

from fastapi import FastAPI, HTTPException

from pydantic import BaseModel

from typing import List

app = FastAPI()

# 设置 OpenAI API Key

openai.api_key = "your_openai_api_key"

# 定义请求数据模型

class ChatRequest(BaseModel):

message: str

history: List[dict] = []

@app.post("/chat")

async def chat(req: ChatRequest):

try:

# 调用 GPT-3.5 模型

response = await openai.ChatCompletion.acreate(

model="gpt-3.5-turbo",

messages=req.history + [{"role": "user", "content": req.message}]

)

return {"response": response.choices[0].message.content}

except Exception as e:

raise HTTPException(status_code=500, detail=str(e))

📌

history字段用于传递对话历史,使得模型能理解上下文。

实现基本对话接口

运行后端服务:

cd backend

uvicorn main:app --reload

访问 http://localhost:8000/docs 查看自动生成的 Swagger 文档,测试 /chat 接口。

示例输入输出:

{

"message": "你好,请介绍一下你自己。",

"history": []

}

返回:

{

"response": "我是由 GPT-3.5 支持的 AI 助手,可以帮你回答问题、写故事、写邮件等任务。"

}

3. 前端界面搭建【实战部分】

使用 Streamlit 构建简易 UI

# frontend/app.py

import streamlit as st

import requests

st.set_page_config(page_title="我的第一个 Chatbot")

st.title("💬 我的第一个大模型 Chatbot")

if "messages" not in st.session_state:

st.session_state.messages = []

for message in st.session_state.messages:

with st.chat_message(message["role"]):

st.markdown(message["content"])

prompt = st.chat_input("请输入你想问的问题")

if prompt:

with st.chat_message("user"):

st.markdown(prompt)

st.session_state.messages.append({"role": "user", "content": prompt})

# 调用后端 API

payload = {

"message": prompt,

"history": st.session_state.messages

}

response = requests.post("http://localhost:8000/chat", json=payload).json()

answer = response.get("response", "")

with st.chat_message("assistant"):

st.markdown(answer)

st.session_state.messages.append({"role": "assistant", "content": answer})

✅ 使用 Streamlit 的

session_state实现简单的“记忆”功能。

运行前端:

cd frontend

streamlit run app.py

4. 部署与上线

本地运行 vs 云端部署

| 方式 | 优点 | 缺点 |

|---|---|---|

| 本地运行 | 免费、简单 | 无法公网访问 |

| HuggingFace Space | 快速部署、支持 GPU | 需注册账号 |

| Vercel / Render | 支持前后端分离部署 | 学习成本略高 |

使用 Ngrok 内网穿透测试

安装 ngrok:

npm install -g ngrok

启动穿透:

ngrok http 8000

复制生成的 URL 替换前端代码中的 http://localhost:8000,即可让他人访问你的服务。

实战案例研究

案例一:构建一个问答型客服机器人

功能需求:

- 用户提问常见问题(如价格、发货时间)

- 机器人自动识别意图并回复标准答案

技术实现:

- 在

/chat接口中添加关键词匹配逻辑 - 如果是 FAQ 类问题,直接返回预设答案

faq_map = {

"运费": "我们提供全国包邮服务。",

"退货政策": "7天内无理由退换货。"

}

if any(keyword in req.message for keyword in faq_map):

return {"response": faq_map[req.message]}

案例二:创建个人助手型聊天应用

功能需求:

- 记录待办事项

- 查询天气

- 自动总结长文本

技术实现:

- 添加多个工具函数(如

get_weather,summarize_text) - 在

/chat中判断意图并调用对应工具

def get_weather(city):

# 模拟获取天气信息

return f"{city}今天气温22°C,多云。"

总结与扩展

如何加入语音识别能力?

你可以使用以下方式为 Chatbot 添加语音输入/输出:

- 语音识别:Google Speech-to-Text / Whisper

- 语音合成:ElevenLabs / Azure TTS

集成 LangChain 提升复杂任务处理能力

LangChain 是一个强大的框架,可以帮助你:

- 将多个模型串联执行复杂任务

- 构建 Agent(代理),自动选择工具执行操作

安装:

pip install langchain

示例:

from langchain.agents import initialize_agent

agent = initialize_agent(llm, tools, agent="structured-chat-zero-shot-react-description")

结语

通过本文的学习,你应该已经掌握了如何:

✅ 搭建一个基于大模型的 Chatbot 后端服务

✅ 实现对话历史传递与上下文理解

✅ 构建一个具备交互能力的前端界面

✅ 在本地和云端部署上线你的 Chatbot

下一步,你可以尝试将其扩展为一个企业级客服系统、智能助手平台,甚至集成语音能力,打造更丰富的交互体验。

如需进一步定制化开发或团队培训,欢迎联系作者!