在互联网时代,网站内容被恶意爬虫或采集工具窃取已成为常见问题。这不仅侵犯原创权益,还可能影响网站性能和SEO排名。以下是结合技术、策略与法律的综合解决方案,帮助网站构建有效防护体系。

一、技术防护:阻断爬虫的“技术防线”

- 动态内容加载与混淆

通过JavaScript动态加载核心内容,或对HTML结构进行随机字符混淆,使爬虫难以直接解析页面。例如,关键数据(如价格、文章正文)可延迟加载,或使用AJAX异步获取。 - IP与频率限制

- IP封禁:对同一IP短时间内高频访问触发验证码或直接封禁。

- 频率控制:设置每秒请求上限(如3次),避免服务器资源被耗尽。

- 行为验证与反爬虫服务

- 人机验证:在敏感页面(如注册、评论)嵌入滑块验证码或图片验证码,增加爬虫操作难度。

- 反爬虫服务:借助Cloudflare、德迅云眼等工具,自动识别并拦截异常流量,同时提供DDoS防护和SSL加密。

- HTTP头信息检测

检测请求头中的User-Agent、Referer等字段,拦截伪造的爬虫标识。例如,通过Canvas指纹或WebGL检测设备唯一性。

二、策略优化:从内容到架构的“主动防御”

- 内容差异化设计

- 水印与版权标识:在图片、文档中嵌入隐形水印或版权声明,便于追踪侵权来源。

- 动态载体混合:将文本拆分为图片、SVG或交互图表,降低直接复制可行性。

- 网站架构调整

- URL加密与陷阱:对核心页面使用动态URL参数(如时间戳),或设置蜘蛛陷阱(如无限循环链接),误导爬虫。

- 定期更新HTML结构:修改类名、ID等前端代码,打乱爬虫的固定抓取逻辑。

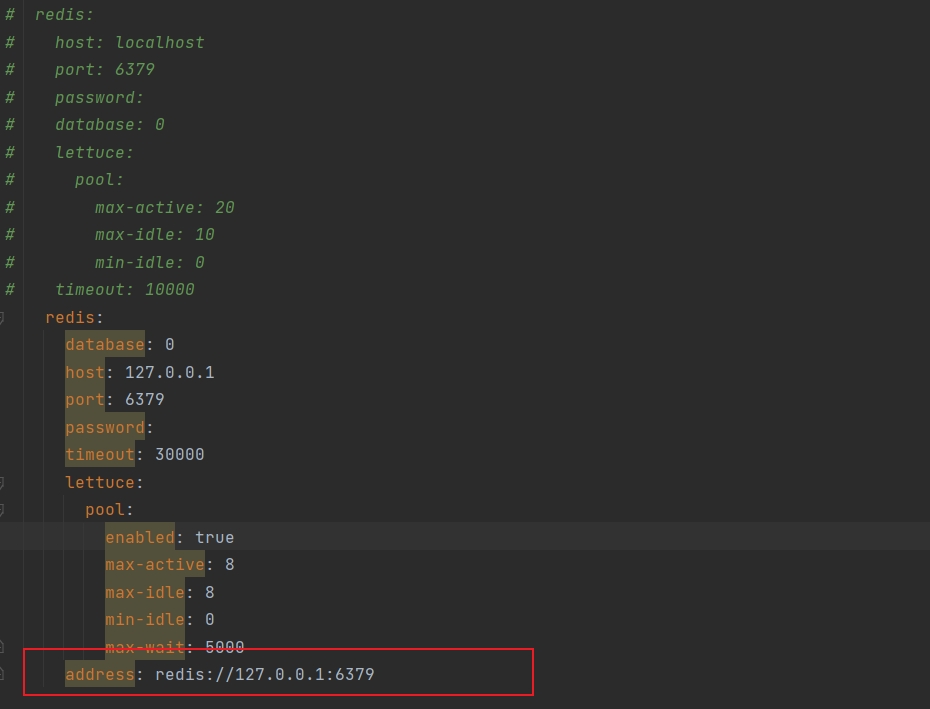

- 服务器安全加固

- HTTPS加密:防止数据传输中被窃取或篡改。

- CDN加速与防火墙:通过安全CDN隐藏源站IP,分散攻击压力。

三、法律手段:从监测到维权的“长效保障”

- 全网监测与取证

- 使用Copyscape、Grammarly等工具定期扫描全网内容相似度,发现侵权后通过公证固定证据。

- 对API接口或核心数据加密,防止泄露。

- 法律行动与投诉

- 发送DMCA警告函或向平台投诉,要求删除侵权内容。

- 保留访问日志、用户行为数据,作为诉讼依据。

四、平衡用户体验与安全

- 合理设置Robots.txt:明确禁止爬虫访问敏感目录,但避免过度限制合法搜索引擎。

- 分层防护策略:对普通用户保持友好,对异常流量采取梯度拦截(如先验证码,再封禁)。

结语

防采集是一场持续的攻防战。技术手段需定期迭代(如升级反爬虫算法),内容策略需保持创新(如动态加载与差异化设计),法律手段则是最后的底线。网站运营者应结合自身需求,选择“技术+策略+法律”的综合方案,同时专注高质量内容生产,让原创价值成为核心竞争力。