用工作流生成测试用例和自动化测试脚本!

引言:用例的黄金起点

在软件工程中,“测试用例”是连接需求理解与质量保障之间的关键桥梁。一份高质量的测试用例,不仅是验证功能实现是否符合需求的工具,更是产品风险感知、用户行为建模、自动化测试可行性分析的基础。用例的构建,是一项高认知、强经验驱动的复杂任务。

而近年来,大语言模型(LLM, Large Language Model)赋予我们一个前所未有的可能性:

能否将复杂、非结构化的自然语言需求,自动转化为结构清晰、覆盖充分的测试用例?

这个问题,正站在“AI重塑软件测试流程”的入口处,引发了一场“从需求到用例”的智能变革。

一、测试用例生成的传统难点

传统软件测试用例的构建,大致经历以下流程:

-

阅读需求说明书(PRD、BRD、用户故事等)

-

理解功能逻辑、角色行为、边界条件

-

提取测试点(What to test?)

-

设计测试步骤、输入数据与期望输出

-

评估覆盖率与风险等级,优化冗余

这个过程中最关键也最耗时的是从非结构化文本中提炼测试点与逻辑路径,其痛点如下:

| 难点 | 描述 |

|---|---|

| 语义理解复杂 | 自然语言描述冗长、含糊,需强领域知识理解 |

| 逻辑推理要求高 | 多个条件组合、状态迁移路径需理清 |

| 场景覆盖缺失 | 容易遗漏边界值、负面路径、异常流程 |

| 高度依赖人力 | 需资深测试分析师花费大量时间构建 |

在需求不断变化的敏捷开发环境中,手动维护用例变得越来越不可持续,测试人员呼唤更智能的工具。而AI,正好来敲门。

二、大模型如何“读懂”需求?

以GPT-4、文心一言、通义千问、ChatGLM等代表的大语言模型为核心的AI系统,具备以下能力,使其成为自动化测试用例生成的有力候选:

1. 自然语言理解与信息抽取

-

识别功能模块、用户行为、输入输出

-

抽取业务规则与条件触发逻辑

-

解析状态转换与前置条件

示例:

需求:“用户登录后可上传头像,上传文件大小不能超过2MB,格式限于jpg、png。”

模型可输出:

{

"测试点": [

"登录后上传头像",

"上传大于2MB的文件应失败",

"上传非jpg/png文件应失败",

"上传jpg/png小于2MB的文件应成功"

]

}

2. 用例结构化生成

通过精心设计的Prompt模板,模型可输出结构完整的测试用例:

{

"用例ID": "TC001",

"标题": "上传头像 - 成功路径",

"前置条件": "用户已登录",

"输入数据": "头像.jpg,文件大小1.5MB",

"测试步骤": ["登录", "点击个人中心", "点击上传头像", "选择头像.jpg", "点击上传"],

"期望结果": "头像上传成功,页面显示更新后的头像"

}

这使得从自然语言需求到自动化测试框架的低代码对接成为可能。

三、AI路径中的“准确率”真相

✅ 成果亮眼

实测表明,LLM在生成中低复杂度业务场景的测试用例时,可实现:

-

用例覆盖率达到人工构建的80%以上

-

生成速度提升10~20倍

-

易于通过模板接入JUnit、pytest等自动化框架

❗ 挑战依然严峻

然而,“准确率”绝不仅仅是语句通顺或结构完整,更关键的是是否覆盖正确的测试点、是否反映业务风险、是否具备逻辑完整性。在以下场景中,AI尚存在明显短板:

| 挑战场景 | 描述 |

|---|---|

| 条件嵌套与状态转移复杂的场景 | 模型容易漏测组合路径 |

| 安全性、合规性用例 | 需理解法规条文与隐含规则 |

| UI/UX交互细节 | 模型对图形界面逻辑理解力有限 |

| 多角色、多权限系统 | 测试路径组合呈指数级增长,模型难穷尽 |

| 高阶异常处理 | 如网络中断、事务回滚等非常规路径难覆盖 |

此外,AI常出现幻觉(hallucination),即生成了需求中根本不存在的测试点,或误解业务逻辑,导致“看似合理、实则错误”的用例。这类错误在自动化测试中尤其危险,因为它们可能被悄无声息地执行,掩盖真实缺陷。

四、提高准确率的AI增强路径

为了在“从需求到用例”的路径中提升准确率,业界正在探索如下AI增强方案:

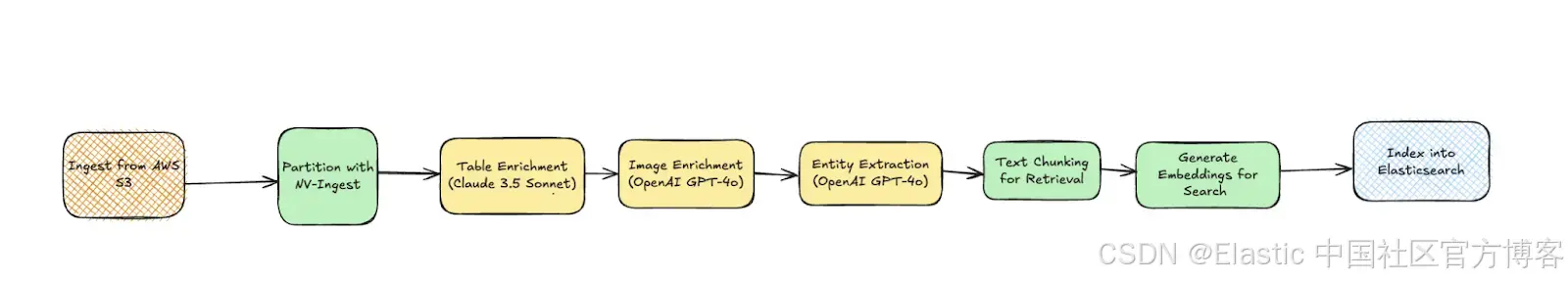

1. RAG(Retrieval-Augmented Generation)技术

将企业现有需求库、测试案例库接入大模型,使其在生成前“查阅背景资料”,可显著降低幻觉率。

示例架构:

需求文档 → 向量检索 → 匹配相似需求与测试点 → LLM整合生成用例

2. Prompt微调与模板约束

使用Few-shot Prompting或Chain-of-Thought Prompting逐步引导模型生成:

第一步:识别该段需求中的用户角色与行为。

第二步:列出所有输入条件与边界。

第三步:生成每一个测试路径。

分步提示让模型更聚焦、更稳定。

3. 多模型协同验证

使用一个模型生成测试用例,另一个模型对其进行校对(“生成-对审”机制),或采用双向生成(如:由测试用例反向还原需求,再比对一致性)来提升准确性。

4. 人机协同模式

当前最佳实践仍是“AI辅助 + 人工审核”:

-

AI完成初步生成

-

测试专家进行审校、风险评估与增补

-

最终集成为可执行测试集

五、未来展望:AI如何改变测试角色与流程?

大模型正逐步推动测试流程从“手工操作”向“知识自动化”演进,其深远影响包括:

-

测试分析师角色重塑:从编写者转为评审者、风险洞察者、Prompt设计者

-

测试资产管理升级:用例不再孤立存储,而成为可结构化生成的知识图谱节点

-

自动化测试驱动方式改变:从“脚本驱动”走向“语义驱动”

我们正在进入一个新时代:

用例不再是“写”出来的,而是“构建知识后自动生成”的。

六、结语:AI能走多远,取决于我们愿走多深

“从需求到用例”的AI路径,并非只是提高效率的捷径,它背后承载的是一个关于需求理解、认知建模与质量控制的智能革命。准确率的提升,不仅依赖模型的强大能力,更需要我们对测试知识、业务逻辑与AI协作边界的深入探索。

大模型不是测试工程师的替代者,而是智力倍增器。谁能掌握AI的“语言”,谁就能引领下一代测试方法论的变革。