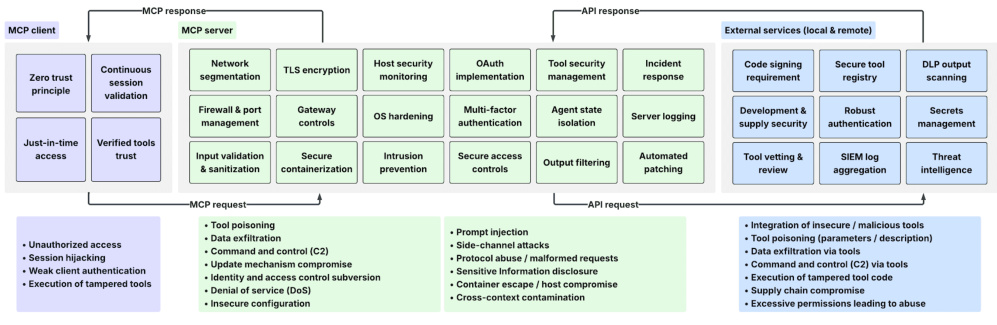

一、MCP的根本原理

模型上下文协议(MCP)是一种标准化接口协议,旨在解决AI系统(尤其是大型语言模型,LLM)与外部工具、数据源之间的交互碎片化问题。其核心原理可以概括为以下三点:

-

统一接口抽象

MCP通过定义服务描述文件(JSON格式),将外部工具的功能、输入参数、输出格式等标准化,使模型能够解析并动态调用这些服务。例如,一个天气预报API的服务描述文件会包含“功能类型”(如“查询天气”)、“参数要求”(如城市、时间)和“返回字段”(如温度、湿度)。这种方式类似于Web服务中的WSDL协议,但针对AI场景优化,支持自然语言交互的上下文感知。 -

上下文状态管理

MCP通过会话生命周期管理,维护AI模型与外部系统的交互状态。例如在多轮对话中,MCP会追踪用户的查询历史、已调用的工具及其返回结果,确保模型在后续交互中能基于完整上下文做出决策。这种机制解决了传统Function Calling协议仅支持单次调用的局限性。 -

双向通信与动态协商

采用客户端-服务器架构(Client-Host-Server),支持有状态的双向RPC模型。MCP客户端(集成于AI应用)与服务器(连接外部资源)之间通过事件驱动机制进行实时通信,例如异步任务执行和动态功能发现。服务器可主动推送新工具或数据源的更新,客户端则根据当前上下文选择最优调用路径。

二、MCP的工作机制

1. 核心架构组件

- MCP主机(Host) :运行AI模型的环境(如聊天机器人平台),负责发起请求并整合最终响应。

- MCP客户端(Client) :嵌入主机的模块,负责协议封装、工具发现请求发送及结果解析。

- MCP服务器(Server) :连接外部资源的枢纽,提供三类核心功能:

- 工具(Tools) :调用API或服务执行操作(如数据库查询、文件写入)。

- 资源(Resources) :提供结构化/非结构化数据(如知识库、实时传感器数据)。

- 提示(Prompts) :预定义的任务模板(如“生成周报摘要需先获取本周会议记录”)。

2. 交互流程示例

以“用户要求AI总结YouTube视频内容”为例:

- 意图解析:MCP客户端将用户自然语言指令转换为结构化请求,识别需调用“视频字幕提取”和“文本摘要”工具。

- 工具选择:客户端查询MCP服务器注册的工具列表,根据功能匹配度、权限、延迟等指标选择最优服务。

- 执行与反馈:

- 服务器调用YouTube API获取字幕,返回结构化数据(时间戳、文本)。

- 客户端将数据传递给AI模型生成摘要,再通过MCP服务器写入本地文件系统。

- 状态同步:会话ID、工具调用记录、中间结果等上下文信息在主机与服务器间实时同步,支持后续追问(如“将摘要翻译成法语”)。

3. 关键技术特性

- 动态能力协商:服务器可声明其支持的功能范围(如“仅能处理≤10MB文件”),客户端据此调整请求策略。

- 安全沙箱机制:敏感操作(如删除文件)需通过OAuth 2.0+授权,并在隔离环境中执行。

- 协议扩展性:支持插件式扩展,例如新增“图像识别”工具只需在服务器注册描述文件,无需修改客户端代码。

总结

MCP通过标准化接口、上下文感知和动态资源协商,成为连接AI模型与真实世界的“神经系统”。其核心价值在于降低集成复杂性(开发成本减少70%)和扩展模型能力边界(支持千级工具调用)。尽管面临安全与标准化挑战,随着企业级安全框架的成熟和生态扩展,MCP正推动AI从封闭的对话系统向开放的任务执行平台演进。