书生·浦语大模型开源开放体系

书生·浦语开源一周年历史

- 2023.7.6:InternLM-7B开源率先免费商用发布全链条开源工具体系

- 2023.9.20:InternLM-20B开源,开源工具链全线升级

- 2024.1.17:InternLM2开源,性能超最新同量级开源模型

- 2024.7.4:InternLM2.5开源

模型能力比较

书生·浦语2.5概览

推理能力领先: 综合推理能力领先社区开源模型相对InternLM2性能提升20%。

支持100万字上下文: 百万字长文的理解和精确处理性能处于开源模型前列。

自主规划和搜索完成复杂任务: 通过信息搜索和整合,针对复杂问题撰写专业回答,效率提升60倍。

核心技术思路

模型能力飞轮

高质量合成数据

领先的推理能力

100万Token上下文

基于规划和搜索解决复杂问题

书生·浦语开源模型谱系

全链条开源,与社区生态无缝连接

书生·万卷: 首个精细处理的开源多模态语料库

InternEvo: 性能超过国际主流训练框架DeepSpeed

XTuner: 多种微调和偏好对齐算法,支持千亿参数+百万上下文

LMDeploy: 性能超过国际主流推理框架vllm

OpenCompass: 社区最全面的开源评测体系

MindSearch: 思索式开源搜索应用

Lagent: 首个支持代码解释器的智能体框架

MinerU: 高效文档解析工具

HuixiangDou: 基于专业知识库的群聊助手

全链条开源开放体系 | 数据

全链条开源开放体系 | 开源数据处理工具箱

全链条开源开放体系 | 预训练 InternEvo

全链条开源开放体系 | 微调XTuner

适配多种生态

- 多种微调算法

多种微调 & 偏好对齐算法,覆盖各类应用场景 - 适配多种开源生态

支持加载HuggingFace、ModelScope 模型或数据集 - 自动优化加速

开发者无需关注复杂的显存优化与计算加速细节

支持千亿参数 + 百万上下文训练

适配多种硬件

- 训练方案覆盖 NVIDIA 20 系以上所有显卡

- 最低只需 8GB 显存即可微调7B模型

XTuner效果对比图

零显存浪费的偏好对齐训练方案

全链条开源开放体系 | OpenCompass 评测体系

构建科学、领先、公平的大模型评测体系,携手行业助力通用人工智能发展

全链条开源开发体系 | 部署 LMDeploy

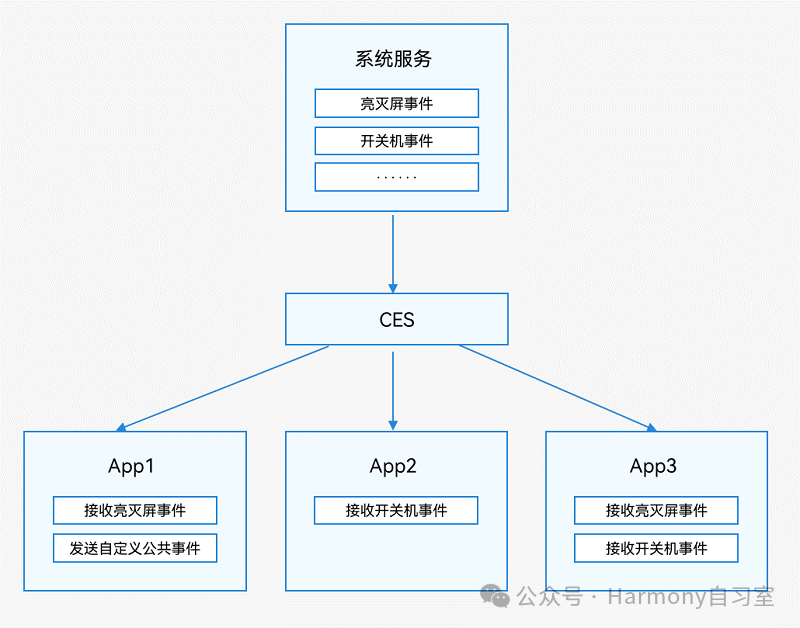

全链条开源开放体系 | 智能体

大语言模型的局限性

- 最新信息和知识的获取

- 回复的可靠性

- 数学计算

- 工具使用和交互

全链条开源开放体系 | 智能体 MindSearch

HuixiangDou 特性

![[大模型]Diffusion扩散式生成模型](https://i-blog.csdnimg.cn/direct/7747c6d712f044b58fc7481a0e6898f0.png)