利用Ollama部署本地大模型

一:终端实现与大模型对话

1.去Ollama官网下载

https://ollama.com/download

2.下载之后按照提示一步步安装即可

3.Win+R, 输入cmd,打开命令行提示符

输入:ollama run llama3运行大模型

4.使用其他开源大模型,比如qwen2

命令:ollama run qwen2

管理ollama

ollama list

删除模型

ollama rm+模型名字

如何结束在终端与大模型的对话?

1.Ctrl+D

2.直接输入“bye”

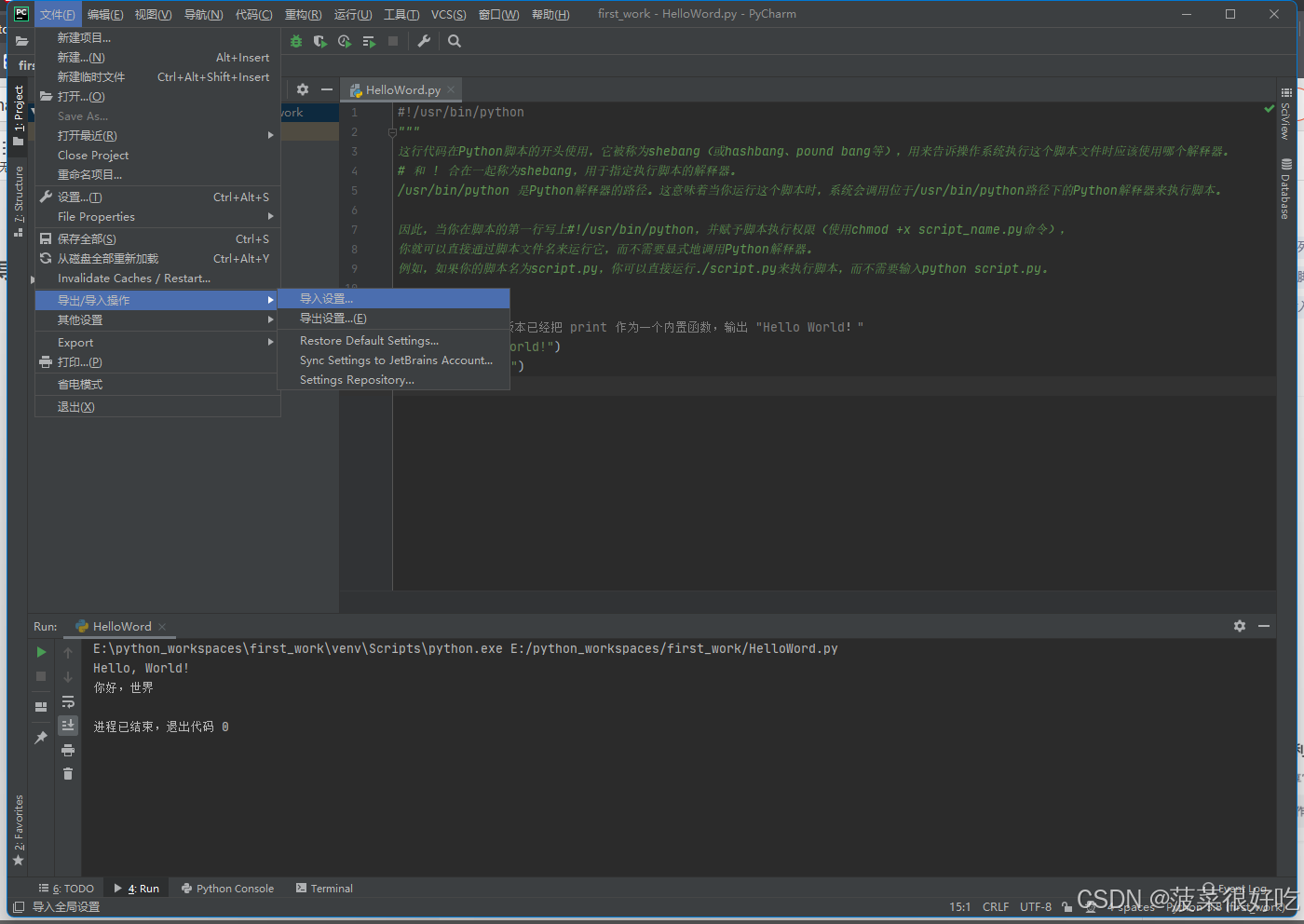

二:Open WebUI中与大模型对话

1.下载Docker

2.命令行中运行命令

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

如果出现了上述错误“unknown flag: --add See ‘docker run --help’.”,这种情况,需要检查下输入的语句是否正确!

正常运行的状态,时间会有点久……大概几分钟,因为需要远程下载个包

成功后回自动弹出浏览器页面,如果没有弹出,你可以手动在搜索栏输入“localhost:3000",跳转进入页面或者进入docker中点击跳转链接

创建账号,登录

总结:

使用效果:【生成答案速度太慢,基本答非所问,体验感不太行……】

学习链接:https://www.bilibili.com/video/BV1zZ421T7Ep/spm_id_from=autoNext&vd_source=20a76bd7aa0358839f0334c33018daa6

本地部署知识库MaxKB

前面我们已经下载安装好了Docker,所以只需要在命令行中输入以下命令:

docker run -d --name=maxkb -p 8080:8080 -v ~/.maxkb:/var/lib/postgresql/data cr2.fit2cloud.com/1panel/maxkb

MaxKB部署:https://github.com/1panel-dev/MaxKB?tab=readme-ov-file

docker run -d --name=maxkb -p 8080:8080 -v ~/.maxkb:/var/lib/postgresql/data cr2.fit2cloud.com/1panel/maxkb

# 用户名: admin

# 密码: MaxKB@123..

Docker中点击链接或者浏览器输入“`localhost:8080”进入页面,输入账号和密码

添加模型:

点击系统设置-选择模型设置-添加模型-ollama[进行具体设置]

如果API域名无法设置,改成这个http://host.docker.internal:11434/,即可添加模型

添加应用:

点击应用-创建应用-

添加知识库

将应用与知识库进行链接

学习链接:

https://www.bilibili.com/video/BV1bU411Z7eo/spm_id_from=333.788.recommend_more_video.30&vd_source=20a76bd7aa0358839f0334c33018daa6

![[UTCTF2020]babymips](https://i-blog.csdnimg.cn/direct/5d2b0613fa324cde9be35190fd846330.png)