AI大模型本地简易搭建方式

- 前言

- 步骤

- 下载Ollama

- 安装Ollama

- 修改Ollama中下载模型的位置

- 检查Ollama是否安装成功

- 下载模型

- 尝试与模型对话

- 使用API访问模型

- 下载Docker(后续补充Docker运行OpenWebUI方式)

- 总结

前言

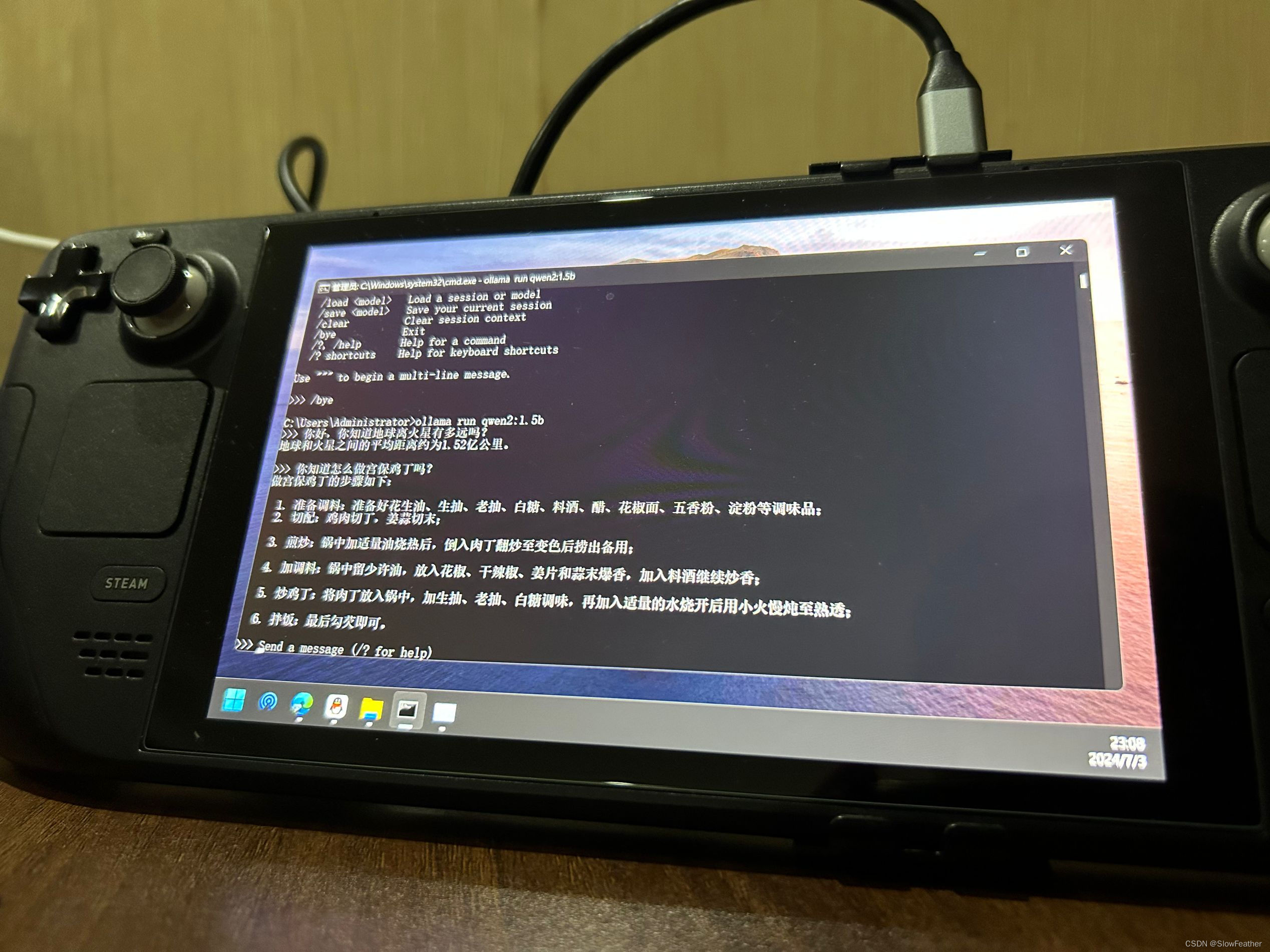

朋友想要实现一个本地ChatGPT风格的对话功能,在Steam Deck上再安装一遍,记录一下。

步骤

下载Ollama

到Github上直接点击下载

GitHub - ollama/ollama: Get up and running with Llama 3, Mistral, Gemma 2, and other large language models.

安装Ollama

双击安装即可

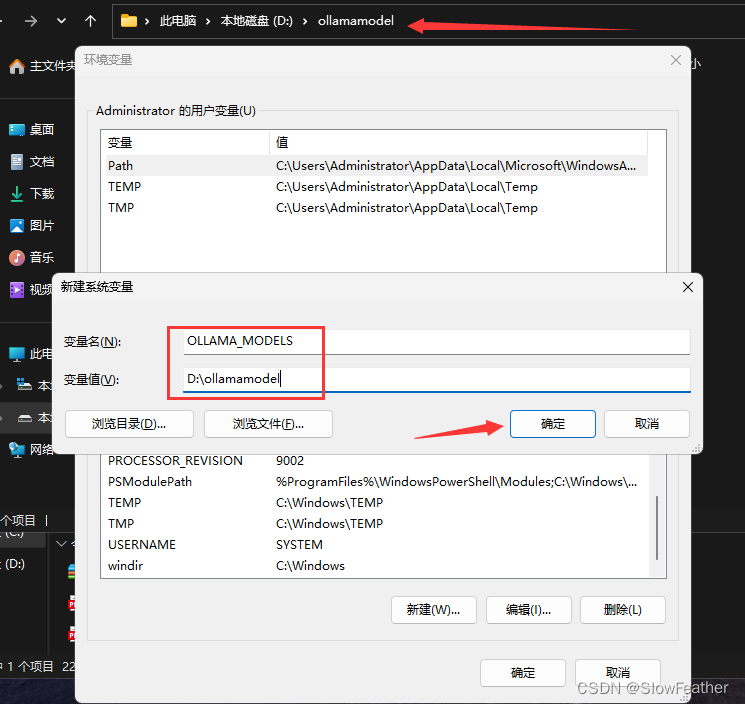

修改Ollama中下载模型的位置

这里防止所有模型都下载到C盘,可以修改一下下载位置

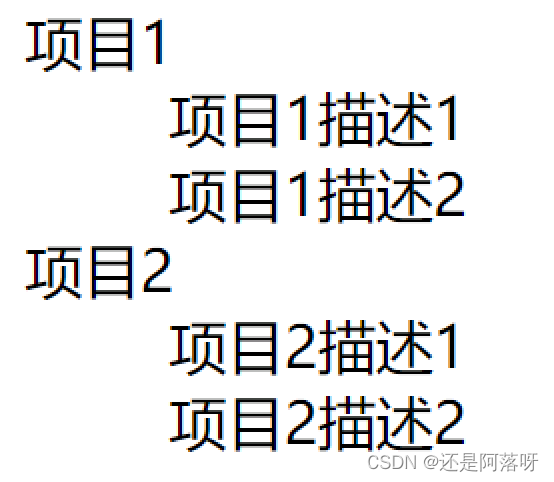

可以在其他盘建一个空文件夹存放模型,此处在D盘新建ollamamodel文件夹,并修改系统环境变量,记得点确定

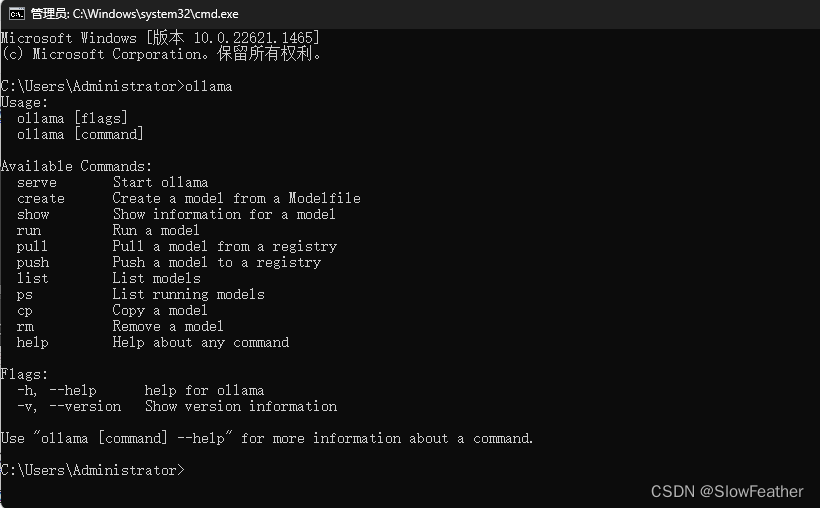

检查Ollama是否安装成功

检查托盘图标和控制台输入ollama来测试是否正常安装

下载模型

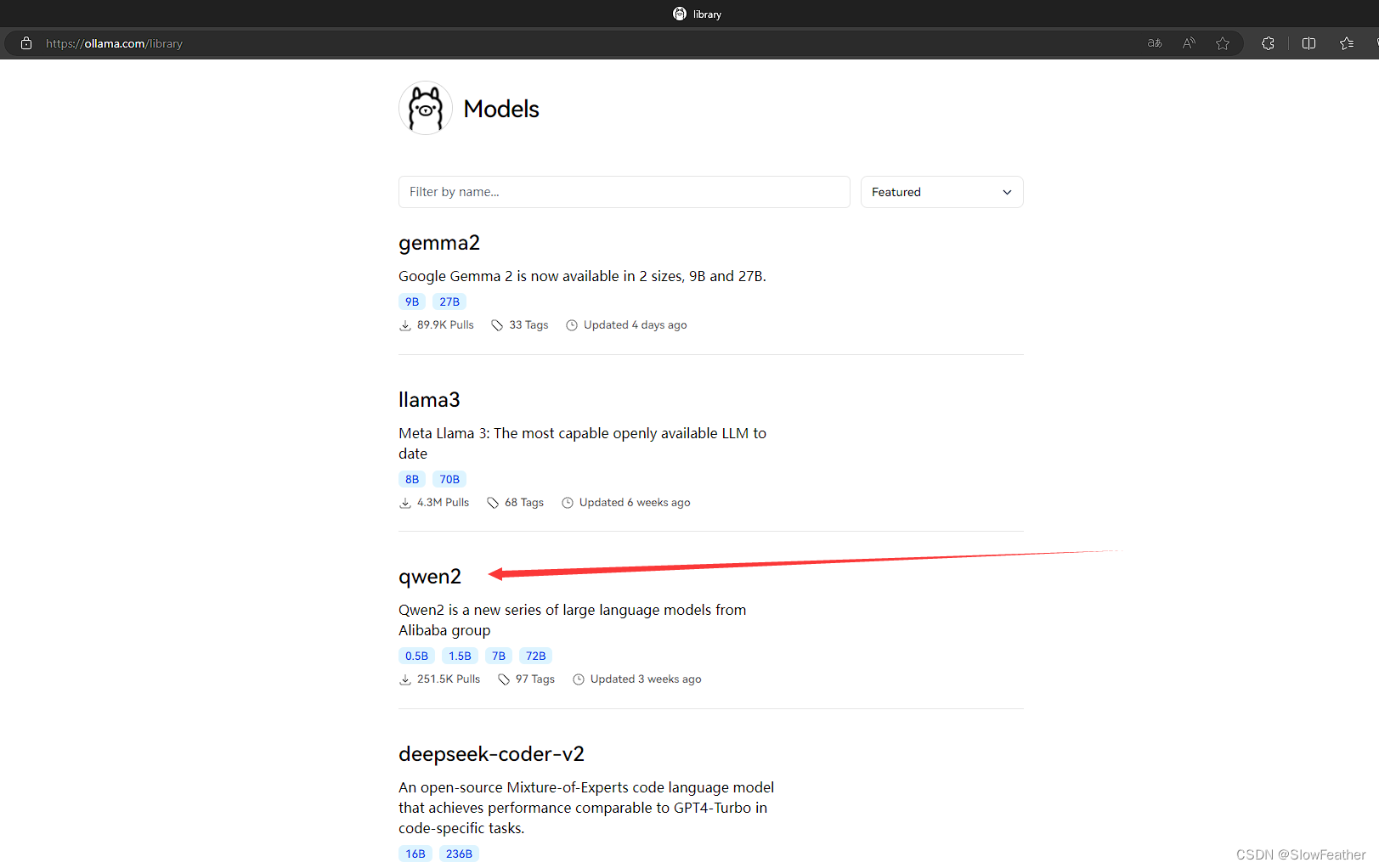

可以在这里找到自己想使用的模型

Ollama Models

里面会有对应的命令直接复制粘贴到命令行即可

比如我们要下载qwen2的1.5B模型,选择qwen2

进入并复制命令

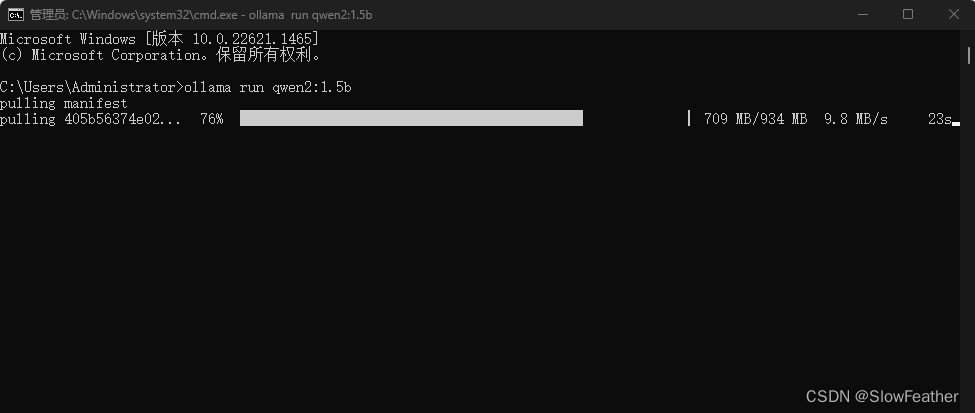

在控制台粘贴此命令

耐心等待下载即可

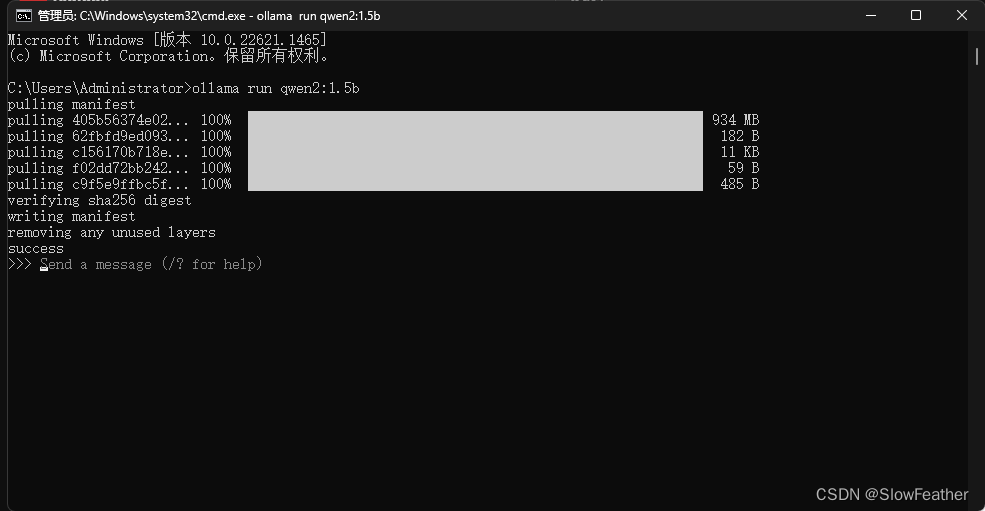

尝试与模型对话

此时说明模型加载完毕,可以进行对话测试

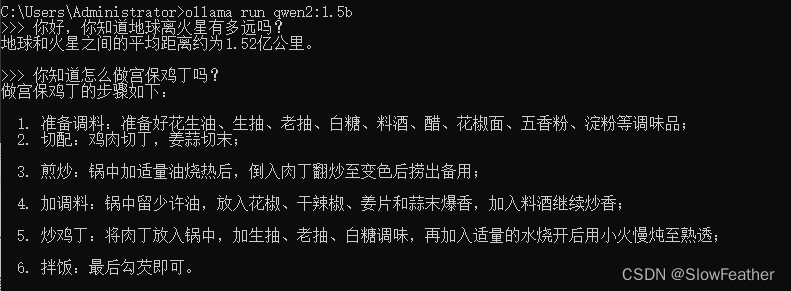

可以尝试输入问题进行对话

输入/?可查看常用命令

输入/bye可退出聊天

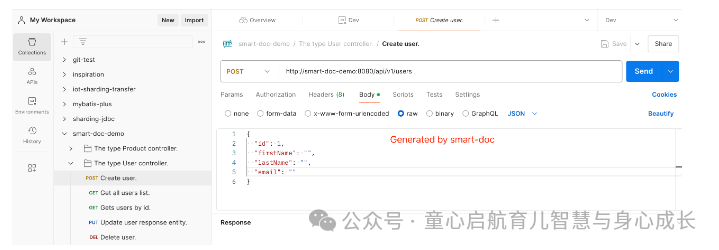

使用API访问模型

Ollama API使用指南

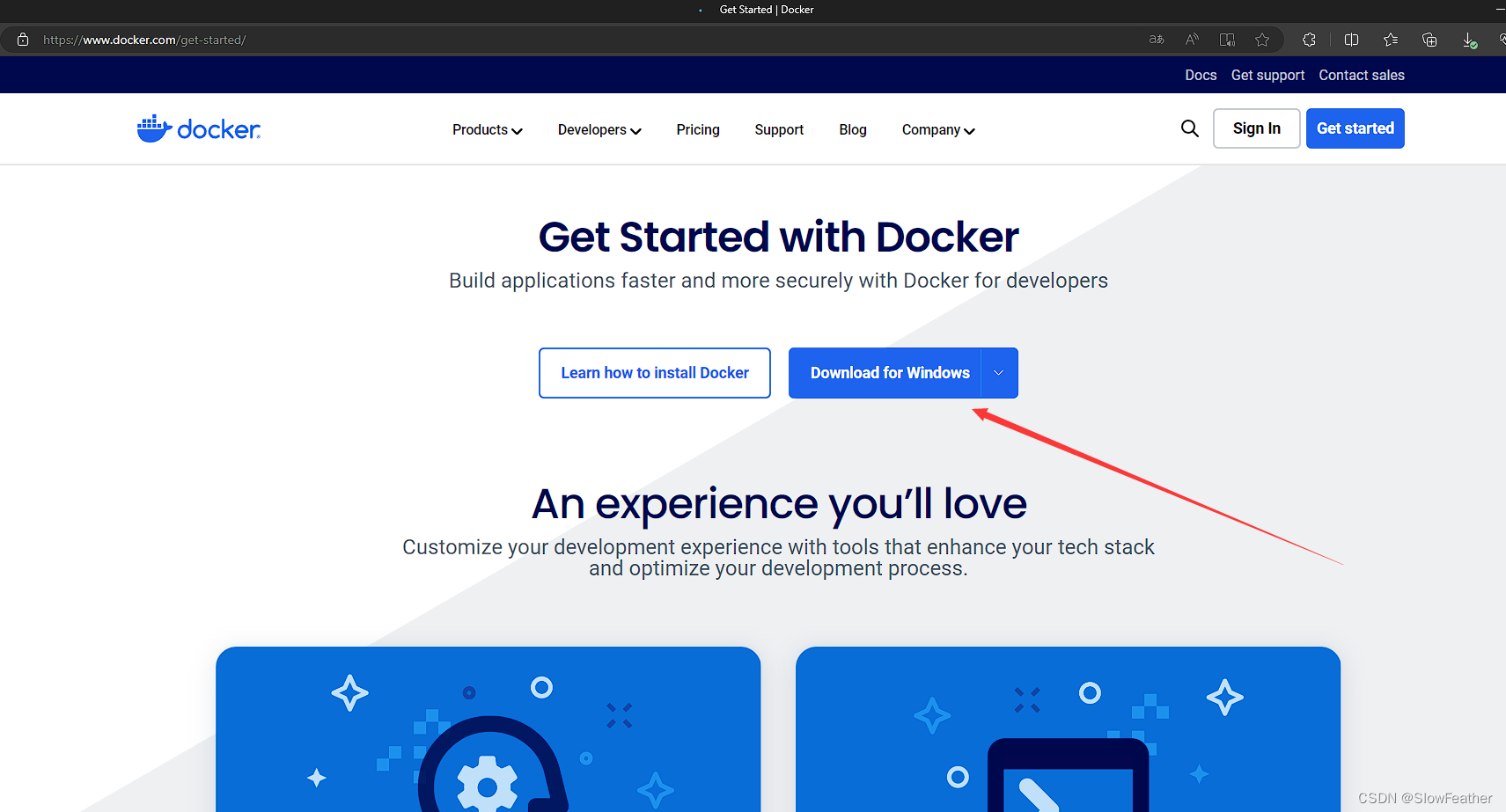

下载Docker(后续补充Docker运行OpenWebUI方式)

去官网下载即可

Docker官网

总结

Steam Deck可能会成为未来微粒计算以及智能硬件的个人计算中枢雏形。