我们可使用本地大型语言模型,如Mistral、Llama等,来给文本做总结,相比在线的 Kimi ,ChatGPT, 我们不用担心数据泄露,因为整个操作都是在本地电脑完成的。

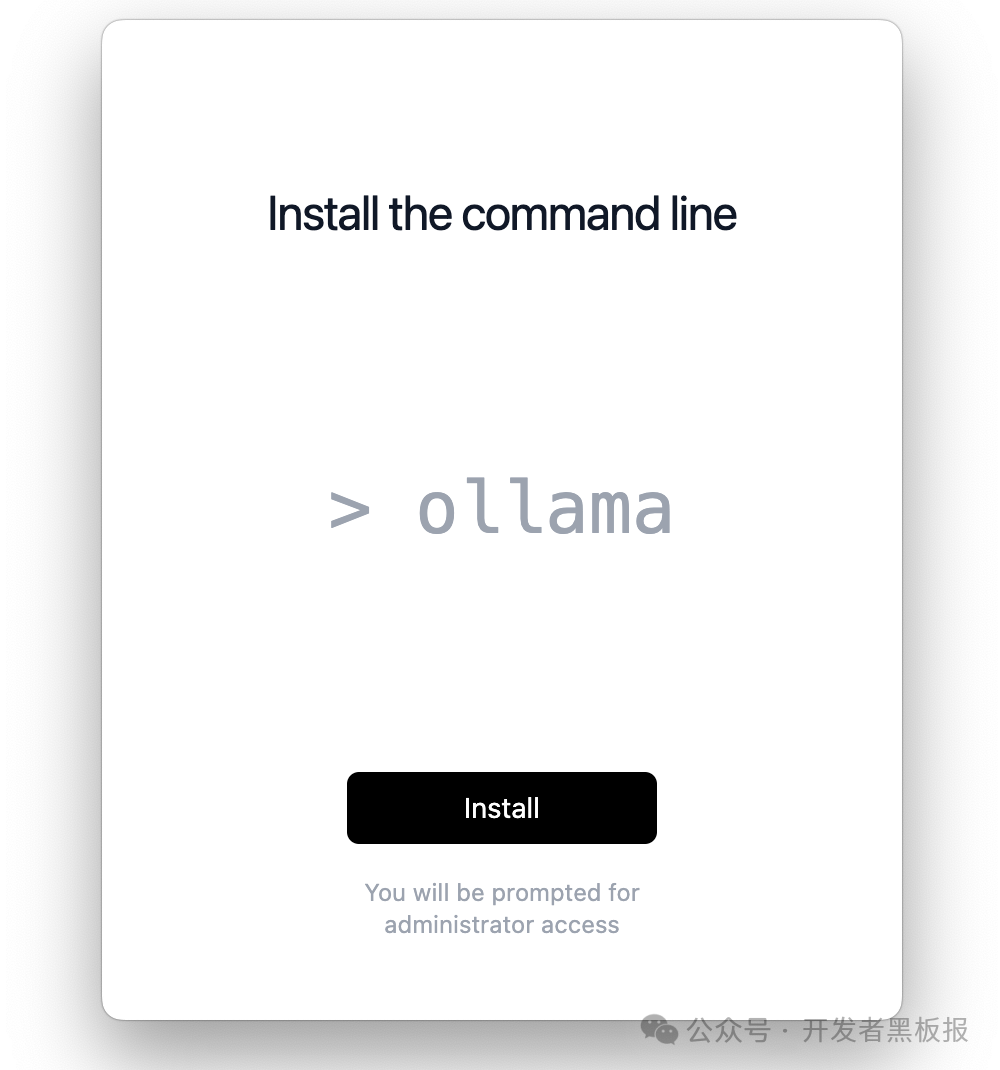

我们用 ollama 举例

首先安装 ollama https://ollama.com/ ,

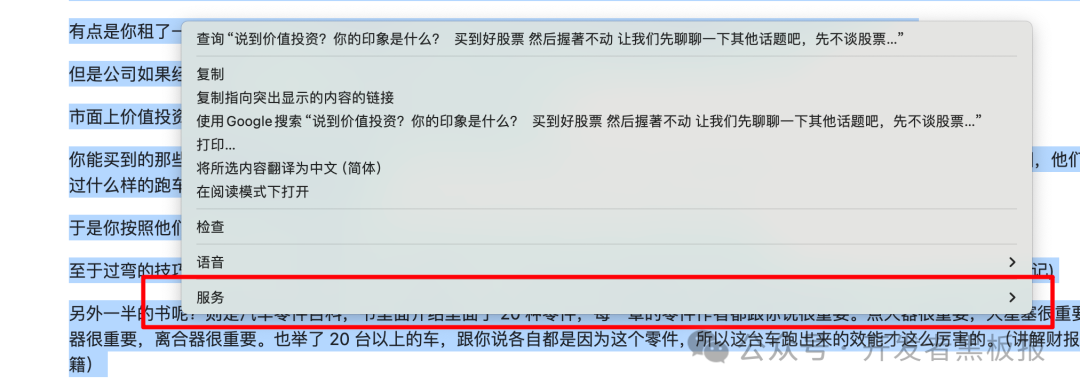

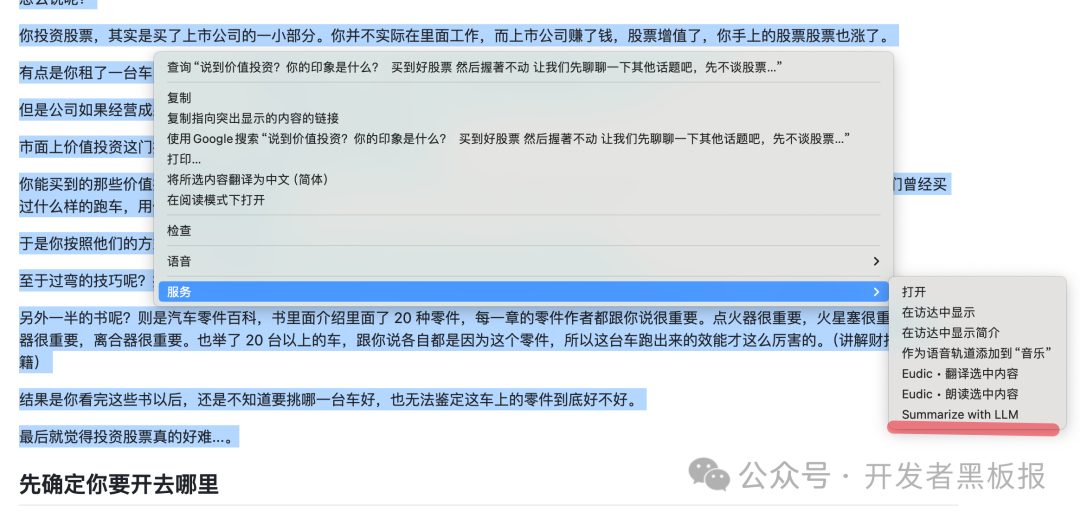

macOS 右键菜单自带服务菜单,我们可以通过服务选择一段文本发送给本地 llm 来达到目的。

也是跨应用发送文本,为了达到这个目的,我们还需要借助 Automator。

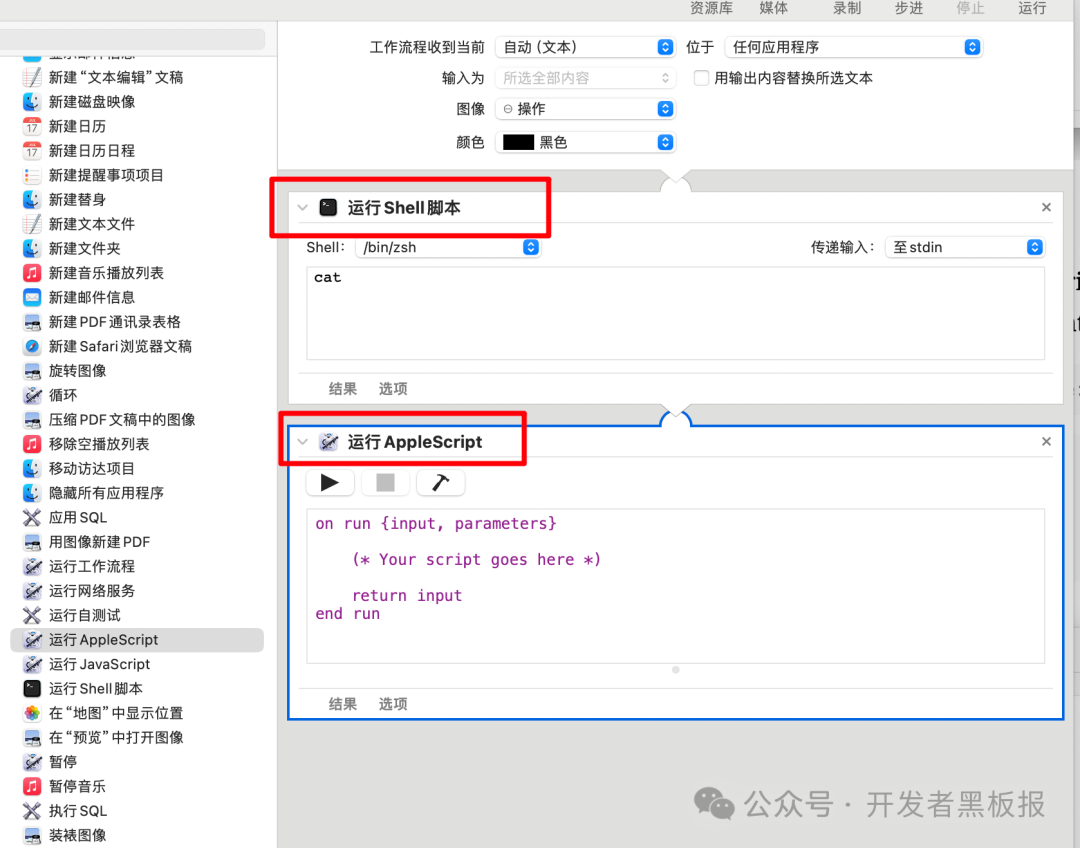

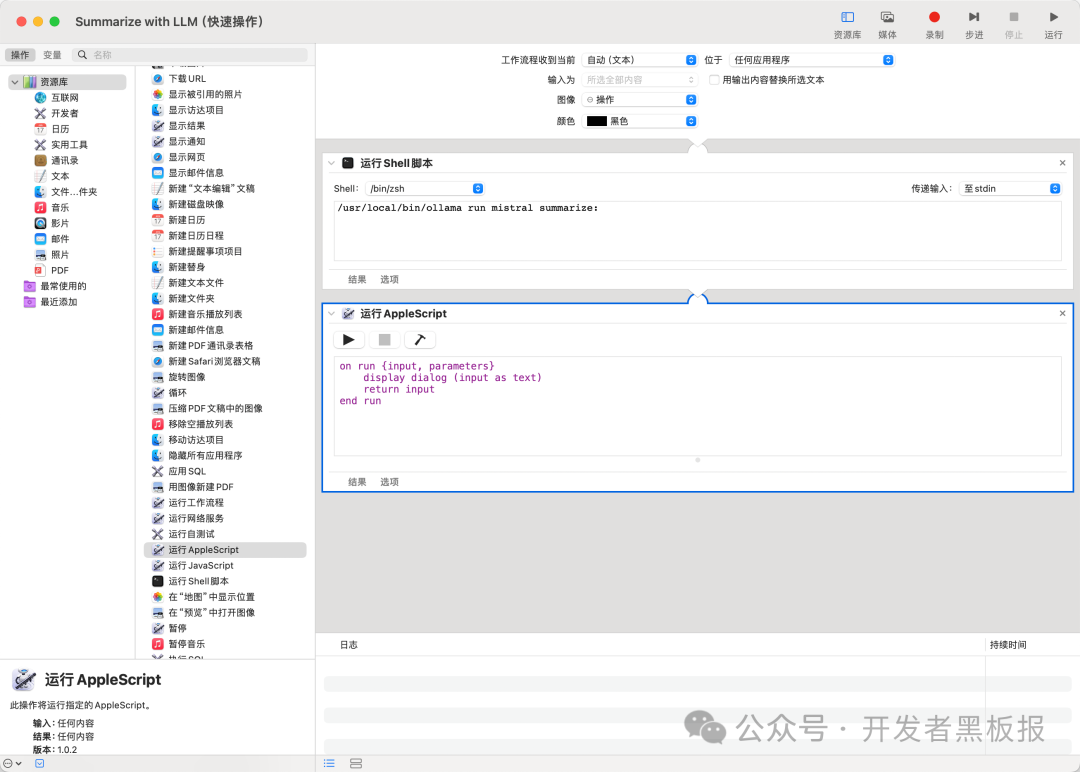

创建一个快捷操作:

选取两个动作:

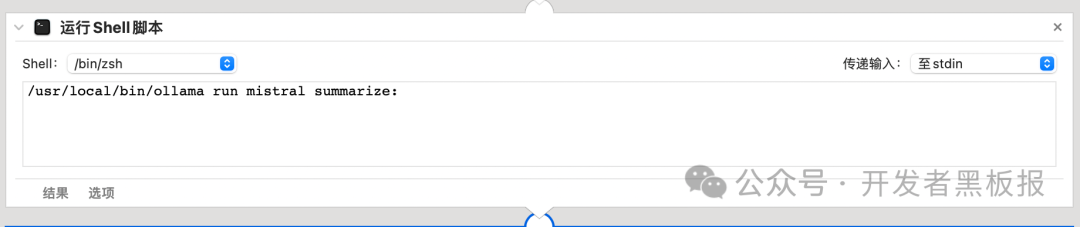

分别输入以下内容:

/usr/local/bin/ollama run mistral summarize:

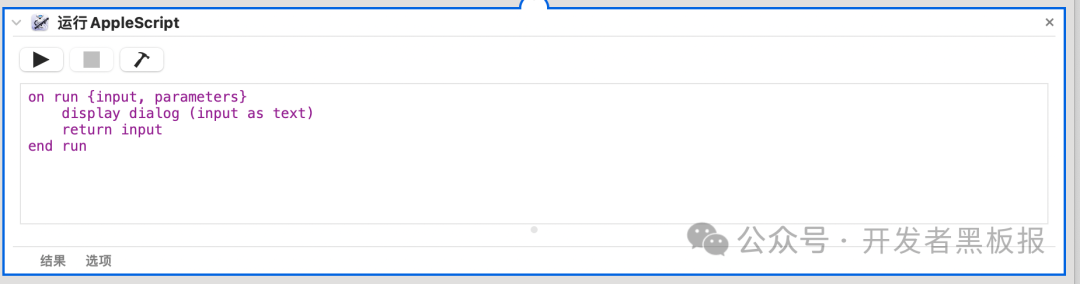

on run {input, parameters}

display dialog (input as text)

return input

end run

之后保存。

然后就可以使用了:

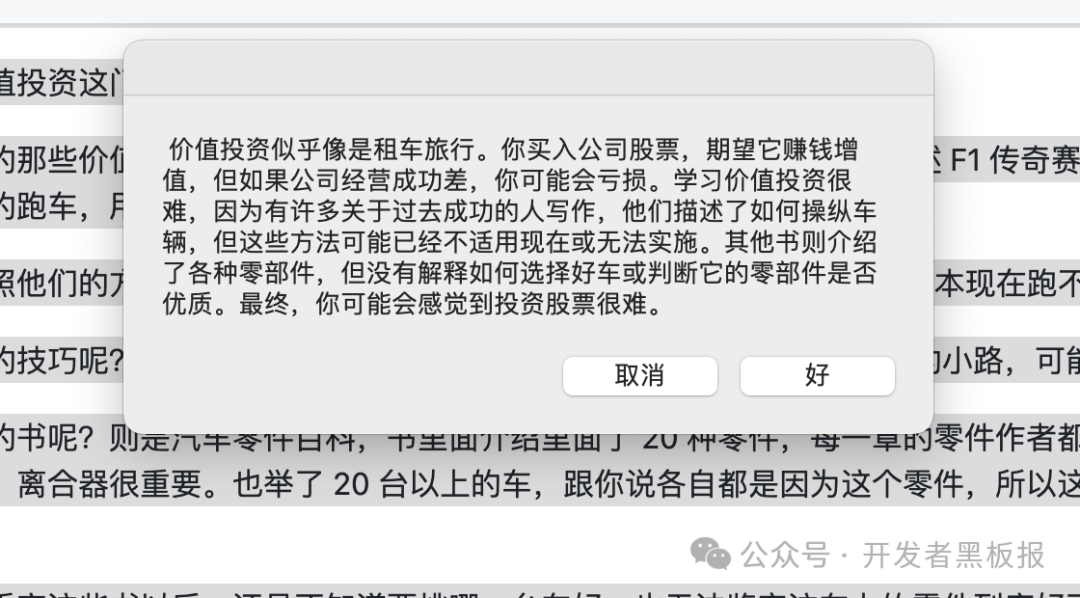

这是结果。

我的使用感受,有点慢。后续慢慢优化吧。

我们可以提前运行一下这个

ollama run mistral

命令,把相应的模型提前下载好。这样使用起来就反应就比较快了。

不然4个G的模型还是要花费一些时间的。

ollma

完!

![[数据库原理]关系范式总结(自用)](https://img-blog.csdnimg.cn/direct/ef1db0fe89f34de7959e76445a551884.jpeg)

![this.$refs[tab.$attrs.id].scrollIntoView is not a function](https://img-blog.csdnimg.cn/direct/9e23c60d80104bc89df5a32d498cdc98.png)