目录

-

- 1.深度卷积神经网络ALexNet 2012

-

- AlexNet

- AlexNet架构

- AlexNet与LeNet复杂度对比

- 总结

- 代码实现

- 2.使用块的网络VGG 2014 image竞猜第二

-

- VGG架构

- 进度

- 总结

- 代码实现

- 3.网络中的网络NiN

-

- 全连接层的问题

- NiN块

- NiN架构

- 总结

- 代码实现

- 4.含并行连结的网络(GoogLeNet)2014 image竞猜第一

-

- 最好的卷积层超参数?

- Inception块:小学生才做选择题,我全要

- GoogLeNet网络结构

-

- Stage1 & Stage2

- Stage3

- Stage4 & 5

- Inception有各种后续变种

- 总结

- 代码实现

- 5.批量归一化(Batch Normalization) 为了更快的拟合

-

- 训练神经网络时出现的挑战

- 核心思想

- 批量归一化在做什么?

- 总结

- 批量归一化从零实现

- 简明实现

- 6.残差网络 ResNet

-

- 问题:随着神经网络的不断加深,一定会带来好处吗?

- 核心思想

- 残差块

- ResNet块细节

- ResNet架构

- 总结

- 代码实现

- 7.ResNet为什么能训练出1000层的模型

-

- 如何避免梯度消失?

- Residual如何处理梯度消失?

1.深度卷积神经网络ALexNet 2012

- 在深度学习之前的网络

- 机器学习(SVM) 2010年之前

- 提取特征

- 选择核函数来计算相关性

- 凸优化问题

- 漂亮的定理(优点:有一套完整的数学定理支持)

- 几何学 2000年

- 抽取特征

- 描述几何(例如多相机)

- (非)凸优化

- 漂亮定理

- 如果假设满足了,效果非常好

- 特征工程

- 特征工程是关键

- 特征描述子:SIFT SURF(特征提取算法)

- 最后使用SVM

- 机器学习(SVM) 2010年之前

-

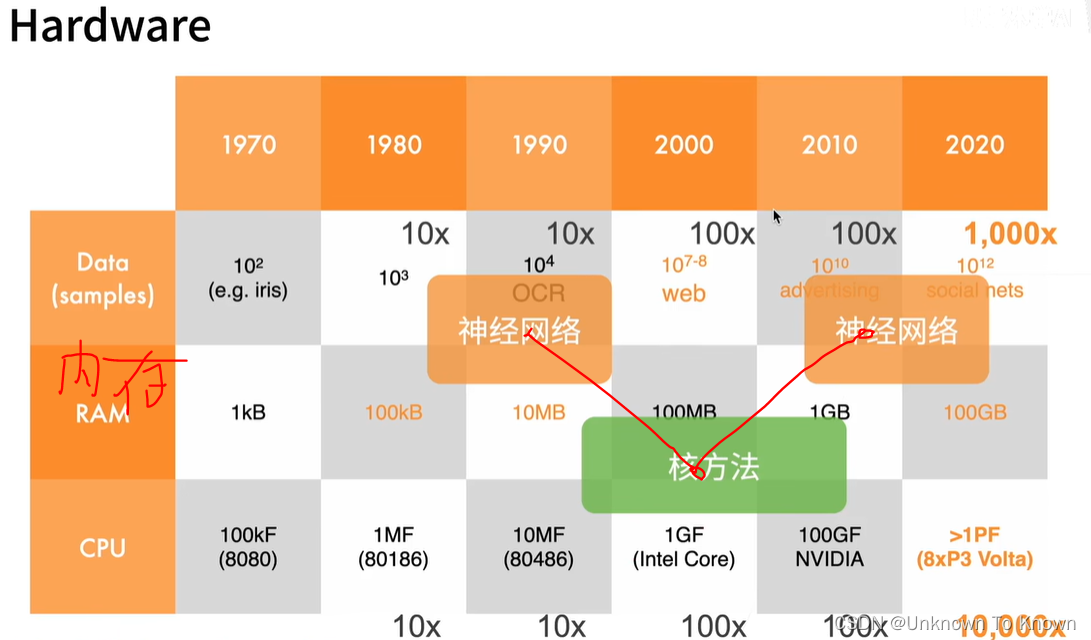

深度神经网络能再起,数据和运算起到关键作用

- ImageNet(2010)

- 图片:自然物体的彩色图片

- 大小:469 * 387

- 样本数 1200000

- 类数:1000

- ImageNet(2010)

AlexNet

- AlexNet 赢了2012年Image竞赛

- 更深更大的LeNet

- 主要改进:

- 丢弃法ÿ