又是一个加班的周末,上周把台式机代码和数据库环境弄好了,这周进行大数据测试,直接把标本、标本医嘱、报告、报告结果、药敏结果等数据插入到1亿的规模,跑了一天一夜插入了5000多万个标本,后面接着补剩下的到一亿。

演示视频

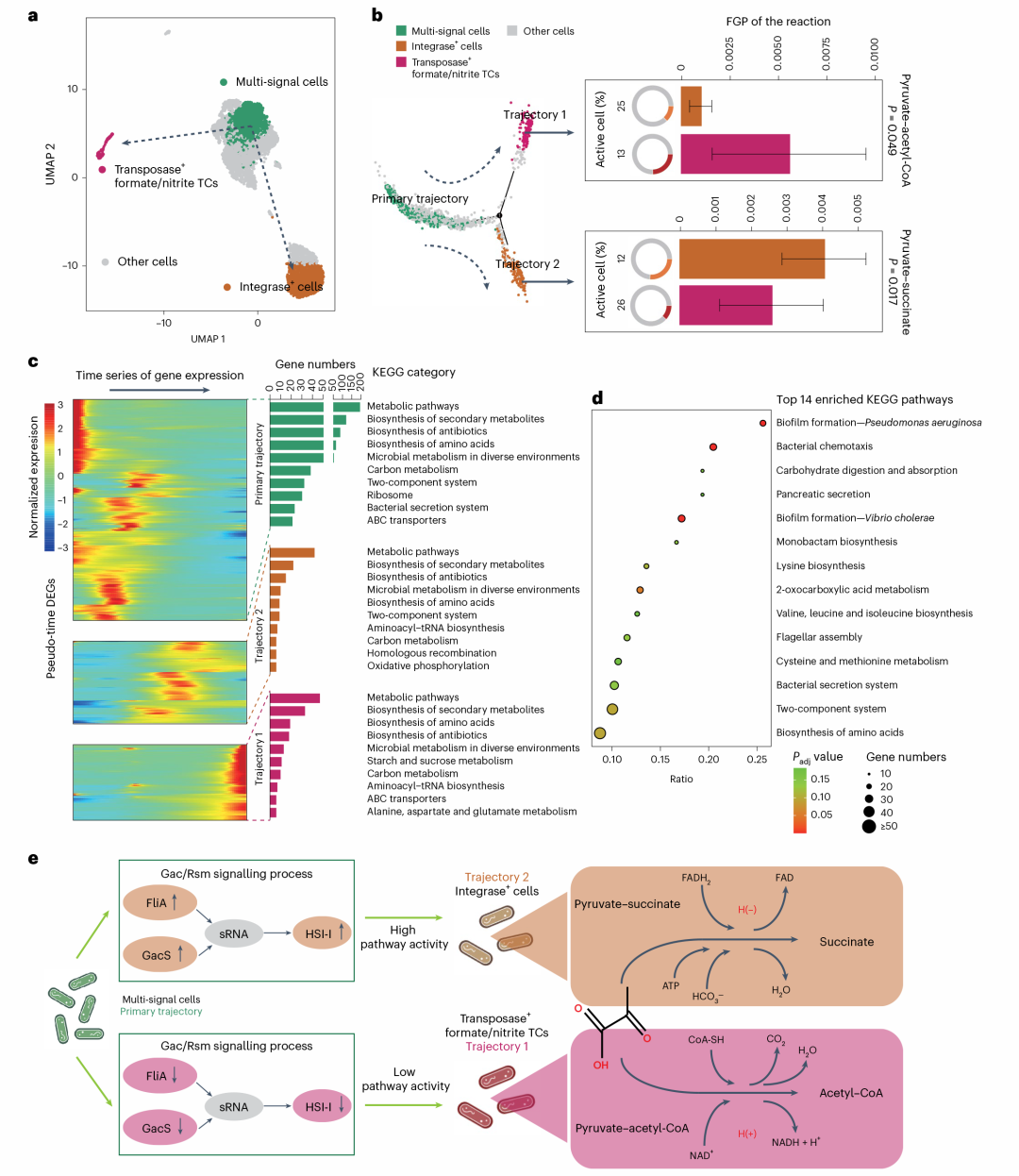

为什么测试1亿数据?

1.按标本两万的医院算,平均每天40万结果,一年数据大概就是1亿出头,一亿没性能问题那么可以保证业务库停留一年数据

2.我的磁盘只有350G,只能存大概1亿

3.网上说关系库在2000w后会性能下降明显,我不级联看1一亿有没有影响

4.设计时候不规划和验证,说后期重构都是扯淡

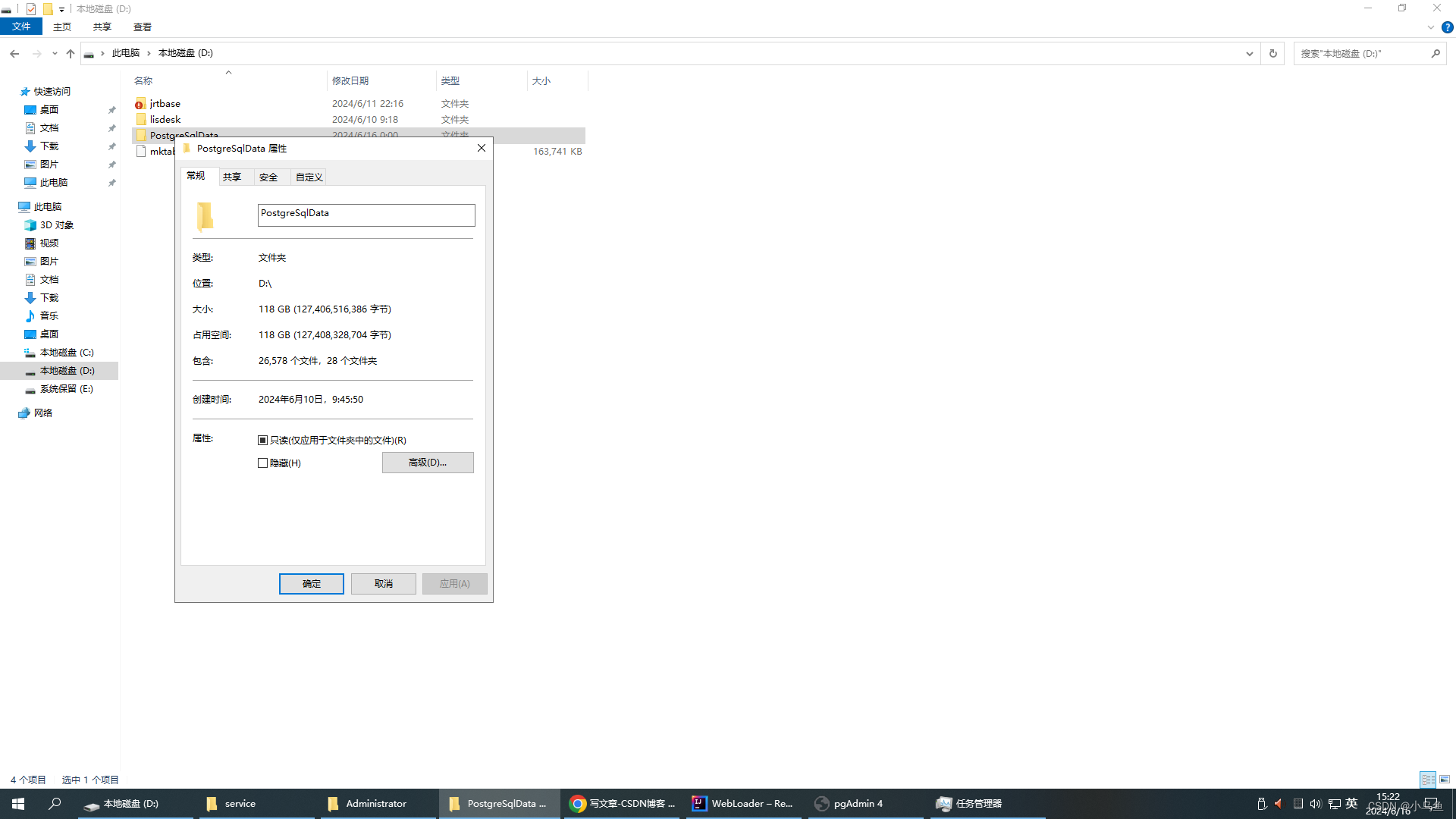

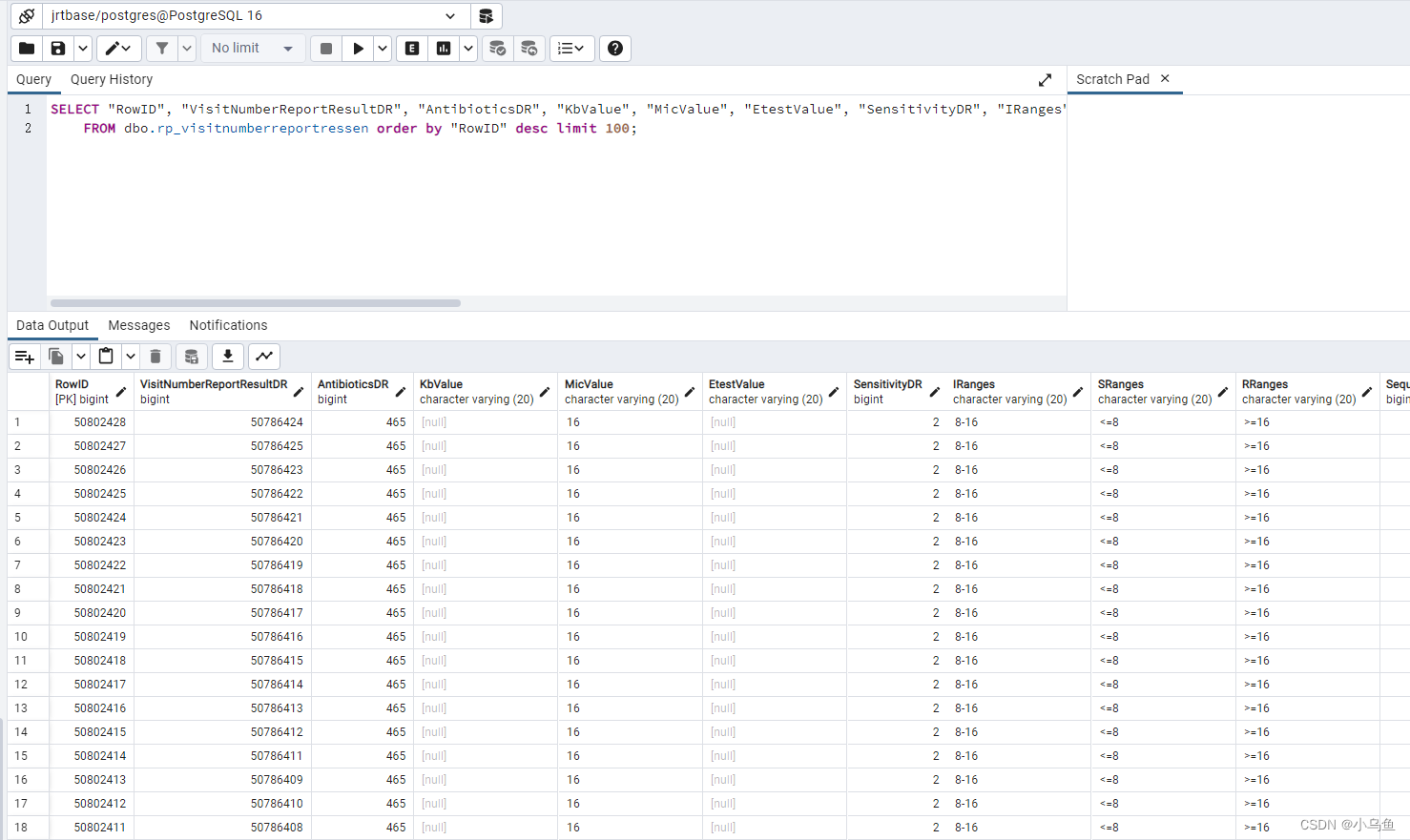

5000万报告时候Postgresql空间占用情况

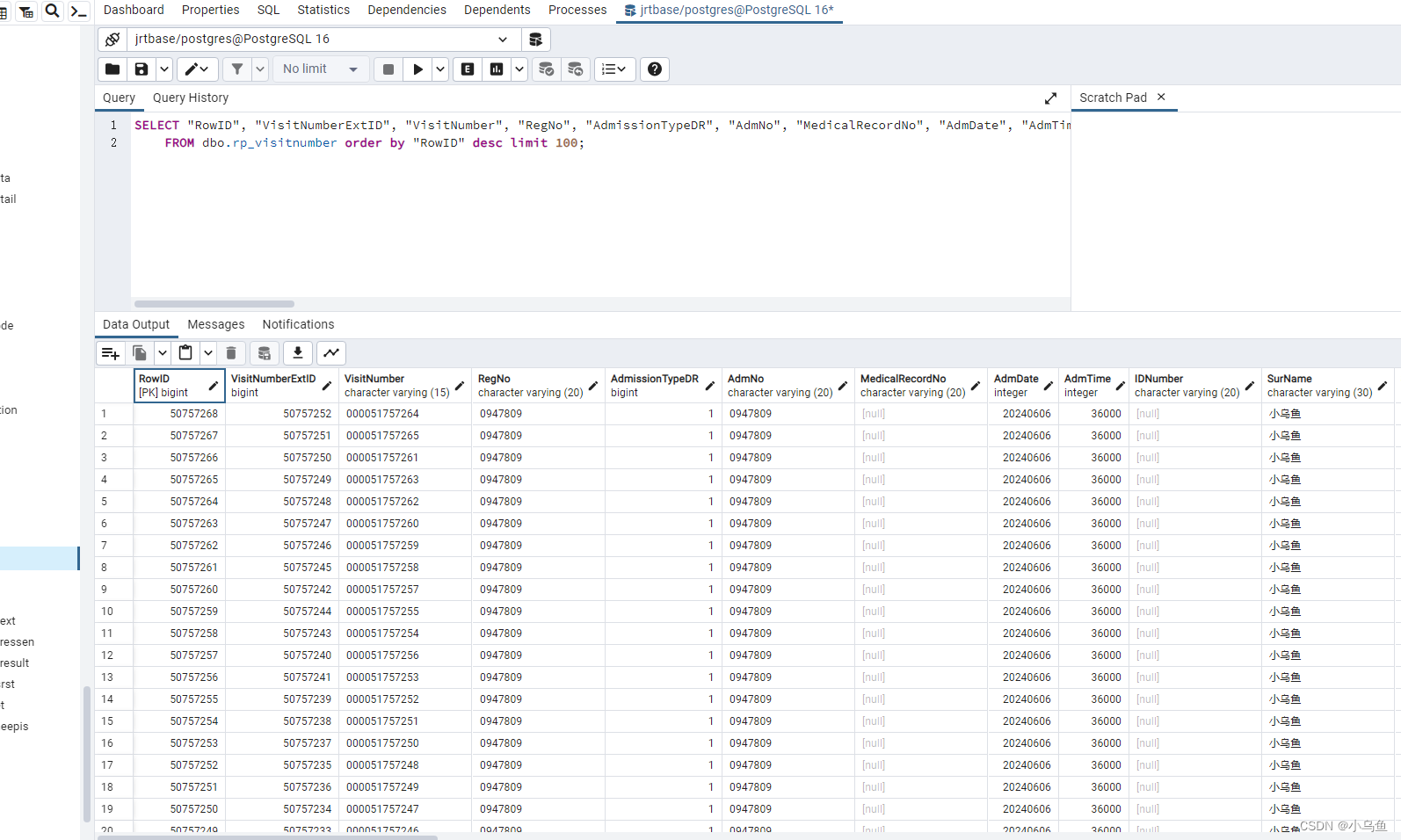

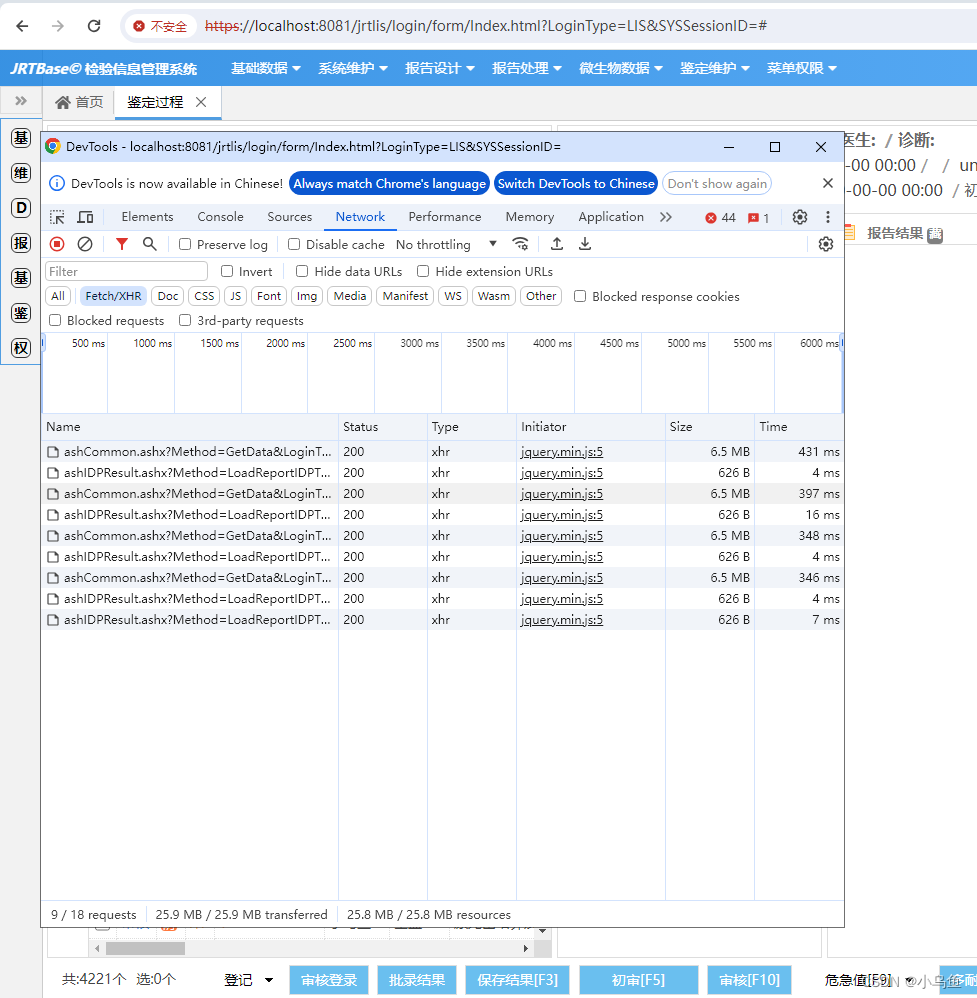

在工作列表返回4200标本下还能以300毫秒返回

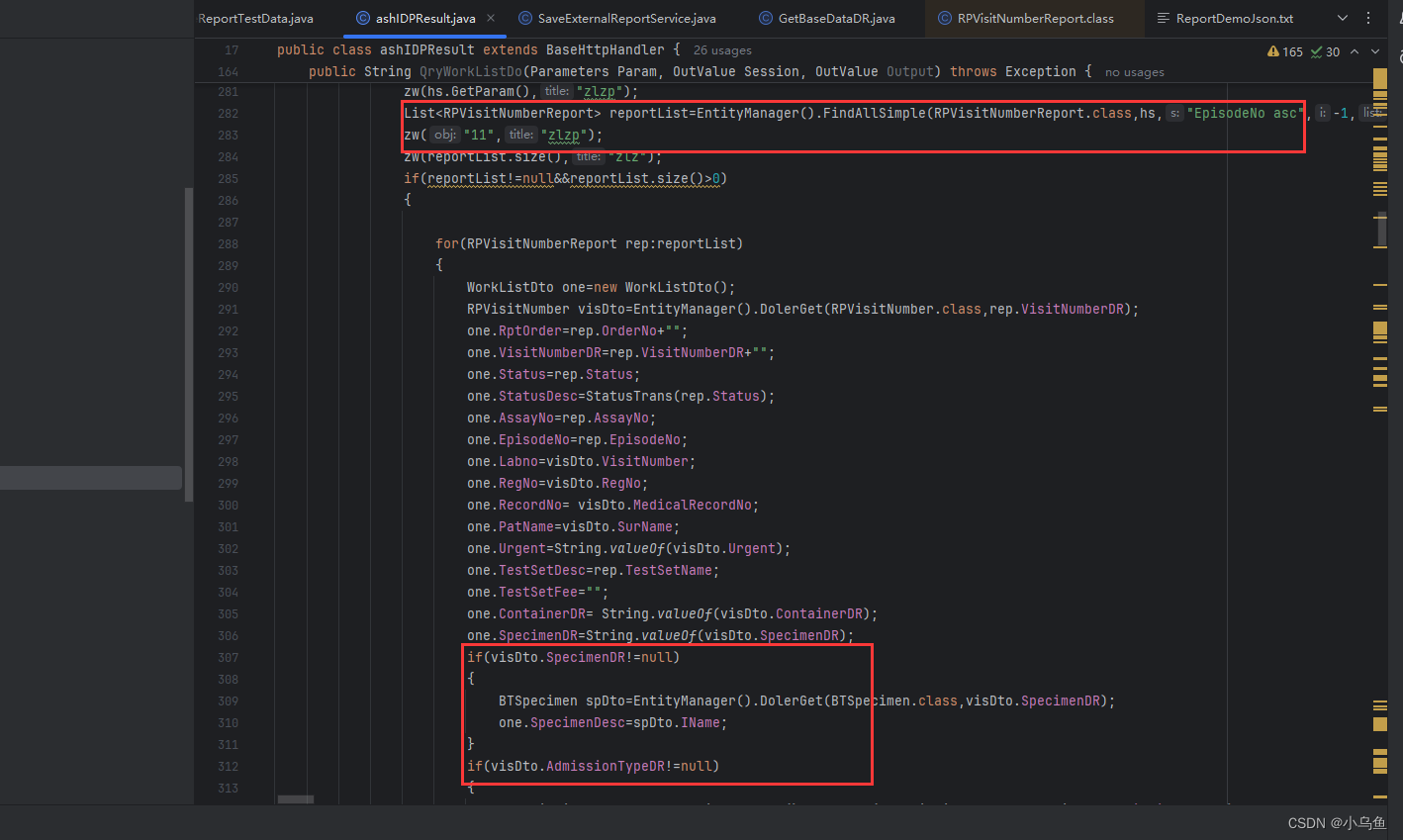

查询代码

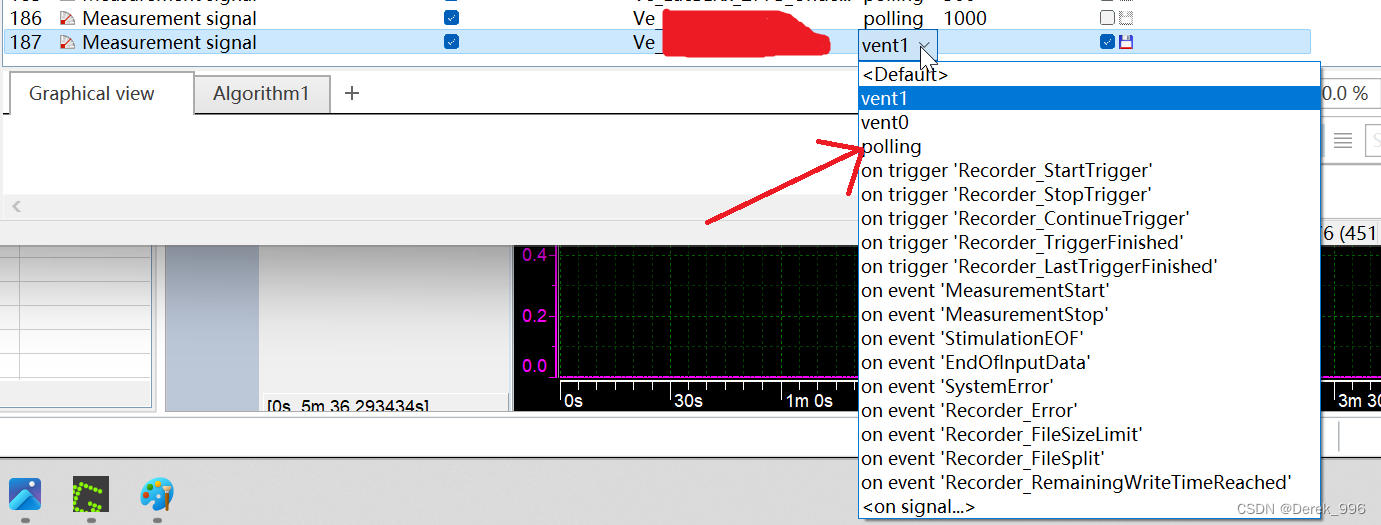

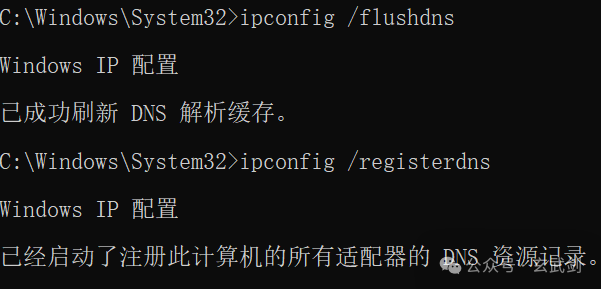

碰到的问题有postgresql索引没生效,通过执行计划排查

EXPLAIN ANALYZE select * from dbo.rp_visitnumberreport where “WorkGroupMachineDR”=7 and “AuthDate”=20240616;

ANALYZE VERBOSE dbo.rp_visitnumberreport

重建索引

REINDEX INDEX rp_visitnumberreport_index_authdate;

本次完成目标:

1.验证jrt大批量长时间ORM操作可靠性

2.验证jrt方案在大数据情况下的性能表现

3.验证关系库在数据超过2000w的性能表现

4.外送回传报告雏形

5.鉴定过程雏形

6.验证和优化jrt缓存的回收可靠性

后续就没什么隐患存在了,关系库一样溜