目录

- 一. Openvino下载

- 二. 准备模型

- 2.1 导出Paddle Inference模型

- 2.2 转换为ONNX模型

- 2.3 转换为ONNX模型

- 2.3.1 获取部署代码

- 2.3.2 环境准备

- 2.3.3 编译

一. Openvino下载

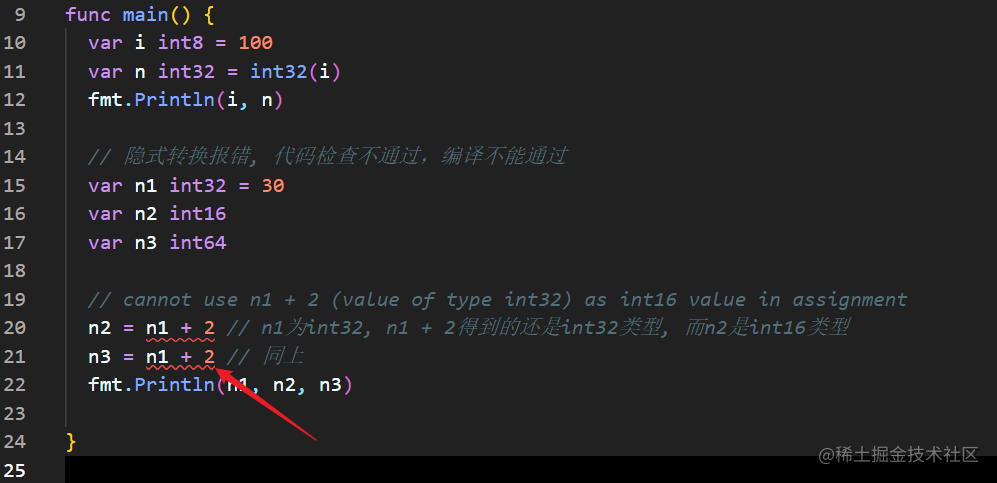

根据Paddle官方的描述,当前检测模型转换为openvino格式是有问题的,暂时只支持分割和分类模型,且openvino版本最好为2021.3(已经过测试,兼容性较好)。

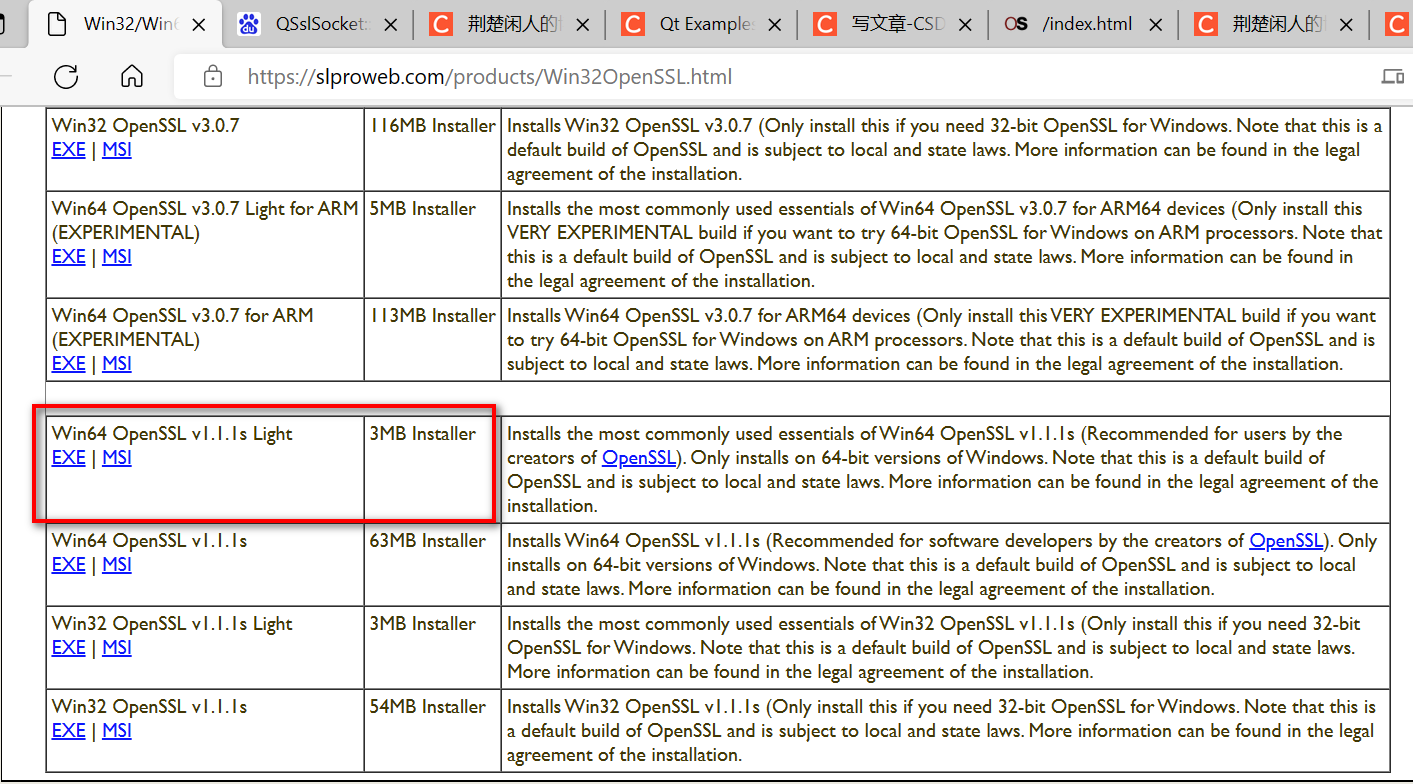

Openvino 2021.3 下载地址

安装过程可以参照OpenVino官方安装步骤来一步步 安装 :

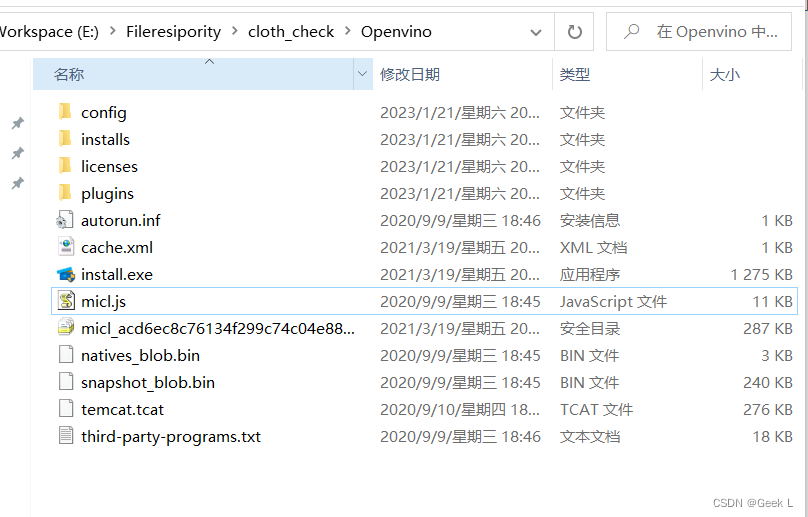

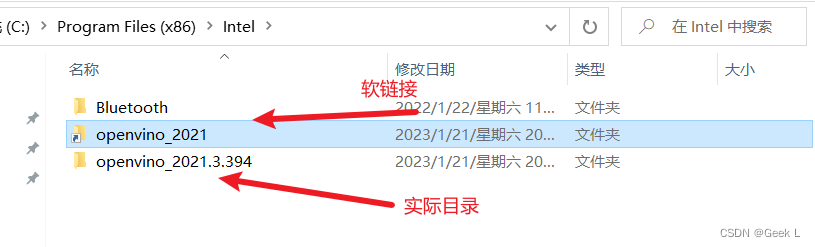

安装完毕后目录如下:

运行install.exe安装推理组件后的目录:

二. 准备模型

2.1 导出Paddle Inference模型

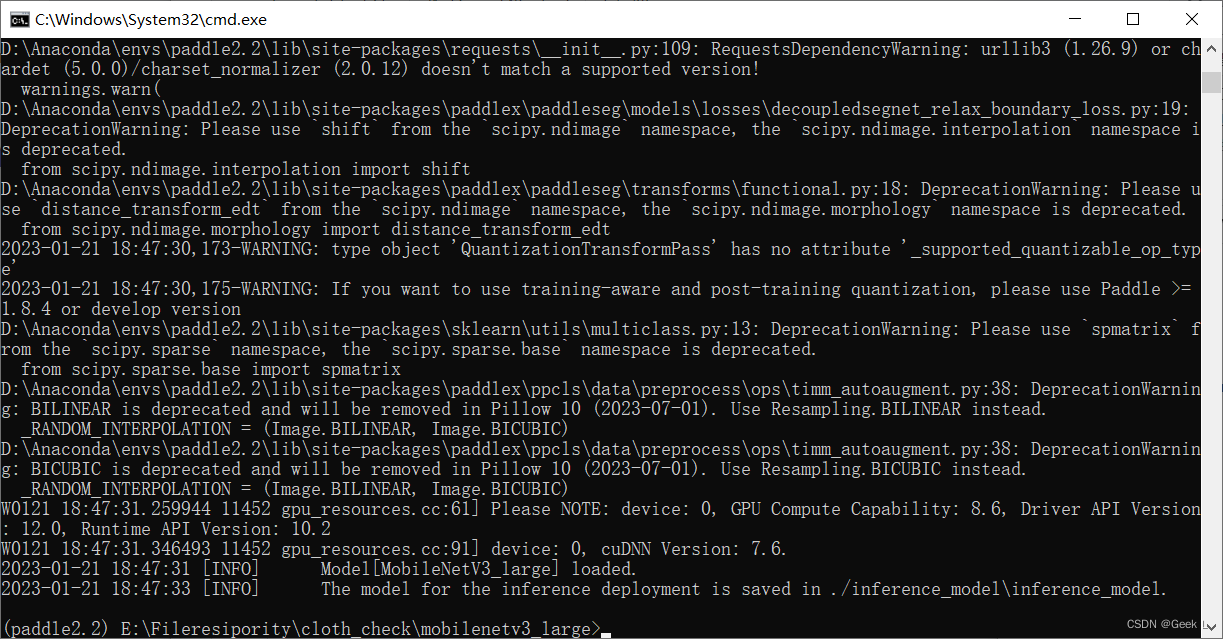

由于目前Openvino只支持比较老的模型,这里以PaddleX训练的mobilenetv3_large模型为例,导出为推理格式模型paddle inference:

安装PaddleX后,执行以下命令进行模型导出:

paddlex --export_inference --model_dir=./output/deeplabv3p_r50vd/best_model/ --save_dir=./inference_model

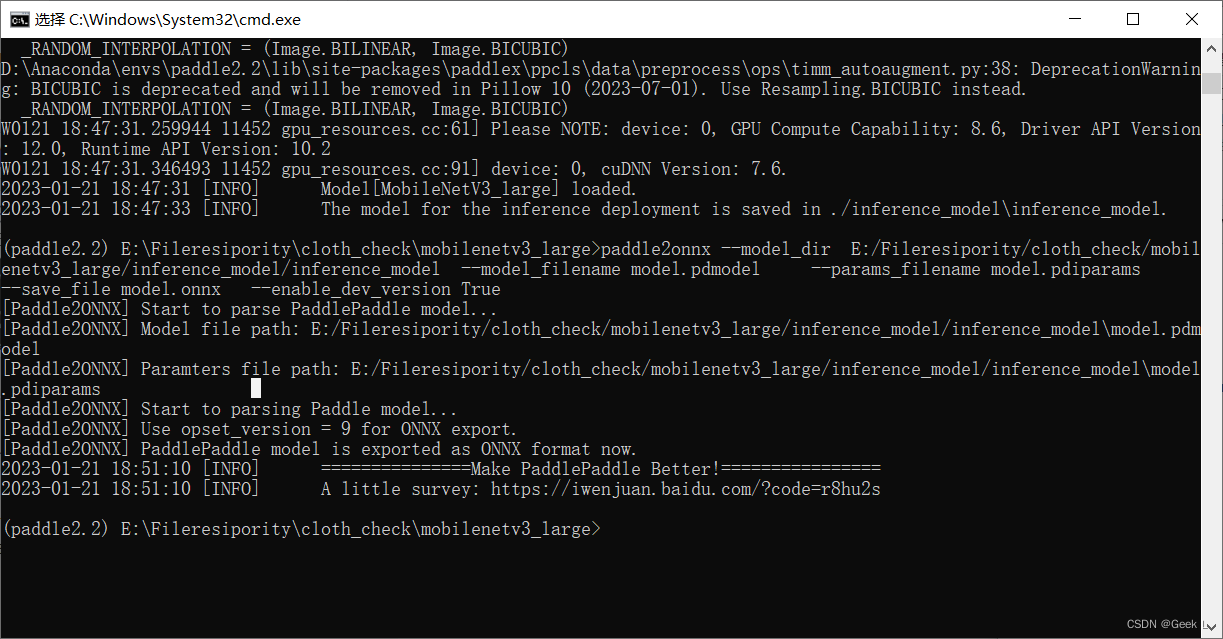

2.2 转换为ONNX模型

将paddle inference模型转为onnx模型:

# model_dir需要ResNet50解压后的路径

paddle2onnx --model_dir E:/Fileresipority/cloth_check/mobilenetv3_large/inference_model/inference_model --model_filename model.pdmodel --params_filename model.pdiparams --save_file model.onnx --enable_dev_version True

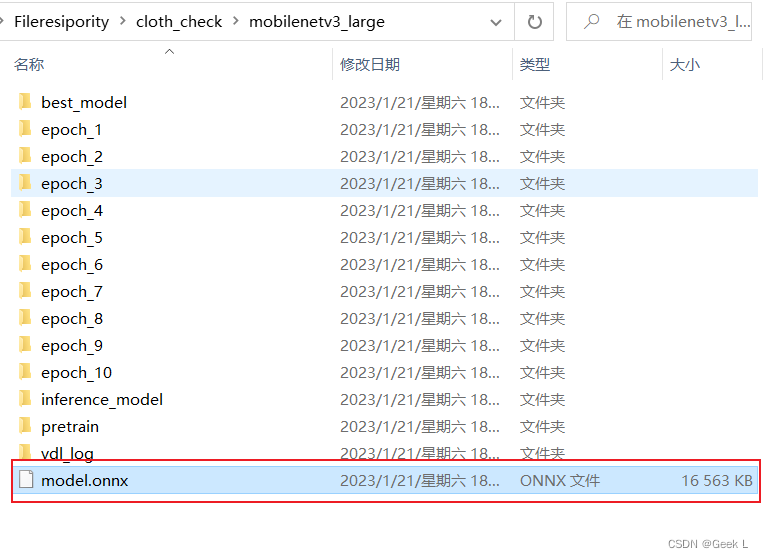

转换后的目录:

2.3 转换为ONNX模型

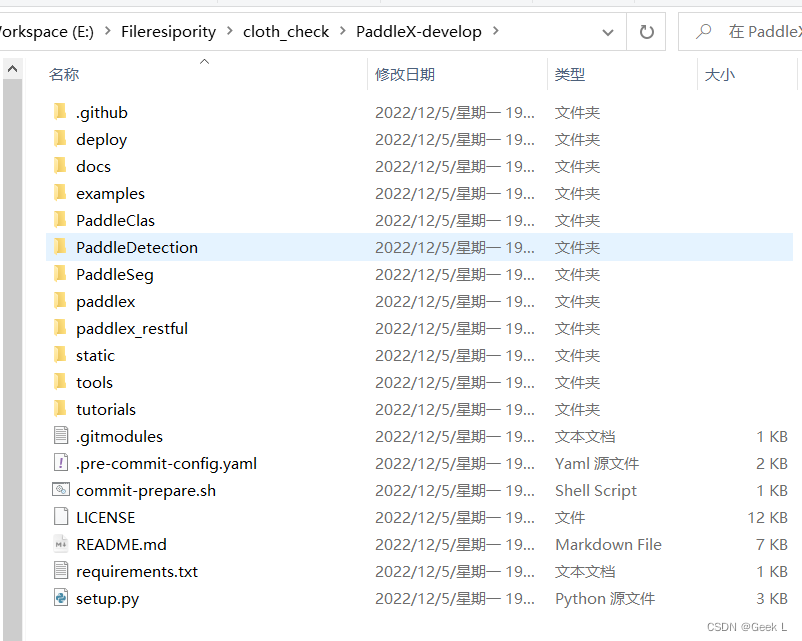

2.3.1 获取部署代码

git clone https://github.com/PaddlePaddle/PaddleX.git

2.3.2 环境准备

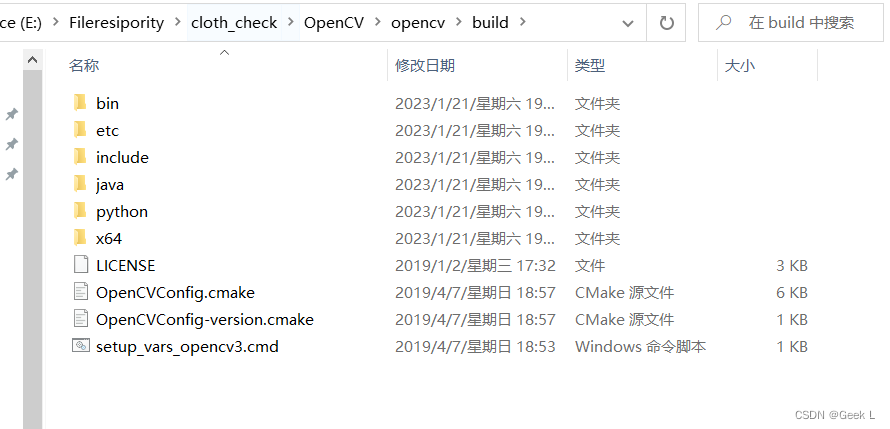

1.在OpenCV官网下载适用于Windows平台的3.4.6版本下载链接

2.运行下载的可执行文件,将OpenCV解压至指定目录,例如D:\projects\opencv。

3.配置环境变量,如下流程所示:

我的电脑->属性->高级系统设置->环境变量

在系统变量中找到Path(如没有,自行创建),并双击编辑

新建,将opencv路径填入并保存,如E:\Fileresipority\cloth_check\OpenCV\opencv\build\x64\vc15\bin

在进行cmake构建时,会有相关提示,请注意vs2019的输出。

4.点击下载gflags依赖包,解压至deps目录

2.3.3 编译

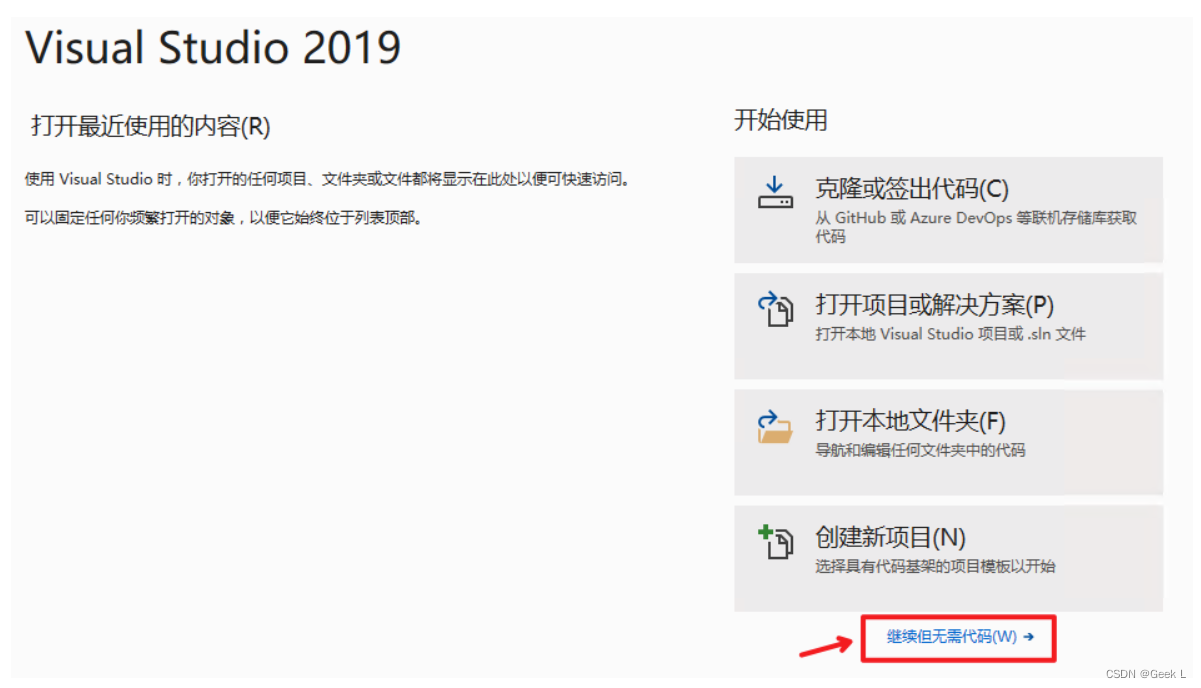

1.打开Visual Studio 2019 Community,点击继续但无需代码

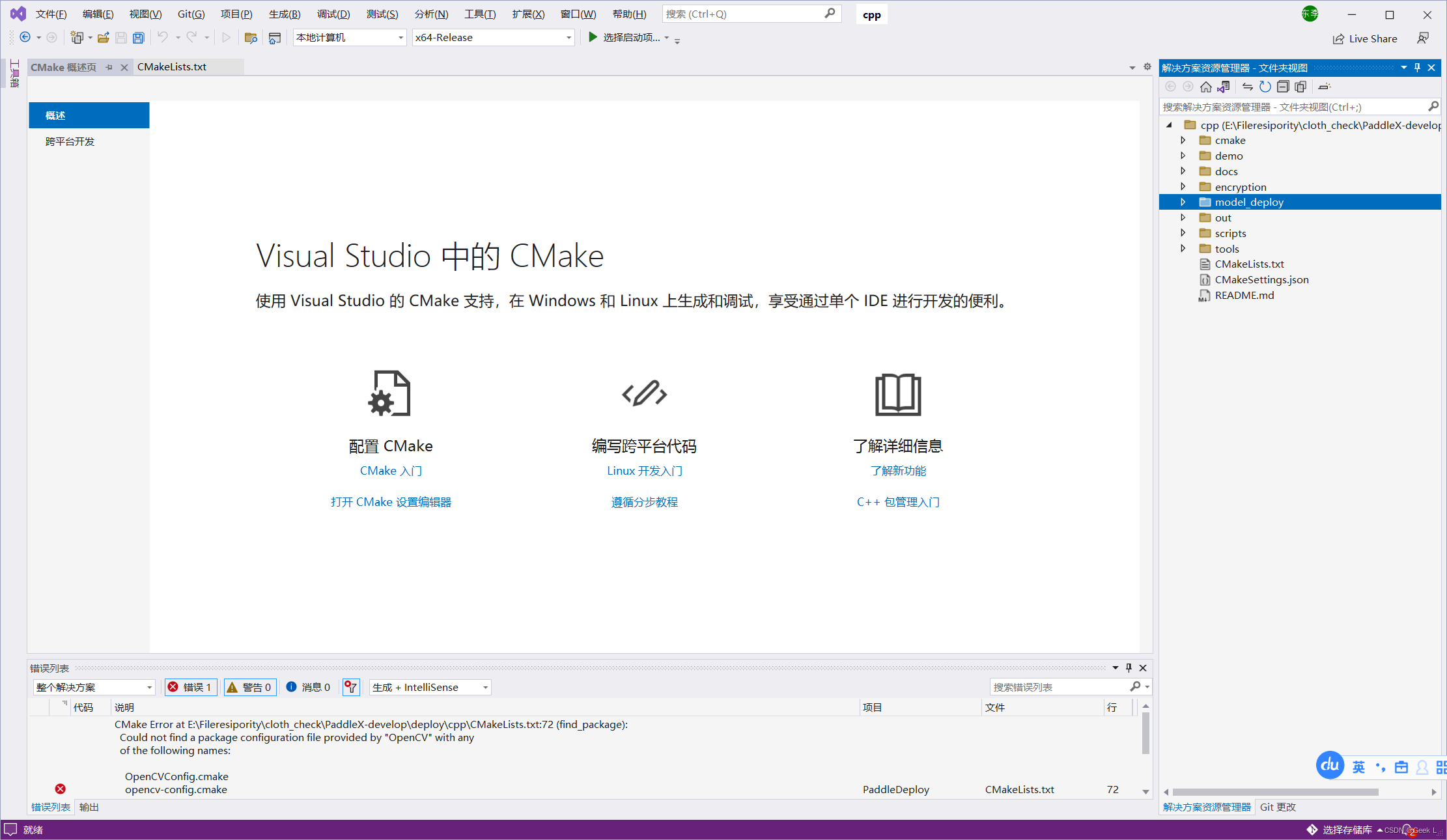

2. 点击: 文件->打开->CMake

选择C++预测代码所在路径(例如E:\Fileresipority\cloth_check\PaddleX-develop\deploy\cpp),并打开CMakeList.txt:

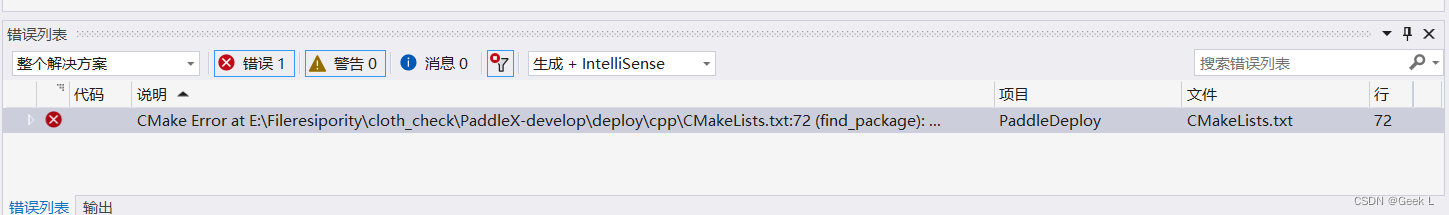

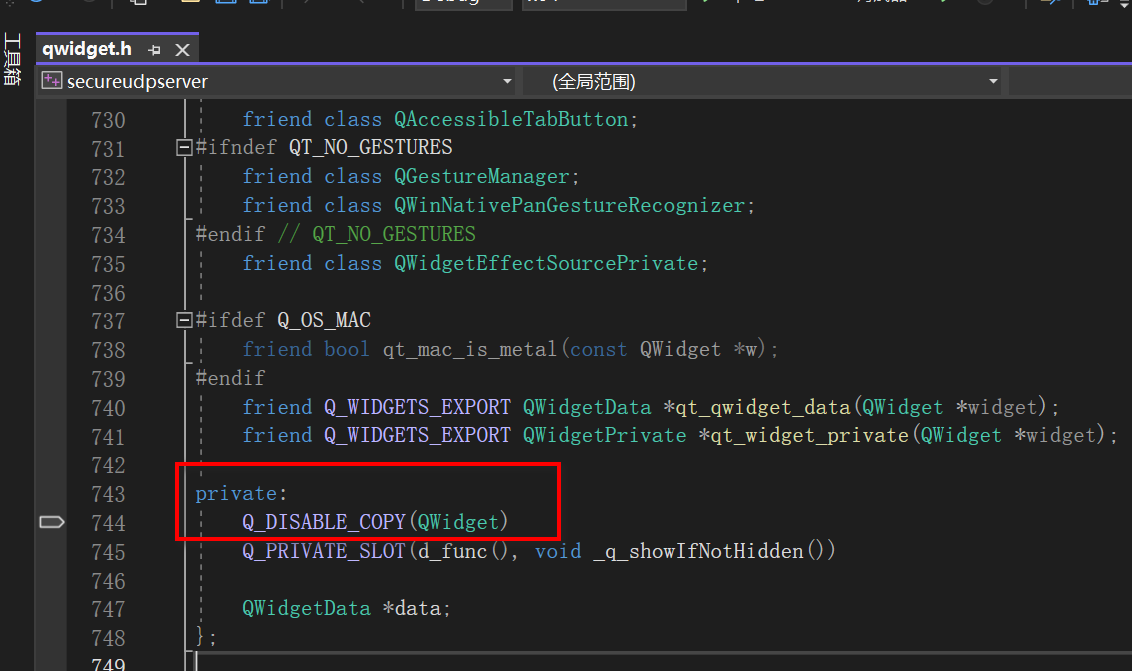

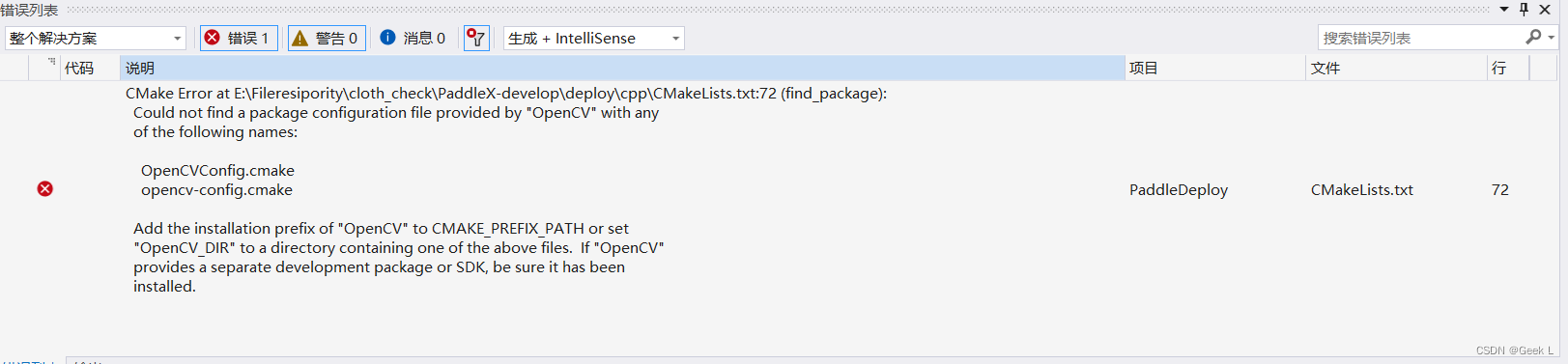

- 打开项目时,可能会自动构建。由于没有进行下面的依赖路径设置会报错,这个报错可以先忽略:

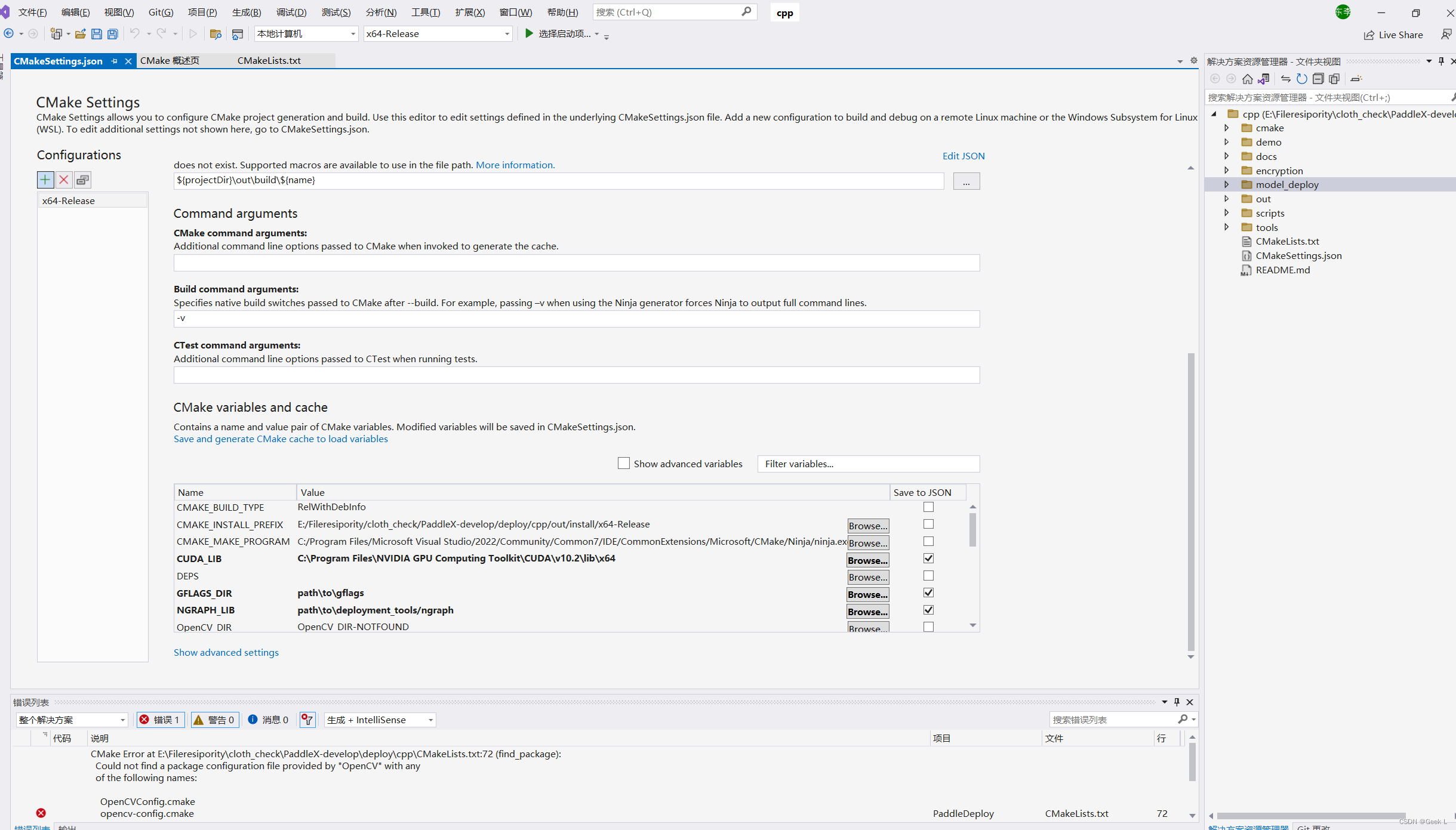

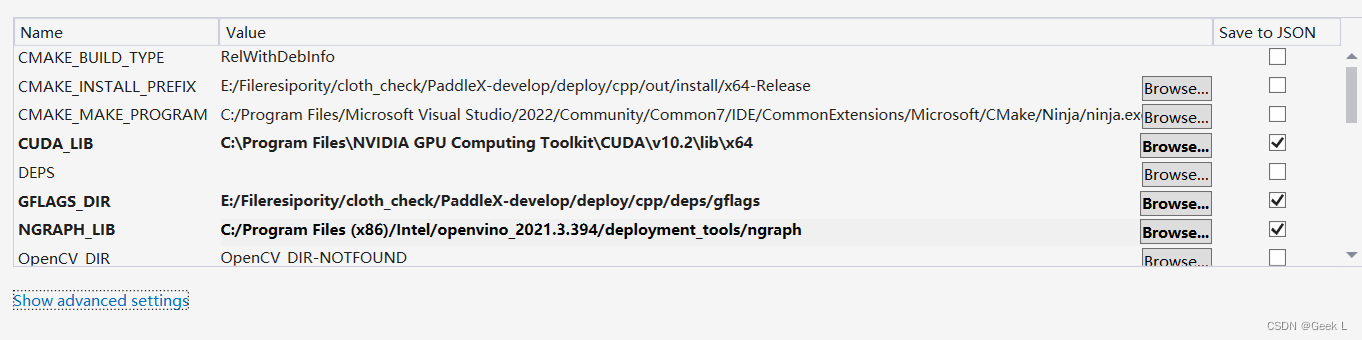

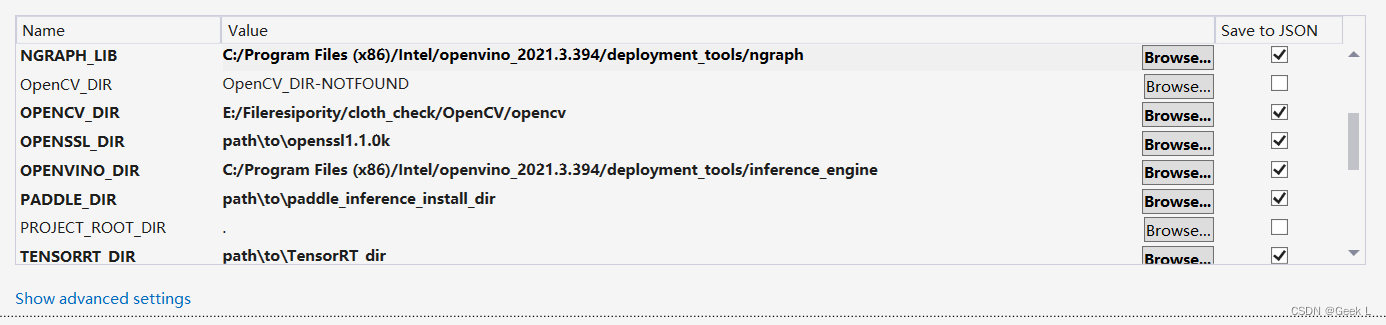

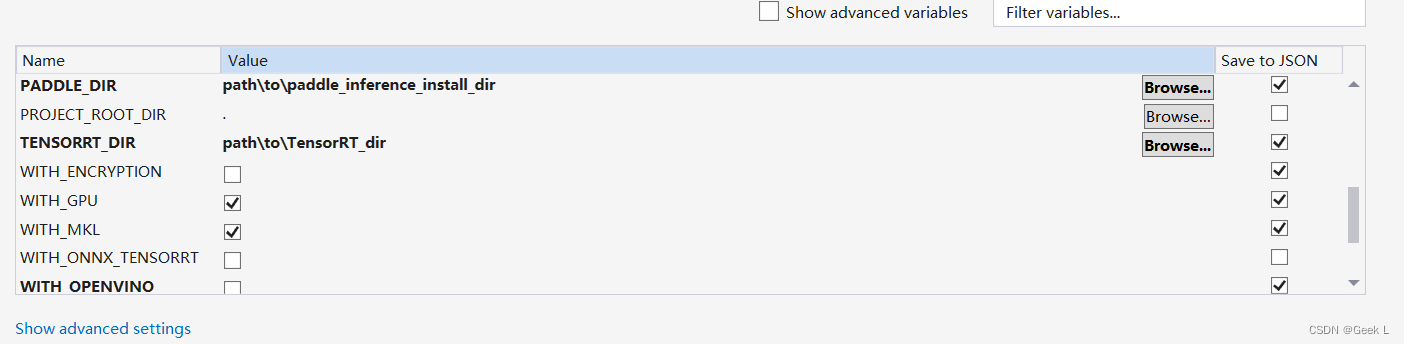

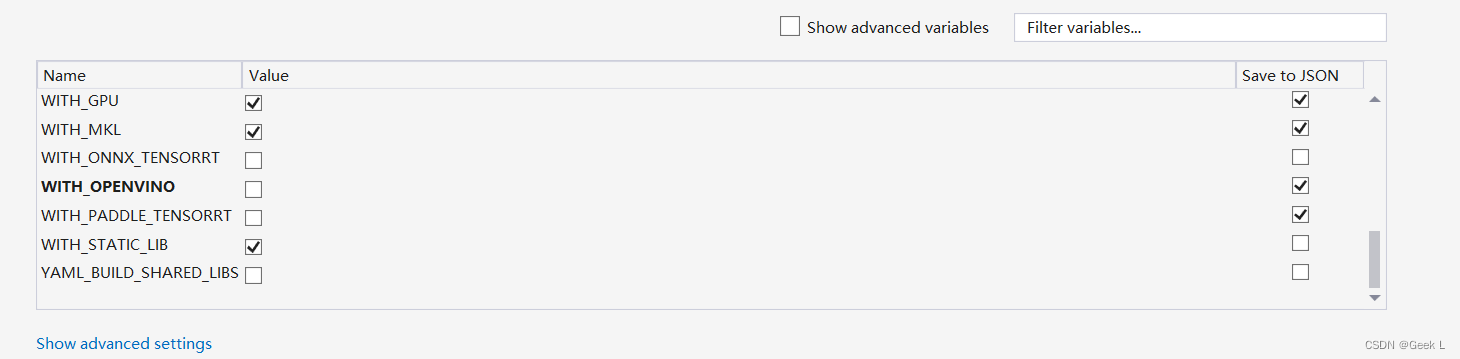

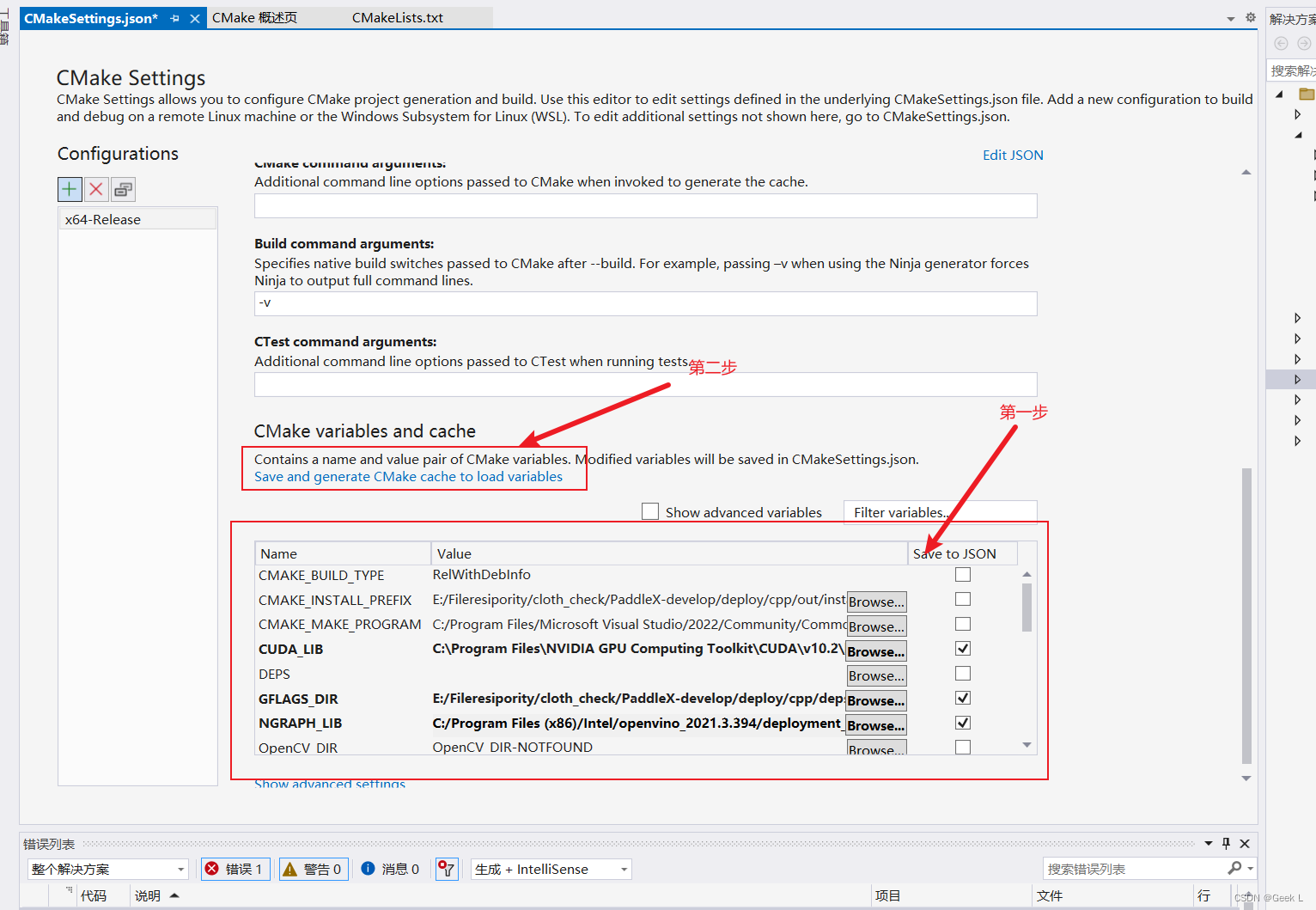

- 点击浏览,分别设置编译选项指定gflag、OpenCV、OpenVINO的路径(也可以点击右上角的“编辑 JSON”,直接修改json文件,然后保存点 项目->生成缓存)。

5. 保存并生成CMake缓存

设置完成后, 点击上图中保存并生成CMake缓存以加载变量。然后我们可以看到vs的输出会打印CMake生成的过程,出现CMake 生成完毕且无报错代表生成完毕。

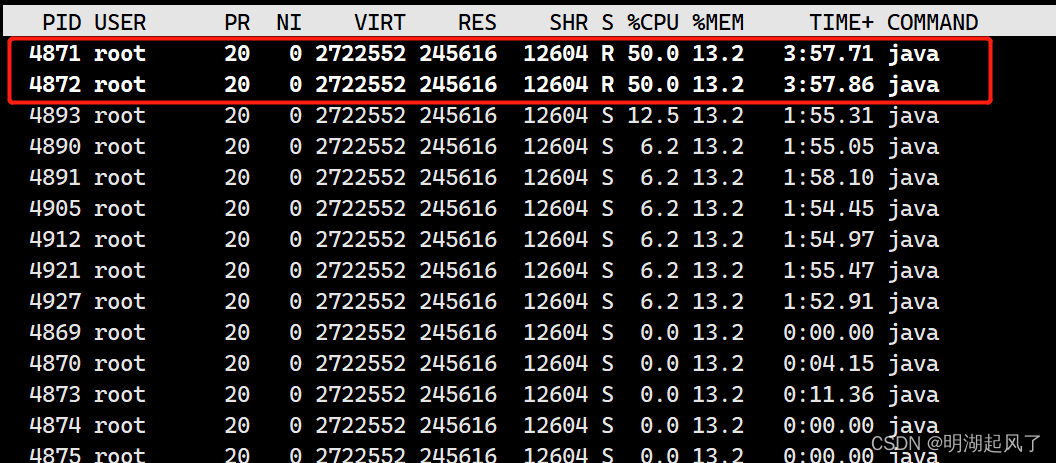

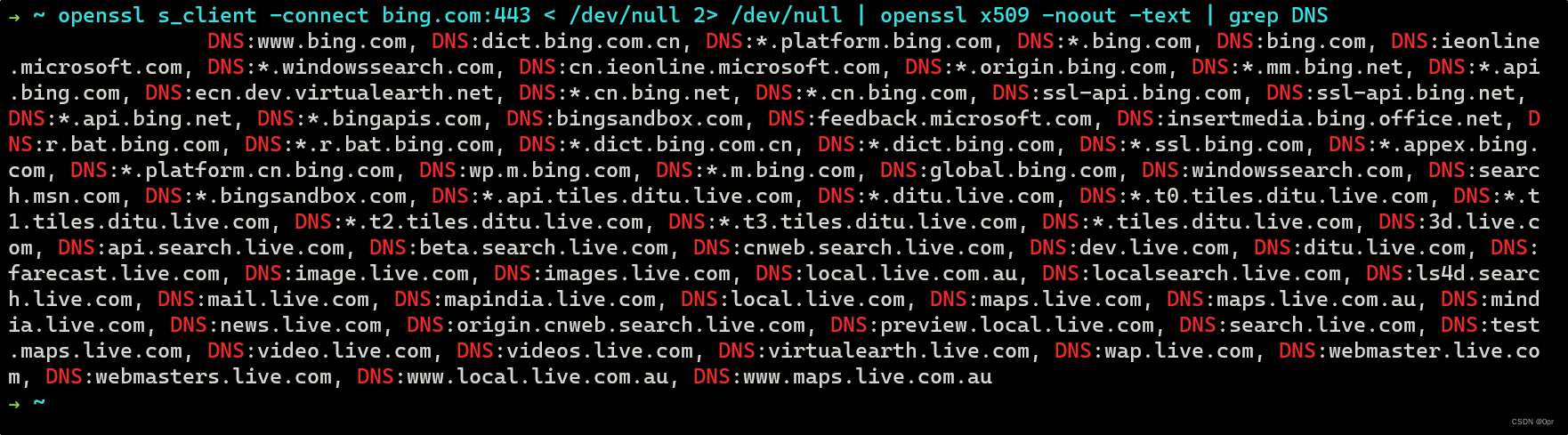

发现报错: