本文主要介绍通过python实现tokens统计,避免重复调用openai等官方api,开源节流。

一、设计思路

- 初始化tokenizer

- 使用tokenizer将文本转换为tokens

- 计算token的数量

二、业务场景

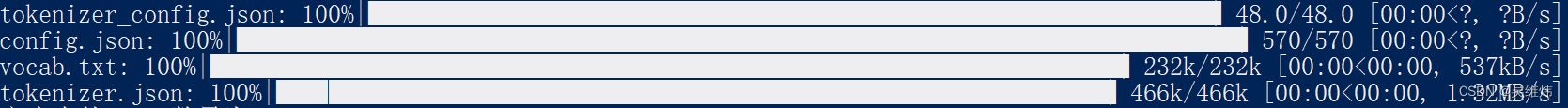

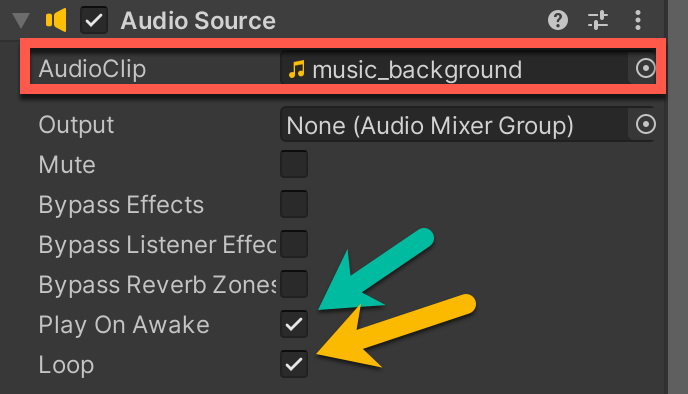

2.1 首次加载依赖

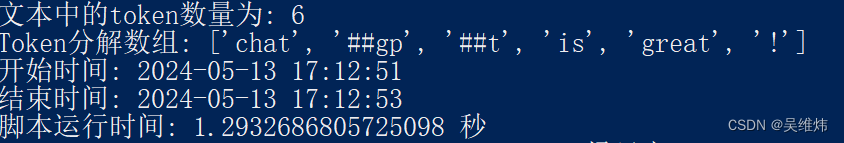

2.2 执行业务逻辑

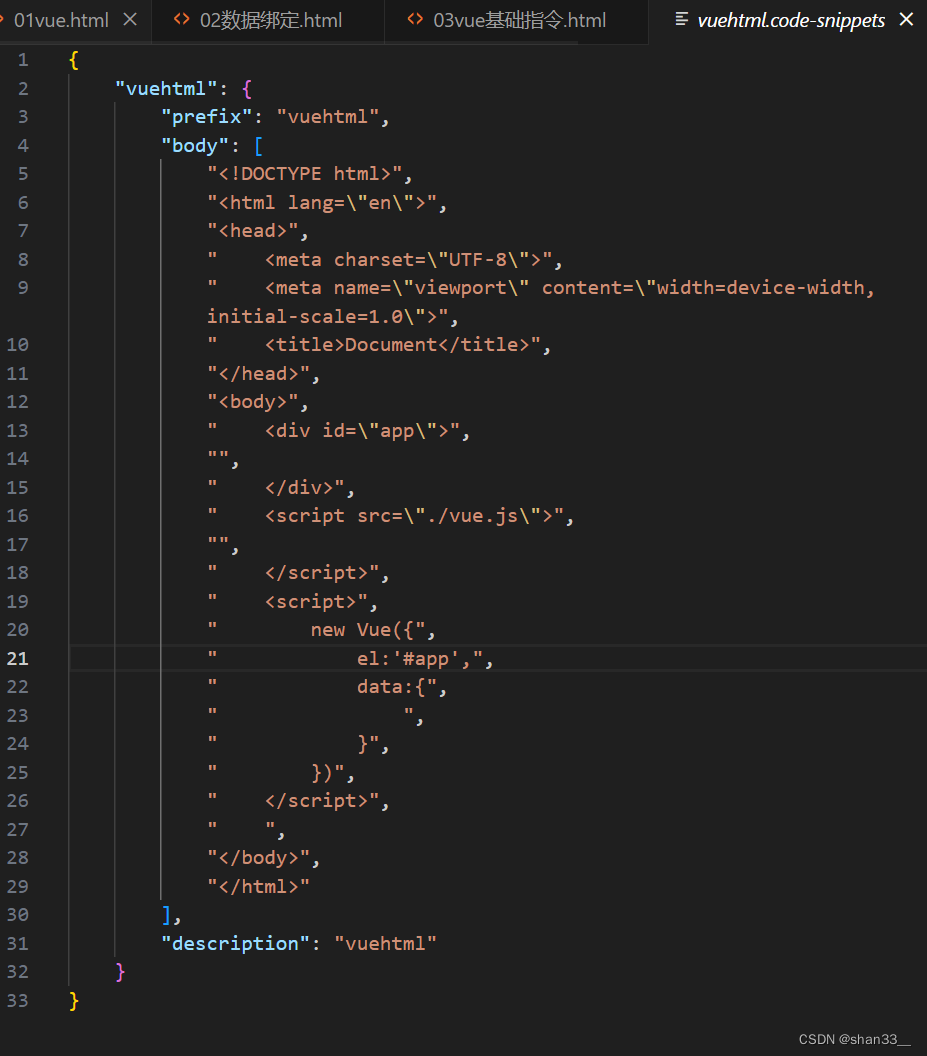

三、核心代码

from transformers import AutoTokenizer

import time

from datetime import datetime

# 获取开始时间,并格式化为"年-月-日 时:分:秒"

start_time = time.time()

start_datetime = datetime.fromtimestamp(start_time).strftime('%Y-%m-%d %H:%M:%S')

# 初始化tokenizer

tokenizer = AutoTokenizer.from_pretrained('bert-base-uncased')

# 示例文本

text = "ChatGPT is great!"

# 使用t

![C++ 日志库 log4cpp 编译、压测及其范例代码 [全流程手工实践]](https://img-blog.csdnimg.cn/direct/1e0f7d5b801d4deea521fe4d14759cc5.png)

![[董晓算法]搜索相关题目及模板](https://img-blog.csdnimg.cn/direct/35f8136c36ef4a54bcbc935b00cfba4b.png)