参考教程

https://github.com/InternLM/Tutorial/blob/camp2/opencompass/readme.md

下载opencompass,配置必要的环境之后,解压下载的数据集

cp /share/temp/datasets/OpenCompassData-core-20231110.zip /root/opencompass/

unzip OpenCompassData-core-20231110.zip

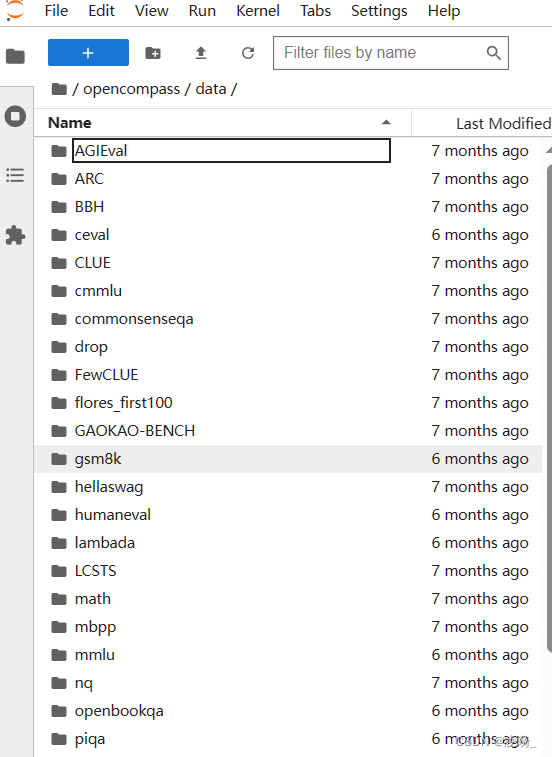

查看下载的数据集

执行运行命令,运行评测

python run.py

--datasets ceval_gen \

--hf-path /share/new_models/Shanghai_AI_Laboratory/internlm2-chat-1_8b \ # HuggingFace 模型路径

--tokenizer-path /share/new_models/Shanghai_AI_Laboratory/internlm2-chat-1_8b \ # HuggingFace tokenizer 路径(如果与模型路径相同,可以省略)

--tokenizer-kwargs padding_side='left' truncation='left' trust_remote_code=True \ # 构建 tokenizer 的参数

--model-kwargs device_map='auto' trust_remote_code=True \ # 构建模型的参数

--max-seq-len 1024 \ # 模型可以接受的最大序列长度

--max-out-len 16 \ # 生成的最大 token 数

--batch-size 2 \ # 批量大小

--num-gpus 1 # 运行模型所需的 GPU 数量

--debug

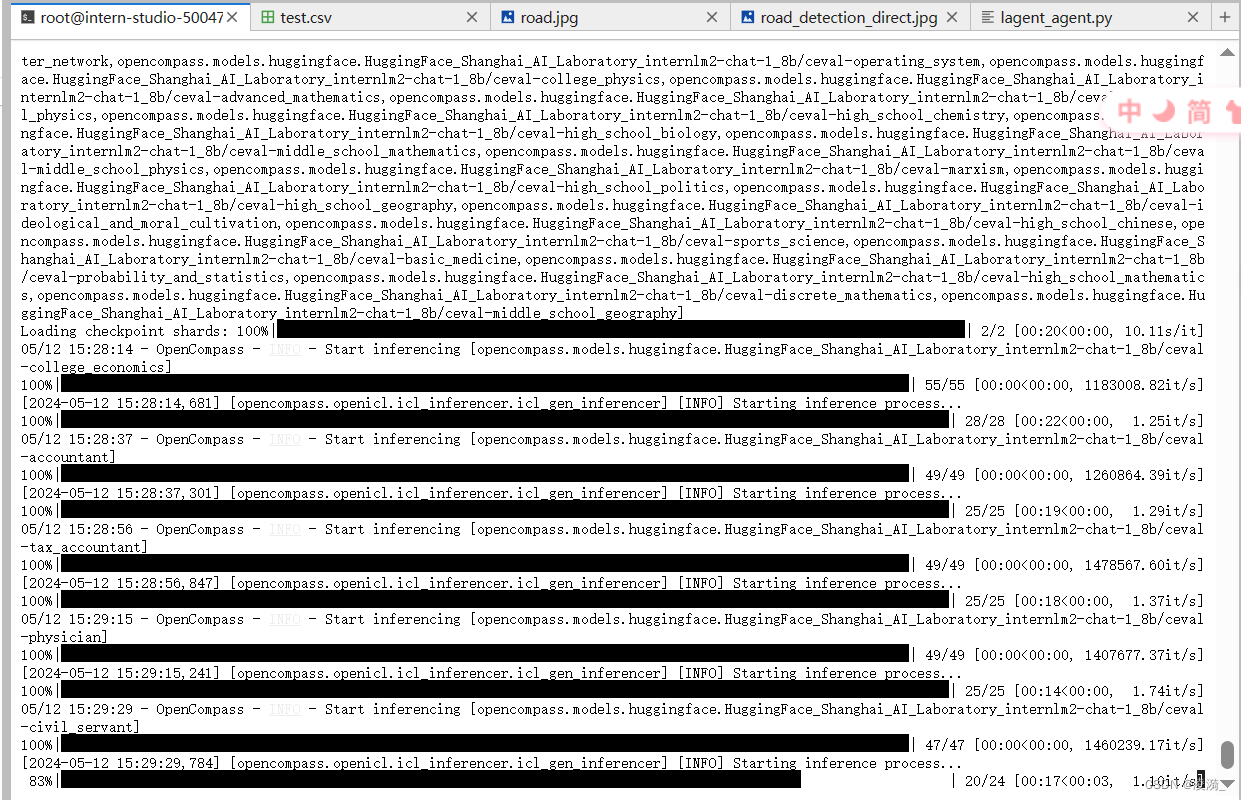

测评运行中

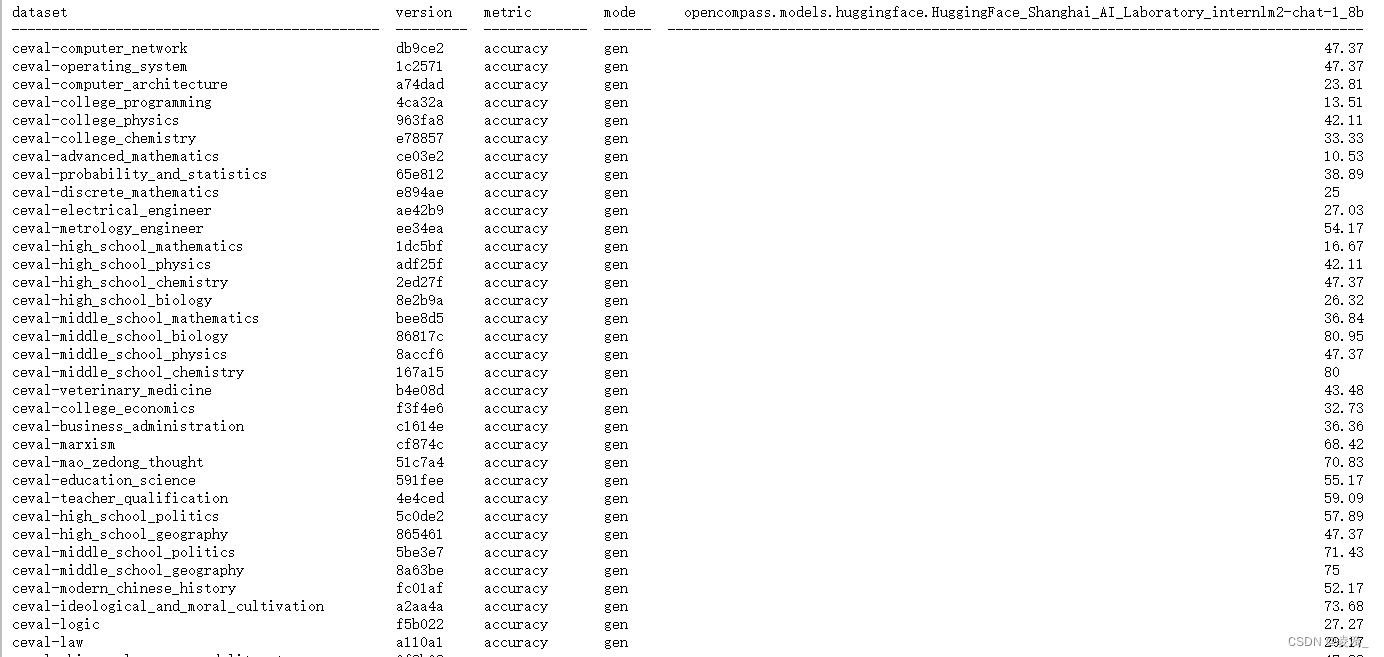

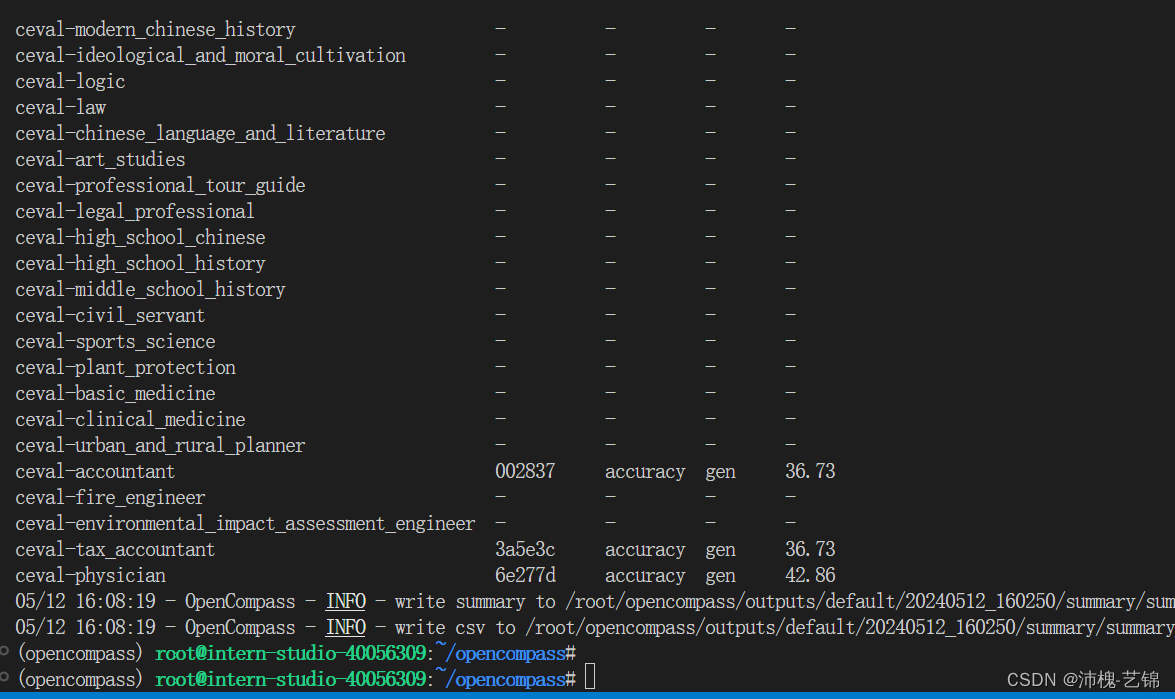

运行结果

![[嵌入式系统-75]:RT-Thread-快速上手:正点原子探索者 STM32F407示例](https://img-blog.csdnimg.cn/img_convert/26603420183b22ef3cc660398726387e.gif)