大模型微调数据构造(补充课程)_哔哩哔哩_bilibili

Tutorial/FineTune at main · Focusshang/Tutorial · GitHub

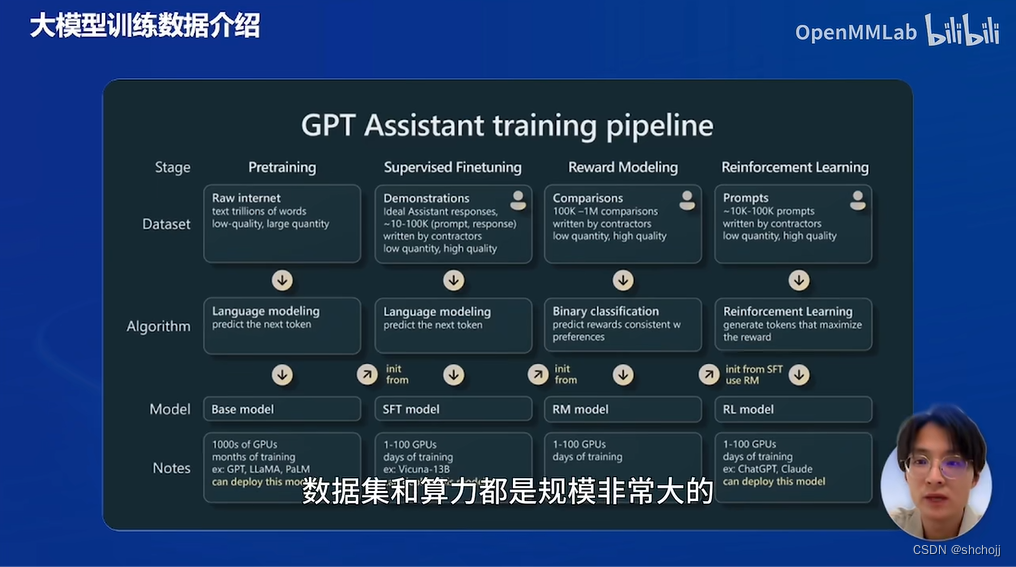

一、大模型训练数据介绍

- 预训练:

- 网络、论文数据,无标签数据

- transform算法

- base model

- 典型:GPT

- 监督微调

- 对话数据:prompt和response,

- 人工标注或者模型生成,规模小但是质量高

- SFT Model:xtuner

- RHF

- 一般不涉及,人工排序、打分,数据少,质量高

- 二分类算法

- reward model

- 强化学习

- prompts:问题,模型提供输出revive model排序打分

- 强化学习算法

- RL model

二、微调是什么

- 预训练:无标签、规模大、质量低、内容杂

- 微调:规模小、质量高、面向特定任务场景,人工或模型标注的问答对

三、指令微调

-

大模型微调fine-tuning:特定领域问题回答的不好

-

指令微调instruction tuning:特定任务指令

四、微调目的

- 预训练无法满足需求:专业问答、组织自身信息

- prompt engineering局限性:输入过长、推理成本高、效果不理想

- 数据安全问题:企业内部数据,敏感数据

- 需要个性化服务:微调轻量级模型

五、微调方式

六、微调步骤☆☆☆☆

七、微调数据分类

八、微调数据质量

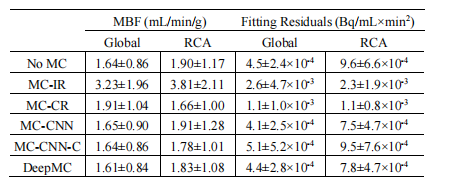

九、微调结果评价

十、微调实践

Tutorial/FineTune at main · Focusshang/Tutorial · GitHub

标注工具:

OpenDataLab · GitHub

OpenDataLab 引领AI大模型时代的开放数据平台