mac本地化部署ChatGLM3

- 写在前面

- 环境准备

- 1. python环境

- 2. 安装第三方依赖torch

- 3.下载模型

- 代码准备

- 1.clone代码

- run

- 效果

写在前面

建议直接去看官方文档

https://github.com/THUDM/ChatGLM3?tab=readme-ov-file

环境准备

1. python环境

python -V

## 3.11.4

2. 安装第三方依赖torch

pip3 install --pre torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/nightly/cpu

3.下载模型

https://modelscope.cn/models/ZhipuAI/chatglm3-6b/files

克隆下来,几个大文件可能需要手动下载,克隆完成后注意看看文件的大小

git clone https://www.modelscope.cn/ZhipuAI/chatglm3-6b.git

代码准备

1.clone代码

git clone https://github.com/THUDM/ChatGLM3.git

cd ChatGLM3

然后使用 pip 安装依赖:

pip install -r requirements.txt

ChatGLM3目录介绍

| 名称 | 说明 |

|---|---|

| basic_demo | 基础demo(cli_demo和web_demo) |

| composite_demo | 综合demo(聊天、工具和代码解释器) |

| finetune_demo | 基础模型微调 |

| langchain_demo | langchain demo |

| model | 自己创建的,将模型文件放在此目录下 |

| openai_api_demo | openapi的api接口demo |

| tensorrt_llm_demo | tensorTR-llm demo |

run

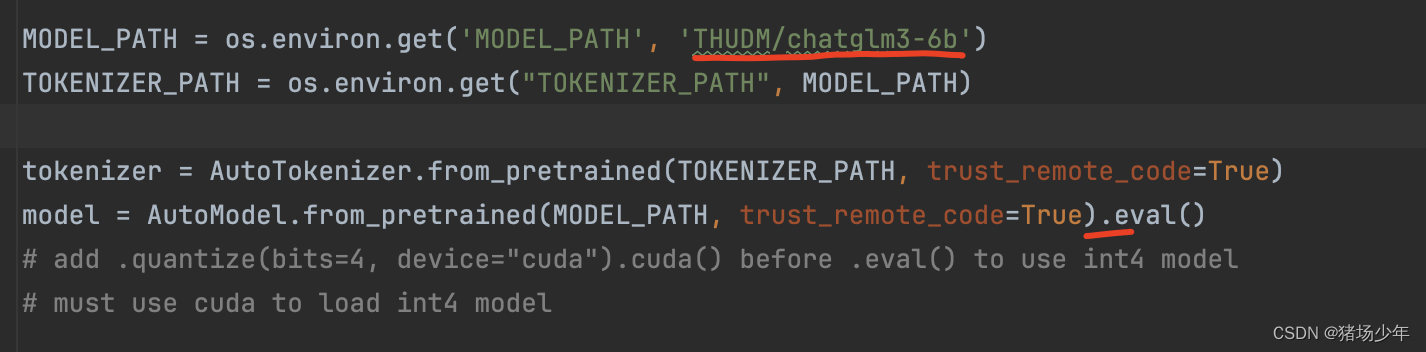

替换模型为本地文件

修改代码中MODEL_PATH为下载的模型的路径

MODEL_PATH = os.environ.get('MODEL_PATH', '/your local path/chatglm3-6b')

TOKENIZER_PATH = os.environ.get("TOKENIZER_PATH", MODEL_PATH)

tokenizer = AutoTokenizer.from_pretrained(TOKENIZER_PATH, trust_remote_code=True)

model = AutoModel.from_pretrained(MODEL_PATH, trust_remote_code=True).to('mps').eval()

然后直接run即可。

启动 composite_demo/main.py时出现

AttributeError: st.session_state has no attribute "chat_history". Did you forget to initialize it?

使用下面的命令启动、

streamlit run main.py

效果