tokenization

tokenization:分词

每一个词语都是token

分词方法:转为单个词、转为多个词语

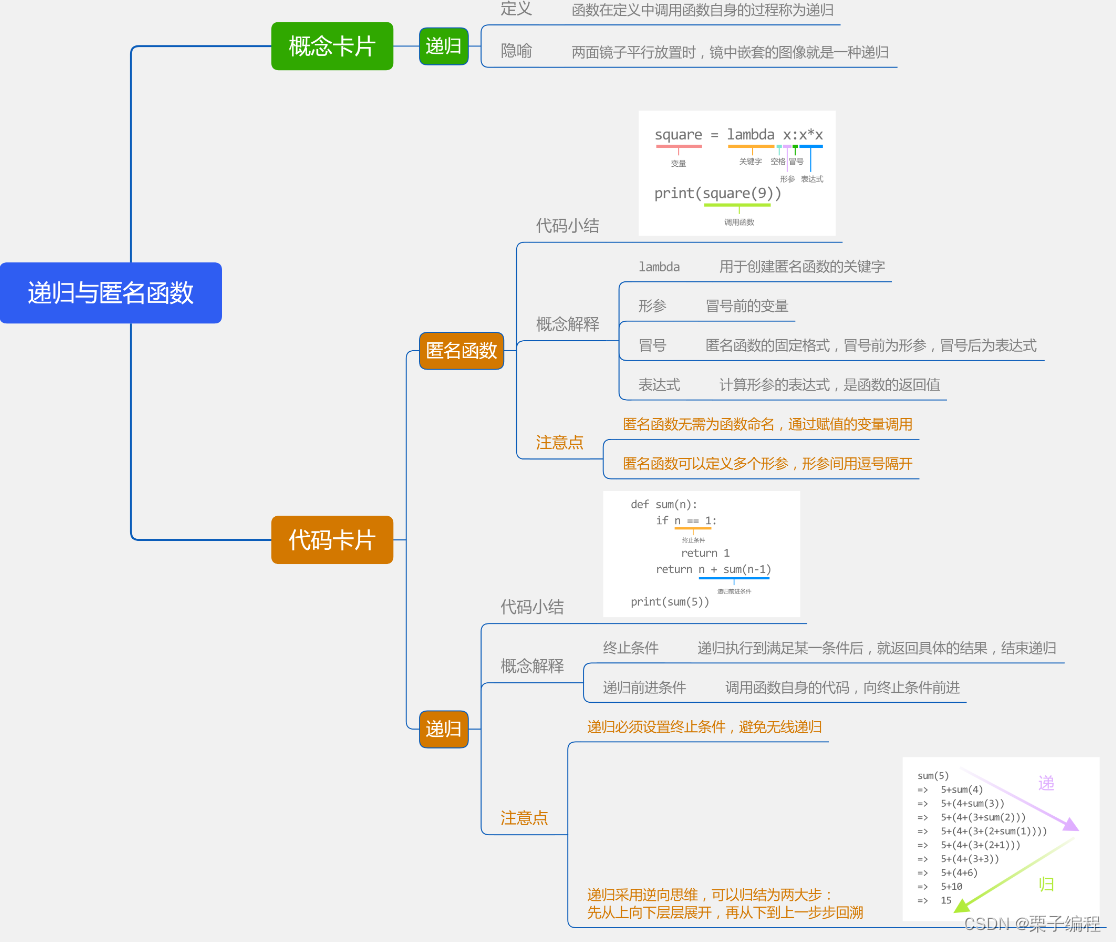

N-gram表示法

准备词语特征的方法

(把连续的N个词作为特征)

如 ”我爱你“——>[我,爱,你]

2-gram——[[我, 爱],[爱, 你]]

向量化

one-hot编码

每一个token都可以用一个N长度的向量表示,N为词空间不重复的词的个数

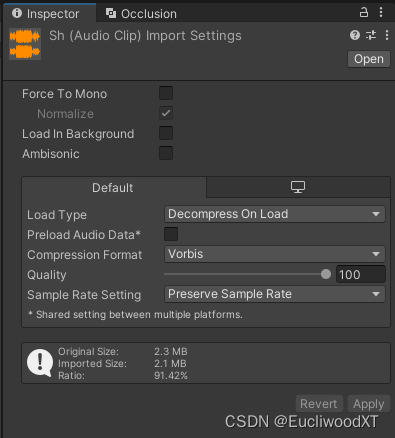

word embedding

使用浮点型的稠密向量表示token,向量通常为不同维度,向量里面每个值都是超参数,其初始值为随机生成的,之后会在训练过程中不断调整。

首先 把token用数字来表示,再把数字转换成向量。

token ——> num ——> vector

| token | num | vector |

|---|---|---|

| 词1 | 0 | [w11, w12,…,w1N] |

| 词2 | 1 | [w21, w22,…,w2N] |

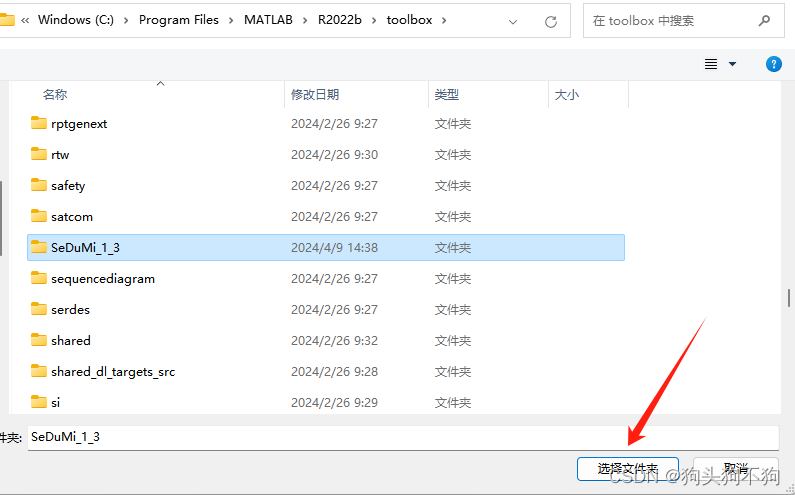

api: nn.Embedding(词典大小, embedding的维度)