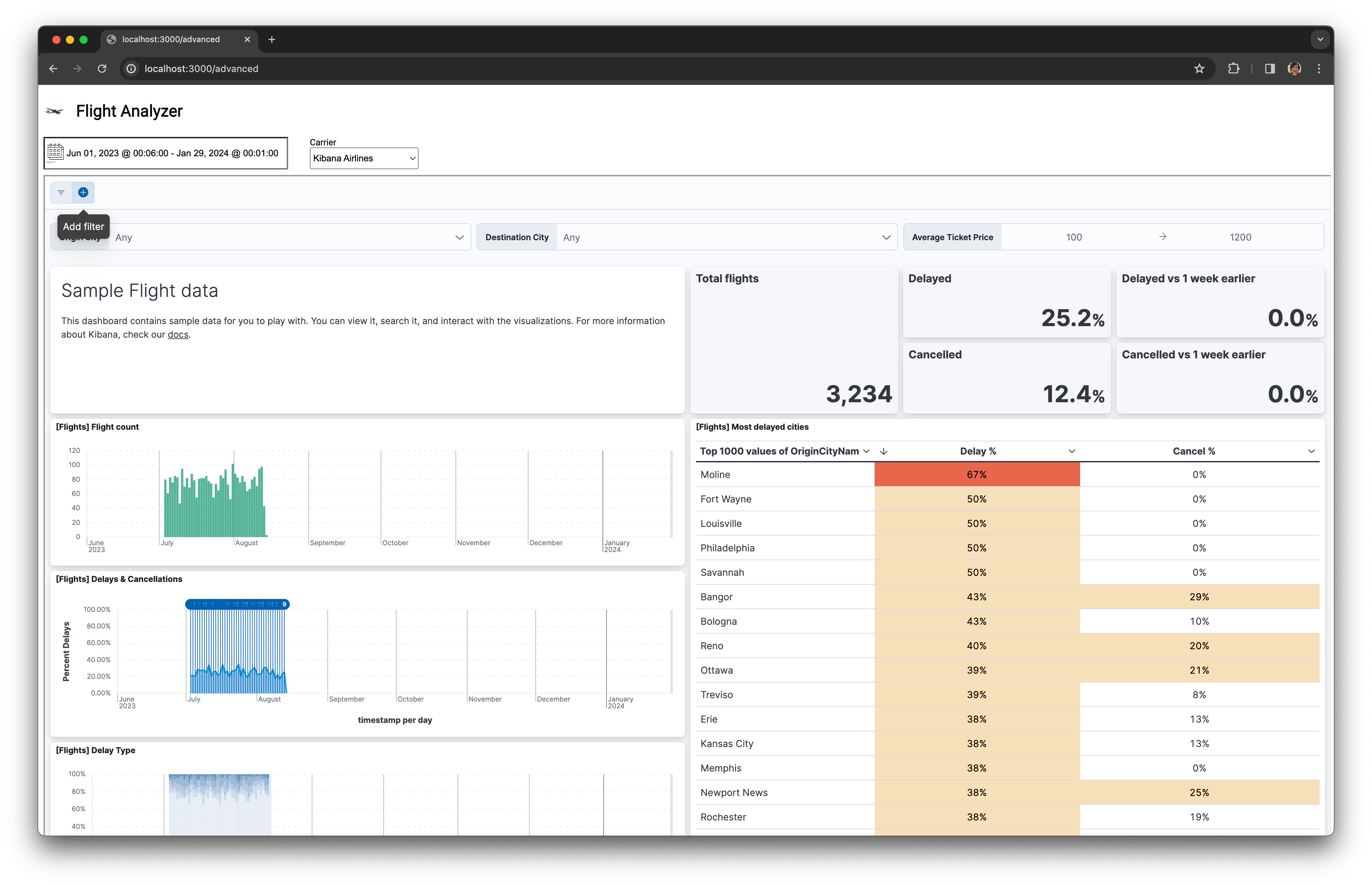

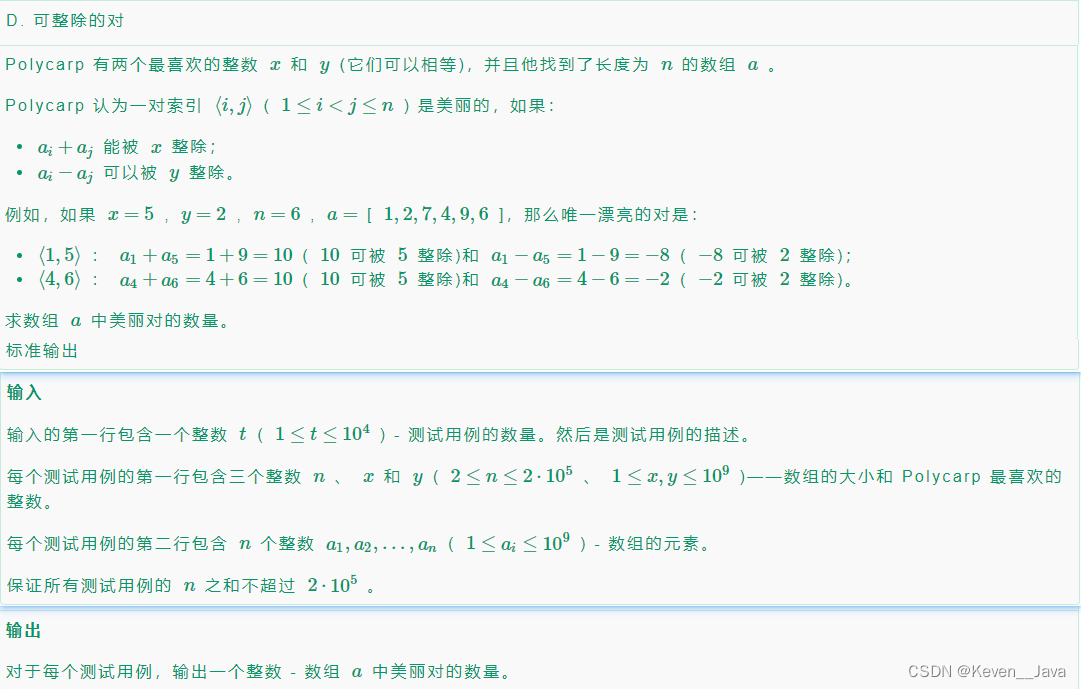

自监督学习 (SSL) 是基于 Transformer 的预训练语言模型的支柱,该范例涉及解决有助于建模自然语言的预训练任务 (PT)。本文将所有流行的预训练任务放在一起,以便我们一目了然地评估它们。

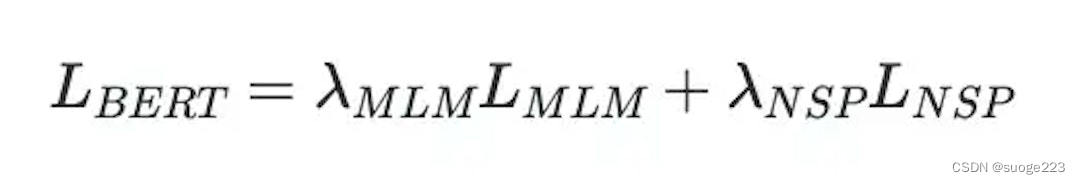

SSL 中的损失函数

这里的损失函数只是模型训练的各个预训练任务损失的加权和。

以BERT为例,损失将是MLM(Masked Language Modelling)和NSP(Next Sentence Prediction)的加权和

多年来,出现了许多解决特定问题的预训练任务。我们将回顾 10 个有趣且流行的函数及其相应的损失函数:

- 因果语言建模(CLM)

- 掩码语言建模(MLM)

- 替换令牌检测 ( RTD )

- 洗牌令牌检测(STD)

- 随机代币替换(RTS)

- 交换语言建模 ( SLM)

- 翻译语言建模(TLM

![BUUCTF misc 专题(47)[SWPU2019]神奇的二维码](https://img-blog.csdnimg.cn/f5b4278a7ed54b81b250d6807299e460.png?x-oss-process=image/watermark,type_d3F5LXplbmhlaQ,shadow_50,text_Q1NETiBAdHRfbnBj,size_20,color_FFFFFF,t_70,g_se,x_16)